当前位置:网站首页>spark中saveAsTextFile如何最终生成一个文件

spark中saveAsTextFile如何最终生成一个文件

2022-07-25 15:10:00 【南风知我意丿】

项目场景:

- 一般而言,

saveAsTextFile会按照执行task的多少生成多少个文件,比如part-00000一直到part-0000n,n自然就是task的个数,亦即是最后的stage的分区数。那么有没有办法最后只生成一个文件,而不是成百上千个文件了?答案自然是有办法。

误区

在RDD上调用

coalesce(1,true).saveAsTextFile(), 意味着做完计算之后将数据汇集到一个分区,然后再执行保存的动作,显然,一个分区,Spark自然只起一个task来执行保存的动作,也就只有一个文件产生了。又或者,可以调用repartition(1),它其实是coalesce的一个包装,默认第二个参数为true。事情最终就这么简单吗?

显然不是。你虽然可以这么做,但代价是巨大的。因为Spark面对的是大量的数据,并且是并行执行的,如果强行要求最后只有一个分区,必然导致大量的磁盘IO和网络IO产生,并且最终执行reduce操作的节点的内存也会承受很大考验。Spark程序会很慢,甚至死掉。这往往是初学Spark的一个思维陷阱,需要改变原先那种单线程单节点的思维,对程序的理解要转变多多个节点多个进程中去,需要熟悉多节点集群自然产生多个文件这种模式。

此外,saveAsTextFile要求保存的目录之前是没有的,否则会报错。所以,最好程序中保存前先判断一下目录是否存在。

当我运行完一个Spark程序想把结果保存为saveAsTextFile,

结果使用Hadoop fs -ls /output后发现里面有一系列的part,好几千个。原因:

运行Spark的时候把数据分成了很多份(partition),每个partition都把自己的数据保存成partxxx文件形式。

如果想保存为一份的话,就要:

先collect

或者data.coalesce(1,true).saveAsTextFile()

也或者

data.repartition(1).saveAsTextFile( ) //You can also use repartition(1), which is just a wrapper for coalesce() with the suffle argument set to true.

data.repartition(1).saveAsTextFile( “HDFS://OUTPUT”)

- 问题:

但是如果你的数据很大,难以在单机内存上装下,以上操作可能会造成单机内存不足(OOM)

原因在于以上操作都是讲分布在各个机器上的数据汇总到单机,然后再保存到磁盘(HDFS)上。

以上操作将各个机器上的RDD partition 合并到单一主机后再读入磁盘。

解决方案:

以下给出更安全的操作,即采用HDFS磁盘合并操作。

如果已经存了很多个part:

可以把大文件夹getmerge:

把HDFS 上的多个文件 合并成一个 本地文件:

hadoop fs -getmerge /hdfs/output /local/file.txt

也可以:

hadoop fs -cat /hdfs/output/part-r-* > /local/file.txt

边栏推荐

- 45padding不会撑开盒子的情况

- String type time comparison method with error string.compareto

- golang复习总结

- LeetCode_字符串_中等_151.颠倒字符串中的单词

- "How to use" agent mode

- Melody + realsense d435i configuration and error resolution

- 44 Sina navigation, Xiaomi sidebar exercise

- npm的nexus私服 E401 E500错误处理记录

- Scala111-map、flatten、flatMap

- 37 元素模式(行内元素,块元素,行内块元素)

猜你喜欢

随机推荐

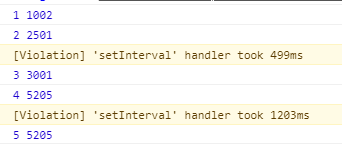

防抖(debounce)和节流(throttle)

pkg_ Resources dynamic loading plug-in

Scala110-combineByKey

mysql heap表_MySQL内存表heap使用总结-九五小庞

44 Sina navigation, Xiaomi sidebar exercise

Boosting之GBDT源码分析

TypeScript学习2——接口

BigDecimal rounds the data

6月产品升级观察站

When using jetty to run items, an error is reported: form too large or form too many keys

Unable to start web server when Nacos starts

pl/sql 创建并执行oralce存储过程,并返回结果集

41 picture background synthesis - colorful navigation map

Bridge NF call ip6tables is an unknown key exception handling

JS 同步、异步,宏任务、微任务概述

了解一下new的过程发生了什么

Introduction to raspberry Pie: initial settings of raspberry pie

Detailed explanation of lio-sam operation process and code

Leo-sam: tightly coupled laser inertial odometer with smoothing and mapping

golang复习总结