当前位置:网站首页>ICML2022 | 从零开始重新审视端到端的语音到文本翻译

ICML2022 | 从零开始重新审视端到端的语音到文本翻译

2022-06-10 21:43:00 【智源社区】

论文链接:https://arxiv.org/pdf/2206.04571.pdf

端到端 (E2E) 语音到文本翻译 (ST) 通常依赖于使用源转录本通过语音识别或文本翻译任务对其编码器和/或解码器进行预训练,否则翻译性能会大幅下降。然而,成绩单并不总是可用的,而且文献中很少研究这种预训练对于 E2E ST 的重要性。在本文中,我们重新审视了这个问题,并探讨了仅在语音翻译对上训练的 E2E ST 的质量可以在多大程度上得到提高。我们重新审视了之前证明对 ST 有益的几种技术,并提供了一组最佳实践,使基于Transformer 的 E2E-ST系统偏向于从头开始训练。此外,我们提出了参数化距离惩罚,以促进语音自注意力模型中的局部性建模。在涵盖 23 种语言的四个基准测试中,我们的实验表明,在不使用任何转录本或预训练的情况下,所提出的系统达到甚至优于以前采用预训练的研究,尽管差距仍然存在于(极)低资源环境中。最后,我们讨论了神经声学特征建模,其中神经模型旨在直接从原始语音信号中提取声学特征,目的是简化归纳偏差并增加模型描述语音的自由度。

边栏推荐

- 【TcaplusDB知识库】TcaplusDB查看进程所在机器介绍

- [tcapulusdb knowledge base] Introduction to tcapulusdb push configuration

- CCF CSP 202109-1 array derivation

- [tcapulusdb knowledge base] tcapulusdb daily inspection introduction

- 【TcaplusDB知识库】TcaplusDB巡检统计介绍

- Redis从入门到入土

- [play with Huawei cloud] take you through the Kunpeng code migration tool to realize source code migration

- Tcapulusdb Jun · industry news collection (V)

- smb匿名

- 但身示你五县非那最土zaiFKMW

猜你喜欢

【TcaplusDB知识库】TcaplusDB TcapDB扩缩容介绍

MySQL主从复制解决读写分离

Web3 ecological decentralized financial platform sealem Finance

Opencv_ 100 questions_ Chapter III (11-15)

【TcaplusDB知识库】TcaplusDB进程启动介绍

Bottom layer communication protocol ① of single chip microcomputer -- synchronous and asynchronous, parallel and serial, full duplex and half duplex, simplex, level signal and differential signal

Keras deep learning practice (8) -- using data enhancement to improve neural network performance

![[tcapulusdb knowledge base] tcapulusdb tcapdb capacity expansion and contraction introduction](/img/3b/6546846fb7bbccbb0abe91422549ed.png)

[tcapulusdb knowledge base] tcapulusdb tcapdb capacity expansion and contraction introduction

【TcaplusDB知识库】TcaplusDB引擎参数调整介绍

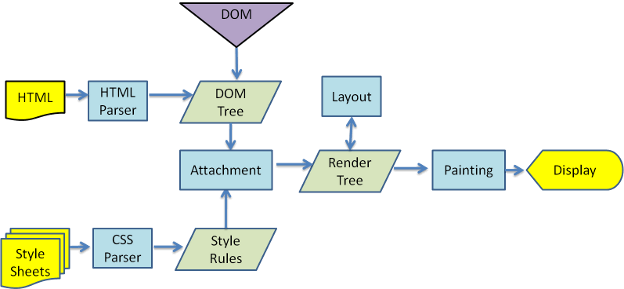

重排 (reflow) 与重绘 (repaint)

随机推荐

【TcaplusDB知识库】TcaplusDB TcapDB扩缩容介绍

Tcapulusdb Jun · industry news collection (IV)

Typescript - declaration files and built-in objects

SMB anonymous

Basic use of mathtype7.x

Flex layout syntax

【TcaplusDB知识库】TcaplusDB巡检统计介绍

【TcaplusDB知识库】TcaplusDB查看线上运行情况介绍

Redis from entry to entry

[tcapulusdb knowledge base] Introduction to the machine where the tcapulusdb viewing process is located

Web3 ecological decentralized financial platform sealem Finance

2022 t elevator repair test question simulation test question bank and online simulation test

【TcaplusDB知识库】TcaplusDB引擎参数调整介绍

Blue Bridge Cup_ A fool sends a letter_ recursion

【TcaplusDB知识库】TcaplusDB刷新tbus通道介绍

Web3生态去中心化金融平台——Sealem Finance

Online questionnaire system based on php+web+mysql

smb匿名

smb匿名

[tcapulusdb knowledge base] Introduction to tcapulusdb engine parameter adjustment