当前位置:网站首页>搭建Spark开发环境(第二弹)

搭建Spark开发环境(第二弹)

2022-08-02 21:09:00 【发量不足】

欢迎来到本博客

本篇介绍的是Spark环境的准备

预更新:体验第一个Spark程序

目录

一.环境准备

配置环境:Hadoop、spark(本人是2.0.0)、JDK(1.8)、Linux(Centos6.7)

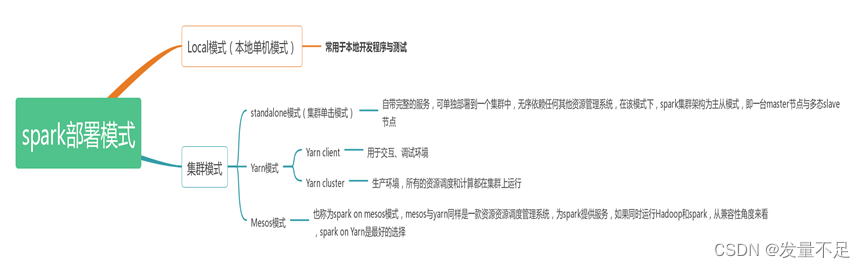

二·.spark的部署方式

spark部署模式分为Local模式和集群模式,在local模式,常用于本地开发与测试,集群模式又分为standalone模式(集群单机模式)、Yarn模式、mesos模式

三.spark集群安装部署

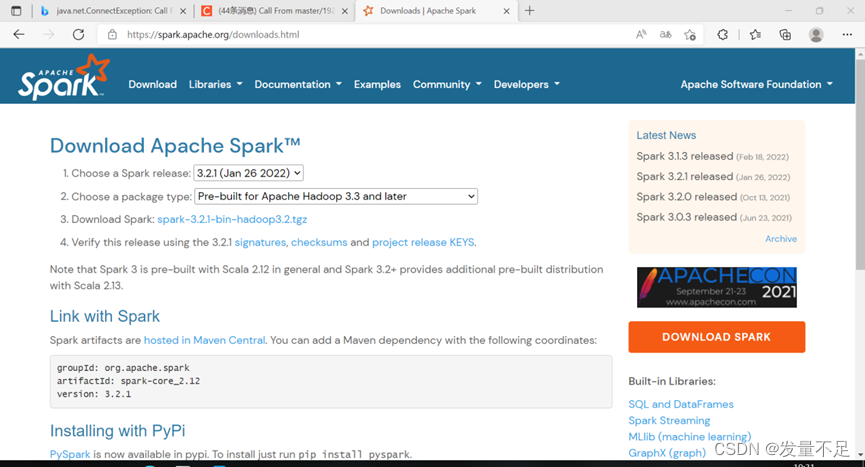

1下载spark安装包.

下载spark安装包 在Apache spark官网下载网址:Downloads | Apache Spark(最新且稳定的版本是3.2.1,本人安装版本为2.0.0)

2.解压spark安装包

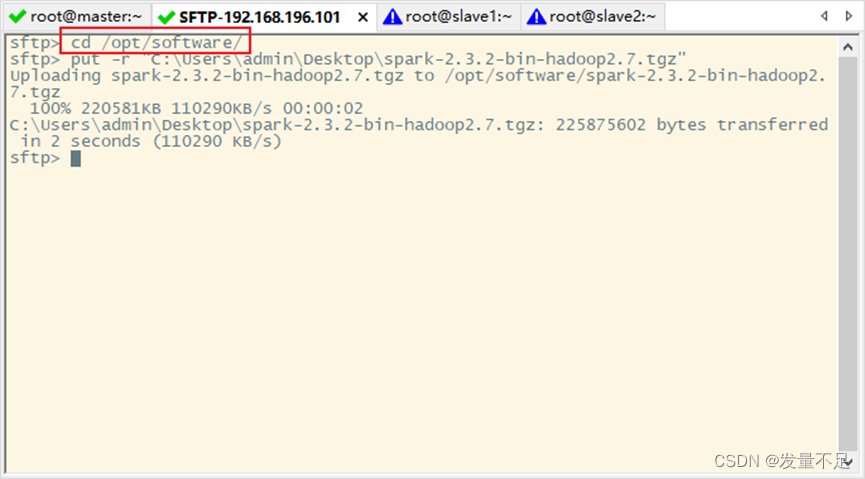

步骤1 先 alt+P,再拉spark-2.3.2-bin-hadoop2.7.tgz上传/opt/software目录下

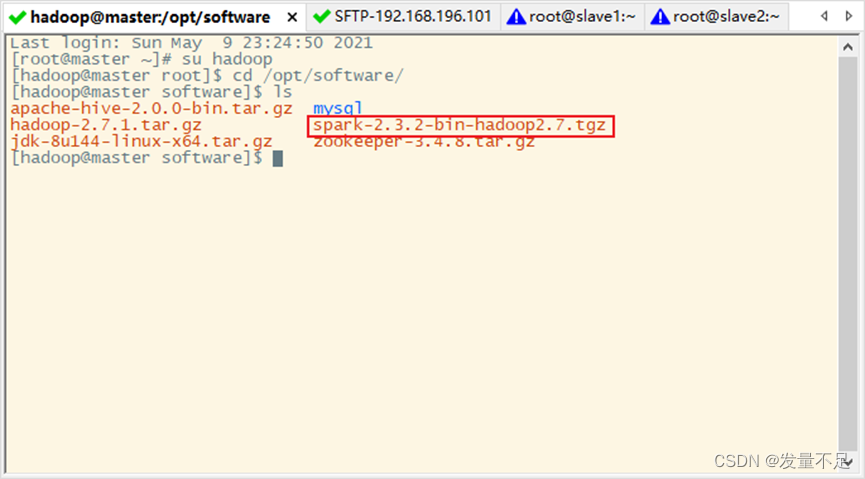

回到master切换hadoop用户

$su Hadoop

$ cd /opt/software

$ls

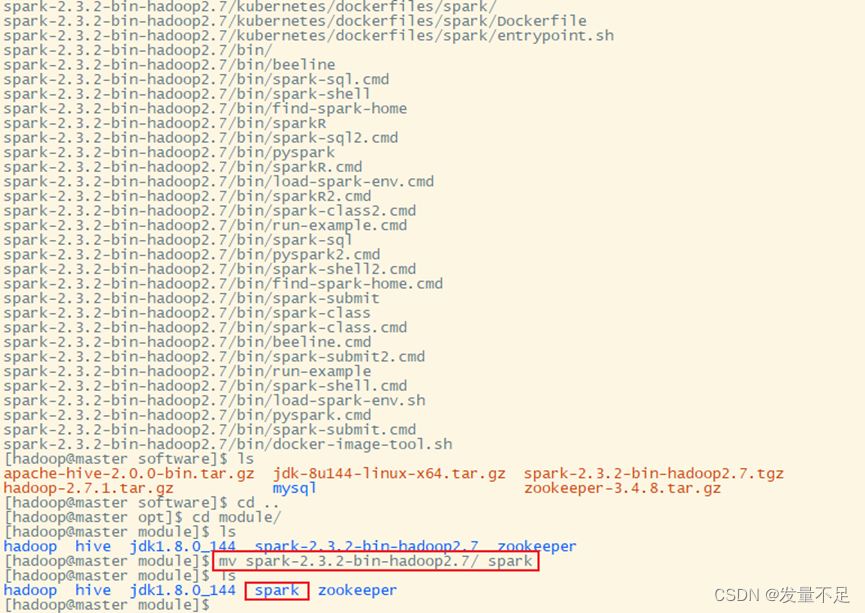

$ tar -zxvf spark-2.3.2-bin-hadoop2.7.tgz -C /opt/module/

3.修改配置文件

步骤1 使用mv命令将spark-2.3.2-bin-hadoop2.7重名为spark

$cd /opt/module

$ mv spark-2.3.2-bin-hadoop2.7/ spark

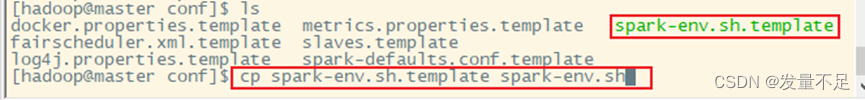

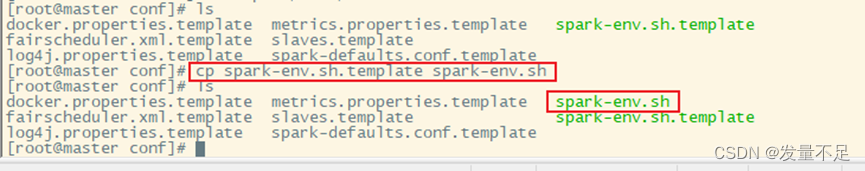

步骤2 先进入/opt/module/spark/conf/目录,将spark-env.sh.template复制给spark-env.sh

$ cd /spark/conf

$ ls

$ cp spark-env.sh.template spark-env.sh

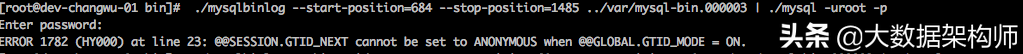

$vi spark-env.sh

![]()

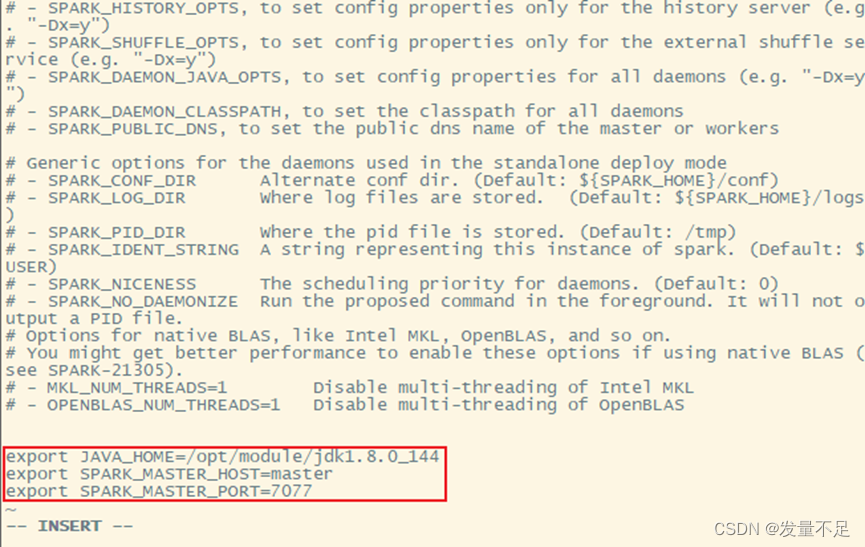

# Java环境变量

export JAVA_HOME=/opt/module/jdk1.8.0_144

# 指定master的 IP

export SPARK_MASTER_HOST=master

# 指定master的 端口

export SPARK_MASTER_PORT=7077

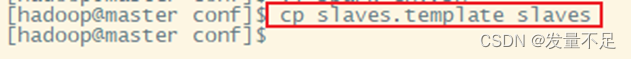

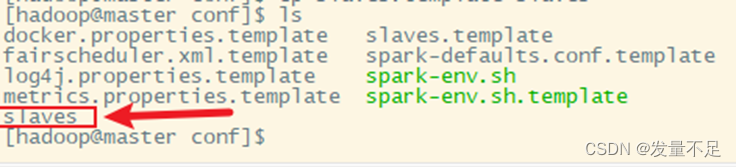

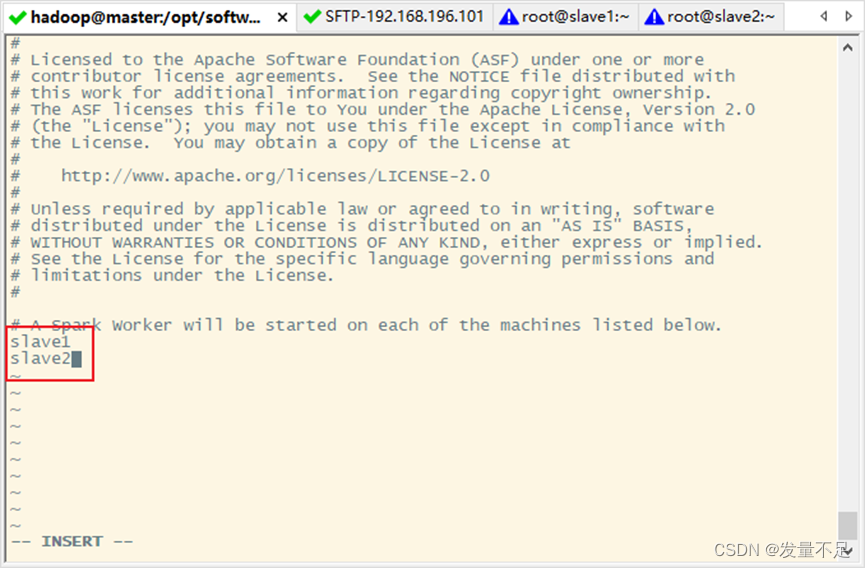

步骤4 复制slaves.template slaves 并重命名slaves

cp slaves.template slaves

步骤5 使用vi slaves命令编辑slaves配置文件,指定从节点IP

$vi slaves

Slave1

Slave2

4.分发文件

$scp -r /opt/module/spark/ slave1:/opt/module/

$ scp -r /opt/module/spark/ slave2:/opt/module/

![]()

![]()

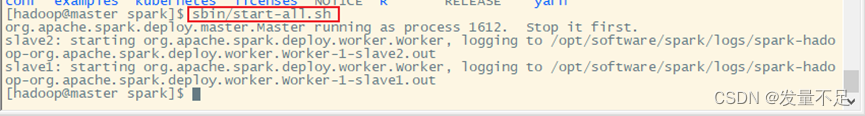

5 启动spark集群

cd ..(回到spark目录)

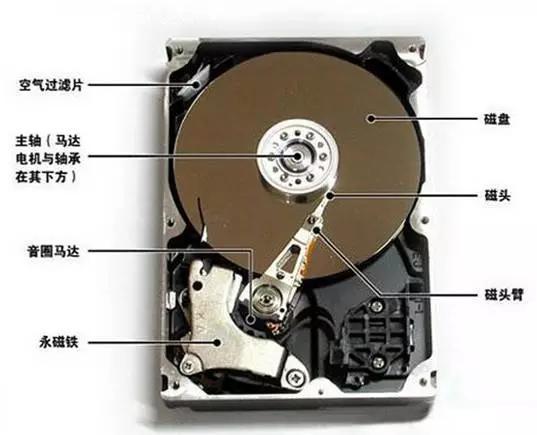

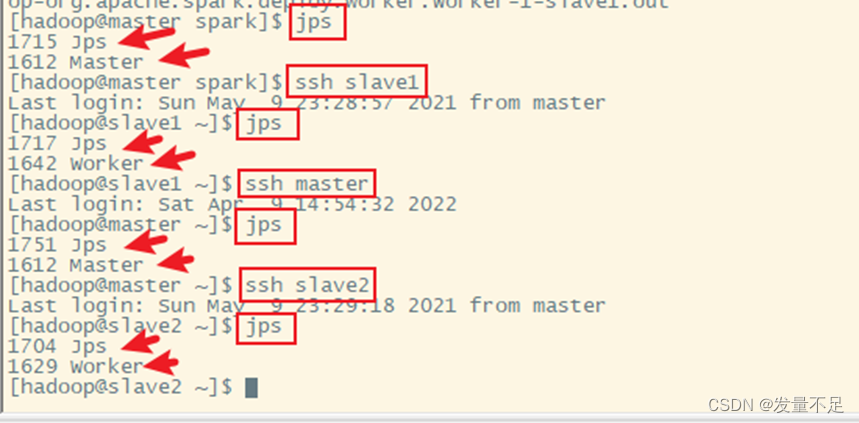

步骤2 先使用ssh命令切到slave1、slave2,使用jps查看各节点进程,主节点有master,从节点有worker

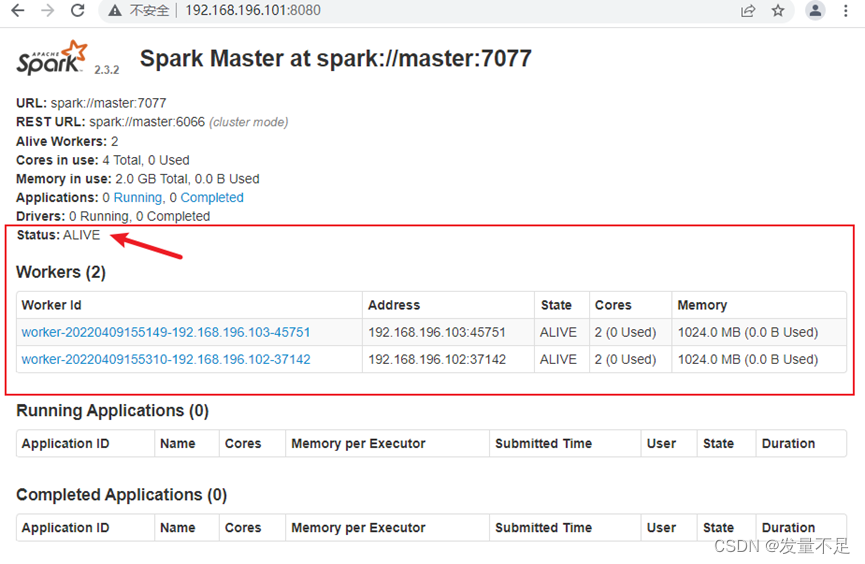

步骤3 访问spark管理界面(master) http://192.168.196.101:8080,如图:

看到该状态

看到该状态

边栏推荐

猜你喜欢

随机推荐

【3D视觉】realsense D435三维重建

Vscode快速入门、 插件安装、插件位置、修改vscode默认引用插件的路径、在命令行总配置code、快捷键

源码构建LAMP环境-2

C primer plus学习笔记 —— 9、联合&枚举&typdef

【3D视觉】深度摄像头与3D重建

包管理工具npm- node package management相关知识 、检查包更新、NPM包上传、更换镜像、npm ERR! registry error parsing json

《分布式微服务电商》专题(一)-项目简介

golang 刷leetcode:从栈中取出 K 个硬币的最大面值和

IP协议(网际协议)

How to quickly compare two byte arrays for equality in .NET

Ansible安装与配置

快速构建电脑软件系统 、超好用经典的网页推荐汇总

golang刷leetcode:按位与结果大于零的最长组合

汇编语言中b和bl关键字的区别

LeetCode 2359. 找到离给定两个节点最近的节点 基环树

YARN资源调度系统介绍

js: 实现一个cached缓存函数计算结果

YAML文件格式

【模型压缩】实例分析量化原理

用户之声 | GBASE南大通用实训有感