当前位置:网站首页>领导无线边缘AI的联合神经形态学习,具有较高的识别精度以及较低的能耗

领导无线边缘AI的联合神经形态学习,具有较高的识别精度以及较低的能耗

2022-08-02 15:54:00 【智源社区】

边栏推荐

猜你喜欢

随机推荐

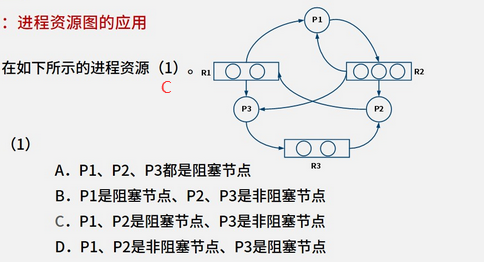

2.6 - 进程资源

NC52 有效括号序列

禅道16.5升级17.3

【[USACO12MAR]Cows in a Skyscraper G】【状压DP && DFS】

mysql 《一》触发器

带你了解MySQL数据库

WWW'22 推荐系统论文之图神经网络篇

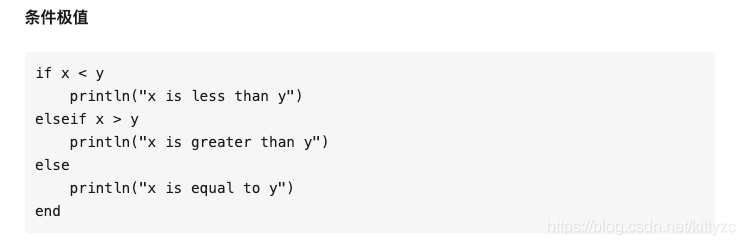

julia系列6:并行计算

JZ70 矩形覆盖

我的创作纪念日

QueryWrapper method explained

2.7 - 文件管理 2.8 - 多级目录结构 2.9 - 位示图

想要白嫖正则是吧?这一次给你个够!

MongoDB 《三》复制集集群搭建实例

tiup mirror set

8大软件供应链攻击事件概述

一文搞懂│php 中的 DI 依赖注入

《独行月球》

打破千篇一律,DIY属于自己独一无二的商城

GFP-GAN学习笔记