当前位置:网站首页>深度学习的几种优化方法

深度学习的几种优化方法

2022-06-21 05:57:00 【前行_的路上】

开门见山,本篇博客涉及到的优化方法包括有:SGD,SGD with momentum,Adagrad,RMSProp,Adam这五种。

文中出现的一些符号的含义:

模型在t时刻的参数

or

:在

处的梯度,用于计算

:从第0步累积到第t步的动量,用于计算

先介绍最基础的两种优化方法:SGD和SGD with momentum

一、SGD

until

每一个时间步,

都要往梯度方向的反方向走一步

二、SGD with momentum

多了一个动量m,可以避免优化器落入鞍点,让优化器可以使loss函数落到更低点(最优点)

比SGD多了一个“动量”m,更新公式变为:

三、Adagrad

为了找到最低点,我们一般希望在梯度平缓的方向上,步子可以迈的大一点,在梯度陡峭的地方,步子就收着点

提出了自适应学习率,避免在loss曲线很崎岖的时候,优化器步子迈的太大,越过了最优点

四、RMSProp

Adagrad这种思路非常直白,就是如果该参数之前的所有梯度都非常平缓,那么步子就会迈的比较大,反之亦然。但这个算法的问题是将之前的梯度值都默认为差不多,平缓的一直平缓,陡峭的一直陡峭。但实际上不是这样,针对这个问题,RMSProp增加了一个超参数 ,可以更稳定的反应梯度变化情况。

,可以更稳定的反应梯度变化情况。

避免Adagrad这种方法在一开始梯度很大的时候就卡住

五、Adam

Adam借鉴了Adagrad自适应学习率和动量梯度下降法的优点,使用动量和自适应学习率来加快收敛速度,既能适应稀疏梯度,又能缓解梯度震荡。

Adam == RMSProp+Mementum

边栏推荐

- sqli-labs26

- Eth Denver conference is a Web3 foam signal? See what investors and builders say respectively

- Li Kou ----- result array after removing letter ectopic words

- Research and Analysis on the current situation of China's video production service market and forecast report on its development prospects (2022)

- 上手自定义线程池

- 模块 14 - 15:网络应用通信考试

- 【Grafana】Grafana Mimir在海量时间序列指标中的优化

- TF. Auto Fonction de réserve

- 应用在洗衣机触摸屏中的触摸芯片

- 成立时间用了时间插件,但在网页上修改参数的时候,如果未修改时间第一次保存会报错,第二次才行

猜你喜欢

You have an error in your SQL syntax; check the manual that corresponds to your MYSQL server

simple_js 攻防世界

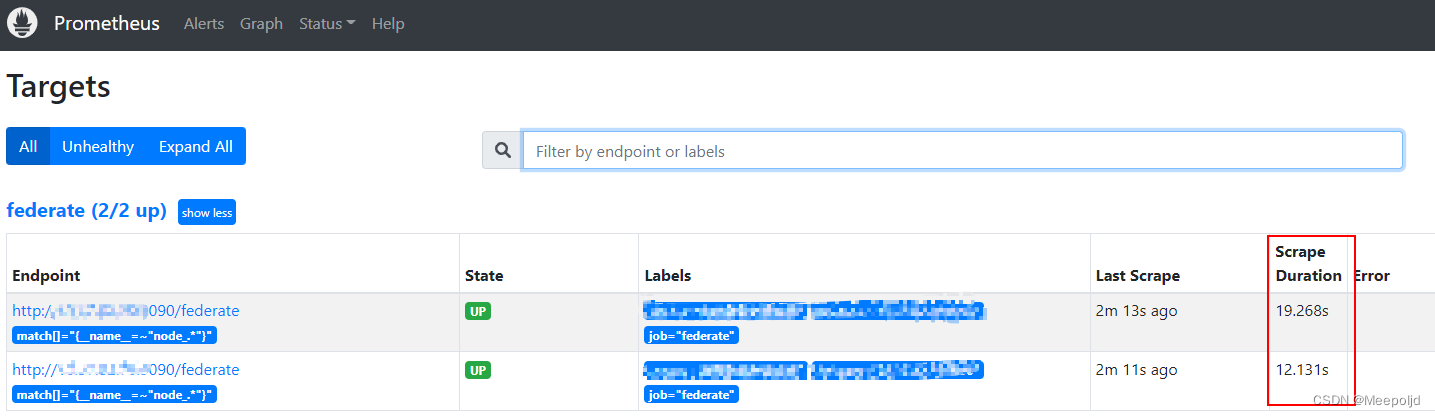

【Prometheus】Prometheus联邦的一次优化记录

应用在电子产品背光显示中的模拟环境光传感芯片

Kali shortcut keys and settings

![[SQL injection 16] read / write file for SQL vulnerability exploitation](/img/83/1c4680d4ea6980e0777b8ea4eeaba5.jpg)

[SQL injection 16] read / write file for SQL vulnerability exploitation

【数据挖掘】期末复习 第五章

Copy the code generated by the code generator to the idea. How to solve the error reported by the web address after running

代码生成器文件运行出错:The server time zone value ‘�й���ʱ��‘ is unrecognized or represents more than one time

![[Prometheus] an optimization record of Prometheus Federation](/img/4a/f026d3b60bb7d2504c7f609cd97ea1.png)

[Prometheus] an optimization record of Prometheus Federation

随机推荐

sqli-labs23

二叉排序树的基本操作

Research and Analysis on the current situation of China's wireless multi room speaker Market and forecast report on its development prospect (2022)

【数据挖掘】期末复习 第四章

tf.compat.v1.MetaGraphDef

Sub-Category Optimization for Multi-View Multi-Pose Object Detection

Transformer模型实现与解析

复制 代码生成器 生成的代码到idea中,运行后网址报错怎么解决

DP背包总结

Picture steganography: Method 1

lambda-stream

获取字符串字节大小

【Grafana】Grafana Mimir在海量时间序列指标中的优化

UVC sterilization lamp with integrated sterilization, deodorization and odor removal

Touch chip applied in touch screen of washing machine

R statistical plot - correlation of environmental factors +mantel test combination diagram (linket package introduction 1)

数据库是8.0的同学,在这个地方,加这一段?useSSL=false&serverTimezone=GMT%2B8&characterEncoding=utf8

Working principle of digital temperature sensor and analysis of temperature measurement principle

【数据挖掘】期末复习 第五章

tf. compat. v1.global_ variables_ initializer

模型在t时刻的参数

模型在t时刻的参数 or

or  :在

:在 处的梯度,用于计算

处的梯度,用于计算

:从第0步累积到第t步的动量,用于计算

:从第0步累积到第t步的动量,用于计算

都要往梯度方向的反方向走一步

都要往梯度方向的反方向走一步