当前位置:网站首页>Splunk Bucket 背後的秘密

Splunk Bucket 背後的秘密

2022-06-11 12:04:00 【shenghuiping2001】

最近剛好一個運維case 來看splunk 移除peer node 數據不會丟失:

1: 由於性能問題,要移除index node, 通常我們說這是一個peer:

可以參考我的blog:Splunk 移除index 節點 + 注意點_shenghuiping2001的博客-CSDN博客

先在CM. server 上執行remove 的命令後:

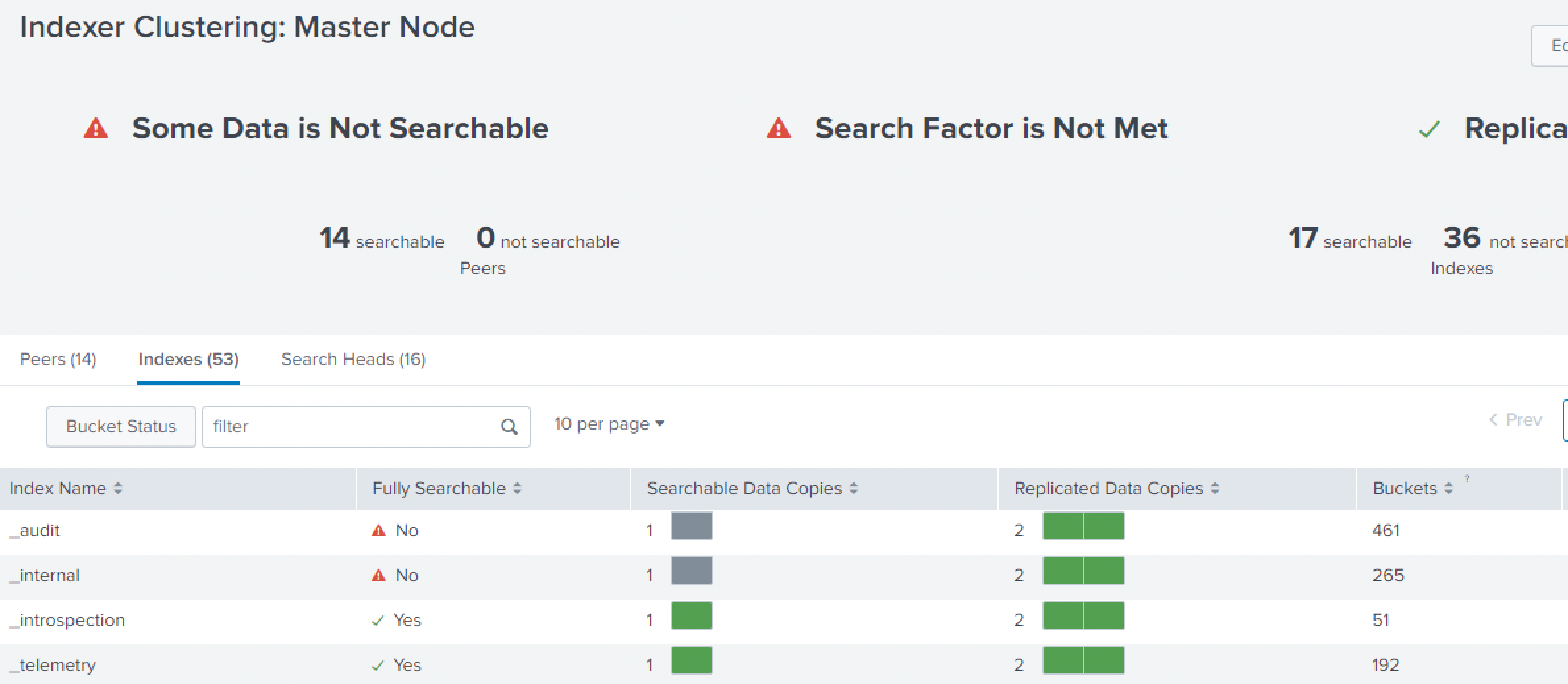

發現node peer : 15 -> 14, 少了一個,但是searchable 的變少了:

2: 但是不用擔心:看上面的replicated Data copies: 2 個,還是綠色的:

檢查一下上面bucket status 的: 點一下 Butcket Status:

可以看到 Fixup Tasks : pending 的數量在不斷减少,稍微等一會,再看上面的searchable 的:

3: 下面再看一下process 的進程:

可以看到pendingd 的數量在不斷减少,而且新的bucket 是在不同的兩個新的peer 上面的copy.

4: 所以,當有兩個node 同時移除的時候,而且這兩個noe 都是含有同一個bucket 的話那這個bucket 就沒有地方copy.

5: 最後完全OK:

6: 關於上圖的: indexer with exces Buckets: (下圖可以解釋)

RF: 2 | ||

peer3 | ||

peer1 | peer2 |

|

bkt1 | bkt1(excess) |

|

| bkt2 | bkt2(excess) |

bkt2 | bkt1 | bkt1(excess) |

|

|

|

Case1:

Peer1: bkt1 / bkt2

Peer2: bkt2

Peer3: bkt1

Case2: when peer2 offline / maintenance:

Peer1: bkt1 / bkt2

Peer2: ---

Peer3: bkt1 / bkt2 (copy from peer2).

Case3: when peer2 recovery:

Peer1: bkt1 / bkt2

Peer2: bkt2

Peer3: bkt1 / bkt2

從上面的case 3 的時候,bkt2 就顯示excess. 如果出現如下case4 的時候:

Case4: when peer3 offline / maintenance:

Peer1: bkt1 / bkt2

Peer2: bkt2 / ( bkt1 / bkt2) excess

Peer3: ---

上面的解釋說明excess buket 產生的過程。

有具體案例可以私信我。

边栏推荐

- 吊打面试官,涨姿势

- Zhouhongyi's speech at the China Network Security Annual Conference: 360 secure brain builds a data security system

- Smart sidebar plug-in: Mo widgets

- Using fast and slow pointer method to solve the problem of array (C language)

- WordPress database cache plug-in: DB cache Reloaded

- 程序员常用的命令符

- POJ 3278 catch the cow (width first search, queue implementation)

- 再不刷题就晚了,最全的BAT大厂面试题整理

- 软件项目管理 7.1.项目进度基本概念

- Splunk Bucket 背后的秘密

猜你喜欢

Web development model selection, who graduated from web development

Software project management 7.1 Basic concept of project schedule

Is the SSL certificate reliable in ensuring the information security of the website?

安全工程师发现PS主机重大漏洞 用光盘能在系统中执行任意代码

It will be too late if you don't brush the questions. The most complete bat interview questions

深度学习与CV教程(14) | 图像分割 (FCN,SegNet,U-Net,PSPNet,DeepLab,RefineNet)

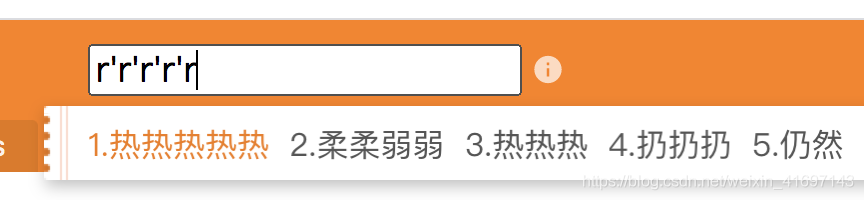

Use of Chinese input method input event composition

Solve the problem of swagger document interface 404

Maximum water container

反射真的很耗时吗,反射 10 万次,耗时多久。

随机推荐

[JUC supplementary] atomic class, unsafe

Deep learning and CV tutorial (14) | image segmentation (FCN, segnet, u-net, pspnet, deeplab, refinenet)

Fast build elk7.3

Memory mapping image of the grayloc module in the surfacefinder process

JS to realize the rotation chart (riding light). Pictures can be switched left and right. Moving the mouse will stop the rotation

读取geo表达矩阵

01_ Description object_ Class diagram

ELK - X-Pack设置用户密码

Centos7.x下安装mysql8遇到的问题Couldn‘t open file /etc/pki/rpm-gpg/RPM-GPG-KEY-mysql-2022

Use compiler option '--downleveliteration' to allow iteration of iterations

Apple mobileone: the mobile terminal only needs 1ms of high-performance backbone

Hamiltonian graph

Dominating set, independent set, covering set

log4j-slf4j-impl cannot be present with log4j-to-slf4j

Linux忘记MySQL密码后修改密码

POJ 3278 catch the cow (width first search, queue implementation)

Android 11+ 配置SqlServer2014+

C# 在PDF文档中应用多种不同字体

What is a Gerber file? Introduction to PCB Gerber file

Wechat web developers, how to learn web development