当前位置:网站首页>Relation entre les classes et à l'intérieur des classes de classification vidéo - - Régularisation

Relation entre les classes et à l'intérieur des classes de classification vidéo - - Régularisation

2022-06-12 11:37:00 【Grandes ailes grillées】

Abstract

Cet article propose un nouveau cadre,Apprentissage conjoint des relations caractéristiques et utilisation des relations de classe pour améliorer la performance de la classification vidéo.En particulier:,Ces deux types de relations se font par le biais de réseaux neuronaux profonds(DNN)Mise en œuvre stricteRégularisationPour apprendre et utiliser.

Contribution:

- Nous suggéronsDNNLa couche de fusion dans la régularisation structurelle,Pour identifier la pertinence de plusieurs caractéristiques,Tout en préservant sa diversité.Cette capacité unique distingue l'approche proposée de la plupart des travaux existants,Ces travaux sont généralement effectués par fusion peu profonde,Sans tenir compte de l'exploration approfondie de la pertinence des caractéristiques.

- Nous proposons également l'adoption d'un avis favorable surDNNLa couche de sortie de a applique une régularisation structurelle similaire pour explorer les relations entre les classes.Donc,,Les relations interfonctionnelles et interclasses sont développées et explorées dans un cadre unifié,Ce cadre peut être facilement utiliséGPURéalisation,Et la formation à un coût abordable.

- Nous avons fourni un grand nombre d'évaluations empiriques,Justification détaillée de l'efficacité du cadre proposé,Et nous avons obtenu les meilleurs résultats à ce jour sur des repères pratiques largement utilisés.

Introduction

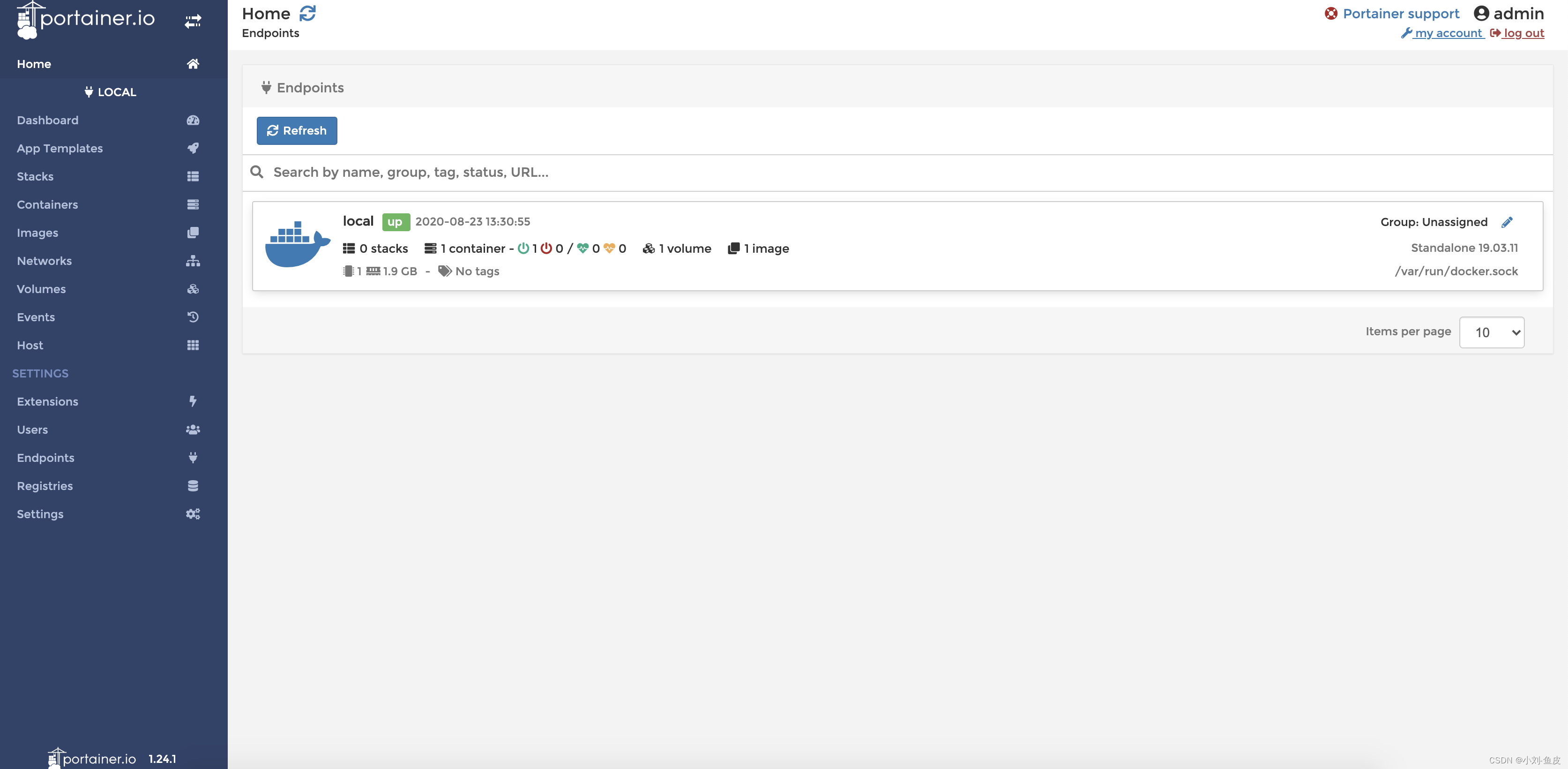

Compte tenu des limites des travaux existants,.Cet article propose un réseau neuronal profond(DNN)Cadre uniforme,Ce cadre d'apprentissage conjointRelation caractéristiqueEtRelations de classe,Tout en utilisant les relations apprises pour classifier les vidéos dans le même cadre.Fig.1Le schéma conceptuel de la méthode proposée dans cet article est donné.

Tout d'abord,,Extraction de diverses caractéristiques vidéo,Y compris les descripteurs visuels locaux et les descripteurs audio.Ensuite, utilisez la fonction commeDNNContribution de, Les deux premières couches sont la couche d'entrée et la couche de transformation des caractéristiques . La troisième couche du réseau s'appelle la couche de fusion (Fusion Layer), Où la régularisation structurelle est appliquée au poids du réseau , Pour identifier et exploiter les relations caractéristiques .En particulier:, La conception du terme de régularisation est basée sur l'observation de deux attributs naturels de la relation entre les caractéristiques , C'est - à - dire la pertinence et la diversité . Le premier signifie que différentes caractéristiques peuvent partager un schéma commun dans une représentation de niveau intermédiaire entre la caractéristique originale et la sémantique avancée . Ce dernier souligne le caractère unique des différentes caractéristiques , En complément de la sémantique de la vidéo prédictive . Ces deux attributs sont modélisés à l'aide d'une matrice de corrélation des caractéristiques , Nous avons fait des poids de fusion Normalisation des traces , Pour révéler la pertinence cachée et la diversité des caractéristiques .

Pour les relations entre classes , Nous avons régularisé le poids de la couche de sortie finale , Pour identifier automatiquement la structure des paquets des classes vidéo et des classes d'exception . Les classes sémantiques du même groupe ont des points communs ou des dépendances , Peut être utilisé comme partage des connaissances pour améliorer le rendement de la classification , Et les classes aberrantes devraient être exclues du partage négatif des connaissances .Nous allons montrer, En appliquant une régularisation similaire basée sur la norme trace au poids de la couche de sortie , Nous pouvons explorer efficacement ces relations complexes entre les classes , Pour obtenir de meilleurs résultats de classification vidéo .

Votre attention, s'il vous plaît., Les données vidéo brutes peuvent être utilisées comme entrée , Plutôt que des caractéristiques faites à la main , Comme les travaux récents sur la classification des images à l'aide de l'apprentissage profond [22].Dans ce cas,, On peut utiliser un réseau neuronal convolutif (CNN) Extraction de caractéristiques à partir de données brutes . Il y a deux raisons d'utiliser des caractéristiques faites à la main dans le cadre que nous proposons .Tout d'abord,, Les caractéristiques faites à la main sont largement utilisées dans la classification vidéo , Et reste un élément central de certains systèmes d'analyse vidéo , Ces systèmes produisent des résultats à jour sur des tâches telles que la reconnaissance du comportement humain et la reconnaissance des événements . En utilisant ces caractéristiques , Facile à combiner avec les méthodes traditionnelles de classification sémantique (Comme à la modeSVMClassificateur)Faire une comparaison équitable.Deuxièmement,, L'utilisation de réseaux neuronaux pour extraire des caractéristiques nécessite plus de couches de neurones , Ces neurones ont besoin d'un grand nombre de paramètres supplémentaires ,Besoin de plus de données sur la formation.

Votre attention, s'il vous plaît., Dans de nombreuses tâches de classification vidéo , La quantité de données d'entraînement disponibles est loin d'être suffisante pour former un réseau neuronal surchargé .Donc,,Dans cet article, La régularisation que nous proposons DNN Pour la fusion de fonctionnalités et la classification sémantique vidéo .Pour autant qu'on sache, Ce travail est la première tentative de DNN Capture des caractéristiques et des relations de classe pour la classification vidéo .

Fig.1:Base proposéeDNN Aperçu du cadre de classification vidéo pour . Tout d'abord, extraire toutes sortes de vision /Caractéristiques audio,Et l'utiliser commeDNNContribution de. Avant la fusion , Utiliser une couche de neurones pour transformer les caractéristiques (Abstract). Dans la couche de fusion , Régularisation des paramètres du réseau , Pour s'assurer que les différentes caractéristiques peuvent partager les dimensions pertinentes , Tout en conservant son caractère unique . Comme le montre le poids de ligne , Certaines dimensions des différentes caractéristiques peuvent être fortement corrélées ( Les lignes épaisses pointent vers le même neurone ).Et puis, Régularisation du poids entre la couche de fusion et la couche de sortie , Pour identifier les groupes de catégories . Les relations entre les caractéristiques apprises et les relations entre les classes sont utilisées pour améliorer le rendement de la classification

3 Methodology

3.1 Symboles et description du problème

Supposons que nous obtenions un contenant N Jeux d'entraînement avec clips vidéo , Ces clips vidéo sont C Classes sémantiques associées .Ici., Chaque clip vidéo est réalisé par M Différentes caractéristiques représentent , Par exemple, divers descripteurs visuels et audio .Donc,, Nous pouvons représenter chaque échantillon d'entraînement comme un (M+1)Tuple:

Parmi eux Indique le paragraphen Le numéro de l'échantillon vidéo mLes caractéristiques représentent.Sin Échantillons vidéo avec c Associations de classes sémantiques ,Et

Indique le paragraphen Le numéro de l'échantillon vidéo mLes caractéristiques représentent.Sin Échantillons vidéo avec c Associations de classes sémantiques ,Et![y_{n}=\left [ y_{n1},y_{n2},...,y_{nC} \right ]^{T} \in \mathbb{R}^{C}](http://img.inotgo.com/imagesLocal/202206/12/202206121134366314_15.gif) Est l'étiquette sémantique correspondante ,Dont:cÉléments

Est l'étiquette sémantique correspondante ,Dont:cÉléments =1.

=1.

L'objectif est de former des modèles de prévision , Pour trier les nouvelles vidéos de test . Une façon simple est de former un classificateur pour chaque classe sémantique , Et il est possible de combiner différentes caractéristiques en utilisant des schémas de fusion précoce ou tardive .Et pourtant, Une telle stratégie d'entraînement autonome n'explore pas les caractéristiques internes et les relations entre les classes .Ici.,Nous proposons une approche basée surDNN Modèle de classification vidéo pour , En explorant la pertinence et la diversité de multiples caractéristiques , Mise en œuvre du partage des caractéristiques au niveau de la fusion ,Comme le montre la figure1Comme indiqué.En outre, La couche prédictive de notre réseau neuronal profond est également régularisée , Afin d'améliorer le partage des connaissances entre les différentes catégories .Donc,, Explorer explicitement ces deux relations dans un processus d'apprentissage unifié .En bas, Nous commençons par les normes avec une fonction unique DNN, Ensuite, nous présentons la régularisation que nous proposons DNNDétails de.

3.2 Caractéristiques uniquesDNNApprendre

Inspiré par le système nerveux biologique ,DNN Utiliser un grand nombre de neurones interconnectés pour construire des modèles de calcul complexes . Cette méthode passe par des neurones tissulaires multicouches , Forte capacité d'abstraction non linéaire , Tant qu'il y a assez de données d'entraînement , Vous pouvez apprendre n'importe quelle fonction de cartographie de l'entrée à la sortie .En bas, Nous examinons brièvement un critère DNN, Il n'y a qu'une seule propriété comme entrée ,C'est - à - dire:M=1. Au total, il y a LStratifiéDNNMoyenne,Nous disons Et

Et En tant que caractéristique unique

En tant que caractéristique unique  Entrées et sorties des couches,

Entrées et sorties des couches, .Et

.Et Et

Et Représente séparément le paragraphe

Représente séparément le paragraphe Matrice de poids et vecteur de déviation de la couche .Del-1Couche à couchel Les couches peuvent être représentées comme :

Matrice de poids et vecteur de déviation de la couche .Del-1Couche à couchel Les couches peuvent être représentées comme :

Ici.σ(·) C'est une non - linéarité sigmoidFonctions,Généralement défini comme:

Fig.2(a)Et(b) Montre deux types de réseaux neuronaux à quatre niveaux utilisant une seule caractéristique comme entrée . Pour calculer le poids optimal de chaque couche , Les problèmes d'optimisation suivants peuvent être développés :

Parmi eux, La première partie passe par la mise en réseau  La production deground truthÉtiquettes

La production deground truthÉtiquettes Les différences sont additionnées pour mesurer la perte d'expérience sur les données de formation , La deuxième partie est un terme de régularisation pour éviter un ajustement excessif .Par souci de simplicité, Nous pouvons ajouter des dimensions supplémentaires aux vecteurs caractéristiques avec des valeurs constantes ,Oui.b Facteur de pondération absorbé WMoyenne.

Les différences sont additionnées pour mesurer la perte d'expérience sur les données de formation , La deuxième partie est un terme de régularisation pour éviter un ajustement excessif .Par souci de simplicité, Nous pouvons ajouter des dimensions supplémentaires aux vecteurs caractéristiques avec des valeurs constantes ,Oui.b Facteur de pondération absorbé WMoyenne.

Fig.2: Illustration des différentes structures du réseau neuronal .(b) Est la structure la plus populaire dans les prévisions Multi - catégories ,Et(d)C'est comme[42] Un tel travail est utilisé pour combiner plusieurs caractéristiques , Où les caractéristiques sont traitées séparément dans le réseau , Et ensuite fusionner à travers la couche intermédiaire .Dans cet article,Nous sommes d'accord avec(d) La même structure est régularisée comme indiqué dans , Pour explorer les relations entre les caractéristiques et les classes .

3.3 Régularisation et relations caractéristiques

Dans certains cas, Basé sur une seule caractéristique DNN Peut - être très puissant .Et pourtant, Il ne peut être utilisé qu'avec un seul aspect des données pour effectuer des prédictions sémantiques . Pour des données complexes comme la vidéo , L'information sémantique peut être représentée par différentes caractéristiques , Y compris les indices visuels et audio .Votre attention, s'il vous plaît., Parce que la relation intrinsèque entre plusieurs représentations de caractéristiques est ignorée , Une stratégie de fusion simple ( Comme une fusion précoce ou tardive ) Il en résulte généralement des gains de performance limités [4].En outre, .Cette méthode de fusion simple nécessite généralement des classificateurs de formation supplémentaires .Donc,, L'espoir d'une représentation compacte et significative de la fusion , Tirer pleinement parti des indices complémentaires des différentes caractéristiques .En bas, Nous allons essentiellement DNN Extension à une variante régularisée , La variante peut s'adapter au processus de fusion profonde de plusieurs caractéristiques .

On a eu MCaractéristiques: Pour chaque échantillon vidéo . Propulsé par le processus d'intégration Multi - capteurs des neurones primaires dans le système biologique , Nous recommandons d'utiliser une couche supplémentaire pour fusionner toutes les caractéristiques ,Comme le montre la figure1Comme indiqué.Donc,, L'équation de transition pour cette couche de fusion peut être écrite comme suit :

Pour chaque échantillon vidéo . Propulsé par le processus d'intégration Multi - capteurs des neurones primaires dans le système biologique , Nous recommandons d'utiliser une couche supplémentaire pour fusionner toutes les caractéristiques ,Comme le montre la figure1Comme indiqué.Donc,, L'équation de transition pour cette couche de fusion peut être écrite comme suit :

Parmi eux,EEtF Index de la dernière couche d'extraction des caractéristiques et de la couche de fusion, respectivement (C'est - à - dire:,F=E+1).Ici Représente la partie extraite de m Représentation intermédiaire des caractéristiques , La caractéristique passe d'abord par le poids

Représente la partie extraite de m Représentation intermédiaire des caractéristiques , La caractéristique passe d'abord par le poids  Effectuer une transformation linéaire,Ensuite, utilisezsigmoid Fonction non linéaire cartographiée à la nouvelle représentation

Effectuer une transformation linéaire,Ensuite, utilisezsigmoid Fonction non linéaire cartographiée à la nouvelle représentation  .

.

Puisque toutes les représentations des caractéristiques correspondent aux mêmes données vidéo , Il est donc facile de comprendre , Diverses caractéristiques peuvent être utilisées pour révéler des modèles potentiels communs liés à la sémantique vidéo .En outre,Comme indiqué précédemment, Différentes caractéristiques peuvent également être complémentaires , Parce qu'ils ont des caractéristiques différentes .Donc,, Le processus de fusion doit viser à saisir les relations entre les caractéristiques , Tout en conservant ses caractéristiques uniques . Nous n'avons pas simplement ajouté plusieurs informations caractéristiques , Au lieu de cela, une fonction objective a été spécialement conçue pour normaliser le processus de fusion , Pour explorer simultanément la corrélation et la diversité entre plusieurs caractéristiques .En particulier, Convertir toutes les caractéristiques en poids d'une représentation partagée  Tout d'abord, les vecteurs séparés sont PVecteur de dimension,Parmi euxP- Oui.

Tout d'abord, les vecteurs séparés sont PVecteur de dimension,Parmi euxP- Oui. Maintien de la paix

Maintien de la paix Le produit de la dimension .Ici., Nous supposons que les caractéristiques extraites ont la même dimension . Nous avons ensuite superposé ces vecteurs de coefficients dans une matrice

Le produit de la dimension .Ici., Nous supposons que les caractéristiques extraites ont la même dimension . Nous avons ensuite superposé ces vecteurs de coefficients dans une matrice  ,Parmi eux

,Parmi eux Chaque colonne correspond au poids d'une seule caractéristique .Donc,,Élément

Chaque colonne correspond au poids d'une seule caractéristique .Donc,,Élément Est donné comme suit: :

Est donné comme suit: :

Et puis, Nous pouvons concevoir la régularisation en fixant les objectifs suivants: DNN:

Parmi eux

![]()

Avec la formule standard du réseau neuronal à fonction unique 2 Par rapport à , La fonction de coût ci - dessus contient un terme de régularisation supplémentaire .Votre attention, s'il vous plaît.,Matrice Coefficient représentant toutes les caractéristiques . Nous utilisons ici une matrice symétrique semi - positive définie

Coefficient représentant toutes les caractéristiques . Nous utilisons ici une matrice symétrique semi - positive définie  Modéliser la corrélation entre les caractéristiques , Et introduire le dernier terme de régularisation en utilisant la norme trace , Cela aide à apprendre la relation entre les caractéristiques 【12,52】.Votre attention, s'il vous plaît.,ψ La valeur médiane la plus élevée indique une forte corrélation caractéristique , Les entrées plus petites représentent les différences entre les caractéristiques , Parce qu'ils sont moins pertinents .Coefficientλ1Etλ2 Contrôler la contribution des différents termes de régularisation .Enfin, Régularisation de l'apprentissage DNN L'objectif de la matrice de pondération W Et la matrice de corrélation caractéristique ψ Processus d'optimisation conjointe pour .

Modéliser la corrélation entre les caractéristiques , Et introduire le dernier terme de régularisation en utilisant la norme trace , Cela aide à apprendre la relation entre les caractéristiques 【12,52】.Votre attention, s'il vous plaît.,ψ La valeur médiane la plus élevée indique une forte corrélation caractéristique , Les entrées plus petites représentent les différences entre les caractéristiques , Parce qu'ils sont moins pertinents .Coefficientλ1Etλ2 Contrôler la contribution des différents termes de régularisation .Enfin, Régularisation de l'apprentissage DNN L'objectif de la matrice de pondération W Et la matrice de corrélation caractéristique ψ Processus d'optimisation conjointe pour .

3.4 Régularisation des relations de classe

Pour l'identification ou la classification CCatégories sémantiques, Vous pouvez simplement utiliser une à plusieurs stratégies pour vous entraîner indépendamment CClassificateur (s).Fig.2(a)Et(c) Décrit séparément le total des paramètres pour une seule caractéristique et plusieurs caractéristiques c Un à plusieurs programmes d'entraînement pour un réseau neuronal à quatre niveaux .Apparemment.,CesC Chacun des réseaux neuronaux est étudié individuellement , Ignorer complètement le partage des connaissances entre les différentes catégories sémantiques .Et pourtant,Tout le monde sait, La sémantique vidéo a aussi quelques points communs , Cela indique que certaines catégories sémantiques peuvent être fortement corrélées [19,36].Donc,, Il est essentiel d'explorer cette similitude en apprenant simultanément plusieurs sémantiques vidéo , Cela conduit généralement à une meilleure performance d'apprentissage .Attention!, Les similitudes entre plusieurs catégories sont souvent représentées par le partage de paramètres entre différents modèles de prévision [3,26]. Comparé à la méthode SVM populaire ,DNN Il est plus naturel d'effectuer plusieurs types d'entraînement simultanément .Comme le montre la figure2(b)Comme indiqué, En utilisant un ensemble de CUnité, Basé sur une seule caractéristique DNN Peut être facilement étendu à plusieurs types de problèmes , Cette structure a été largement utilisée .StandardMTLMéthodes[3,26] L'inspiration du cadre de régularisation utilisé dans , Nous proposons ici une régularisation DNN, Conçu pour former plusieurs Classificateurs en même temps , Explorez également les relations de classe . Pour renforcer le partage sémantique ,Nous avons fixé des normesDNN La cible originale de :

Attention!,Certains des anciensMTL Les relations de classe des hypothèses de travail sont explicitement données , Et peut être utilisé comme connaissance préalable [26], Et notre méthode n'a pas besoin de faire ça .SelonMTL La formule convexe de [52], Ici, nous avons le coefficient  Ajout d'une couche de sortie régulière de la norme trace à , Les relations de classe sont étendues aux variables matricielles

Ajout d'une couche de sortie régulière de la norme trace à , Les relations de classe sont étendues aux variables matricielles  .Attention aux contraintes

.Attention aux contraintes Indique que la matrice de relation de classe est semi - positive définie , Parce qu'il peut être considéré comme une mesure de similarité pour une classe sémantique .Coefficientλ1Etλ2Est un paramètre de régularisation.Dans le processus d'apprentissage, Matrice de pondération optimale {Wl}Ll=1 Et la matrice des relations de classe Ω Exporter en même temps.

Indique que la matrice de relation de classe est semi - positive définie , Parce qu'il peut être considéré comme une mesure de similarité pour une classe sémantique .Coefficientλ1Etλ2Est un paramètre de régularisation.Dans le processus d'apprentissage, Matrice de pondération optimale {Wl}Ll=1 Et la matrice des relations de classe Ω Exporter en même temps.

3.5 Objectifs communs

Afin d'harmoniser les objectifs susmentionnés dans un cadre commun , Nous proposons maintenant un nouveau DNNFormule, Cette formule explore les relations entre les caractéristiques et les classes .Dans notre cadre, Nous utilisons une couche de neurones pour fusionner plusieurs caractéristiques , .L'objectif est de combler l'écart entre les caractéristiques de bas niveau et la sémantique vidéo de haut niveau . Au dernier niveau où les prévisions sont générées , Nous appliquons la normalisation des traces entre différentes sémantiques , Pour mieux apprendre les prédictions de plusieurs classes .En mathématiques, On va mettre l'équation 4 Régularisation des caractéristiques et équations dans 5 Les classes sont régularisées et combinées dans les fonctions objectives suivantes :

Parmi euxλ1、λ2Etλ3Est un paramètre de régularisation.Et l'équation2 Par rapport à la cible originale , Nous avons deux termes de régularisation de la norme trace , Pour la fusion de plusieurs caractéristiques et l'exploration des relations entre les classes . Deux contraintes supplémentaires tr(ψ)=1Ettr(Ω) = 1 Pour limiter la complexité ,Par exemple:[52]Comme indiqué.Enfin, La fonction de coût décrite ci - dessus par rapport au poids du réseau {Wl}Ll=1、 Matrice des relations entre les caractéristiques ψ Et la matrice de corrélation entre les classes est minimisée Ω.

边栏推荐

猜你喜欢

随机推荐

十折交叉验证代码中的问题

AcWing 1921. Rearranging cows (ring diagram)

DS18B20数字温度计 (一) 电气特性, 寄生供电模式和远距离接线

890. find and replace mode

正则表达式 | 浅解

MySQL - built in function

Clj3-100alh30 residual current relay

AI - face

Drqueueonrails integrated LDAP authentication

The evil 203 in systemctl

Socket Programming TCP

arm各种交叉编译工具的区别

自然语言处理nlp 数据集下载地址

Byte order - how to judge the big end and the small end

Record the pits encountered when using JPA

Deep learning and CV tutorial (14) | image segmentation (FCN, segnet, u-net, pspnet, deeplab, refinenet)

Doris records service interface calls

MySQL45讲 01 | 基础架构:一条SQL查询语句是如何执行的?

LVS health state detection based on application layer

VirtualBox virtual machine shut down due to abnormal system. The virtual machine startup item is missing