当前位置:网站首页>NLP常用Backbone模型小抄(1)

NLP常用Backbone模型小抄(1)

2022-08-02 22:43:00 【Andy Dennis】

前言

自17年Transformer出现以来,NLP各大工作都出现它的身影。最近,斯坦福还专门为transformer开了一门课程CS25: 【Stanford】CS25 Transformers United | Fall 2021

刚入门NLP的人可以看看我之前写的一篇文章 研0_NLPer启程

对于对应的模型,可以去hugginface的transfomers库看看 transformers/models (github), 可以找到对应模型看看它的源码实现。

现在主要是结合上下文的动态词向量编码技术,很少使用word2vec, glove词表进行静态词向量映射了。

b站一个视频 吹爆!计算机博士【NLP自然语言处理】不愧是清华教授!5小时让我搞定了NLP自然语言处理! (虽然标题有些emm…但是看了一下目录啥的好像还行…

论文

Mass

Bart

T5

Exploring the Limits of Transfer Learning with a Unified

Text-to-Text Transformer

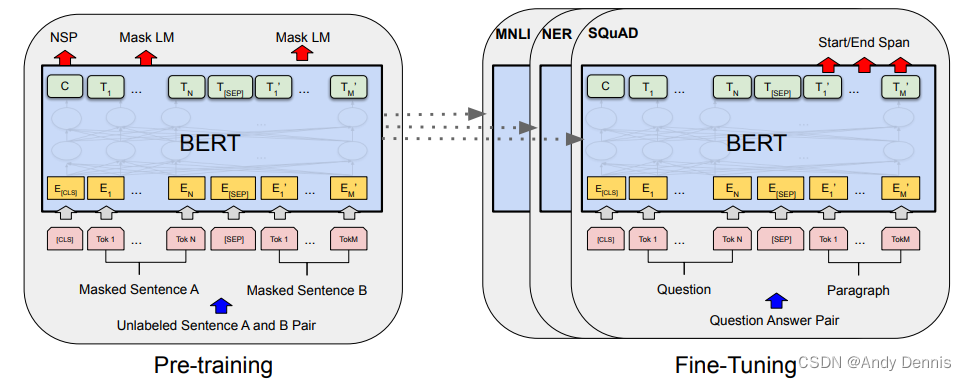

Bert

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

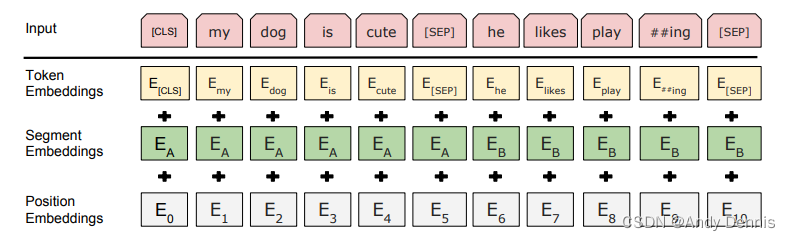

encoder结构。bert家族很多,如蒸馏版本distilBert, 变体Roberta等。

词向量输入构成:

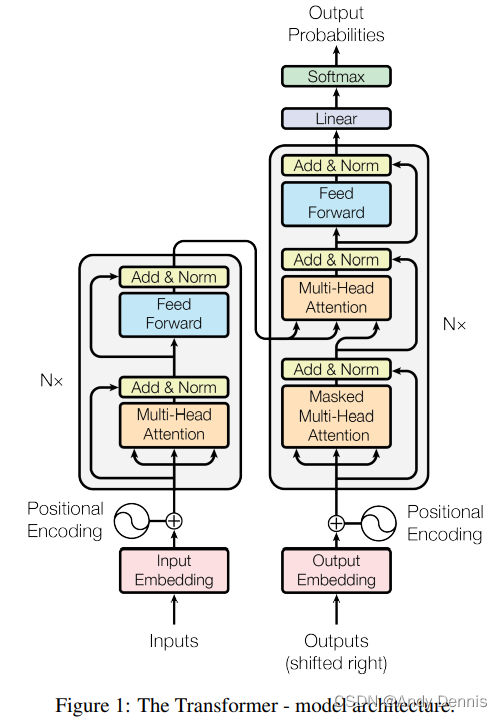

transformer

著名的self-attention就出自这篇文章.

Attention Is All You Need

之前复现过这个模型: transformer结构复现__attention is all you need (pytorch)

encoder-decoder结构:

Attention模块:

边栏推荐

猜你喜欢

随机推荐

工业元宇宙的价值和发展

Based on two levels of decomposition and the length of the memory network multi-step combined forecasting model of short-term wind speed

[论文总结] 深度学习在农业领域应用论文笔记10

redis的学习笔记

mysql 错误:The driver has not received any packets from the server.

虚拟内存 virualmemory

Controller层代码这么写,简洁又优雅!

# DWD层及DIM层构建## ,220801 ,

Auto.js实现朋友圈自动点赞

In-depth study TypeScript TypeScript 】 【 class (under)

Numpy数组中d[True]=1的含义

浅读一下dotenv的主干逻辑的源码

微信小程序(一)

scala 集合通用方法

WAF WebShell Trojan free to kill

21天学习挑战赛(1)设备树的由来

CodeTON Round 2 A - D

The only way to go from a monthly salary of 10k to 30k: automated testing

Word2Vec词向量训练、使用及可视化操作

无代码开发平台表单样式设置步骤入门课程