当前位置:网站首页>Copycat CNN: Stealing Knowledge by Persuading Confession with Random Non-Labeled Data阅读心得

Copycat CNN: Stealing Knowledge by Persuading Confession with Random Non-Labeled Data阅读心得

2022-08-04 16:39:00 【zzuls】

一、研究背景

这篇文章发布于2018年,发表在Computer Vision and Pattern Recognition上面,当时CNN在图像识别上如日中天,而CNN的应用也极为广泛。一般来说,一个优秀的CNN模型需要大量的人力和物力。不仅需要搭建模型,还需要宝贵的数据集和卓越的算力,才能构建一个CNN模型。

二、主要工作

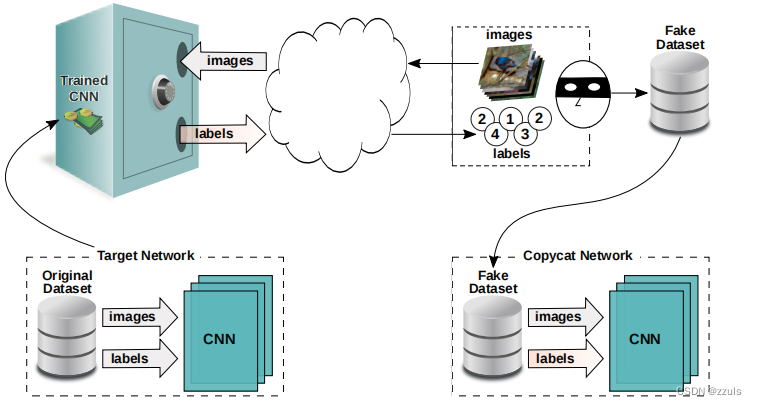

而作者的研究就是针对以CNN模型的攻击,他们通过向模型查询no-lable的数据,搭建一个数据集,然后再根据这个数据集训练出一个替代模型。

三、创新点

作者提出了一种针对CNN的模型窃取方法copycat,该方法并不需要目标模型的数据集,在高维的输入以及深层的模型上表现的都不错。

四、文章内容

1.introduction

CNN在图像分类和图像识别上面具有很好的表现,一个优秀的CNN模型具有很高的价值,这也使得CNN值得保护。作者提出了一种针对CNN的模型窃取方法copycat,如图一,他们通过向模型查询no-lable的数据,搭建一个数据集,然后再根据这个数据集训练出一个替代模型。

这个方法通过三种问题的解决效果来评估,分别是facial expression, object, and crosswalk classifification。

作者三大贡献:作者提出了一种针对CNN的模型窃取方法copycat,发现可以使用与目标模型训练集不相关的图像复制模型,该方法在不同的问题和大数据集上也适用。

2.RELATED WORKS

研究发现[1,2],复制一个CNN黑盒模型是可行的,他们可以通过模型查询的方式来构建一个替代模型, 在SVM、决策树和贝叶斯分类器上取得了成功。但是他们没有尝试DNN模型的窃取。在另外的研究中[3,4],[3]研究了将分类器(DNN,SVM,decision tree, nearest neighbor, and ensembles)迁移到另一个深度学习模型中。

作者与之前研究不同在于,作者提出的是复制目标模型然后生成替代模型,生成替代模型的过程不需要原始数据,选用来源广泛的互联网图像就可以完成复制。

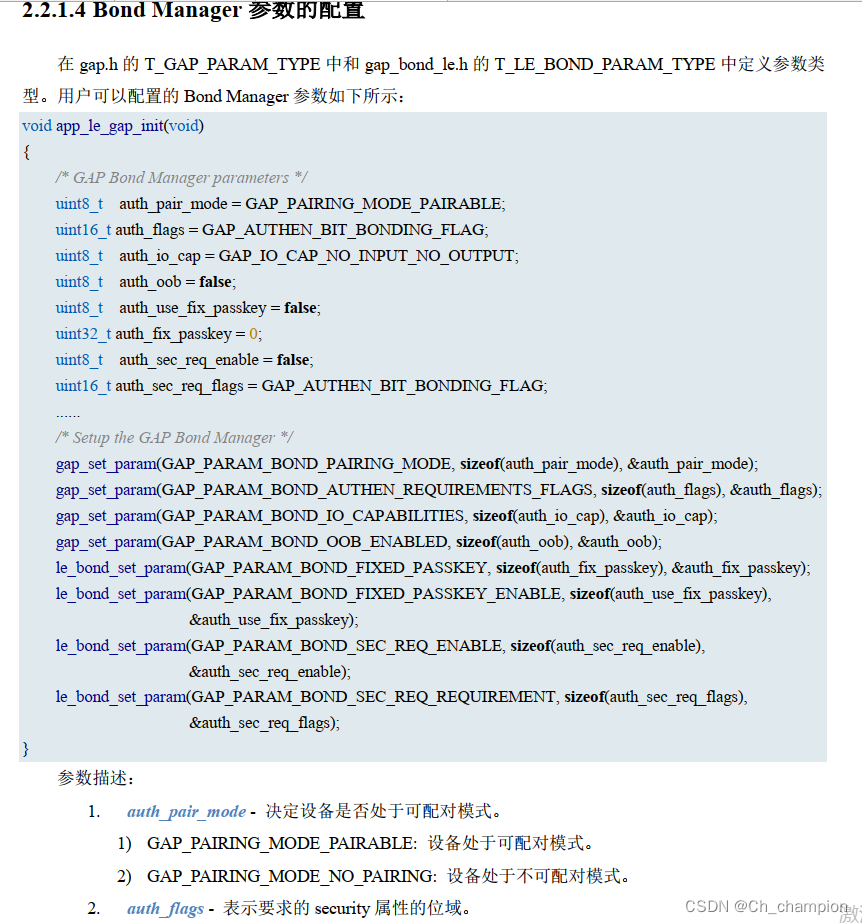

3.COPYCAT CONVOLUTIONAL NEURAL NETWORK

(1)Fake Dataset Generation

为了训练一个网络,需要一个数据集,使用目标模型的数据集固然是好的,但是一般来说攻击者很难得到目标模型的数据集,为此可以用其他方法。

作者搭建Fake Dateset的方法是从互联网上下载一些无标签的图片,这些图片可以与问题相关,也可以与问题无关。然后作者再使用目标模型的查询功能,将模型的输出作为数据的标签。

互联网上下载的数据可以与问题相关,也可以不相关,然后再利用数据增强技术,以便更好地利用目标模型的空间维度。

(2)Copycat Network Training

训练模型的关键是首先要确定目标模型的结构,这个确定的方法,作者没有,只是固定为VGG-16的结构。

然后就是根据构建的数据集训练模型,调整模型的参数然后得到提到模型。

五、reference

[1] F. Tramer, F. Zhang, A. Juels, M. K. Reiter, and T. Ristenpart, “Stealing machine learning models via prediction apis.” in USENIX Security Symposium, 2016, pp. 601–618.

[2] Y. Shi, Y. Sagduyu, and A. Grushin, “How to steal a machine learning classififier with deep learning,” in IEEE International Symposium on Technologies for Homeland Security (HST). IEEE, 2017, pp. 1–5.

[3] N. Papernot, P. D. McDaniel, and I. J. Goodfellow, “Transferability in machine learning: from phenomena to black-box attacks using adversarial samples,” CoRR, vol. abs/1605.07277, 2016

[4]N. Papernot, P. McDaniel, I. Goodfellow, S. Jha, Z. B. Celik, and A. Swami, “Practical Black-Box Attacks Against Machine Learning,” in Proceedings of the 2017 ACM on Asia Conference on Computer and Communications Security. ACM, 2017, pp. 506–519.

边栏推荐

- Real-Time Rendering 4th related resource arrangement (no credit required)

- 越来越火的图数据库到底能做什么?

- 【打卡】广告-信息流跨域ctr预估(待更新)

- Mobile magic box CM211-1_YS foundry _S905L3B_RTL8822C_wire brush firmware package

- 海报 | 夏季高温,危化品安全风险的注意事项必须get!

- HCIP笔记(8)

- 移动海信IP102H_905L3-B_线刷固件包

- 寻找消失的类名

- 《分布式云最佳实践》分论坛,8月11日深圳见

- 九联_UNT400G_S905L2_(联通)_线刷固件包

猜你喜欢

Steady Development | Data and Insights on Mobile Game Players in Western Europe

Minecraft HMCL 使用认证服务器LittleSkin进行登录

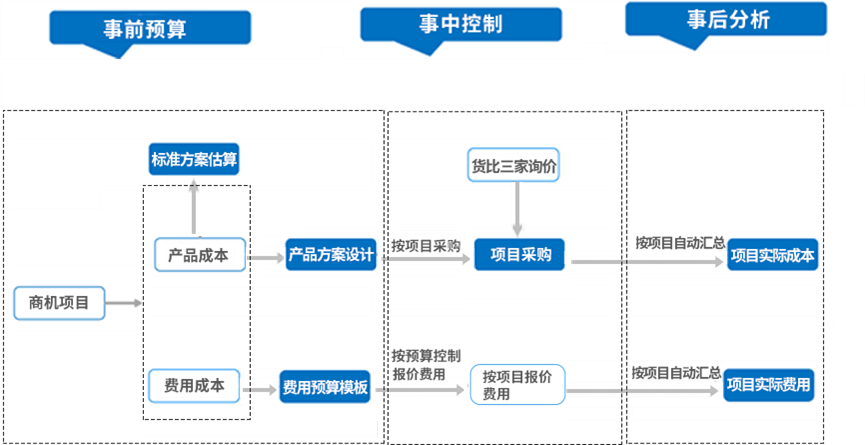

电气成套设备行业如何借助ERP系统,解决企业管理难题?

RTL8762DK 远端设备配对

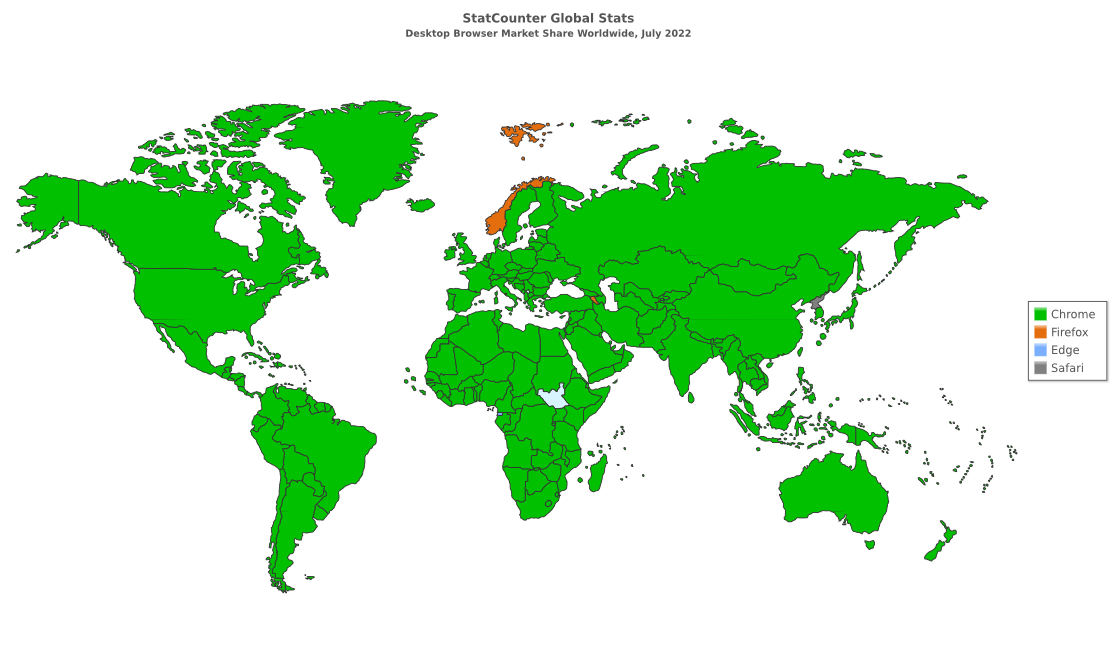

7 月浏览器市场份额:Edge 全球第二、360 安全浏览器中国第二

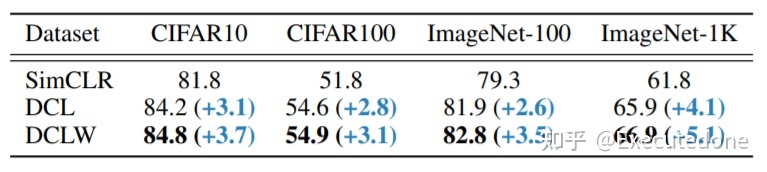

从正负样本解耦看对比学习为何需要large batch size训练Ddcoupled Contrastive learning (DCT)

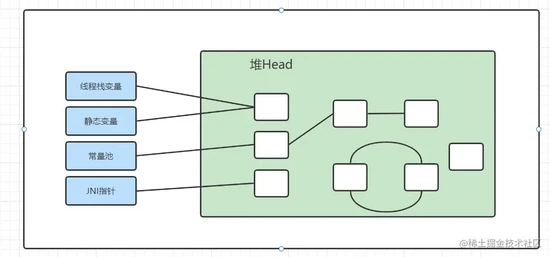

JVM Tuning-GC Fundamentals and Tuning Key Analysis

开一个羽毛球馆大概需要多少钱?大约15万左右可以搞定!

奖金池高达 20 万,RTE 2022 创新编程挑战赛正式开启

18 Data Collection Analysis

随机推荐

手把手教你搭建一个Minecraft 服务器

Visual Studio 2022创建项目没有CUDA模板的解决方法

服装店如何利用好积分?

黑龙江移动新魔百盒M411A_2+8_S905L3A_线刷固件包

8年软件测试感悟,送给刚入测试行业的小伙伴

8月5日,麒麟信安邀您相约鲲鹏开发者创享日·长沙站!

"Distributed cloud best practices" BBS, on August 11, shenzhen

DMS 有接口获取每个实例下的数据库列表吗

勒索软件的原理

NFT盲盒挖矿系统dapp开发NFT链游搭建

会话劫持安全攻击

贝叶斯优化核极限学习机KELM用于回归预测

【TA-霜狼_may-《百人计划》】美术2.7 Metallic 与 Speculer流程

葫芦娃解析

太一集团宣布全资收购火币旗下社交产品火信

It took half a month to finally make a collection of high-frequency interview questions of first-tier manufacturers

广东湛江海关破获3起走私冻海产品案 查证案值约1亿元

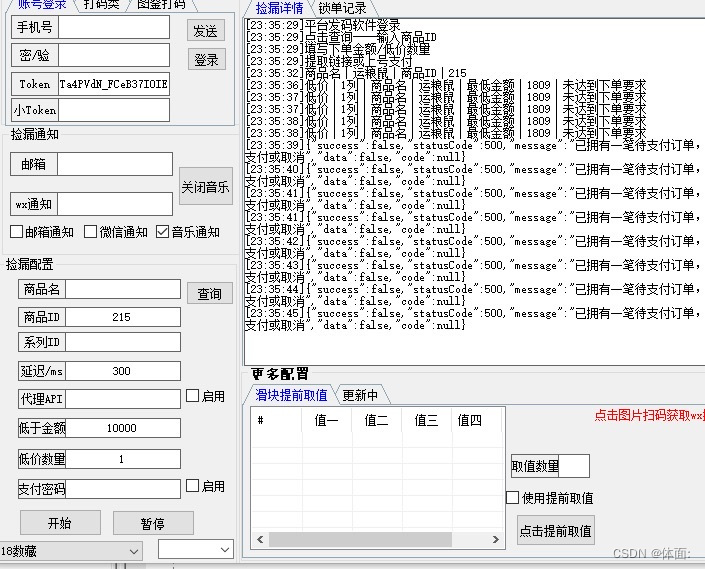

番茄插件番茄助手下载

redis

911S5正式谢幕后 如何找到一个好用的替代品