当前位置:网站首页>智能計算之神經網絡(BP)介紹

智能計算之神經網絡(BP)介紹

2022-06-22 20:21:00 【洋洋菜鳥】

目錄

1. 神經網絡流行原因

人工神經網絡之所以如此流行,源於人工神經網絡具有的特點和優越性,主要錶現在以下三個方面:

(1)具有自學習功能.例如,實現圖像識別時,只要先把許多不同的圖像樣板和對應的識別結果輸入人工神經網絡,網絡就會通過自學習功能,慢慢學會識別類似的圖像.自學習功能對於預測有特別重要的意義,預期未來的人工神經網絡計算機將為人類提供經濟預測,市場預測,效益預測,其應用前途是很遠大的.

(2)具有聯想儲存功能.用人工神經網絡的反饋網絡就可以實現這種聯想.(3)具有高速尋找優化解的能力.尋找一個複雜問題的優化解,往往需要很大的計算量,利用一個針對某問題而設計的反饋型人工神經網絡,發揮計算機的高速運算能力,可能很快找到優化解.

2. 人工神經網絡定義

人工神經網絡模擬人腦及其活動的一個數學模型,它由大量的處理單元(process element)通過適當的方式互聯構成,是一個大規模的非線性自適應系統.1988年,Hecht-Nielsen曾經對人工神經網絡給出了如下的定義:

“人工神經網絡是一個並行、分布處理結構,它由處理單元及稱為聯結的無向信號通道互聯而成.這些處理單元具有局部內存,並可以完成局部操作.每個處理單元有一個單一的輸出連接,這個輸出可以根據需要被分支多個並行聯結,而且這些並行聯結都輸出相同的信號,即相應處理單元的信號及其信號的太小不因分支的多少而變化.處理單元的輸出信號可以是任何需要的數學模型,每個處理單元中進行的操作必須是完全局部的.也就是說,它必須僅僅依賴於經過輸入聯結到達處理單元的所有輸入信號的當前值和儲存在處理單元局部範圍的值.”

該定義主要强調了神經網絡以下4個方面的內容:

(1)並行、分布處理結構;

(2)一個處理單元的輸出可以被任意分支且大小不變;

(3)輸出信號可以是任意的數學模型;

(4)處理單元的局部操作

這裏說的處理單元就是人工神經元(artificial neuron ,AN).

按照Rumellhart ,MeClelland , Hinton等提出的並行分布處理系統(paralleldistributed processing ,PDP)模型,人工神經網絡由以下8個方面的要素組成:

(1)一組處理單元(PE或AN);

(2)處理單元的激活狀態(a);

(3)每個處理單元的輸出函數(f);

(4)處理單元之間的聯結模式;

(5)傳遞規則;

(6)把處理單元的輸入及當前狀態結合起來產生激活值的激活規則(F);

(7)通過經驗修改聯結强度的學習規則;

(8)系統運行的環境(樣本集合).

1987年.Simpson從人工神經網絡的拓撲結構出發,給出了如下一個雖然不太嚴格但卻簡明扼要的定義:

“人工神經網絡是一個非線性的有向圖.圖中含有可以通過改變權值大小來存放模式的加權邊,並且可以從不完整或未知的輸入找到模式.”

對一般的應用來說,人工神經網絡除了可以叫做 PDP 以外,還可以叫做人工神經系統(ANS)、神經網絡(NN)、自適應系統(adaptive systems)、自適應網(adap-tive networks),聯結模型(connectionism)和神經計算機(neuron computer)等.

人工神經網絡不僅在形式上模擬了生物神經系統,它在以下兩個方面確實具有大腦的一些基本特征:

(1)神經元及其聯結.從系統構成的形式上看,由於人工神經網絡是受生物神經系統的啟發構成的,從神經元本身到聯結模式,基本上都是以與生物神經系統相似的方式工作的.這裏的AN與生物神經元(BN)相對應,可以改變强度的聯結則與突觸相對應.

(2)信息的儲存與處理.從錶現特征上來看,人工神經網絡也力求模擬生物神經系統的基本運行方式.例如,可以通過相應的學習/訓練算法,將蘊含在一個較大數據集中的數據聯系抽象出來,就像人們可以不斷地探索規律,總結經驗一樣,可以從先前得到的例子找出一般規律或一般框架,再按要求產生出新的實例.

3. 人工神經網絡的學習能力

人工神經網絡可以根據所在的環境來改變它的行為.也就是說,人工神經網絡可以接受用戶提交的樣本集合,依照系統給定的算法,不斷地修正用來確定系統行為的神經元之間聯結的强度,而且在網絡的基本構成確定之後,這種改變是根據其接受的樣本集合自然地進行的.一般來說,用戶不需要再根據所遇到的樣本集合去對網絡的學習算法作相應的調整,也就是說,人工神經網絡具有良好的學習功能.

神經網絡與傳統的人工智能系統的學習問題形成對照.在傳統的人工智能系統的研究中,雖然人們對“機器學習”問題給予了足够的重視並傾注了極大的努力,但是,系統的自學習能力差依然是阻礙這些系統獲得廣泛應用的最大障礙,而人工神經網絡具有良好的學習功能的這一性能,使得人們對它產生了極大的興趣.人工神經網絡的這一特性被稱為“自然具有的學習功能”.

在學習過程中,人工神經網絡不斷地從所接受的樣本集合中提取該集合所蘊含的基本信息,並將其以神經元之間的聯結權重的形式儲存在系統中.例如,對於某一模式,可以用它的含有不同噪聲的數據去訓練一個網絡,在這些數據選擇得比較恰當的前提下,使得網絡今後在遇到類似的含有一定缺陷的數據時,仍然能够得到它對應的完整的模式.這錶明,人工神經網絡可以學會按要求產生它從未遇到過的模式.人工神經網絡的這一功能叫做“抽象”.

4. 人工神經網絡的基本原理

神經元的結構如下:

在生物上有生物神經元,那生物神經元和人工神經元關系怎樣呢?

從圖中我們可大致得出人工神經元是如何模仿生物的神經元進行工作的過程:

5. 神經網絡的研究進展

6. 神經網絡的典型結構

人工神經網絡有很多種不同的模型,通常可按以下5個原則進行歸類。·

- 按照網絡的結構區分,有前向網絡和反饋網絡。

- 按照學習方式區分,有有監督學習網絡和無監督學習網絡。

- 按照網絡性能區分,有連續型和離散型網絡,隨機型和確定型網絡。·按照突觸性質區分,有一階線性關聯網絡和高階非線性關聯網絡。

- 按對生物神經系統的層次模擬區分,有神經元層次模型,組合式模型﹑網絡層次模型﹑神經系統層次模型和智能型模型。

6.1 單層感知器網絡

單層感知器是最早使用的,也是最簡單的神經網絡結構,由一個或多個線性閾值單元組成。

由於這種網絡結構相對簡單,因此能力也非常的有限,一般比較少用。

6.2 前饋型網絡

前饋型網絡的信號由輸入層到輸出層單向傳輸。

每層的神經元僅與其前一層的神經元相連,僅接受前一層傳輸來的信息。

是一種非常廣泛使用的神經網絡模型,因為它本身的結構也不太複雜,學習和調整方案也比較容易操作,而且由於采用了多層的網絡結構,其求解問題的能力也得到明顯的加强,基本上可以滿足使用要求。

6.3 前饋內層互聯網絡

這種網絡結構從外部看還是一個前饋型的網絡,但是內部有一些節點在層內互連。

6.4 反饋型網絡

這種網絡結構在輸入輸出之間還建立了另外一種關系,就是網絡的輸出層存在一個反饋回路到輸入層作為輸入層的一個輸入,而網絡本身還是前饋型的。

這種神經網絡的輸入層不僅接受外界的輸入信號,同時接受網絡自身的輸出信號。輸出反饋信號可以是原始輸出信號,也可以是經過轉化的輸出信號;可以是本時刻的輸出信號,也可以是經過一定延遲的輸出信號。

此種網絡經常用於系統控制、實時信號處理等需要根據系統當前狀態進行調節的場合。

6.5 全互聯網絡

全互聯網絡是網絡中所有的神經元之間都有相互間的連接。

如Hopfiled和Boltgmann網絡都是這種類型。

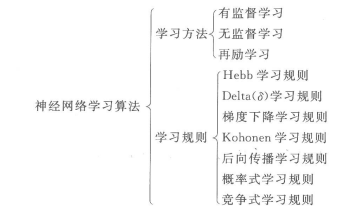

7. 神經網絡的學習算法

7.1 學習方法

- Supervised learning 監督學習:是有特征(feature)和標簽(label)的,即便是沒有標簽的,機器也是可以通過特征和標簽之間的關系,判斷出標簽。

- Unsupervised learning 無監督學習:只有特征,沒有標簽。

- Semi-Supervised learning 半監督學習:使用的數據,一部分是標記過的,而大部分是沒有標記的。和監督學習相比較,半監督學習的成本較低,但是又能達到較高的准確度。

- Reinforcement learning 强化學習:强化學習也是使用未標記的數據,但是可以通過一些方法知道你是離正確答案越來越近還是越來越遠(獎懲函數)。

7.2 學習規則

Hebb學習規則:簡單理解就是,如果處理單元從另一個處理單元接受到一個輸入,並且如果兩個單元都處於高度活動狀態,這時兩單元間的連接權重就要被加强。

Hebb學習規則是一種沒有指導的學習方法,它只根據神經元連接間的激活水平改變權重,因此此這種方法又稱為相關學習或並聯學習。

Delta(δ \deltaδ)學習規則:Delta規則是最常用的學習規則,其要點是改變單元間的連接權重來减小系統實際輸出與應有的輸出間的誤差。

這個規則也叫Widrow-Hoff學習規則,首先在Adaline模型中應用,也可稱為最小均方差規則。

BP網絡的學習算法稱為BP算法,是在Delta規則基礎上發展起來的,可在多層網絡上有效地學習。

梯度下降學習規則:梯度下降學習規則的要點為在學習過程中,保持誤差曲線的梯度下降。

誤差曲線可能會出現局部的最小值,在網絡學習時,應盡可能擺脫誤差的局部最小值,而達到真正的誤差最小值 。

目前我們接觸到的很多降低損失函數值的算法利用的就是梯度下降的學習規則。而梯度下降具體也有很多種類別,感興趣的可以自行去了解哦。

Kohonen學習規則:該規則是由Teuvo Kohonen在研究生物系統學習的基礎上提出的,只用於沒有指導下訓練的網絡。

後向傳播學習規則:後向傳播(Back Propagation,BP)學習,是應用非常廣泛的神經網絡學習規則。

概率式學習規則:從統計力學、分子熱力學和概率論中關於系統穩態能量的標准出發,進行神經網絡學習的方式稱概率式學習。

誤差曲線可能會出現局部的最小值,在網絡學習時,應盡可能擺脫誤差的局部最小值,而達到真正的誤差最小值 。

競爭式學習規則:競爭式學習屬於無監督學習方式。這種學習方式是利用不同層間的神經元發生興奮性聯接以及同一層內距離很近的神經元間發生同樣的興奮性聯接,而距離較遠的神經無產生抑制性聯接。

競爭式學習規則的本質在於神經網絡中高層次的神經元對低層次神經元的輸入模式進行競爭識別。

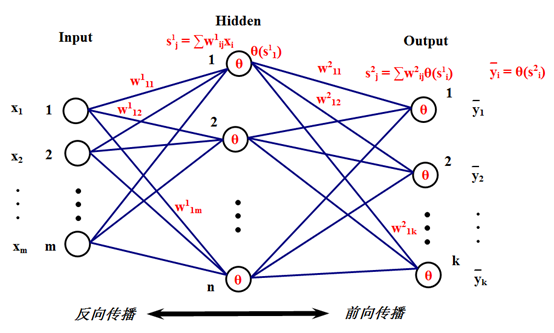

8. BP神經網絡

8.1 基本思想

BP神經網絡也稱:後向傳播學習的前饋型神經網絡(Back Propagation Feed-forward Neural Network,BPFNN/BPNN),是一種應用最為廣泛的神經網絡。

在BPNN中,後向傳播是一種學習算法,體現為BPNN的訓練過程,該過程是需要教師指導的;前饋型網絡是一種結構,體現為BPNN的網絡構架。

反向傳播算法通過迭代處理的方式,不斷地調整連接神經元的網絡權重,使得最終輸出結果和預期結果的誤差最小。

BPNN是一種典型的神經網絡,廣泛應用於各種分類系統,它也包括了訓練和使用兩個階段。由於訓練階段是BPNN能够投入使用的基礎和前提,而使用階段本身是一個非常簡單的過程,也就是給出輸入,BPNN會根據已經訓練好的參數進行運算,得到輸出結果。

8.2 算法流程

其實這個本質上與感知機的原理是有相似之處的。

步驟如下:

8.3 舉例

洋洋就介紹到這裏了,我也是初次學,請大家指教,有問題之間評論或私聊即可,看到就會回複哦,先說好,我不知我什麼時候會上線哦,有時候一個星期也不來一次的。哈哈哈!

边栏推荐

- socket的connect函数用法

- [in depth understanding of tcapulusdb technology] introduction tcapulusdb problem summary

- 自己写了一个telnet命令

- 【深入理解TcaplusDB技术】查看TcaplusDB线上运行情况

- 【深入理解TcaplusDB技术】单据受理之创建游戏区

- ZABBIX learning notes (37)

- Cloud computing in the metauniverse to enhance your digital experience

- [in depth understanding of tcapulusdb technology] tcapulusdb regular documents

- 【深入理解TcaplusDB技术】如何启动TcaplusDB进程

- mysql filesort要小心

猜你喜欢

随机推荐

Classic interview question: a page from entering URL to rendering process

[deeply understand tcapulusdb technology] realize tcapulusdb transaction management in the operation and maintenance platform

[in depth understanding of tcaplus DB technology] Introduction to tcaplus JDBC development

[deeply understand tcapulusdb technology] cluster management operation

ZABBIX learning notes (37)

播放增长900w,B站用户叫好叫座的恰饭总结

510000 prize pool invites you to join the war! The second Alibaba cloud ECS cloudbuild developer competition is coming

带超时的recv函数

Comment le sac à dos complet considère - t - il la disposition?

[deeply understand tcapulusdb technology] tcapulusdb model management

NFT 中可能存在的安全漏洞

Summary of 2019: 31 is just another start

Three months of self-taught automatic test, salary from 4.5K to 15K, who knows what I have experienced?

An IPFs enabled email - skiff

Async-profiler介绍

阿波罗使用注意事项

How should programmers look up dates

【深入理解TcaplusDB技术】如何启动TcaplusDB进程

Fibonacci search (golden section)

Matlab calling API

![[in depth understanding of tcaplus DB technology] getting started tcaplus SQL driver](/img/2b/3ab5e247ac103728b4d3579c3c5468.png)