当前位置:网站首页>Spark集群搭建

Spark集群搭建

2022-08-01 21:22:00 【xiexiexie0520】

Spark集群搭建

Standalone模式

1、上传解压

tar -zxvf spark-2.4.5-bin-hadoop2.7.tgz -C /usr/local/soft mv spark-2.4.5-bin-hadoop2.7 spark-2.4.52、修改配置文件

# 重命名文件 cp spark-env.sh.template spark-env.sh cp slaves.template slaves增加配置:

vim spark-env.shmaster相当于RM worker相当于NM

export SPARK_MASTER_IP=master export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=2 export SPARK_WORKER_INSTANCES=1 export SPARK_WORKER_MEMORY=2g export JAVA_HOME=/usr/local/soft/jdk1.8.0_171增加从节点配置:

vim slaves以node1、node2作为从节点

node1 node23、复制到其它节点

cd /usr/local/soft/ scp -r spark-2.4.5 node1:`pwd` scp -r spark-2.4.5 node2:`pwd`4、配置环境变量

5、在主节点执行启动命令

注意:start-all.sh 与Hadoop的sbin目录中的启动命令有冲突

cd /usr/local/soft/spark-2.4.5/ ./sbin/start-all.sh6、访问Spark Web UI

http://master:8080/7、测试及使用

切换目录:

cd /usr/local/soft/spark-2.4.5/examples/jarsstandalone client模式 :日志在本地输出,一般用于上线前测试

提交自带的SparkPi任务

spark-submit --class org.apache.spark.examples.SparkPi --master spark://master:7077 --executor-memory 512m --total-executor-cores 1 spark-examples_2.11-2.4.5.jar 100

standalone cluster模式:上线使用,不会在本地打印日志

提交自带的SparkPi任务

spark-submit --class org.apache.spark.examples.SparkPi --master spark://master:7077 --executor-memory 512M --total-executor-cores 1 --deploy-mode cluster spark-examples_2.11-2.4.5.jar 100

8、其他运行方式

spark-shell spark 提供的一个交互式的命令行,可以直接写代码

spark-shell master spark://master:7077

On Yarn模式

在公司一般不适用standalone模式

因为公司一般已经有yarn,不需要搞两个资源管理框架

Spark整合yarn只需要在一个节点整合,可以删除node1和node2中所有的Spark文件

1、停止Spark Standalone模式集群

# 切换目录 cd /usr/local/soft/spark-2.4.5/ # 停止集群 ./sbin/stop-all.sh2、增加hadoop 配置文件地址

vim spark-env.sh # 增加HADOOP_CONF_DIR export HADOOP_CONF_DIR=/usr/local/soft/hadoop-2.7.6/etc/hadoop3、关闭Yarn

stop-yarn.sh4、修改Yarn配置

cd /usr/local/soft/hadoop-2.7.6/etc/hadoop/ vim yarn-site.xml # 加入如下配置 <property> <name>yarn.nodemanager.pmem-check-enabled</name> <value>false</value> </property> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property>5、同步到其他节点

scp -r yarn-site.xml node1:`pwd` scp -r yarn-site.xml node2:`pwd`6、启动Yarn

start-yarn.sh7、测试及使用

切换目录:

cd /usr/local/soft/spark-2.4.5/examples/jarsSpark on Yarn Client模式:日志在本地输出,一班用于上线前测试

提交自带的SparkPi任务

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-client --executor-memory 512M --num-executors 2 spark-examples_2.11-2.4.5.jar 100

Spark on Yarn Cluster模式:上线使用,不会在本地打印日志

提交自带的SparkPi任务

spark-submit --class org.apache.spark.examples.SparkPi --master yarn-cluster --executor-memory 512m --num-executors 2 --executor-cores 1 spark-examples_2.11-2.4.5.jar 100获取yarn程序执行日志 执行成功之后才能获取到

yarn logs -applicationId application_1652086375126_0002

8、开启Spark On Yarn的WEB UI

修改配置文件:

# 切换目录 cd /usr/local/soft/spark-2.4.5/conf # 去除后缀 cp spark-defaults.conf.template spark-defaults.conf # 修改spark-defaults.conf vim spark-defaults.conf # 加入以下配置 spark.eventLog.enabled true spark.eventLog.dir hdfs://master:9000/user/spark/applicationHistory spark.yarn.historyServer.address master:18080 spark.eventLog.compress true spark.history.fs.logDirectory hdfs://master:9000/user/spark/applicationHistory spark.history.retainedApplications 15创建HDFS目录用于存储Spark History日志

hdfs dfs -mkdir -p /user/spark/applicationHistory启动Spark History Server

cd /usr/local/soft/spark-2.4.5/ ./sbin/start-history-server.sh

边栏推荐

- 磷酸化甘露糖苷修饰白蛋白纳米粒/卵白蛋白-葡聚糖纳米凝胶的

- 如何优雅的性能调优,分享一线大佬性能调优的心路历程

- C专家编程 第1章 C:穿越时空的迷雾 1.3 标准I/O库和C预处理器

- Popular explanation: what is a clinical prediction model

- 左旋氧氟沙星/载纳米雄黄磁性/As2O3磁性Fe3O4/三氧化二砷白蛋白纳米球

- 使用员工管理软件,解锁人力生产力新水平,提高人力资源团队灵活性

- 关于Request复用的那点破事儿。研究明白了,给你汇报一下。

- ORI-GB-NP半乳糖介导冬凌草甲素/姜黄素牛血清白蛋白纳米粒的研究制备方法

- How to encapsulate the cookie/localStorage sessionStorage hook?

- 如何让定时器在页面最小化的时候不执行?

猜你喜欢

随机推荐

R语言 数据的关系探索

C专家编程 第1章 C:穿越时空的迷雾 1.1 C语言的史前阶段

漏洞分析丨HEVD-0x6.UninitializedStackVariable[win7x86]

C陷阱与缺陷 附录B Koenig和Moo夫妇访谈

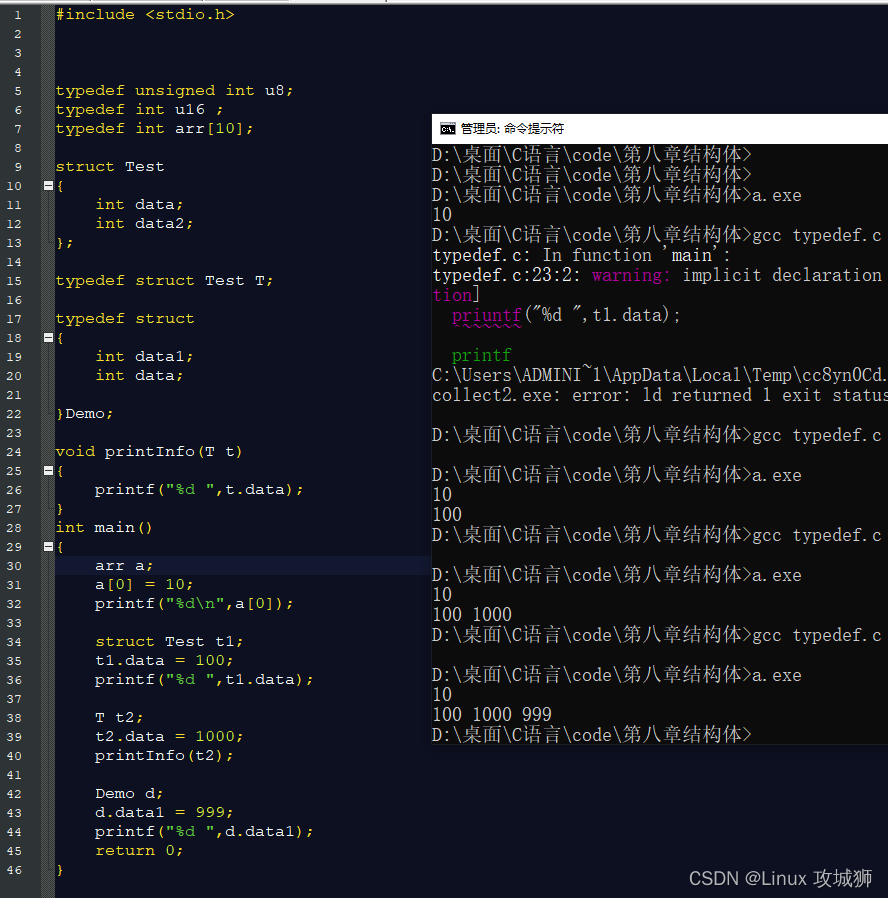

C语言_枚举类型介绍

C陷阱与缺陷 第8章 建议与答案 8.1 建议

【Unity实战100例】文件压缩Zip和ZIP文件的解压

C Pitfalls and Defects Chapter 7 Portability Defects 7.11 An Example of a Portability Problem

C Expert Programming Chapter 1 C: Through the Fog of Time and Space 1.5 ANSI C Today

Graph adjacency matrix storage

C Pitfalls and Defects Chapter 5 Library Functions 5.5 Library Function Signal

磷酸化甘露糖苷修饰白蛋白纳米粒/卵白蛋白-葡聚糖纳米凝胶的

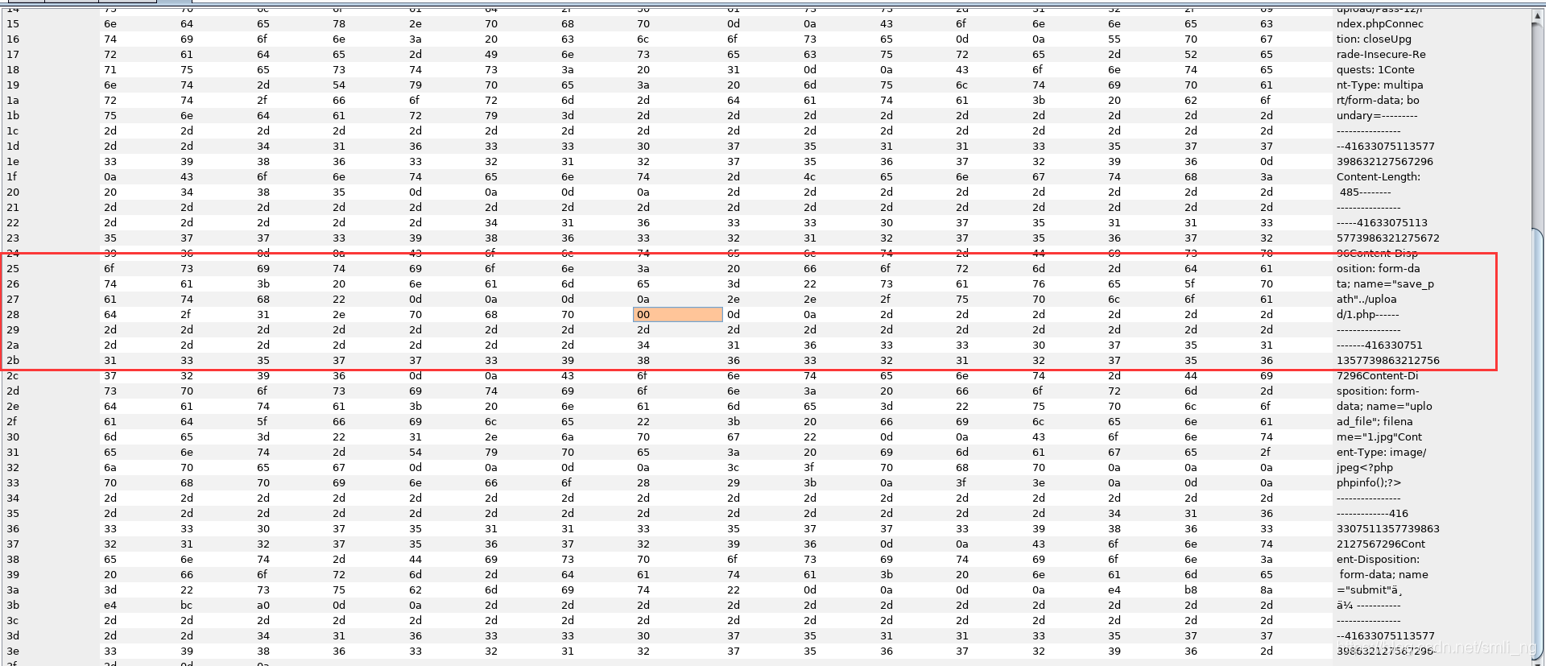

XSS漏洞

如何优雅的性能调优,分享一线大佬性能调优的心路历程

分类接口,淘宝分类详情 API

RecycleView的使用

如何让定时器在页面最小化的时候不执行?

C专家编程 第1章 C:穿越时空的迷雾 1.5 今日之ANSI C

记录第一次给开源项目提 PR

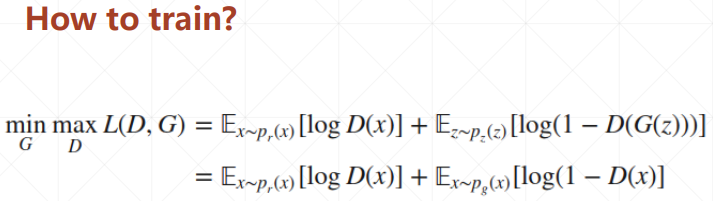

图像融合GANMcC学习笔记

![[Chinese tree tags - CTB]](/img/f4/b985da2ff83b2a9ab4eebb8bd060bf.png)