当前位置:网站首页>Pytorch - - Basic Reference North Deux élèves du secondaire peuvent comprendre [Rétropropagation et Gradient descendant]

Pytorch - - Basic Reference North Deux élèves du secondaire peuvent comprendre [Rétropropagation et Gradient descendant]

2022-07-01 01:59:00 【On dit que c'est zzy.】

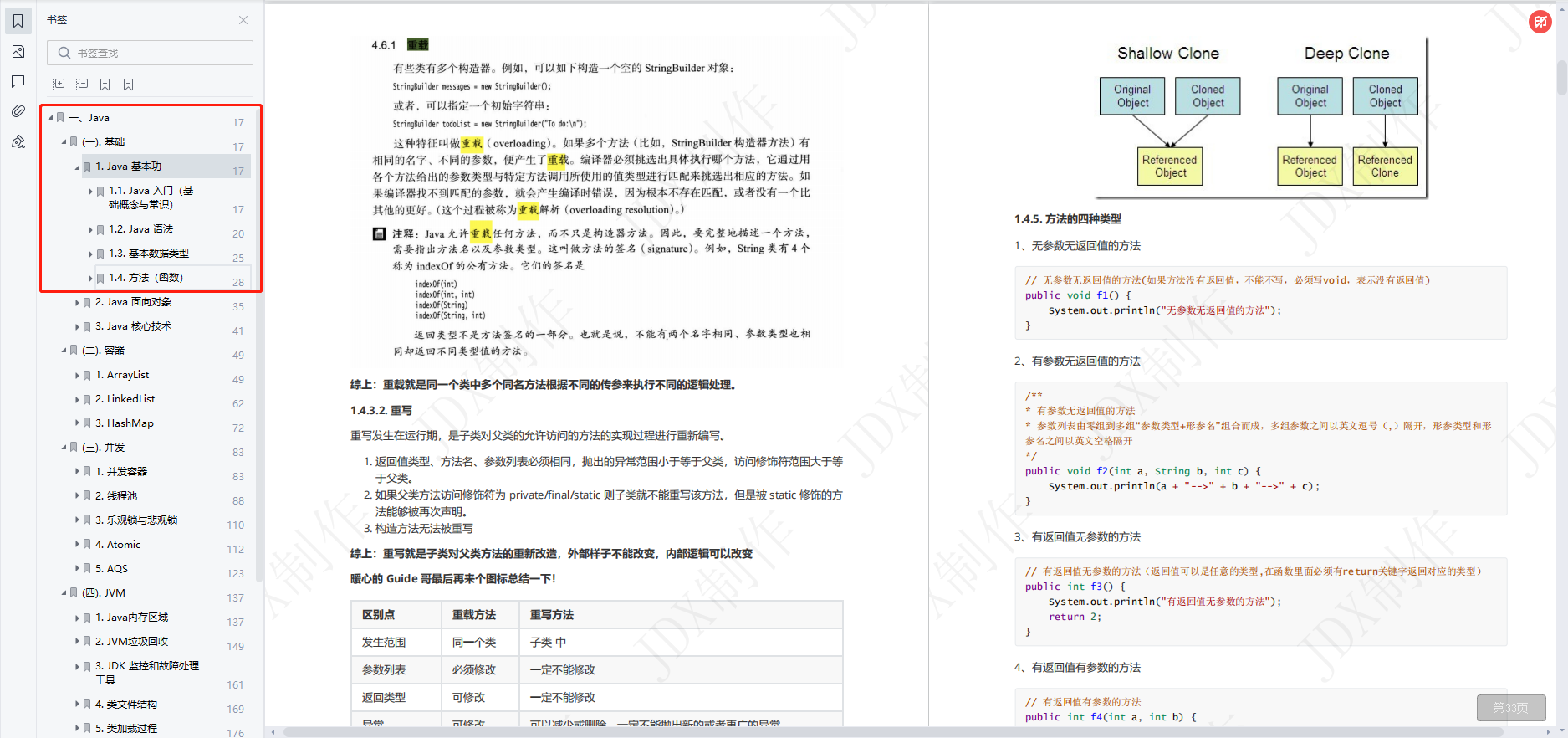

Pytorch ——Indice de base Nord_II.

Un cours que les élèves du secondaire peuvent lire!

Environnement logiciel:

- pytorch 1.10

- pycharm

Code d'accompagnement télécharger l'adresse:

Connaissances de base:

Pour former un réseau,La compréhension des gradients est essentielle,Voici quelques concepts de base pour les gradients.

0、Cosinus directionnel et unités vectorielles

Le cosinus directionnel est un concept courant dans les vecteurs,Il est utilisé pour orienter un vecteur,Ça pourrait être un brouillard.,Mais c'est bon.,Nous utilisons des dessins pour comprendre.

Par exemple,,Comme le montre la figure ci - dessous, il y a un système de coordonnéesxoy,Les effets sont les suivants::

Qui contient un vecteur l → \overrightarrow{l} l ,Les coordonnées du vecteur sont: ( a , b ) (a,b) (a,b)

Le vecteur ci - dessus satisfait alors à l'équation suivante::

( a a 2 + b 2 , b a 2 + b 2 ) (\frac{a}{\sqrt{a^2+b^2}},\frac{b}{\sqrt{a^2+b^2}}) (a2+b2a,a2+b2b)

L'équation ci - dessus est en fait une unit é vectorielle,Le vecteur nouvellement généré,C'est ce qu'on disaitVecteur directionnel.

Les vecteurs directionnels peuvent en fait être optimisés, Nous voyons qu'il y a deux autres angles marqués sur la photo qui sont α Et β \alphaEt\beta αEtβ, Il n'y a plus beaucoup à dire sur la relation entre les deux. , Et ils ont des points de vue complémentaires , La condition à remplir est que l'addition est égale à 90Degré.

Nous pouvons alors transformer cette formule en une telle forme :

a a 2 + b 2 = cos α \frac{a}{\sqrt{a^2+b^2}} = \cos{\alpha} a2+b2a=cosα

De même, il y a:

b a 2 + b 2 = cos β \frac{b}{\sqrt{a^2+b^2}} = \cos{\beta} a2+b2b=cosβ

Expression d'un vecteur dans cette direction ,Peut être écrit comme suit::

( a a 2 + b 2 , b a 2 + b 2 ) = ( cos α , s i n α ) (\frac{a}{\sqrt{a^2+b^2}},\frac{b}{\sqrt{a^2+b^2}}) =(\cos{\alpha},sin{\alpha}) (a2+b2a,a2+b2b)=(cosα,sinα)

En fait, parce que la congruence angulaire peut être transformée en :

( c o s α , c o s β ) (cos{\alpha},cos{\beta}) (cosα,cosβ)

1、Dérivation partielle de la fonction multivariée

Fonction univariée,C'est - à - dire qu'il y a un argument.Similaire f ( x ) f(x) f(x)

Fonction multivariée,C'est - à - dire qu'il y a plusieurs arguments.Similaire f ( x , y , z ) , Trois - Oui. Depuis Changement Quantité x , y , z f(x,y,z),Trois argumentsx,y,z f(x,y,z),Trois- Oui.DepuisChangementQuantitéx,y,z

Dans le processus de dérivation partielle de la fonction multivariée:Dérivation d'un argument,D'autres arguments peuvent être considérés comme des constantes

Exemple1:

Exemple2:

Exemple3:

Exercice:

Connu pour J ( a , b , c ) = 3 ( a + b c ) , Ordre u = a + v , v = b c J(a,b,c) = 3(a+bc),Ordreu=a+v,v = bc J(a,b,c)=3(a+bc),Ordreu=a+v,v=bc,S'il te plaît.a,b,cDérivée partielle respective.

2、Dérivée directionnelle:

En termes simples, la Dérivée directionnelle décrit la satisfaction d'une relation(Y=KX+B),Pour le taux de variation numérique de cette relation dans toutes les directions(YTaux de variation)Expression quantitative pour.

Dérivation mathématique,Voir l'article suivant. Mais je n'ai pas pu le comprendre une fois que j'ai fini , Ça ne devrait pas être si difficile à comprendre , Réfléchissons à l'envers. , Pouvez - vous construire à partir de la base précédente quelle est exactement la Dérivée directionnelle .

Dérivée directionnelle1 Chapitre I

De 2D、 3 - D Start

Dans une relation 2D Y=KX+B Nous ne comprenons pas très bien ce qu'est une Dérivée directionnelle , Nous savons que pour une fonction , y = k x + b y=kx+b y=kx+b La dérivée de :

Pour un point d'une fonction , La dérivée est égale à la pente de la tangente à ce point , C'est un concept extrême. . Autant comprendre le processus de cette limite :

L'image suivante montre une fonction , Il contient trois points comme suit: :

Parmi euxA、B Est deux points aléatoires sur une fonction .Parmi euxA、B Deux points sont satisfaits comme suit: :

A = ( x 0 , f ( x 0 ) ) B = ( x 0 + Δ x , f ( x 0 + Δ ) ) A= (x_0,f(x_0))\\ B= (x_0+\Delta x,f(x_0+\Delta)) A=(x0,f(x0))B=(x0+Δx,f(x0+Δ))

Et puisAB Connexion à deux points ,Pour former unSécant, La pente de la tangente satisfait aux conditions suivantes: :

k A B = f ( x 0 + Δ x ) − f ( x 0 ) ( x 0 + Δ x ) − x 0 = f ( x 0 + Δ x ) − f ( x 0 ) Δ x k_{AB} = \frac{f(x_0+\Delta x) - f(x_0)}{(x_0+\Delta x) - x_0} = \frac{f(x_0+\Delta x) - f(x_0)}{\Delta x} kAB=(x0+Δx)−x0f(x0+Δx)−f(x0)=Δxf(x0+Δx)−f(x0)

Lorsque: , Produit des tangentes et des dérivés :

QuandBL'infini s'approche deAQuand,C'est - à - dire: Δ x \Delta x ΔxL'infini s'approche de0Quand,SécantAB Se transforme en tangente ,Comme suit:

Les relations mathématiques satisfaisantes sont les suivantes: :

KaTeX parse error: Undefined control sequence: \varliminf at position 11: k_{ab} = \̲v̲a̲r̲l̲i̲m̲i̲n̲f̲_{\Delta x \to …

Et nous savons que la pente de la tangente est la valeur de la dérivée , C'est en 2D. .

Dérivé directionnel 3D

Dans le cas bidimensionnel, nous le savons déjà. , On va l'étendre au cas tridimensionnel et essayer ,Par exemple,:

Commençons par la définition suivante. :

En général, la Dérivée directionnelle d'une fonction à trois bits est en fait plane XOYPlus haut ( x , y ) (x,y) (x,y) Valeur de la fonction 3D f ( x , y ) f(x,y) f(x,y), Et ce qu'il représente ( x , y , f ( x , y ) ) (x,y,f(x,y)) (x,y,f(x,y))Par vecteurl Le vecteur directionnel de (Point(x,y)) Valeur d'une tangente de .

C'est abstrait., Prenons un exemple pour le comprendre. :

La parabole circulaire de la fonction 3D est approximativement la suivante: :

Z = x 2 + y 2 Z = x^2+y^2 Z=x2+y2

Comme le montre la figure:

Ça a l'air compliqué, mais ça va. , Nous comptons sur la couleur pour distinguer :

Le rouge contient deux parties :RespectivementxyPoint plat ( x , y ) (x,y) (x,y) Et la courbe de la Section .

Orange contient deux parties : l → \overrightarrow{l} l - Oui. X O Y XOY XOY L'avion(Système de coordonnées cartésiennes)Vers le Haut P ( X 0 , Y 0 ) P(X_0,Y_0) P(X0,Y0)Un rayon au début, e l = ( cos α , cos β ) e_l = ( \cos \alpha , \cos \beta) el=(cosα,cosβ) Oui L Vecteur unitaire dans la même direction. Il contient également un plan construit à partir de son vecteur directionnel A.

La partie bleue contient un contenu :C'est une fonction.Z.

Voyons ce que ça veut dire.

Quand il y a un point cDu point(x,y) Le départ change le long du vecteur directionnel t t tQuand, Les coordonnées sont les suivantes: :

C = ( x + t c o s α , y + t c o s β ) ( Le Moyenne Angle Degré Et Allez. Texte Moyenne De - Oui. Un. Échantillons Italie Justice ) C = (x+tcos{\alpha},y+tcos{\beta}) ( L'angle a le même sens que ci - dessus. ) C=(x+tcosα,y+tcosβ)(LeMoyenneAngleDegréEtAllez.TexteMoyenneDe- Oui.Un.ÉchantillonsItalieJustice)

À ce moment - là.c Le point est en fait une ligne noire pointillée lLe point sur. Et cette trajectoire vectorielle est un vecteur , Sa direction et l Le vecteur de direction du vecteur est le même , Et une courbe est cartographiée en fonction , Comme indiqué dans la courbe de la partie rouge , Nous considérons un cas particulier pour cette courbe , Lorsque cette condition est remplie , Comment la courbe change - t - elle? ?

Oui, c'est le cas en 2D ci - dessus. :

Le résultat est exactement le même, C'est juste que la tangente ici correspond à la tangente sur la courbe , Nous obtenons ici la définition de la Dérivée directionnelle comme suit :

∂ f ∂ l ∣ ( x 0 , y 0 ) = lim t → 0 + f ( x 0 + t cos α , y 0 + t cos β ) − f ( x 0 , y 0 ) t \left. \frac{\partial f}{\partial l}\right|_{\left(x_{0}, y_{0}\right)}=\lim _{t \rightarrow 0^{+}} \frac{f\left(x_{0}+t \cos \alpha, y_{0}+t \cos \beta\right)-f\left(x_{0}, y_{0}\right)}{t} ∂l∂f∣∣∣∣(x0,y0)=t→0+limtf(x0+tcosα,y0+tcosβ)−f(x0,y0)

À partir de la définition de la Dérivée directionnelle,Dérivée directionnelle ∂ f ∂ l ∣ ( x 0 , y 0 ) C'est une fonction. f ( x , y ) Au point P 0 ( x 0 , y 0 ) Direction l Taux de variation. \text { À partir de la définition de la Dérivée directionnelle,Dérivée directionnelle }\left.\frac{\partial f}{\partial l}\right|_{\left(x_{0}, y_{0}\right)} \text { C'est une fonction. } f(x, y) \text { Au point } P_{0}\left(x_{0}, y_{0}\right) \text { Direction } l \text { Taux de variation. } À partir de la définition de la Dérivée directionnelle,Dérivée directionnelle ∂l∂f∣∣∣∣(x0,y0) C'est une fonction. f(x,y) Au point P0(x0,y0) Direction l Taux de variation.

Théorème:

Si la fonction f ( x , y ) Au point P 0 ( x 0 , y 0 ) Différenciable,Donc la fonction est dans n'importe quelle direction à ce point La Dérivée directionnelle existe pour,Et il y a : \text { Si la fonction } f(x, y) \text { Au point } P_{0}\left(x_{0}, y_{0}\right) \text { Différenciable,Donc la fonction est dans n'importe quelle direction à ce point La Dérivée directionnelle existe pour,Et il y a :} Si la fonction f(x,y) Au point P0(x0,y0) Différenciable,Donc la fonction est dans n'importe quelle direction à ce point La Dérivée directionnelle existe pour,Et il y a :

∂ f ∂ l ∣ ( x 0 , y 0 ) = f x ( x 0 , y 0 ) cos α + f y ( x 0 , y 0 ) cos β Note: Italie - Oui. Face Pour Déviation Guide C'est International Allez. Juste Points Solution Oui. C'est X Y Axe Allez. Lettre Nombre Changement De Taux \left.\frac{\partial f}{\partial l}\right|_{\left(x_{0}, y_{0}\right)}=f_{x}\left(x_{0}, y_{0}\right) \cos \alpha+f_{y}\left(x_{0}, y_{0}\right) \cos \beta \\Notez qu'il y a une déviation à l'intérieur. En fait, il s'est décomposé enX YTaux de variation de la fonction sur l'axe ∂l∂f∣∣∣∣(x0,y0)=fx(x0,y0)cosα+fy(x0,y0)cosβNote:Italie- Oui.FacePourDéviationGuideC'estInternationalAllez.JustePointsSolutionOui.C'estXYAxeAllez.LettreNombreChangementDeTaux

Parmi eux, cos α Et cos β \cos \alpha \text { Et } \cos \beta cosα Et cosβC'est un vecteur. l l l Cosinus directionnel de.

Encore une fois, quelle est la différence entre la Dérivée directionnelle et la dérivée partielle ?

Un cas particulier de Dérivée directionnelle réelle dérivée partielle , Lorsque le vecteur est pris x Sur l'axe positif , La Dérivée directionnelle se transforme en xDérivée partielle de,Les résultats sont les suivants::

∂ f ∂ l ∣ ( x 0 , y 0 ) = lim t → 0 + f ( x 0 + t cos α , y 0 ) − f ( x 0 , y 0 ) t \left.\frac{\partial f}{\partial l}\right|_{\left(x_{0}, y_{0}\right)} = \lim _{t \rightarrow 0^{+}} \frac{f\left(x_{0}+t \cos \alpha, y_{0}\right)-f\left(x_{0}, y_{0}\right)}{t} ∂l∂f∣∣∣∣(x0,y0)=t→0+limtf(x0+tcosα,y0)−f(x0,y0)

Si vous regardez attentivement, vous verrez que la définition ici est en fait la définition de dérivée partielle , C'est une sorte de Dérivée directionnelle. .

Encore une fois. , Quel est le sens de cette formule? :

∂ f ∂ l ∣ ( x 0 , y 0 ) = f x ( x 0 , y 0 ) cos α + f y ( x 0 , y 0 ) cos β \left.\frac{\partial f}{\partial l}\right|_{\left(x_{0}, y_{0}\right)}=f_{x}\left(x_{0}, y_{0}\right) \cos \alpha+f_{y}\left(x_{0}, y_{0}\right) \cos \beta ∂l∂f∣∣∣∣(x0,y0)=fx(x0,y0)cosα+fy(x0,y0)cosβ

En fait,, C'est cette formule que nous utilisons pour calculer la Dérivée directionnelle , Cette formule décompose le vecteur de direction correspondant en xAxe ety Le cosinus directionnel de l'axe est calculé , C'est - à - dire que le vecteur directionnel est en fait xAxe ety Formé par le cosinus directionnel de l'axe .

Et pour utiliser le même point , La Dérivée directionnelle formée par différents vecteurs directionnels est également de taille différente , Mais la direction de ces dérivés directionnels sera toujours dans un plan , Ce plan est le plan tangent de ce point. !

3、Gradient:

Le Gradient est un cas particulier de Dérivée directionnelle:

gradf ( x , y ) = ∂ f ∂ x i ˙ + ∂ f ∂ y j ˙ \operatorname{gradf}(x, y) = \frac{\partial f}{\partial x} \dot{i}+\frac{\partial f}{\partial y} \dot{j} gradf(x,y)=∂x∂fi˙+∂y∂fj˙

On sait qu'il existe les relations suivantes pour les dérivés directionnels en un point:

∂ f ∂ l = ∂ f ∂ x cos φ + ∂ f ∂ y sin φ = { ∂ f ∂ x , ∂ f ∂ y } ⋅ { cos φ , sin φ } \frac{\partial f}{\partial l}=\frac{\partial f}{\partial x} \cos \varphi+\frac{\partial f}{\partial y} \sin \varphi=\left\{\frac{\partial f}{\partial x}, \frac{\partial f}{\partial y}\right\} \cdot\{\cos \varphi, \sin \varphi\} ∂l∂f=∂x∂fcosφ+∂y∂fsinφ={ ∂x∂f,∂y∂f}⋅{ cosφ,sinφ}

Dans la direction **L **Les vecteurs unitaires suivants sont satisfaits:

e → = cos φ i → + sin φ j ⃗ → \overrightarrow{\boldsymbol{e}}=\cos \varphi \overrightarrow { \boldsymbol{i}}+\sin \varphi \overrightarrow{ \vec{j} } e=cosφi+sinφj

Ensuite, la Dérivée directionnelle peut être convertie comme suit::

$$

\frac{\partial f}{\partial l}

\begin{equation}

\operatorname{gradf}(x, y)

\end{equation} * \overrightarrow{\boldsymbol{e}}

$$

Le produit dot équivaut à une projection,Dérivée directionnelle Et Gradient Maintenir un angle entre(Fais un peu de produit.)Pour former des dérivés directionnels dans toutes les directions.Quand le vecteur directionnel est - il le plus grand??

Il est facile de penser qu'il peut être satisfait quand il n'y a pas d'angle,Parce qu'à ce stade, le produit maximal du point satisfait aux conditions suivantes:

KaTeX parse error: No such environment: equation at position 8: \begin{̲e̲q̲u̲a̲t̲i̲o̲n̲}̲ \text { Seulement si }…

Le Gradient d'une fonction à un certain point est un vecteur,Sa direction correspond à celle de la Dérivée directionnelle maximale,Sa taille est exactement la plus grande Dérivée directionnelle.

Compréhension du concept de gradient:Comme le montre la figure ci - dessous,InpPoint isotherme pour placer une source de chaleur,La source de chaleur rayonne de l'intérieur vers l'extérieur10°、20°、30°、40°,Si une petite fourmioPoint,Pour échapper le plus rapidement possible à la chaleur,On devrait y aller.ojDirection de la fuite,Si...omLe taux de changement de la source de chaleur est0,Depuis toujours.20°,C'est - à - dire qu'une fois que la fourmi a identifié une direction de fuite(0°,90°)Angle de fuite,Continuez dans cette direction.,Est la direction la plus rapide de la baisse de la source de chaleur

Pour une fonction linéaire unidimensionnelle, sa dérivée est un gradient.

La relation entre le gradient et la dérivée de diverses fonctions:

Pour une explication plus détaillée, veuillez consulter les liens aux références.

TensorGradient et Rétropropagation

Examen de l'apprentissage automatique

Collecte de données x x x ,Construire un modèle d'apprentissage automatique f f f,Je l'ai. f ( x , w ) = Y p r e d i c t f(x,w) = Y_{predict} f(x,w)=Ypredict

Comment juger si le modèle est bon ou mauvais?Méthode de jugement du modèle:

loss = ( Y p r e d i c t − Y true ) 2 (Retour à la perte) loss = Y true ⋅ log ( Y predict ) (Pertes classées) \begin{array}{ll} \operatorname{loss}=\left(Y_{p r e d i c t}-Y_{\text {true }}\right)^{2} & \text { (Retour à la perte) } \\ \operatorname{loss}=Y_{\text {true }} \cdot \log \left(Y_{\text {predict }}\right) & \text { (Pertes classées) } \end{array} loss=(Ypredict−Ytrue )2loss=Ytrue ⋅log(Ypredict ) (Retour à la perte) (Pertes classées)

Adoption de la décision finale l o s s loss loss La sortie de,Pour calculer la taille du gradient et ajuster la taille du paramètre pour obtenir la solution optimale.

Quand l o s s loss loss Comme le montre la figure

Après avoir calculé le gradient:Opération dans la direction du changement de gradient,Sélectionner au hasard un point de départ w 0 w_0 w0,Par ajustement w 0 w_0 w0,Jean l o s s loss loss La fonction obtient la valeur minimale.

w w wMéthodes de mise à jour pour:

- Calcul w w wLe gradient de(Dérivée)

$$

\begin{align*}

\nabla w = \frac{f(w+0.000001)-f(w-0.000001)}{2*0.000001}

\end{align*}

$$

- Mise à jour w w w

w = w − α ∇ w w = w - \alpha \nabla w w=w−α∇w

Parmi eux:

- $\nabla w <0 $ ,Ce qui signifiewVa augmenter

- $\nabla w >0 $ ,Ce qui signifiewSera réduit

Résumé:Le Gradient est la tendance changeante des paramètres de la fonction multivariée(Orientation de l'apprentissage des paramètres),Lorsqu'il n'y a qu'un seul argument appeléDérivée,Est appelé dérivé partiel lorsqu'il y a plusieurs.

Rétropropagation?

Diagramme de calcul

Pour faciliter la description,Les fonctions sont décrites graphiquement.

J ( a , b , c ) = 3 ( a + b c ) , Ordre u = a + v , v = b c J(a,b,c) = 3(a+bc),Ordreu=a+v,v = bc J(a,b,c)=3(a+bc),Ordreu=a+v,v=bc,Le dessiner dans un diagramme de calcul peut être représenté comme suit::

La dérivation partielle pour chaque noeud peut avoir:

Le processus de Rétropropagation est un processus de droite à gauche illustré ci - dessus,Arguments a , b , c a,b,c a,b,cLa dérivée partielle respective est le produit du gradient sur la ligne:

KaTeX parse error: No such environment: align* at position 8: \begin{̲a̲l̲i̲g̲n̲*̲}̲ \frac{dJ}{da} …

Pourquoi la Rétropropagation??

Parce que pour calculer le gradient.

Démonstration sur le terrain:

Ensuite, essayez de calculer le gradient d'une structure simple,Le problème est décrit ci - dessous:

Supposons que notre modèle de base soity = wx+b,Parmi euxwEtbSont des paramètres,Nous utilisonsy = 3x+0.8Pour construire des donnéesx、y,Donc, en fin de compte, le modèle devrait être capable dewEtbOn devrait s'approcher séparément.3Et0.8.

En termes simples, il s'adapte à la satisfactiony = 3x+0.8Cette courbe.

Les étapes sont divisées en quatre étapes:

# 1 Données de construction

# 2 Conception propagation vers l'avant Et Fonction de Rétropropagation Pour former le réseau

# 3 Formation

# 4 Dessiner une courbe ajustée

Le processus est illustré comme suit::

De gauche à droite est la partie de propagation vers l'avant

De droite à gauche est la partie de Rétropropagation

PourWEtB C'est un calcul similaire ici. BC'est tout.

PourBLe gradient de,Ce qui est remarquable, c'est queLoosCe qu'on obtient, c'est une moyenne, et ce qu'on obtient, c'est un scalaire,Le calcul du gradient pour un scalaire est en fait une moyenne(Ça vaut la peine d'y réfléchir.).

∂ L o s s ∂ B = ∑ i = 0 N 2 ∗ ( y i − y p i ) / N \frac{\partial Loss}{\partial B} = \sum_{i=0}^N 2*(y_i-y_{pi})/N ∂B∂Loss=i=0∑N2∗(yi−ypi)/N

Après RétropropagationBEffectuer une descente en gradient:

B = B − r a t e ∗ ∂ L o s s ∂ B B = B - rate *\frac{\partial Loss}{\partial B} B=B−rate∗∂B∂Loss

Une fois le gradient abaissé, la propagation vers l'avant est de nouveau suffisante,CalculerY_p,Enfin calculéLoss.

La propagation vers l'avant satisfait à la formule suivante::

Y p r e d i c t ( 0... N ) = X p r e d i c t ( 0... N ) ∗ W + B Y_{predict (0...N)} =X_{predict (0...N)}* W + B Ypredict(0...N)=Xpredict(0...N)∗W+B

Les codes sont les suivants::

import torch

import numpy as np

import matplotlib.pyplot as plt

# 1 Données de construction

x_number = 50

x = torch.rand([x_number, 1])

y = 3 * x + 0.8

rate = 0.01

study_time = 3000

# 2 Transmission positive Et Rétropropagation

w = torch.rand([1, 1], requires_grad=True, dtype=torch.float32)

b = torch.rand(1, requires_grad=True, dtype=torch.float32)

y_preidct = torch.matmul(x, w) + b

def forward_propagation():

global x, w, b, y_preidct

y_preidct = torch.matmul(x, w) + b

# Calcul loss

loss = (y - y_preidct).pow(2).mean()

return loss

def back_propagation():

global x, w, b, loss, rate, y_preidct

test = 0.0

if w.grad is not None:

w.grad.data.zero_()

if b.grad is not None:

b.grad.data.zero_()

# Rétropropagation

loss.backward()

w.data -= w.grad * rate

b.data -= b.grad * rate

#Ici pour vérifierbPour calculer le gradient

# for j in range(x_number):

# test += ((y[j] -y_preidct[j].item()) * 2)

# print("b:", b.grad)

# print("b_t:", test/x_number)

# 3 Formation

for i in range(study_time):

loss = forward_propagation()

back_propagation()

if i % 10 == 0:

print("w,b,loss", w.item(), b.item(), loss.item())

# 4 Section des dessins

predict = x * w + b # Après l'entraînementwEtbCalculer les prévisions

plt.scatter(x.data, y.data, c="r")

plt.plot(x.data.numpy(), predict.data.numpy())

plt.show()

Le rouge est le résultat de l'ensemble de données le bleu est le résultat de l'entraînement:

La courbe d'ajustement n'est pas correcte lorsque le nombre d'exercices est relativement faible:

Lorsque vous réduisez le taux d'apprentissage(Réduction de la plage de variation),L'augmentation du nombre d'études donne de bons résultats:

Références:

边栏推荐

- Opencv -- Notes

- Short message sending solution in medical his industry

- (translation) use eyebrow shaped text to improve Title click through rate

- Test essential tool - postman practical tutorial

- How does ZABBIX configure alarm SMS? (alert SMS notification setting process)

- Analysis on user behavior loss of data exploration e-commerce platform

- org.redisson.client.RedisResponseTimeoutException: Redis server response timeout (3000 ms)错误解决

- [Agora] user management

- Upstream and downstream in software development

- Connectivity basis of Graphs

猜你喜欢

Sitge joined the opengauss open source community to jointly promote the ecological development of the database industry

![[fundamentals of wireless communication-15]: illustrated mobile communication technology and application development-3-overview of digital communication 2G GSM, CDMA, 3G wdcma/cdma200/td-scdma, 4G LTE](/img/22/1efa444220131359b06005f597c9db.png)

[fundamentals of wireless communication-15]: illustrated mobile communication technology and application development-3-overview of digital communication 2G GSM, CDMA, 3G wdcma/cdma200/td-scdma, 4G LTE

45 year old programmer tells you: why do programmers want to change jobs? It's too true

RocketQA:通过跨批次负采样(cross-batch negatives)、去噪的强负例采样(denoised hard negative sampling)与数据增强(data augment

(translation) use eyebrow shaped text to improve Title click through rate

聚焦绿色低碳,数据中心散热进入“智能冷却”新时代

With regard to the white box test, you have to master these skills~

机器学习9-通用逼近器径向基函数神经网络,在新观点下审视PDA和SVM

How does ZABBIX configure alarm SMS? (alert SMS notification setting process)

测试必备工具—Postman实战教程

随机推荐

【JS给元素添加属性:setAttribute;classList.remove;classList.add;】

FL studio20.9 fruit software advanced Chinese edition electronic music arrangement

数学知识:求组合数 III—求组合数

Ernie-gram, 显式、完备的 n-gram 掩码语言模型,实现了显式的 n-gram 语义单元知识建模。

Log4j2 threadcontext log link tracking

测试必备工具-Postman实战教程

With regard to the white box test, you have to master these skills~

Handsontable数据网格组件

opencv -- 笔记

Mathematical knowledge: 01 sequence satisfying conditions - find combinatorial number

Laravel event & Monitoring

数学知识:满足条件的01序列—求组合数

URL和URI

AS400 大厂面试

MySQL insert \ pre update + judgment condition

2022年最新csdn涨薪技术栈-app自动化测试概述

Qt5 mvc: revealing the secrets of data visualization

MYSQL 数据库查看磁盘占用情况

(翻译)使用眉状文本提高标题点击率

Live shopping mall source code, realize left-right linkage of commodity classification pages