当前位置:网站首页>搭建Spark开发环境

搭建Spark开发环境

2022-08-02 14:17:00 【发量不足】

实验报告

①.spark集群基础

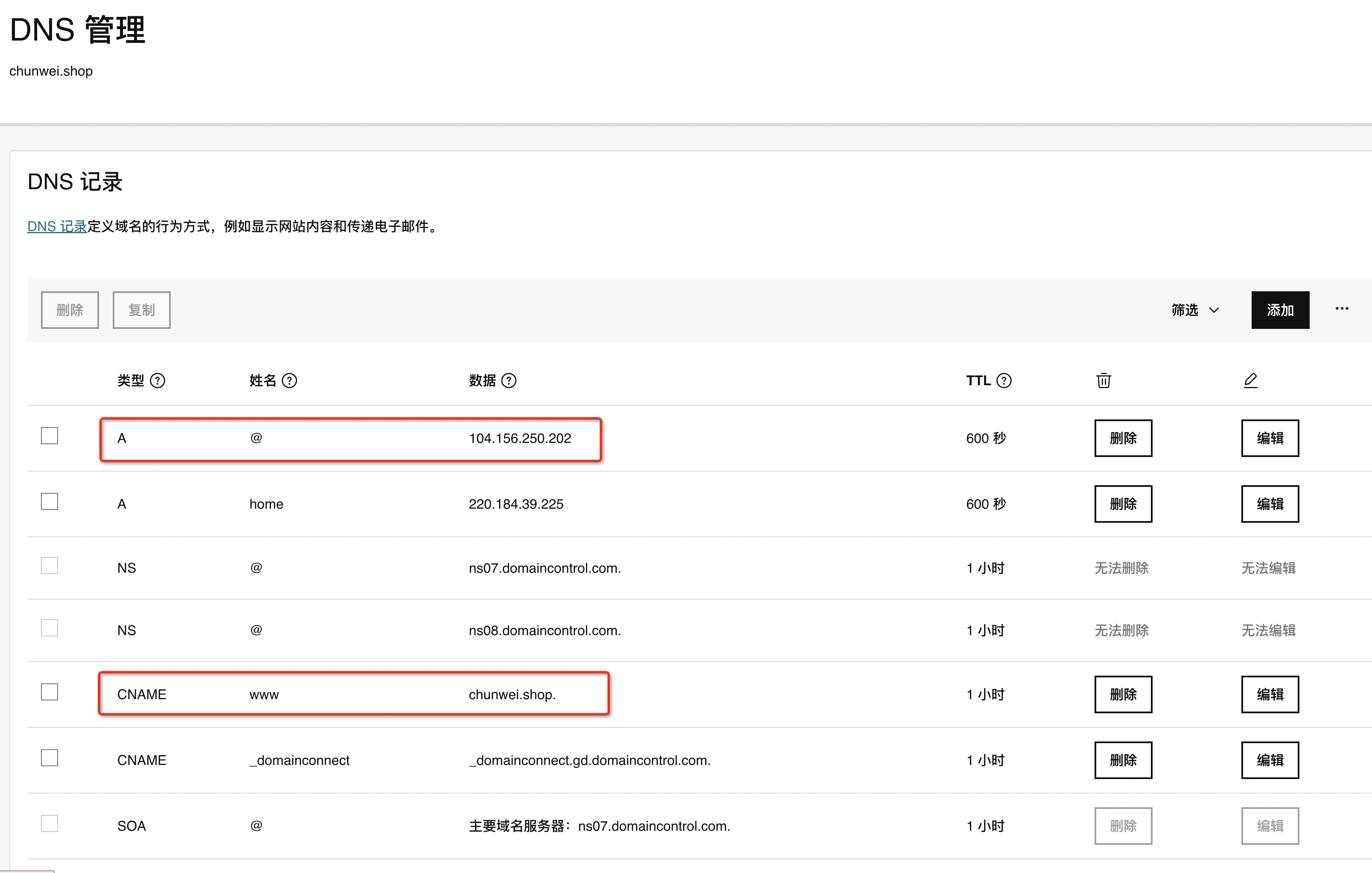

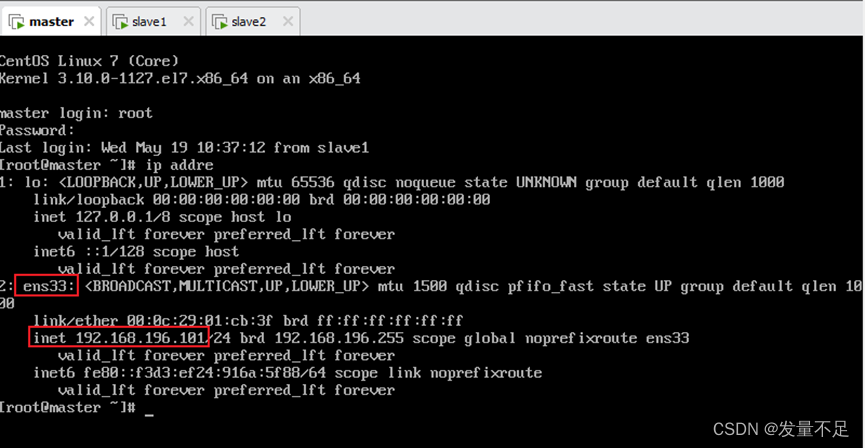

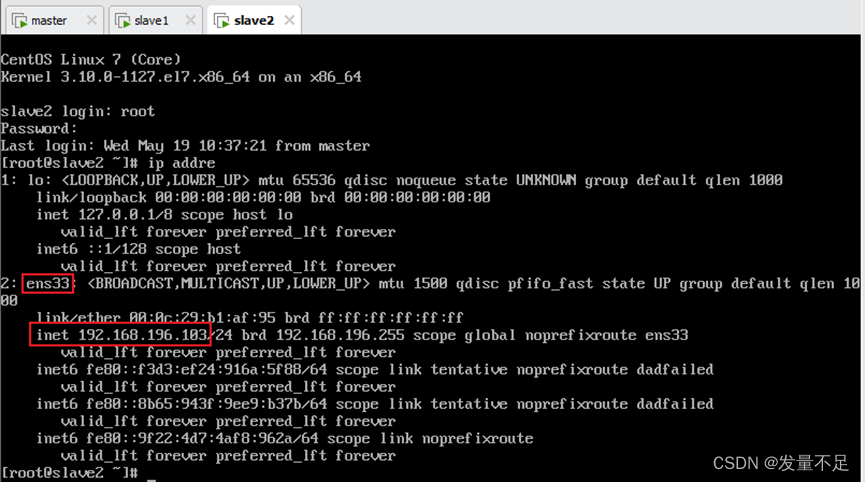

查看自己三个节点环境的ip地址:ip addre

Master:

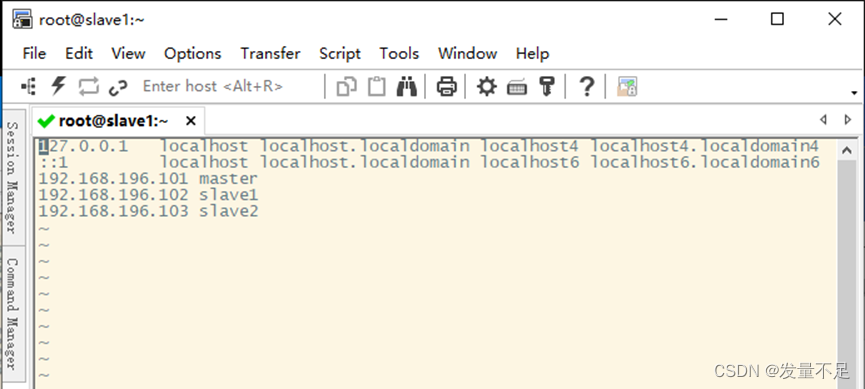

Slave1:

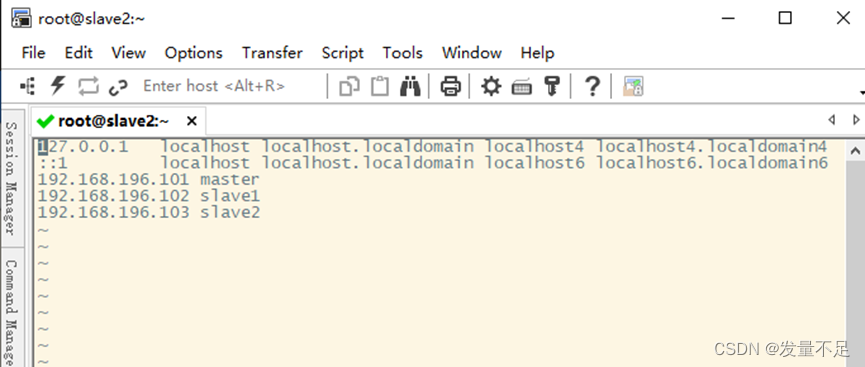

Slave2:

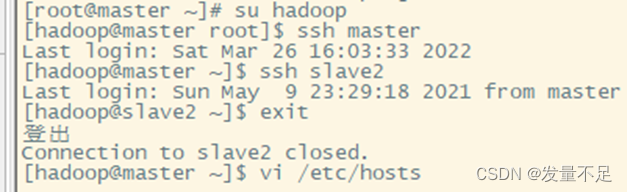

切换hadoop用户查看master能否切换另外两台slave然后配置另外两台可以自由切换

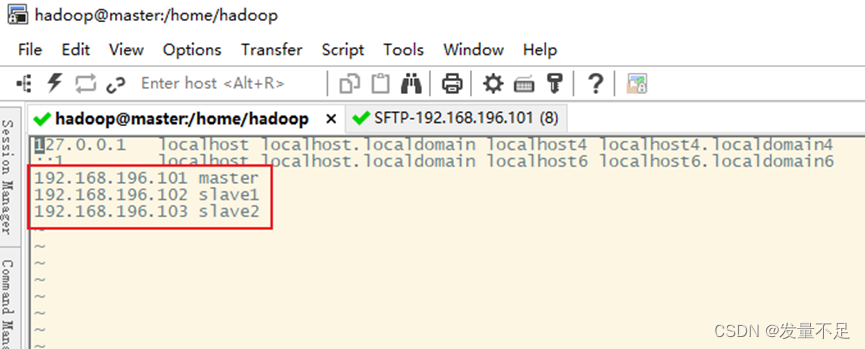

配置成刚才三个节点的ip地址

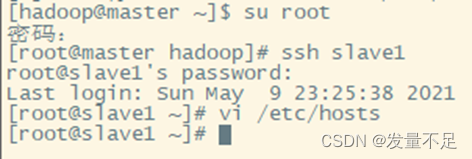

配置另外两个节点的免密快速访问(修改配置需要管理员root权限才能修改)

②.Spark集群安装部署

1.下载Spark安装包

Apache Spark官网httpd://spark.apache.org/downloads.html下载使用。

2.解压Spark安装包

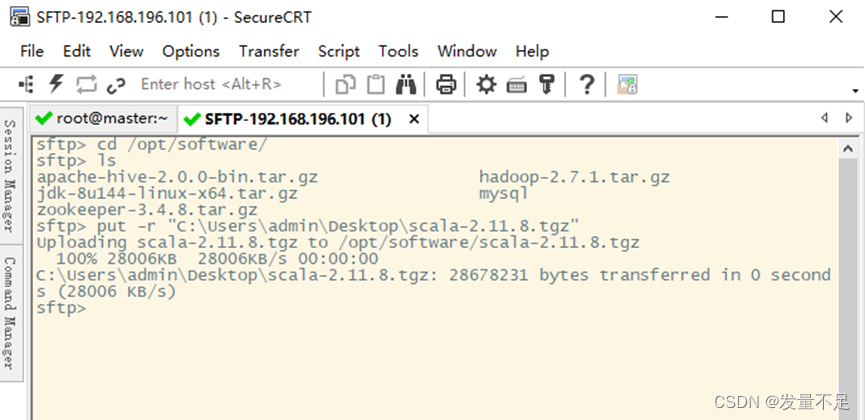

在CRT页面Alt+P打开文件传输窗口

cd /opt/software/

ls

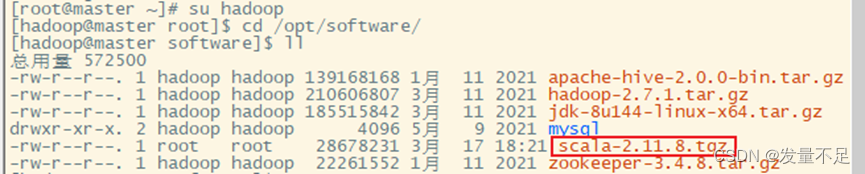

回到CRT页面切换hadoop用户

su Hadoop

cd /opt/software/

查看是否传输成功

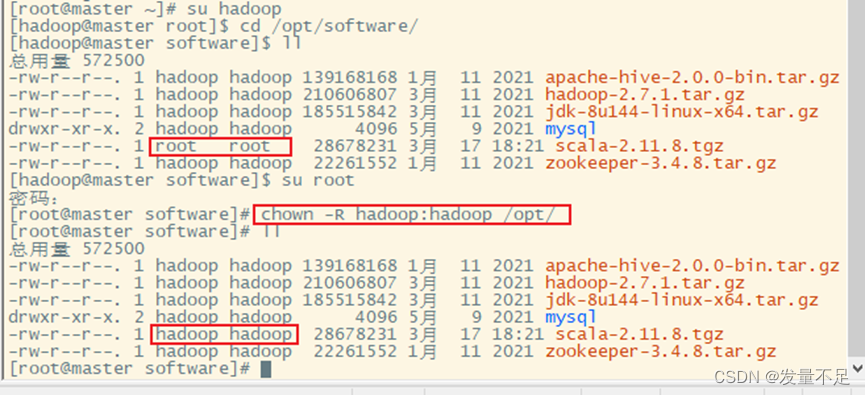

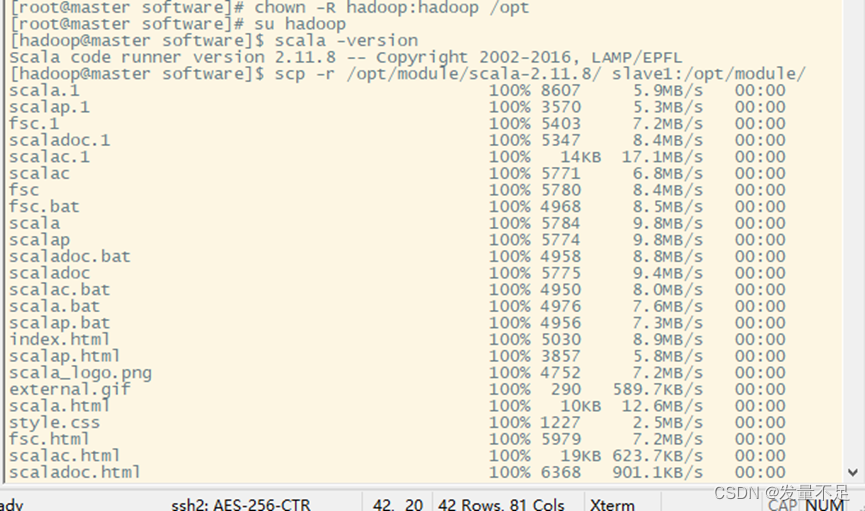

切换root修改scala的文件权限给hadoop

su Hadoop

cd /opt/software

su root

chown -R hadoop:hadoop /opt/

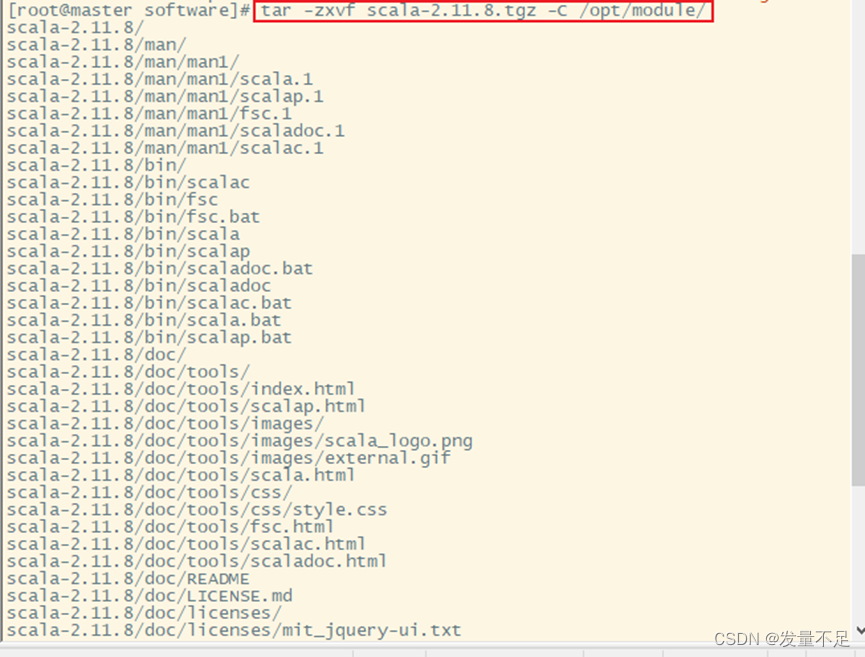

修改完成后解压scala

tar -zxvf scala-2.11.8.tgz -C /opt/module/

清屏

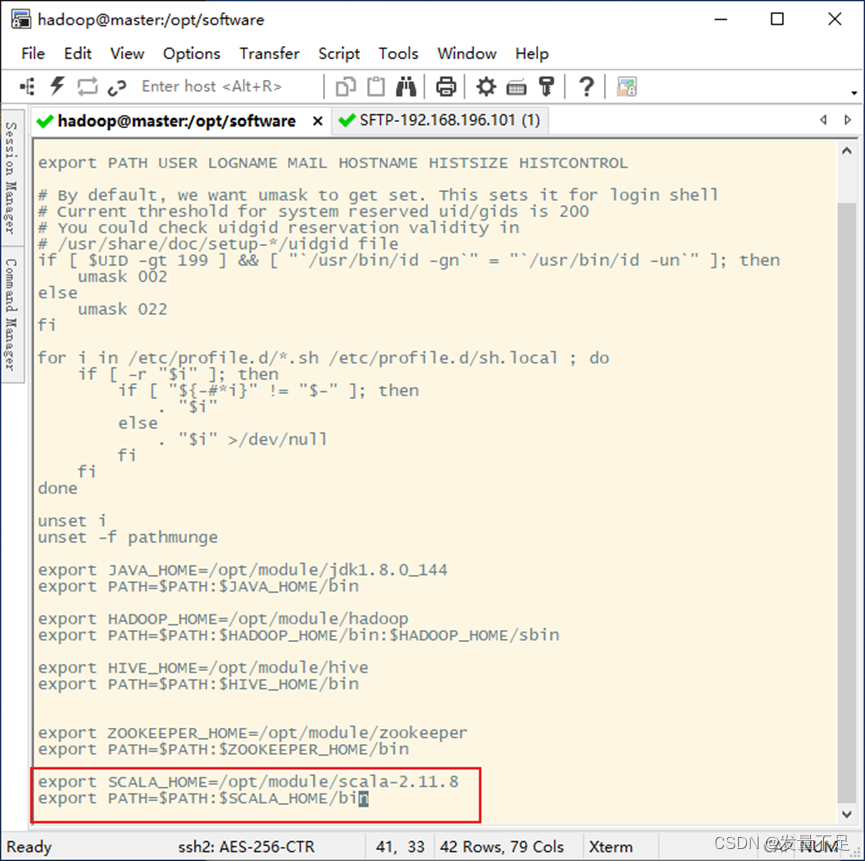

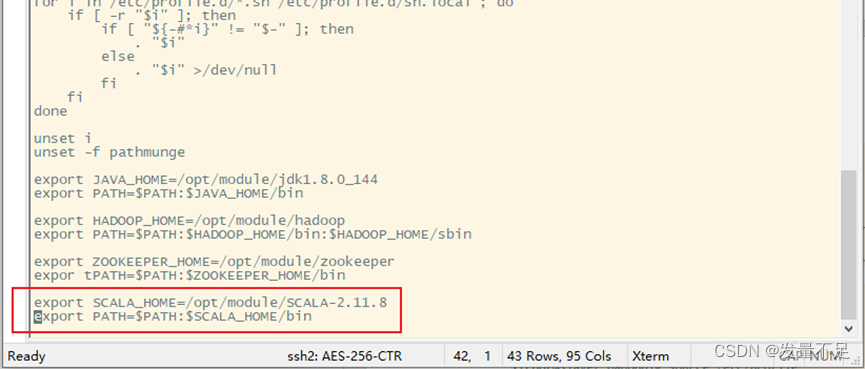

3.修改配置文件

vi /etc/profile

添加如下配置:

export SCALA_HOME=/opt/module/scala-2.11.8

export PATH=$PATH:$SCALA_HOME/bin

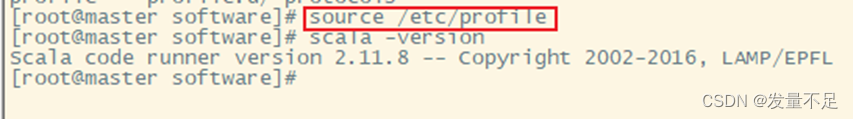

配置完后让配置生效

然后检查版本

分发文件:修改完1配置文件后将master目录分发至slave1和slave2两个节点

scp -r /opt/module/scala-2.11.8/ slave1:/opt/module/

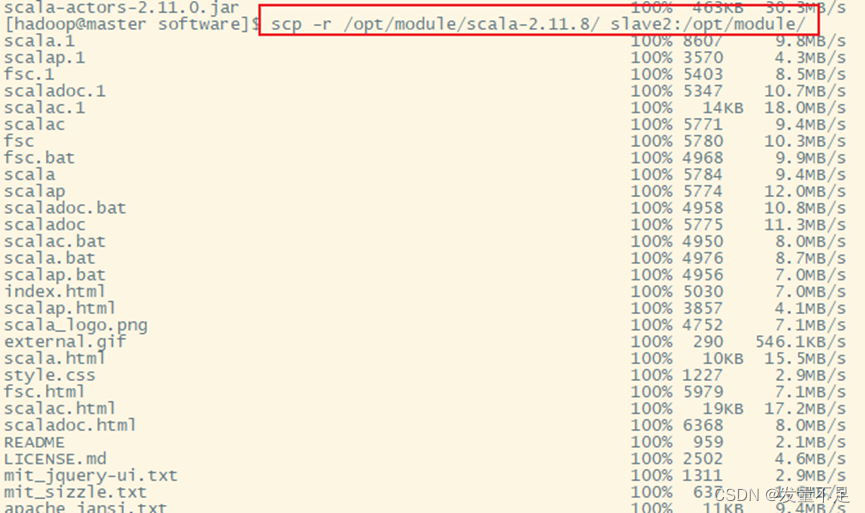

scp -r /opt/module/scala-2.11.8/ slave2:/opt/module/

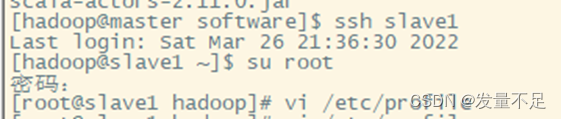

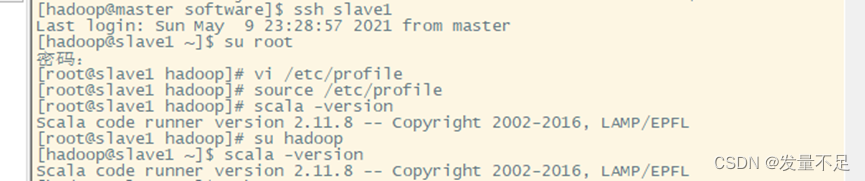

切换slave1用户使用管理员身份

ssh slave1

su root

vi /etc/profile

添加环境配置:

export SCALA_HOME=/opt/module/scala-2.11.8

export PATH=$PATH:$SCALA_HOME/bin

:wq保存

查看是否成功

scala -version

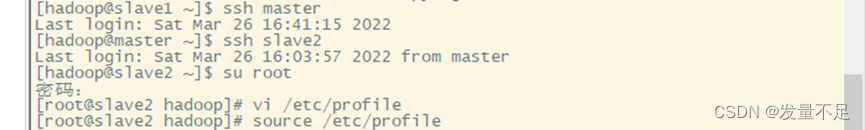

切换slave2用户使用管理员身份

ssh slave2

su root

vi /etc/profile

添加环境配置:

export SCALA_HOME=/opt/module/scala-2.11.8

export PATH=$PATH:$SCALA_HOME/bin

:wq保存

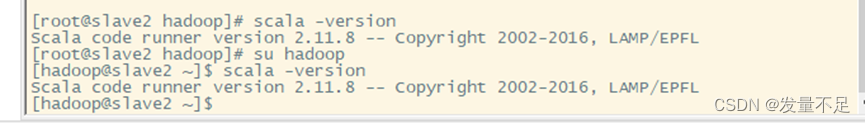

查看是否成功

scala -version

边栏推荐

- Doubly linked list (normal iterators and const iterators)

- ssm整合

- 小知识系列:Fork之后如何与原仓库分支同步

- Class template/assignment operations and add operations

- 对象头和synchronized的升级

- webrtc 中怎么根据 SDP 创建或关联底层的 socket 对象?

- JOOQ 报错 StackOverflowError

- 【软件测试】自动化测试selenium3

- IDEA如何进行远程Debug

- CDH (computational Diffie-Hellman) problem and its differences with discrete logarithm and DDH problems

猜你喜欢

随机推荐

【软件测试】selenium自动化测试2

RouteOS 导入至PVE

CDH (computational Diffie-Hellman) problem and its differences with discrete logarithm and DDH problems

排序方法汇总(C语言)

类模板/赋值运算和加等运算

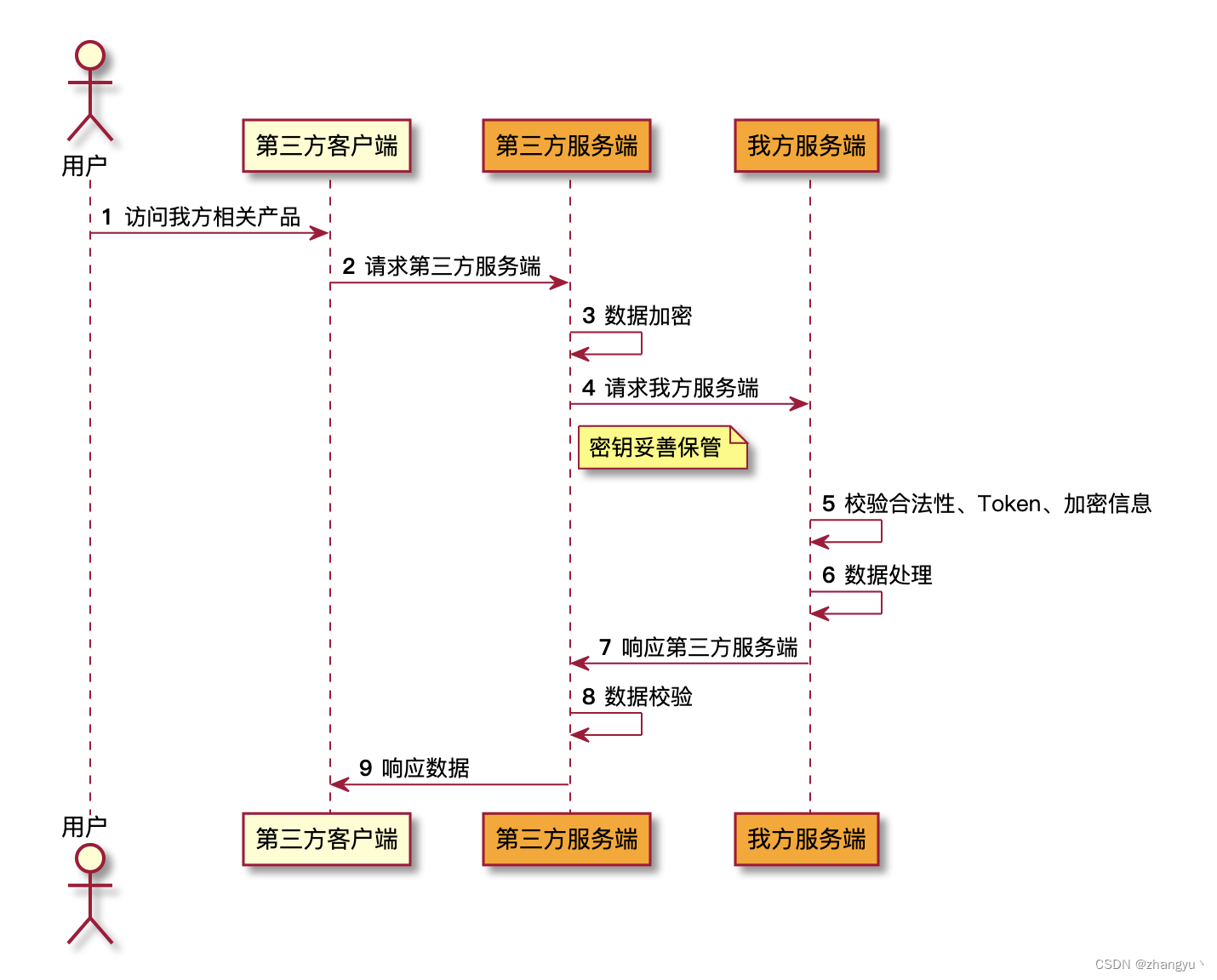

Oauth2.0 补充

关于导出聊天记录这件事……

WebRTC 中有关 Media Stream & Track & Channel 之间的关系

网络运维系列:端口占用、端口开启检测

记一次 ThreadLocal 泄漏导致的 shardingsphere-jdbc-core 单元测试偶发失败的排查与修复

对象头和synchronized的升级

hybrid 实现同网段但不同vlan之间通讯

unittest框架

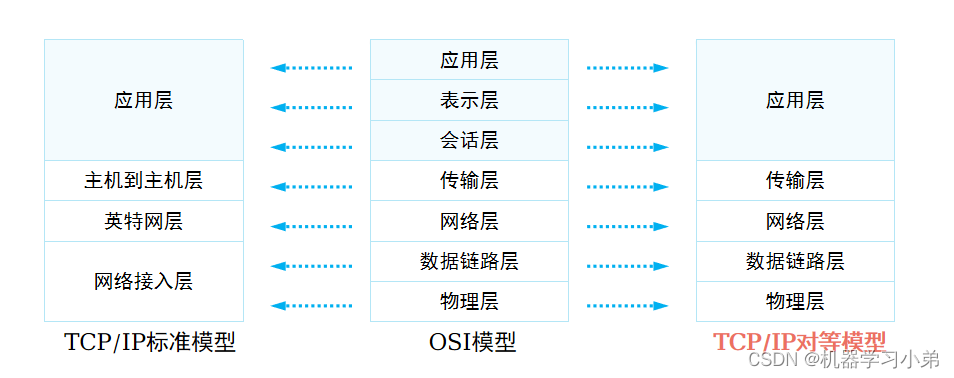

HCIE学习记录——数据封装与常用协议(TCP/UDP)

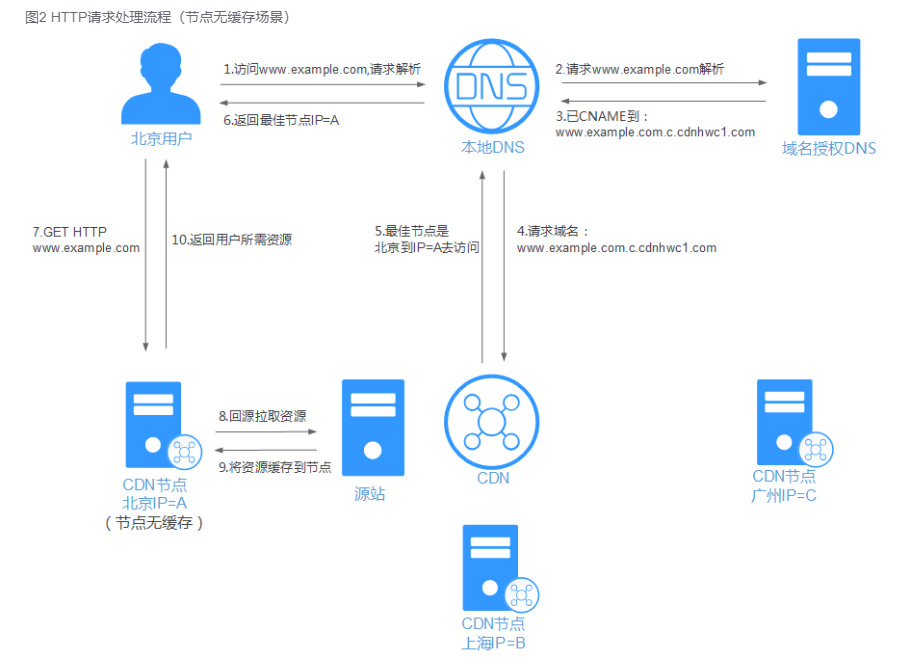

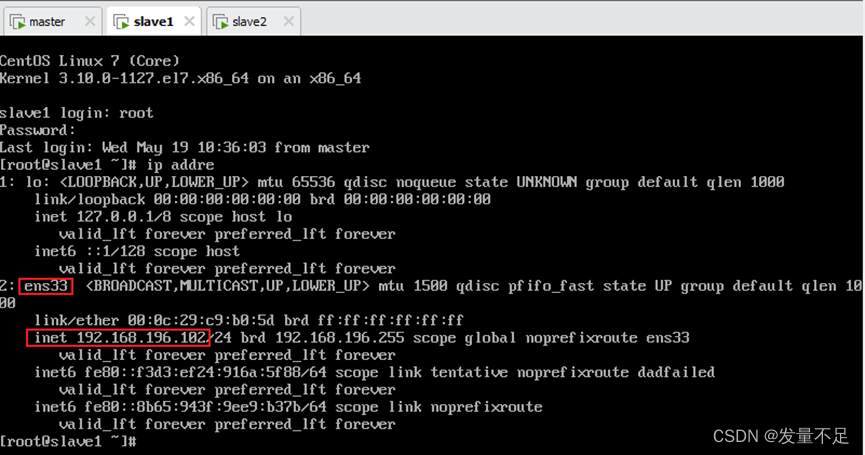

网络运维系列:二级域名启用与配置

一线大厂研发流程(转载自鱼皮)

华为单臂路由配置,实现不同vlan之间的通信

Oauth2.0 认证服务器搭建

HCIE学习记录——OSI参考模型

IDEA如何进行远程Debug