当前位置:网站首页>协作D2D局部模型聚合的半分散联合学习

协作D2D局部模型聚合的半分散联合学习

2022-08-05 02:14:00 【物腐虫生】

摘要

提出了双时间尺度混合联邦学习(TT-HF),这是一种半分散式学习体系结构,将用于联邦学习的传统设备到服务器通信范式与用于模型训练的设备到设备(D2D)通信相结合。

每个全局聚合间隔期间,设备

(i)在其单个数据集上执行多多次随机梯度下降迭代,

(ii)通过本地集群内的协作分布式D2D通信,不定期地参与其模型参数的协商过程。

开发了一种自适应控制算法,该算法可以随时间调整TT-HF的步长、D2D通信轮数和全局聚合周期,以达到O(1/t)的次线性收敛速度,同时最小化网络资源利用率。

传统联邦学习

在每次迭代中,每个设备基于其自己的数据集训练局部模型,通常使用(随机)梯度下降。然后,设备将其本地模型上载到服务器,服务器通常使用加权平均值将其聚合为全局模型,并将设备与此新模型同步,以启动下一轮本地训练。

为了降低上行链路和下行链路传输的成本,提出了局部模型训练与周期性但不频繁的全局聚合相结合。

然而,局部数据集可能在其统计分布中表现出显著的异质性,导致学习模型可能偏向于局部数据集,因此降低了全局模型的准确性.

TT_HF

(i)涉及设备到设备和设备到服务器通信之间的混合

(ii)包含两个用于模型训练的时间尺度:单个设备上的随机梯度下降迭代和集群内的多轮协作D2D通信。

在全局聚合期间,集群中只有一个设备需要将集群模型上传到服务器,

具体来说,在联邦学习的本地更新间隔期间,设备可以系统地与其附近的其他设备共享其模型参数,以在每个边缘设备集群之间形成分布式共识。

在每个本地训练间隔结束时,假设每个设备的模型现在反映了其集群的一致性,则主服务器可以从每个集群中随机抽取一个设备进行全局聚合。

量化设备级随机梯度更新、集群级共识过程和网络级全局聚合之间的关系。并使用它们来调整每个本地更新和共识周期的长度。

结果:联邦学习的一个版本,它优化了全局模型收敛特性,同时最小化了系统中的上行链路通信需求。

推荐文献:全面了解联邦学习

[28] S. Abdulrahman, H. Tout, H. Ould-Slimane, A. Mourad, C. Talhi, and

M. Guizani, “A survey on federated learning: The journey from central-

ized to distributed on-site learning and beyond,” IEEE Internet Things

J., vol. 8, no. 7, pp. 5476–5497, Apr. 2021.

[29] T. Li, A. K. Sahu, A. Talwalkar, and V . Smith, “Federated learning:

Challenges, methods, and future directions,” IEEE Signal Process. Mag.,

vol. 37, no. 3, pp. 50–60, May 2020.

就无线通信效率而言,有几项工作研究了在连续全局聚合之间执行多轮局部梯度更新的影响,包括根据总资源预算优化聚合周期。

为了进一步减少对全局聚合的需求,[31]提出了一种用于联邦学习的分层系统模型,其中边缘服务器用于部分全局聚合。

[31] L. Liu, J. Zhang, S. Song, and K. B. Letaief, “Client-edge-cloud hierarchical federated learning,” in Proc. IEEE Int. Conf. Commun.

(ICC), vol. 2020, pp. 1–6.

还提出了模型量化[]和稀疏化技术。

本文提出了一种半分散架构,其中D2D通信用于与全局聚合一起在节点之间交换模型参数。

针对数据异构性,[34]中,作者建议将局部数据集的一部分上传到服务器,然后用于增强全局模型训练。

[34] N. Y oshida, T. Nishio, M. Morikura, K. Y amamoto, and R. Y onetani,

“Hybrid-FL for wireless networks: Cooperative learning mechanism

using non-IID data,” in Proc. IEEE Int. Conf. Commun. (ICC), Jun. 2020,

pp. 1–7.

本文利用D2D通信在设备之间交换模型参数,这缓解了此类担忧。

将设备间的分布式协作学习引入到局部更新过程中,形成了一种具有D2D增强学习的新型系统架构。

可同时解决通信效率和数据异构性挑战。

在这种情况下

(i)设备可能在全局聚合之间进行多次(随机)梯度迭代,

(ii)全局聚合是非周期的,

(iii)设备之间的共识过程可能在每个全局聚合期间不周期地发生。

由于设备的移动性,每个集群的拓扑结构(即节点数量及其在集群内的位置)可能会随着时间而变化,尽管我们假设与两个全局聚合之间的时间相比,这种演变是缓慢的。

对梯度上界使用了三角形不等式。。。平滑度条件

TT-HF:双时间尺度混合联邦学习

1)概述和基本原理:由非周期全局聚合之间的一系列局部模型训练间隔组成。在每个间隔期间,设备进行局部随机梯度下降(SGD)迭代,并通过集群内的局部一致性过程非周期地同步其模型参数。

后面还在看,公式太多了。。。。。

边栏推荐

- 海量服务实例动态化管理

- source program in assembly language

- 释放技术创新引擎,英特尔携手生态合作伙伴推动智慧零售蓬勃发展

- leetcode-对称二叉树

- 如何基于OpenVINO POT工具简单实现对模型的量化压缩

- Short domain name bypass and xss related knowledge

- Log an error encountered when compiling google gn "I could not find a ".gn" file ..."

- Greenplum Database Fault Analysis - Can a Soft Connection Be Made to the Database Base Folder?

- 多线程(2)

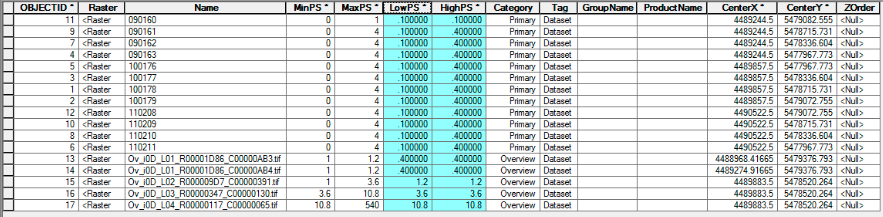

- 使用SuperMap iDesktopX数据迁移工具迁移ArcGIS数据

猜你喜欢

KingbaseES V8 GIS data migration solution (2. Introduction to the capabilities of Kingbase GIS)

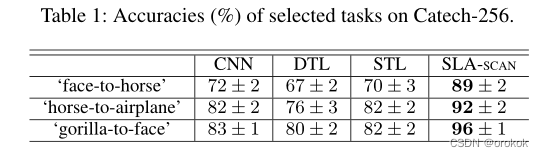

Transfer Learning - Distant Domain Transfer Learning

MySQL3

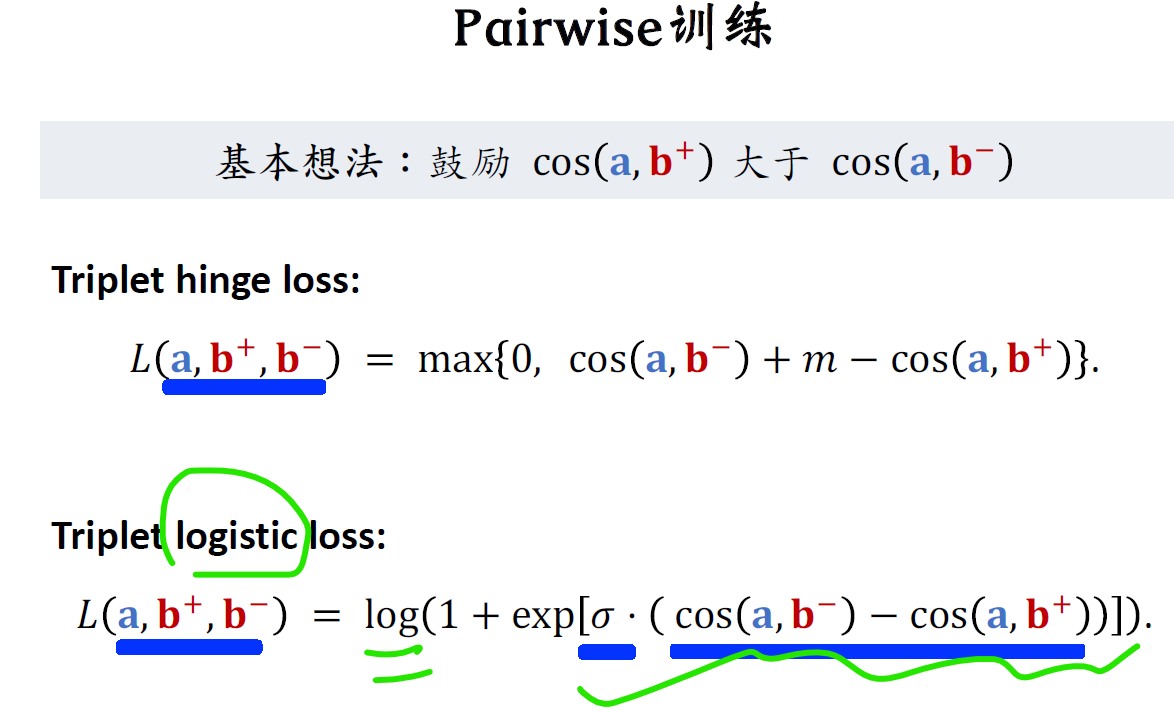

一文看懂推荐系统:召回06:双塔模型——模型结构、训练方法,召回模型是后期融合特征,排序模型是前期融合特征

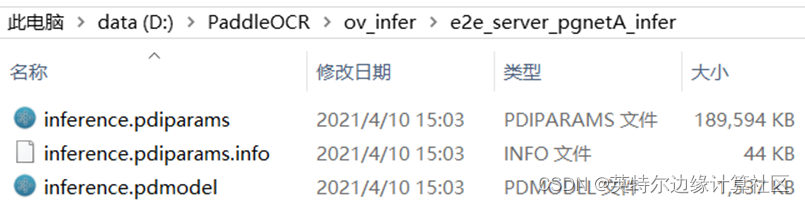

使用OpenVINO实现飞桨版PGNet推理程序

Exploding the circle of friends, Alibaba produced billion-level concurrent design quick notes are too fragrant

![[Redis] Redis installation under Linux](/img/84/7791a87ff976be15b455f6ddc05bf2.png)

[Redis] Redis installation under Linux

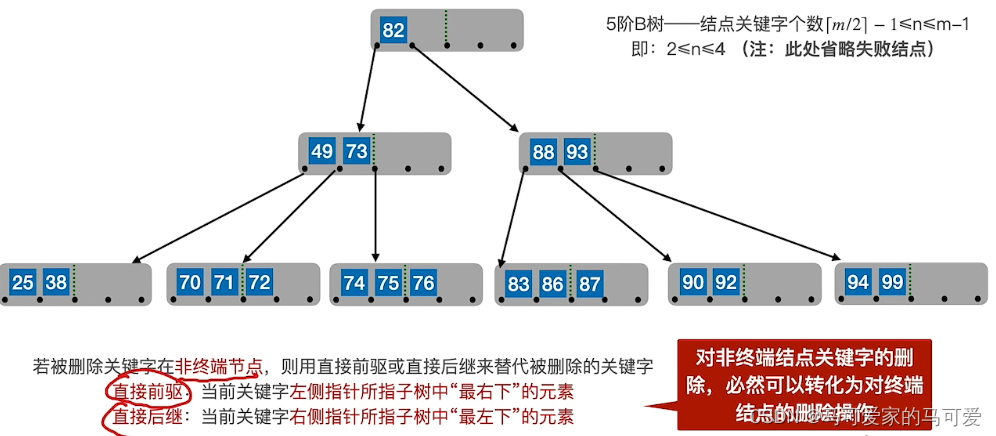

树表的查找

HOG特征学习笔记

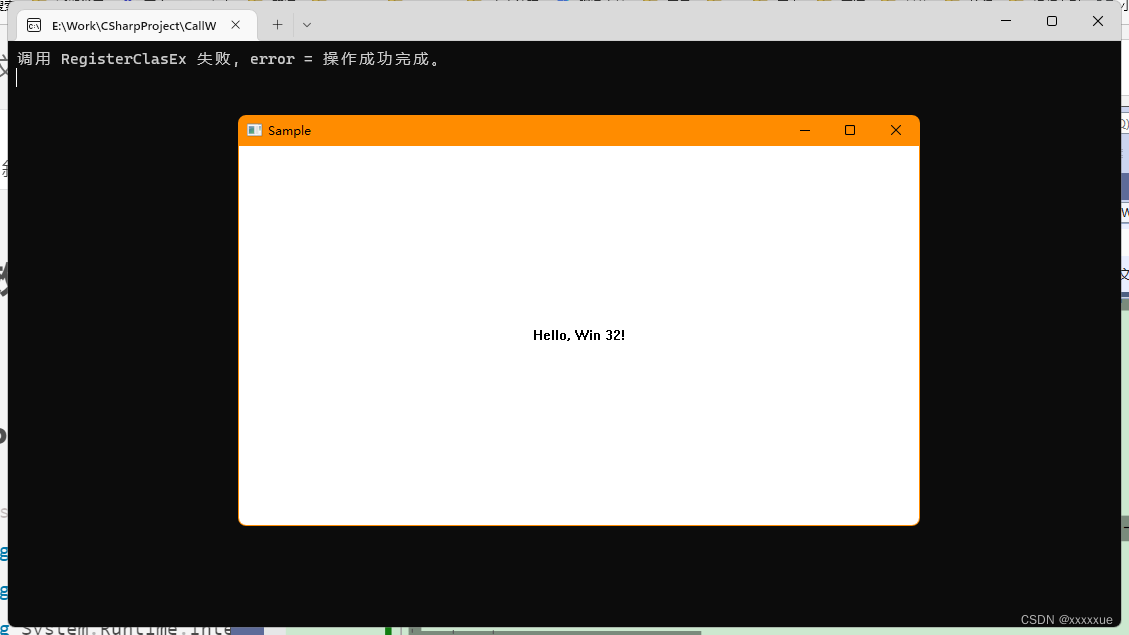

.Net C# Console Create a window using Win32 API

随机推荐

How to simply implement the quantization and compression of the model based on the OpenVINO POT tool

MySQL learning

“嘀哩哩,等灯等灯”,工厂安全生产的提示音

C学生管理系统 头添加学生节点

如何模拟后台API调用场景,很细!

AI+小核酸药物|Eleven完成2200万美元种子轮融资

在这个超连接的世界里,你的数据安全吗

开篇-开启全新的.NET现代应用开发体验

浅谈数据安全治理与隐私计算

基于OpenVINO工具套件简单实现YOLOv7预训练模型的部署

MySQL3

【Unity入门计划】2D游戏中遮挡问题的处理方法&伪透视

.Net C# Console Create a window using Win32 API

ExcelPatternTool: Excel表格-数据库互导工具

LPQ(局部相位量化)学习笔记

leetcode 15

Greenplum数据库故障分析——版本升级后gpstart -a为何返回失败

Live playback including PPT download | Build Online Deep Learning based on Flink & DeepRec

1349. 参加考试的最大学生数 状态压缩

.Net C# 控制台 使用 Win32 API 创建一个窗口