当前位置:网站首页>历史最全混合专家(MOE)模型相关精选论文、系统、应用整理分享

历史最全混合专家(MOE)模型相关精选论文、系统、应用整理分享

2022-07-04 20:46:00 【lqfarmer】

稀疏性(Sparsity),指的是模型具有非常大的容量,但只有模型的用于给定的任务、样本或标记的某些部分被激活。这样,能够显著增加模型容量和能力,而不必成比例增加计算量。

2017年,谷歌引入了稀疏门控的专家混合层(Sparsely-Gated Mixture-of-Experts Layer,MoE),该层在各种转换基准测试中显示出更好的结果,同时使用的计算比以前最先进的密集 LSTM 模型少10倍。

本资源整理了近年来混合专家(MoE) 相关的论文,并进行了详细分类。为这个知识库加注星标,然后你就可以及时了解这个蓬勃发展的研究领域的最新进展。

资源整理自网络,下载及获取见源地址:https://github.com/codecaution/Awesome-Mixture-of-Experts-Papers#awesome-mixture-of-experts-papers

目录

内容截图

往期精品内容推荐

边栏推荐

- y56.第三章 Kubernetes从入门到精通 -- 业务镜像版本升级及回滚(二九)

- Jerry's ad series MIDI function description [chapter]

- Jerry's ad series MIDI function description [chapter]

- The video sound of station B is very low - solution

- Why does invariant mode improve performance

- Roast B station charges, is it because it has no money?

- 【Try to Hack】宽字节注入

- 解析互联网时代的创客教育技术

- Flutter 返回按钮的监听

- 更强的 JsonPath 兼容性及性能测试之2022版(Snack3,Fastjson2,jayway.jsonpath)

猜你喜欢

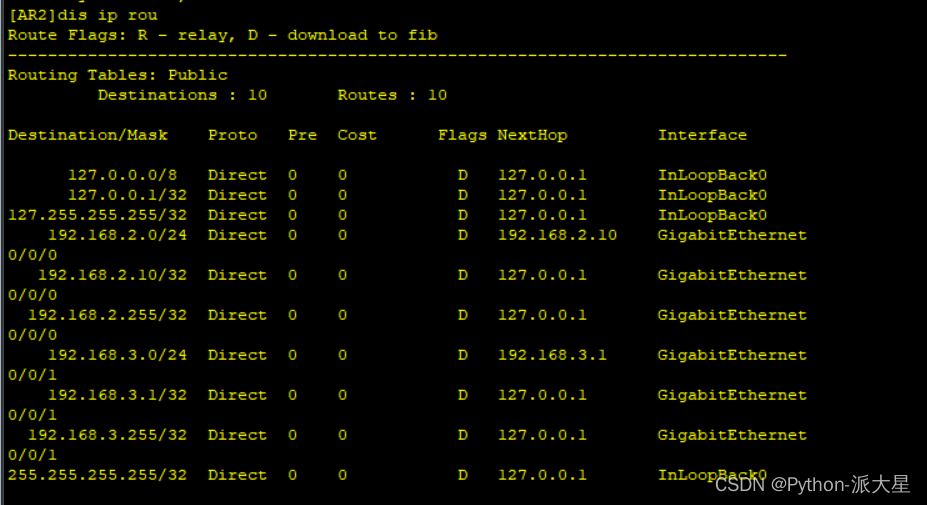

华为ensp模拟器 实现多个路由器的设备可以相互访问

创客思维在高等教育中的启迪作用

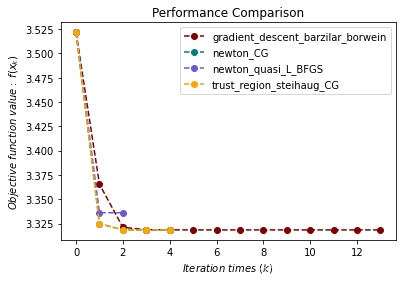

【optimtool.unconstrain】无约束优化工具箱

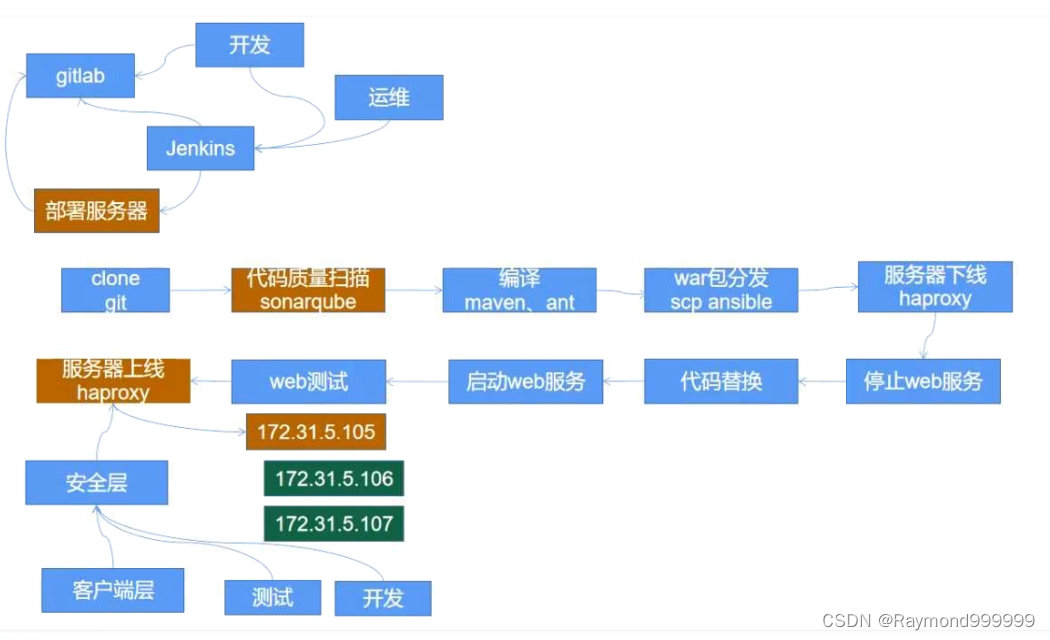

y56.第三章 Kubernetes从入门到精通 -- 业务镜像版本升级及回滚(二九)

奋斗正当时,城链科技战略峰会广州站圆满召开

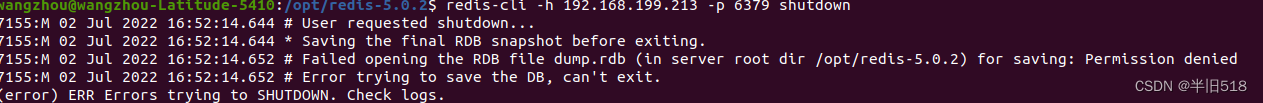

redis03——Redis的网络配置与心跳机制

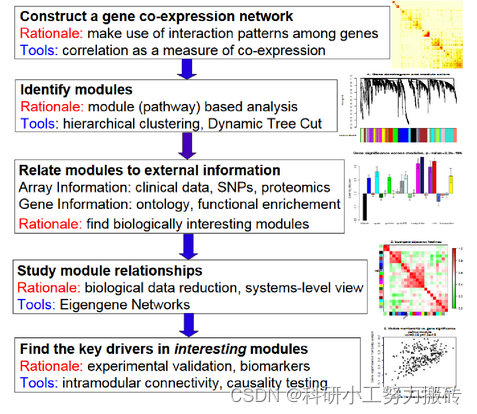

WGCNA analysis basic tutorial summary

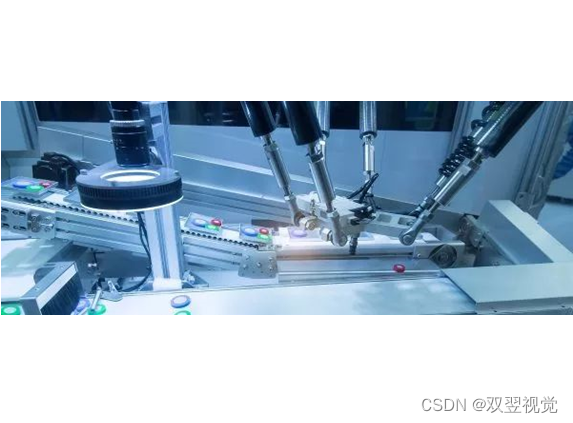

Methods of improving machine vision system

The video sound of station B is very low - solution

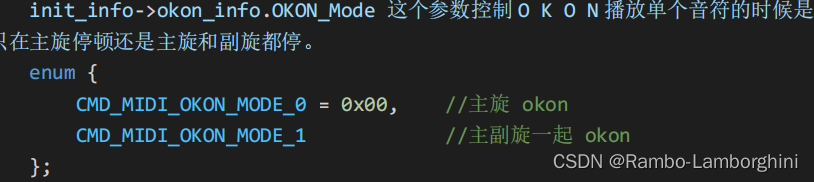

杰理之AD 系列 MIDI 功能说明【篇】

随机推荐

面试官:说说XSS攻击是什么?

Maidong Internet won the bid of Beijing life insurance

Rotary transformer string judgment

数十亿公民信息遭泄漏!公有云上的数据安全还有“救”吗?

redis缓存

解析互联网时代的创客教育技术

minidom 模塊寫入和解析 XML

LambdaQueryWrapper用法

Introduction to pressure measurement of JMeter

Daily question-leetcode556-next larger element iii-string-double pointer-next_ permutation

redis管道

redis布隆过滤器

Numpy vstack and column_ stack

Drop down selection of Ehlib database records

Kubeadm初始化报错:[ERROR CRI]: container runtime is not running

应用实践 | 蜀海供应链基于 Apache Doris 的数据中台建设

杰理之AD 系列 MIDI 功能说明【篇】

类方法和类变量的使用

CAD中能显示打印不显示

Daily question -leetcode1200- minimum absolute difference - array - sort