当前位置:网站首页>历时2年442位作者132个机构!Google发布语言模型评价新基准BIG-bench,204个任务全面评价语言模型能力,附论文

历时2年442位作者132个机构!Google发布语言模型评价新基准BIG-bench,204个任务全面评价语言模型能力,附论文

2022-06-10 18:58:00 【智源社区】

如何评价语言模型是个非常重要的问题,今天,Google发布语言模型评价新基准BIG-bench,204个任务全面评价语言模型能力,旨在超越图灵测试,更加准确地实现语言模型落地。

项目地址:https://github.com/google/BIG-bench/#creating-a-programmatic-task

边栏推荐

- 马斯克称自己不喜欢做CEO,更想做技术和设计;吴恩达的《机器学习》课程即将关闭注册|极客头条

- 【FAQ】运动健康服务REST API接口使用过程中常见问题和解决方法总结

- Detailed interpretation of tph-yolov5 | making small targets in target detection tasks invisible

- Key and encryption mechanism in financial industry

- 企业级存储发展趋势谈:开源存储的冷思考

- 如何查询 SAPGUI 屏幕上某个字段对应的数据库表存储

- 叮咚抢菜-派送时段监听及推送工具

- How to add aggregation hotspots in VR panorama? How to add a content module?

- Mongodb index unique

- Only three steps are needed to learn how to use low code thingjs to connect with Sen data Dix data

猜你喜欢

云图说|每个成功的业务系统都离不开APIG的保驾护航

China pufuteng hotels and resorts launched new spa products to celebrate the global health day on June 11

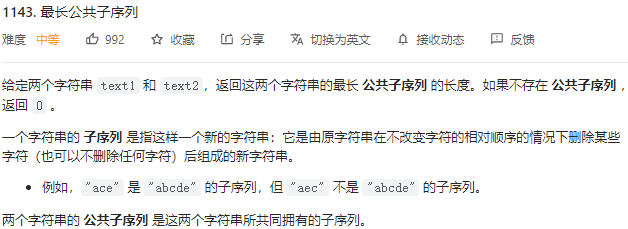

2022.05.26 (lc_1143_longest common subsequence)

用 Plotly 绘制了几张精湛的图表,美翻了!!

详细解读TPH-YOLOv5 | 让目标检测任务中的小目标无处遁形

Go语学习笔记 - 跨域配置、全局异常捕获 | Web框架Gin(四)

In the all digital era, how can enterprise it complete transformation?

![[6.4-6.10] wonderful review of Blog](/img/66/0cfc97bf4bc0c2b6e66c0419690ce5.png)

[6.4-6.10] wonderful review of Blog

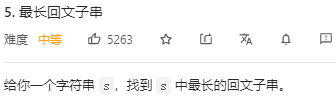

2022.05.28 (lc_5_longest palindrome substring)

改变世界的开发者丨玩转“俄罗斯方块”的瑶光少年

随机推荐

Integrate machine learning to make Chrome browser more "understand" you

Go语学习笔记 - 跨域配置、全局异常捕获 | Web框架Gin(四)

2022.05.28 (lc_5_longest palindrome substring)

Analysis of epidemic situation in Shanghai based on improved SEIR model

今年高考期间各考点秩序井然,未发生影响安全的敏感案事件

frp reverse proxy

[C language] still don't understand the structure? Take a look at this article to give you a preliminary understanding of structure

Soft deletion of data - when? How to realize it?

Esp8266 system environment setup

性能测试方案(计划)模板

One article explains in detail the exploration and practice of eventmesh landing on Huawei cloud

Cet article vous donne un aperçu de la tâche future de j.u.c, du cadre Fork / join et de la file d'attente de blocage

Computer: successfully teach you how to use one trick to retrieve the previous password (the password once saved but currently displayed as ******)

Solving Bob's survival problem by trilogy routine

[advanced C language] advanced pointer [Part 2]

2022.05.23 (lc_300_longest increment subsequence)

仅需三步学会使用低代码ThingJS与森数据DIX数据对接

HW blue team intermediate interview reply

Harbor镜像拉取凭证配置

VR全景如何应用在家装中?体验真实的家装效果