当前位置:网站首页>实力卷王LinkSLA,实现运维工程师快乐摸鱼

实力卷王LinkSLA,实现运维工程师快乐摸鱼

2022-08-05 05:19:00 【LinkSLA】

监控界的内卷

非一日练成

冬卷三九,夏卷三伏

翻车、救火的痛,除了消防员

运维工程师最懂!

监控盲区的系统故障就象,

头顶的达摩克里斯之剑,

啥时掉下来说不准,

反正精神压力就很大

好的监控面面俱到,

监控搞得好,所有烦恼说byebye.....

它是运维的眼睛,

是必须抱紧的大腿...

如何让运维更高效呢?

全栈监控---关联分析---跨系统调用的串联

---实时报警和自动处置---系统性能分析

完成这些操作基本,运维将变得轻松简单

运维有两大场景:异常检测和预警。

通俗点.....像体检和急症,

体检时能查漏补缺,

急诊时能药到病除。

这就要求运维工具能够达成这些KPI

①

告警及时

第一时间通知指定用户,

及时解决故障,防止故障蔓延

②

告警准确

不能误报、漏报和重复报,

接收精准信息。

③

监控全面

从机房动环、硬件设备、操作系统、应用组件到业务系统

全链路的监控。

④

运维闭环

发现、处理在SLA规定时间内完成

......

罗马非一日建成

运维也经历人工工具化、工具平台化、平台智能化的不同发展阶段

智能运维优势在于数据标准和交付价值

全面挖掘运维的数据价值

找全问题,找准问题,减少问题

LinkSLA智能运维管家

2015年进行算法研究孵化

18年场景落地,

在全栈监控、异常检测、日志异常检测方面,

单点应用突破、效果显著,

发挥卓越的数据价值!

提供企业发展的决策依据。

使用LinkSLA智能运维管家,

高效运维,快乐摸鱼!

声明:文案及图片由南京林科斯拉原创发布,转载请注明。

边栏推荐

- Unity中的GetEnumerator 方法及MoveNext、Reset方法

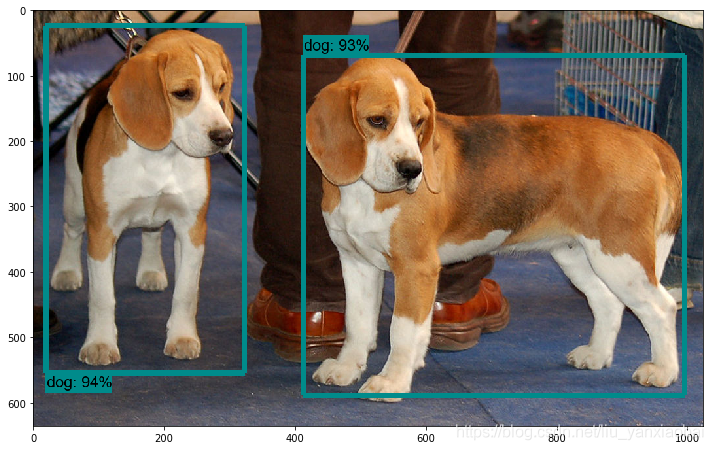

- Autoware中安装Yolo3目标检测模块遇到的问题

- 正则表达式小实例--去掉字符串中间和两边的空格

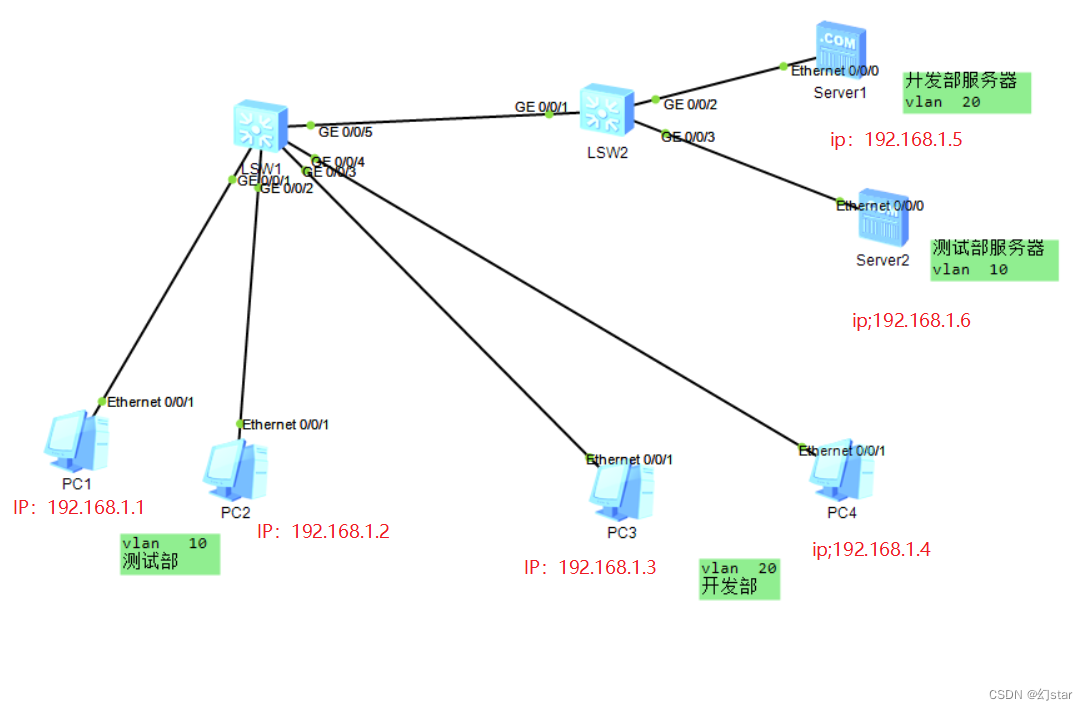

- ACLs and NATs

- [Day8] (Super detailed steps) Use LVM to expand capacity

- Introductory document 05-2 use return instructions the current task has been completed

- LeetCode Interview Questions

- Spark source code-task submission process-6.2-sparkContext initialization-TaskScheduler task scheduler

- ACL 和NAT

- spark算子-parallelize算子

猜你喜欢

随机推荐

[Day5] Soft and hard links File storage, deletion, directory management commands

SSL证书提示过期或者无效,该怎么处理呢?

VRRP原理及命令

One-arm routing and 30% switch

The spark operator - repartition operator

入职前,没想到他们玩的这么花

Getting Started Doc 08 Conditional Plugins

微信小程序页面跳转传参

入门文档10 资源映射

小度 小度 在呢!

入门文档05-2 使用return指示当前任务已完成

Getting Started Document 09 Standalone watch

[Day1] VMware software installation

网络不通?服务丢包?看这篇就够了

NIO works is analysed

LeetCode Interview Questions

ROS视频教程

spark算子-textFile算子

IP数据包格式(ICMP协议与ARP协议)

专有宿主机CDH

![[Day8] Commands involved in using LVM to expand](/img/ba/39b81cbcecec9bc54a710ff9dba81a.png)