当前位置:网站首页>ACL2022 | bert2BERT:参数复用的高效预训练方法,显著降低超大模型的训练成本

ACL2022 | bert2BERT:参数复用的高效预训练方法,显著降低超大模型的训练成本

2022-06-10 17:34:00 【智源社区】

近年来各大公司在大模型上积极布局,发布了一系列千亿参数级别的超大模型,在自然语言理解、生成和推理问题上实现了质的突破。然而,超大模型的预训练是极其耗费资源的。为此,本文提出了一种新的预训练加速技术:基于模型参数复用的bert2BERT方法,它可以让大模型在初始化阶段有效继承小模型的能力,减少重复训练成本,显著提升训练效率。bert2BERT在BERT和GPT上进行了广泛的实验,在Base版本模型上分别节省45%和47%的计算成本。同时借助MindSpore和CANN计算框架能力,该方法也被应用于千亿大模型的训练。实验表明当用百亿模型加速千亿大模型的时候,以预训练loss为评判标准,bert2BERT能显著减少30%以上的训练成本。

论文链接:https://aclanthology.org/2022.acl-long.151.pdf

代码链接:https://github.com/huawei-noah/Pretrained-Language-Model

边栏推荐

- Abbexa 无细胞 DNA 试剂盒说明书

- 一个WPF开发的打印对话框-PrintDialogX

- 搭建在线帮助中心,轻松帮助客户解决问题

- Step on the pit. The BigDecimal was improperly used, resulting in P0 accident!

- 苹果放大招!这件事干的太漂亮了……

- 如何定位游戏发热问题

- 【技术分析】探讨大世界游戏的制作流程及技术——前期流程篇

- 云计算搭建全部内容总结,保证可以搭建一个完整的云计算服务器,包括节点安装、实例的分配和网络的配置等内容

- This article introduces you to j.u.c's futuretask, fork/join framework and BlockingQueue

- 苹果期待的「无密码时代」,真能实现吗?

猜你喜欢

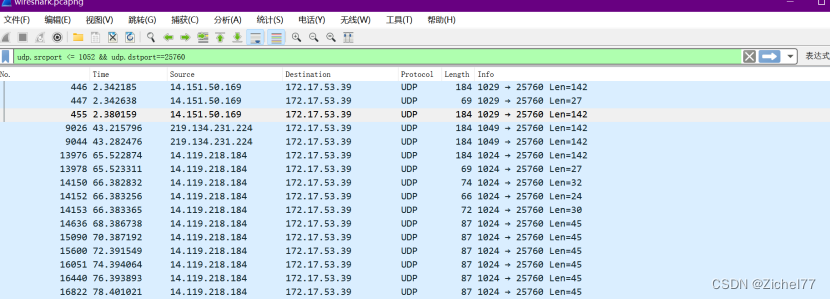

Wireshark learning notes (I) common function cases and skills

Abbexa CDAN1 siRNA使用说明书

mmcv之Config类介绍

Talk about those things about telecommuting, participate in the essay solicitation, receive the contribution fee and win the grand prize!

IP summary (tcp/ip volumes 1 and 2)

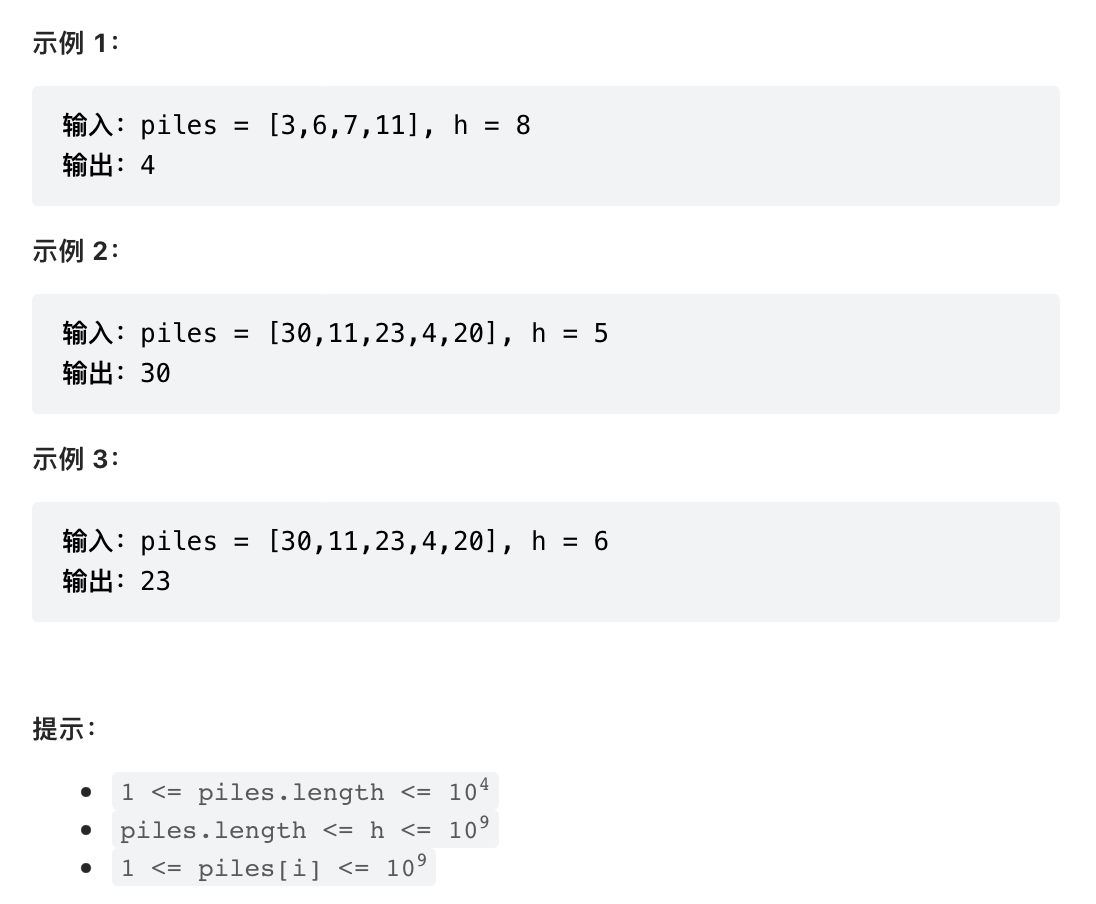

Leetcode 875. 爱吃香蕉的珂珂

Canvas fire burning H5 animation JS special effects

JS blur shadow follow animation JS special effect plug-in

js锚点定位可以扩展很多功能

AOE网关键路径

随机推荐

True thesis of information system project manager in the first half of 2022

你还在手写TS类型代码吗

Flutter在数字生活的发展与天翼云盘落地实践

Some views on the current CIM (bim+gis) industry

解决 vs2022在调试程序时缓慢加载一堆符号的问题

Chunk extend: hit training lab13

CUDA实现高效查找--审核未通过?

仅需三步学会使用低代码ThingJS与森数据DIX数据对接

js手机端复制文本到剪切板代码

Detailed explanation of MySQL windowing function

Leetcode 875. Coco, who likes bananas

Classic topics of leetcode tree (I)

Set up an online help center to easily help customers solve problems

Step on the pit. The BigDecimal was improperly used, resulting in P0 accident!

掌握高性能计算前,我们先了解一下它的历史

最新好文 | 基于因果推断的可解释对抗防御

ZigBee模块无线传输星形拓扑组网结构简介

基于注解和反射生成xml

聊聊远程办公那些事儿,参与征文领稿费拿大奖!

Container containing the most water