当前位置:网站首页>Apprentissage comparatif non supervisé des caractéristiques visuelles par les assignations de groupes de contrôle

Apprentissage comparatif non supervisé des caractéristiques visuelles par les assignations de groupes de contrôle

2022-07-07 11:15:00 【InfoQ】

- L'étude comparative des dieux au crépuscule

- “La course aux armements”L'étude comparative de la période est bonne.

- ToutimagenetFaire un dictionnaire,En extraire unmini batchComme échantillon positif. Ensuite, nous choisissons au hasard 4096 Barre comme échantillon négatif .

- Extraire un mini batch Pour l'agrandir , En utilisant un réseau jumeau , Mettre l'image originale sur un réseau , Placez le graphique amélioré dans un autre réseau , Les deux s'entraînent en même temps , Utilisez un NCE lossOuinfoNCE loss. Une image et son élargissement comme échantillon positif , Les images restantes et leur agrandissement en tant qu'échantillons négatifs .

- Extraire un mini batch Il a été agrandi deux fois , En utilisant un réseau jumeau , Mettre un ensemble d'améliorations d'image sur un réseau , Mettre un autre ensemble d'améliorations d'image sur un autre réseau , Les deux s'entraînent en même temps , Utilisez un NCE lossOuinfoNCE loss.

- Il peut être extrait à plusieurs reprises dans les mêmes données . Bien que votre ensemble de données ait beaucoup d'images , Mais vous pouvez en tirer la même image .Dans des cas extrêmes, Si vous prenez un ensemble d'images comme échantillon positif , Ensuite, vous prenez le même ensemble d'images répétées comme échantillon négatif . Ça pourrait avoir un impact sur l'entraînement. .

- Ou peut ne pas être représentatif de l'ensemble des données . Par exemple, il y a beaucoup d'animaux dans ces données , Mais tu fumes des chiens , De cette façon, les données ne sont pas représentatives .

- Bien sûr, plus la sélection est complète, mieux c'est. , Mais si vous choisissez trop d'échantillons négatifs, vous risquez de gaspiller des ressources informatiques .

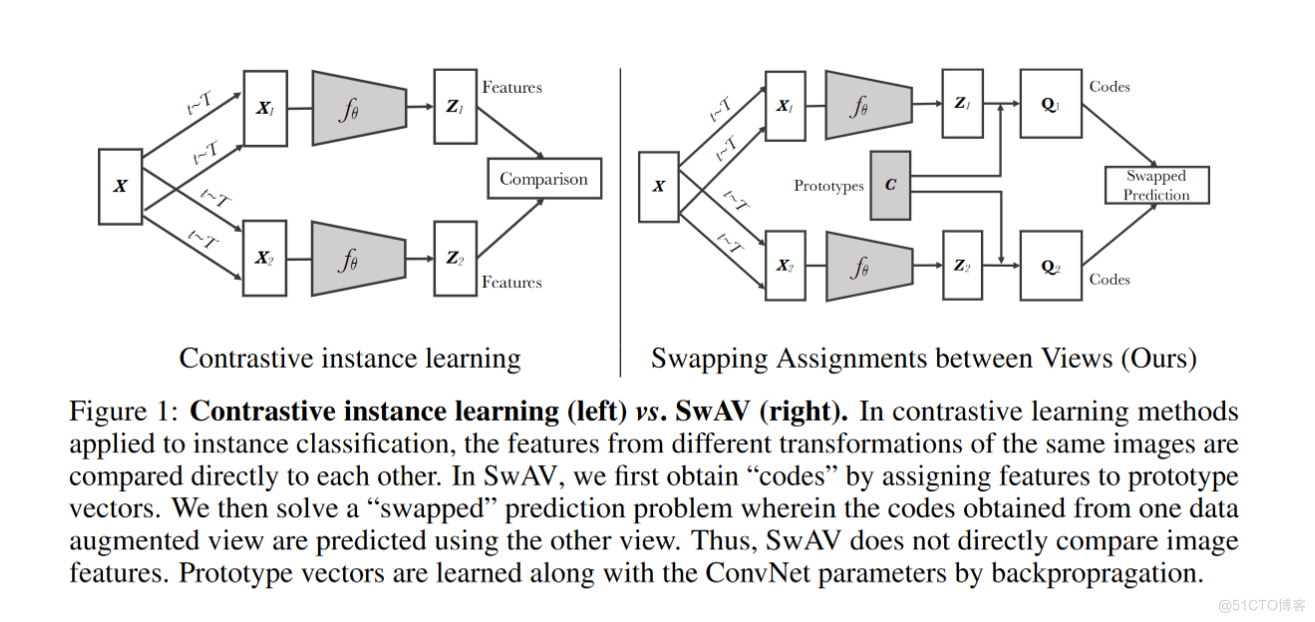

- Commençons par les questions répétitives : Parce que vous utilisez des centres de regroupement pour comparer . Bien que différents centres de regroupement , Il n'y a donc aucune chance qu'il se répète .

- Encore une fois, il n'y a pas de représentation : Le regroupement consiste à regrouper de nombreuses images dans différentes catégories . Comparaison avec le Centre de chaque catégorie , Est absolument représentatif .

- Encore une fois, il y a eu trop d'échantillons négatifs dans le passé, ce qui a entraîné un gaspillage de ressources . Si vous voulez faire une analogie avec beaucoup d'échantillons négatifs , Il faudrait des milliers d'échantillons négatifs , Et même ainsi, ce n'est qu'une approximation , Et si on le compare au centre de regroupement , Vous pouvez utiliser des centaines ou un maximum de 3,000Centres de regroupement, Ça suffit pour dire . Réduction significative de la consommation de ressources informatiques .

边栏推荐

- Multithreaded application (thread pool, singleton mode)

- Transaction rolled back because it has been marked as rollback only

- Kitex 重试机制

- mif 文件格式记录

- 基于Retrofit框架的金山API翻译功能案例

- Drive HC based on de2115 development board_ SR04 ultrasonic ranging module [source code attached]

- 学习笔记|数据小白使用DataEase制作数据大屏

- The use of list and Its Simulation Implementation

- What if copying is prohibited?

- Unity websocket server

猜你喜欢

seata 1.3.0 四種模式解决分布式事務(AT、TCC、SAGA、XA)

Still cannot find RPC dispatcher table failed to connect in virtual KD

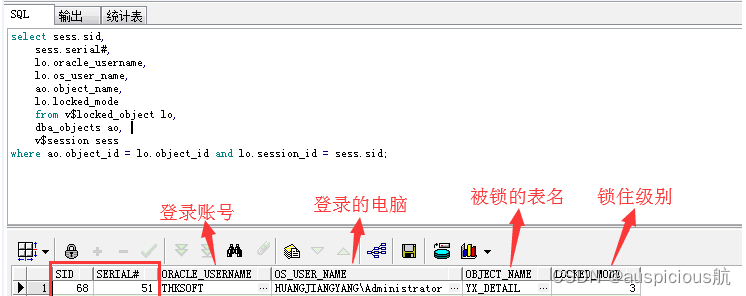

oracle常见锁表处理方式

![[STM32] actual combat 3.1 - drive 42 stepper motors with STM32 and tb6600 drivers (I)](/img/cd/7cd8e2e77419c65d633a2a235b2362.png)

[STM32] actual combat 3.1 - drive 42 stepper motors with STM32 and tb6600 drivers (I)

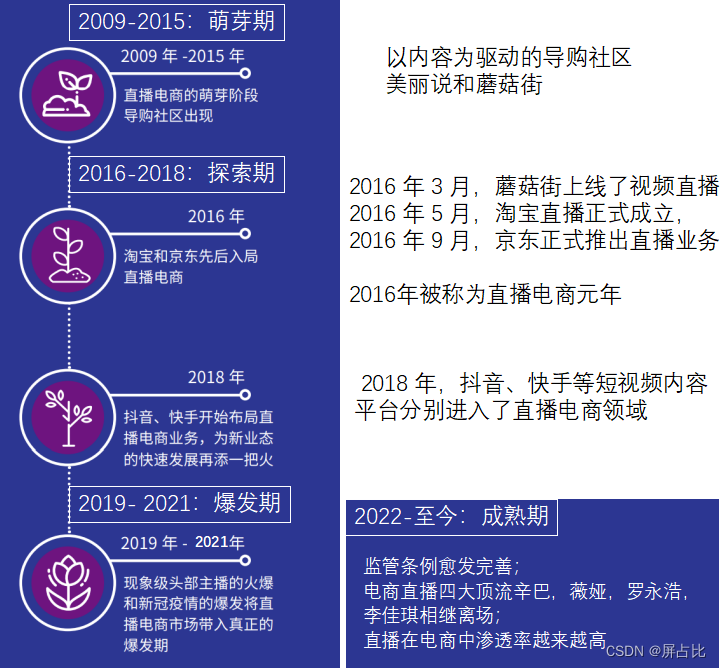

從色情直播到直播電商

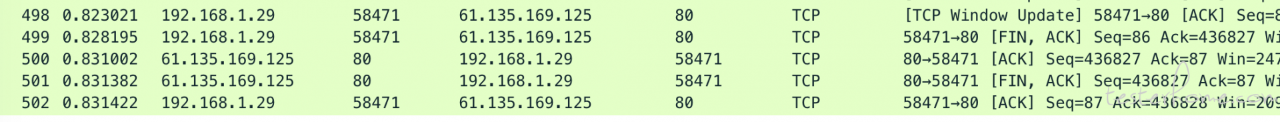

技术分享 | 抓包分析 TCP 协议

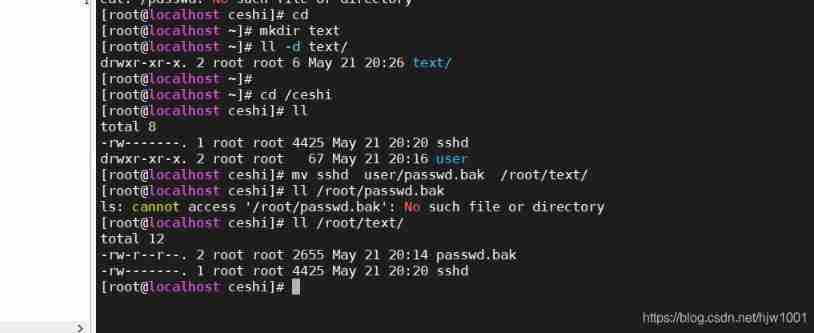

2021-05-21

对比学习之 Unsupervised Learning of Visual Features by Contrasting Cluster Assignments

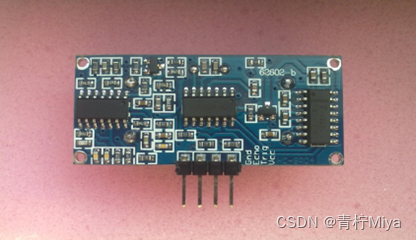

基于DE2 115开发板驱动HC_SR04超声波测距模块【附源码】

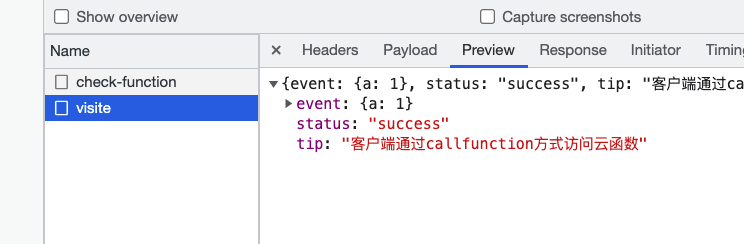

uniCloud

随机推荐

Une fois que l'uniapp a sauté de la page dans onlaunch, cliquez sur Event Failure resolution

Unity script generates configurable files and loads

Process control (creation, termination, waiting, program replacement)

Poj1821 fence problem solving Report

Unity websocket client

Wallhaven壁纸桌面版

Multithreaded application (thread pool, singleton mode)

对比学习之 Unsupervised Learning of Visual Features by Contrasting Cluster Assignments

Arduino receives and sends strings

Verilog 实现数码管显视驱动【附源码】

Static semantic check of clang tidy in cicd

普通测试年薪15w,测试开发年薪30w+,二者差距在哪?

The post-90s resigned and started a business, saying they would kill cloud database

oracle常见锁表处理方式

Interprocess communication (IPC)

Ping tool ICMP message learning

Eth trunk link switching delay is too high

Qt|多个窗口共有一个提示框类

高考作文,高频提及科技那些事儿……

Seata 1.3.0 four modes to solve distributed transactions (at, TCC, Saga, XA)