当前位置:网站首页>spark 读取本地文件

spark 读取本地文件

2022-08-02 07:00:00 【this is a book】

1 背景

基于spark 开发程序

数据放在本地文件中,为text格式

本文语言案例为java

2 步骤

2.1 搭建工程

基于maven搭建spark工程_this is a book的博客-CSDN博客

2.2 代码示例

SparkConf conf = new SparkConf().setAppName("demo").setMaster("local[*]");

SparkSession sparkSession = SparkSession.builder().config(conf).getOrCreate();

JavaSparkContext javaSparkContext = new JavaSparkContext(sparkSession.sparkContext());

JavaRDD<String> rdd = javaSparkContext.textFile(INPUT_PATH);

rdd.foreach(new VoidFunction<String>() {

@Override

public void call(String s) throws Exception {

System.out.println(s);

}

}); 3 注意事项

如果是放在linux 服务器上,并且跑在spark 上,文件路径需要加这个前缀

file:///data/demo.text原因是spark一般和hdms组合使用,读取本地文件需要加前缀表明读取的是本地文件

边栏推荐

猜你喜欢

张驰课堂:六西格玛培训工具——箱线图

【图像去噪】基于matlab双立方插值和稀疏表示图像去噪【含Matlab源码 2009期】

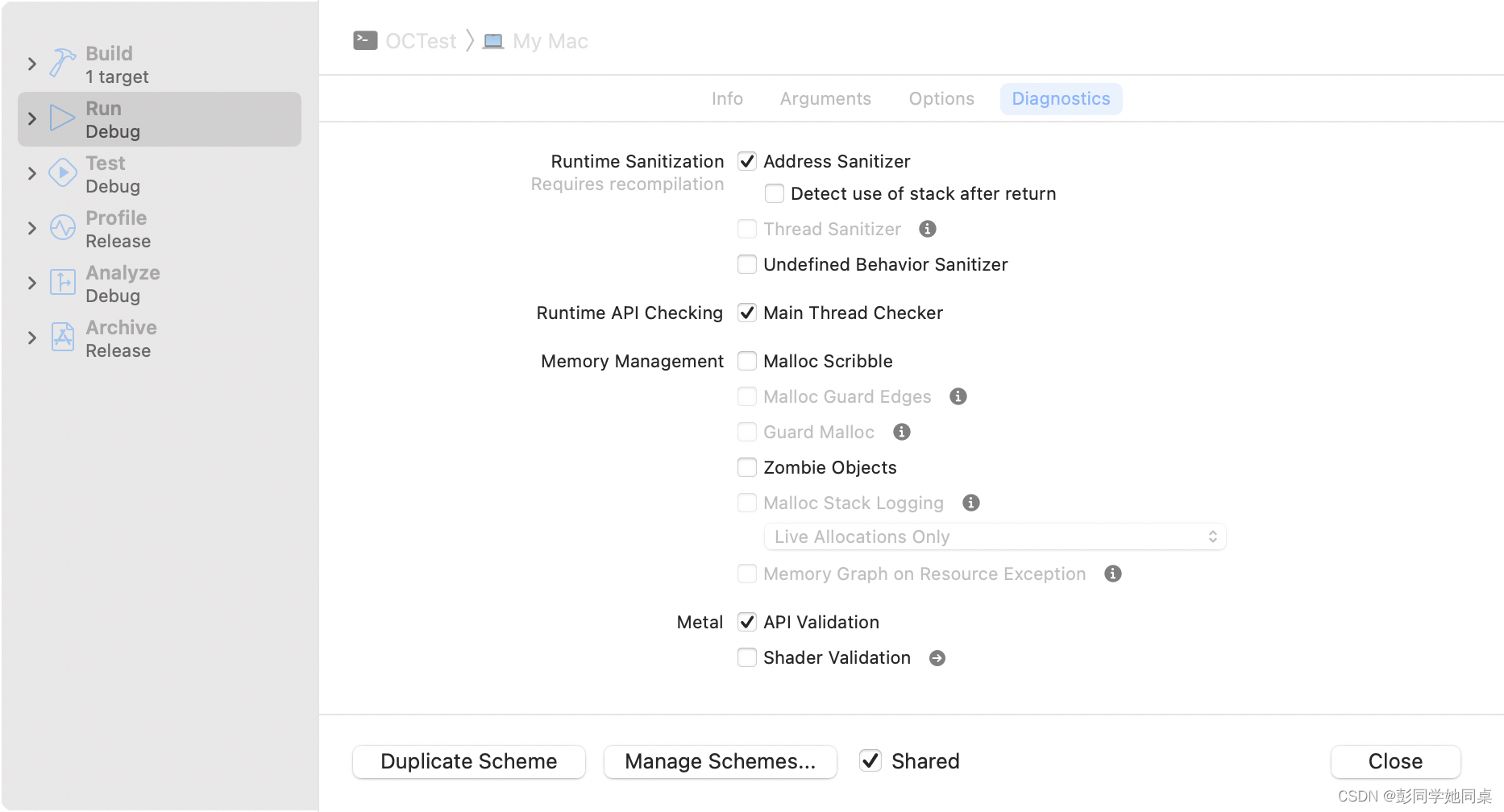

OC-错误提示

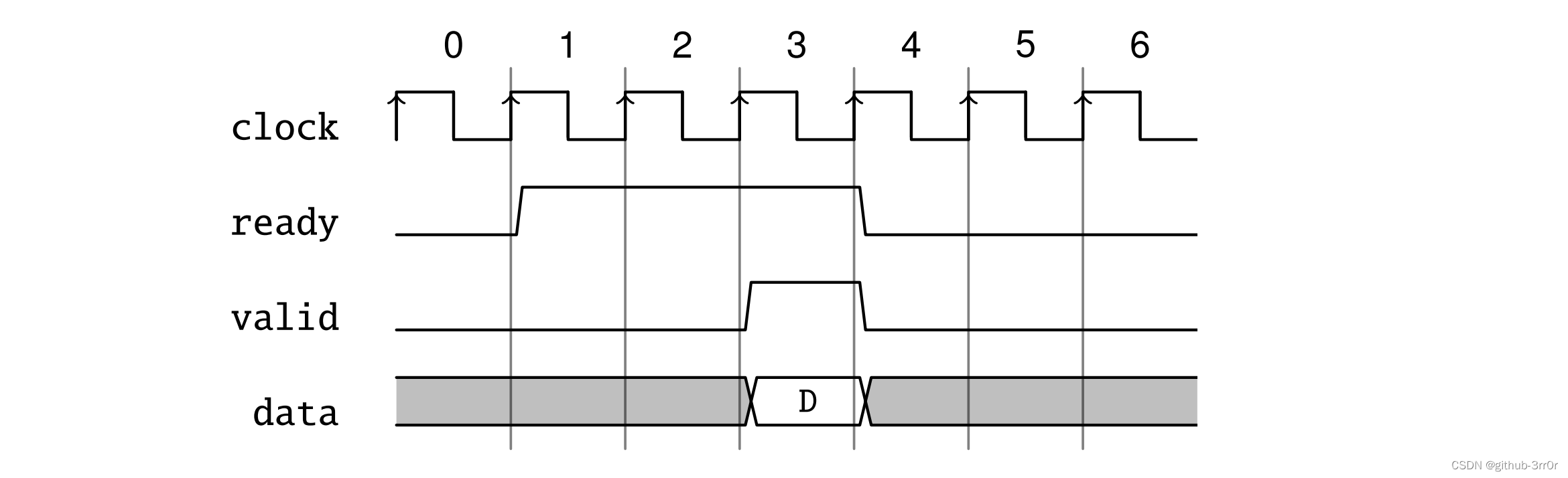

吃透Chisel语言.31.Chisel进阶之通信状态机(三)——Ready-Valid接口:定义、时序和Chisel中的实现

你认同这个观点吗?大多数企业的数字化都只是为了缓解焦虑

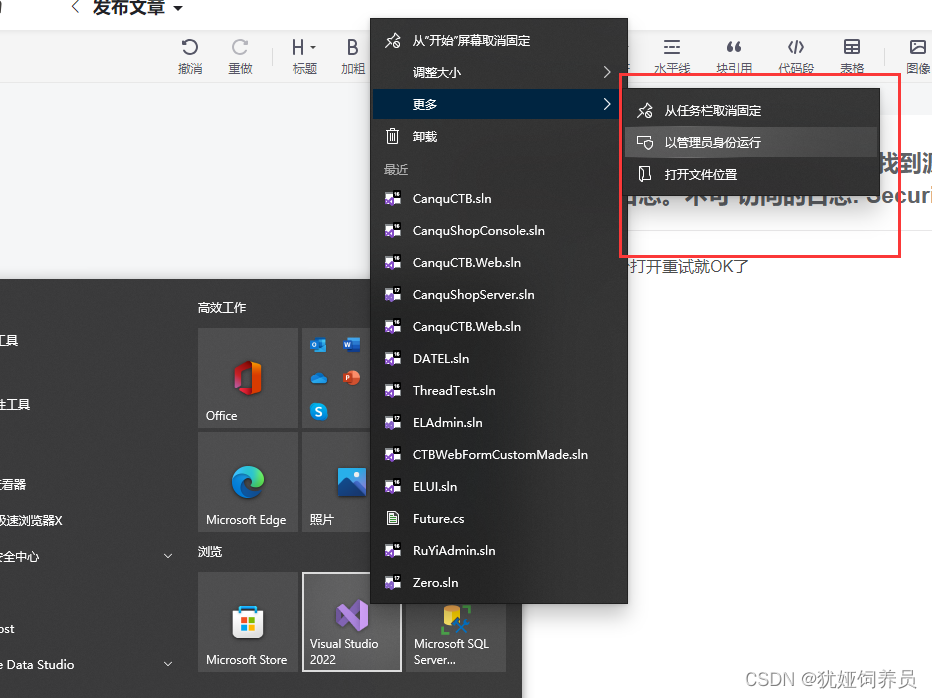

System.Security.SecurityException: 未找到源,但未能搜索某些或全部事件日志。不可 访问的日志: Security

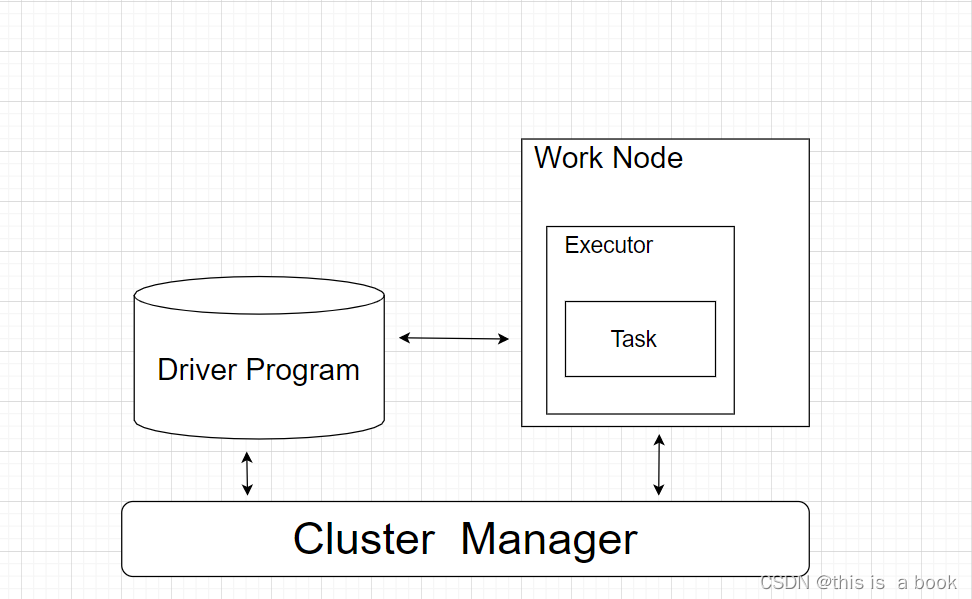

spark架构

实例026:递归求阶乘

2022.07.31(LC_6133_分组的最大数量)

C#重点问题之Struct和Class的异同

随机推荐

OC-NSDictionary

企业实训复现指导手册——基于华为ModelArts平台的OpenPose模型的训练和推理、基于关键点数据实现对攀爬和翻越护栏两种行为的识别、并完成在图片中只标注发生行为的人

埋点开发流程

LeetCode 2312. 卖木头块

实验8 VLAN综合实验

2020美亚团队赛复盘

PWA 踩坑 - 第一次加载页面后无法获取CacheStorage某些资源

【CV】OpenVINO安装教程

gdalinfo: error while loading shared libraries: libgdal.so.30: cannot open shared object file: No su

Gradle系列——Gradle插件(基于Gradle文档7.5)day3-2

FormData上传二进制文件、对象、对象数组

【网络】IP、子网掩码

Facebook社媒营销的5大技巧,迅速提高独立站转化率!

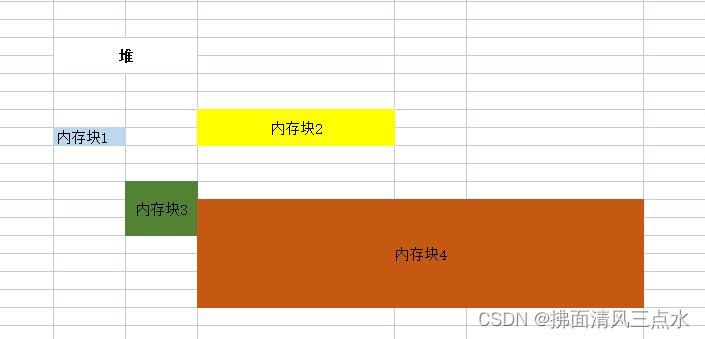

jvm 二之 栈帧内部结构

获取间隔的日期列表工具类

主流定时任务解决方案全横评

交换部分 VLAN

21 days learning challenge 】 【 sequential search

自然语言处理 文本预处理(下)(张量表示、文本数据分析、文本特征处理等)

OC-NSArray