当前位置:网站首页>E-commerce data warehouse ODS layer-----log data loading

E-commerce data warehouse ODS layer-----log data loading

2022-08-03 21:34:00 【big data theory】

First generate the simulated log data and upload it to hdfs层

再将hdfsThe log data in the cut data is loaded intoODS层日志

一般企业在搭建数仓时,业务系统中会存在一定的历史数据,此处为模拟真实场景,需准备若干历史数据.假定数仓上线的日期为2020-06-14,具体说明如下.

1.用户行为日志

用户行为日志,一般是没有历史数据的,故日志只需要准备2020-06-14一天的数据.具体操作如下:

1)启动日志采集通道,包括Flume、Kafak等

2)修改两个日志服务器(hadoop102、hadoop103)中的/opt/module/applog/application.yml配置文件,将mock.date参数改为2020-06-14.

3)执行日志生成脚本lg.sh.

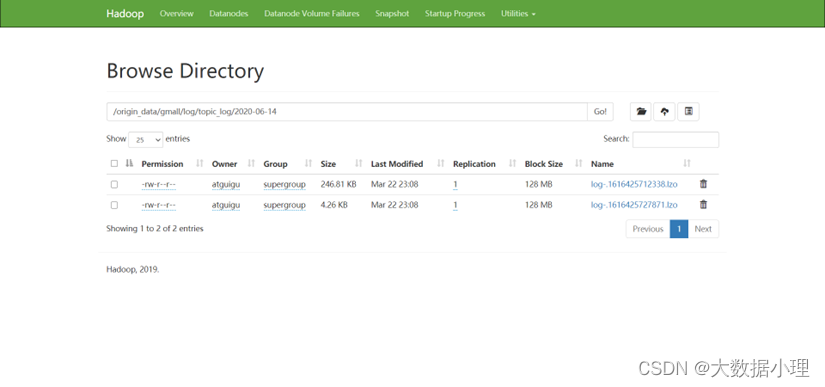

4)观察HDFS是否出现相应文件.

以下使用datagripData warehouse tools and script commands

create database gmall;

– ODS层

– ODS日志表

drop table if exists ods_log;

create external table ods_log(linestring)

partitioned by (dtstring) --按照时间创建分区

stored as inputformat ‘com.hadoop.mapred.DeprecatedLzoTextInputFormat’

–指定存储格式,读数据采用LzoTextInputFormat;

OUTPUTFORMAT ‘org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat’

LOCATION ‘/warehourse/gmall/ods/ods_log’ --指定数据在hdfs上的存储位置

;

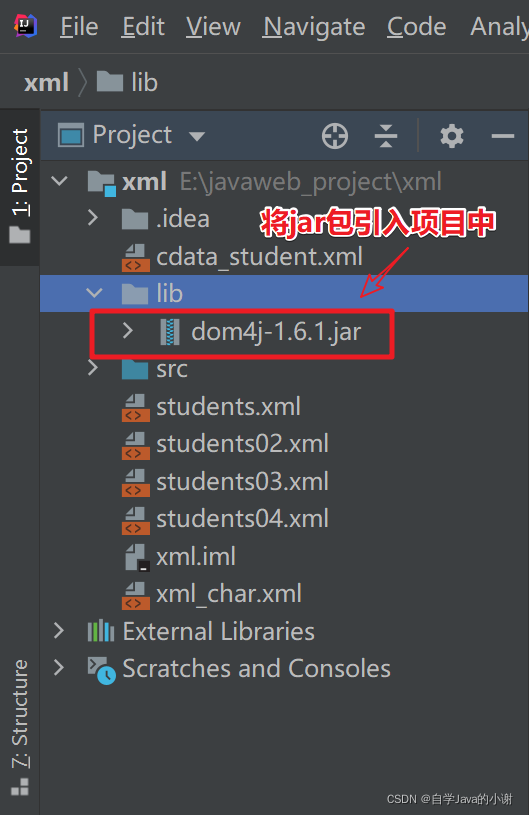

–数据装载语句:Load with a load script

–2020-06-14

//load data inpath ‘/origin_data/gmall/log/topic_log/2020-06-14’ into table ods_log partition(dt=‘2020-06-14’);

–为hiveCreate an index on the files in the table

// [bin]$ hadoop jar /opt/module/hadoop3.1.3/share/common/hadoop-lzo-0.4.20.jar

– com.hadoop.compression.lzo.DistributedLzoIIndexer /warehouse/gmall/ods/ods_log/dt=2020-06-14

// 即hadoop jar jar包位置 全类名 to create an indexlzo文件所在的路径

//创建脚本 vim hdfs_to_ods_log.sh 再 chmod 777 hdfs_ods_log.sh

/*

#!/bin/bash

定义变量方便修改

APP=gmall

hive=/opt/module/hive/bin/hive

如果是输入的日期按照取输入日期;如果没输入日期取当前时间的前一天

if [ -n “$1” ] ;then

do_date=$1

else

do_date=date -d "-1 day" +%F

fi

echo ================== 日志日期为 d o d a t e = = = = = = = = = = = = = = = = = = s q l = " l o a d d a t a i n p a t h ′ / o r i g i n d a t a / do_date ================== sql=" load data inpath '/origin_data/ dodate==================sql="loaddatainpath′/origindata/APP/log/topic_log/$do_date’ into table A P P . o d s l o g p a r t i t i o n ( d t = ′ {APP}.ods_log partition(dt=' APP.odslogpartition(dt=′do_date’);

"

h i v e − e " hive -e " hive−e"sql"

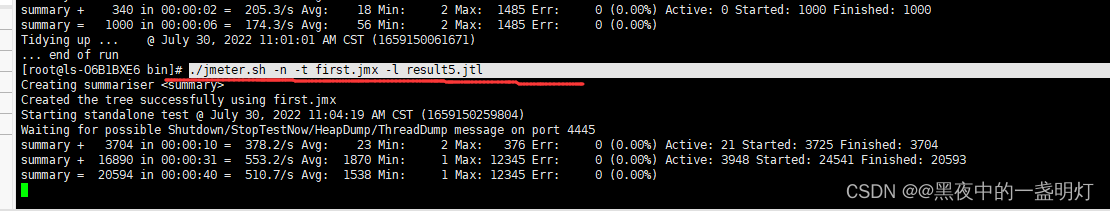

hadoop jar /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar com.hadoop.compression.lzo.DistributedLzoIndexer /warehouse/ A P P / o d s / o d s l o g / d t = APP/ods/ods_log/dt= APP/ods/odslog/dt=do_date

*/

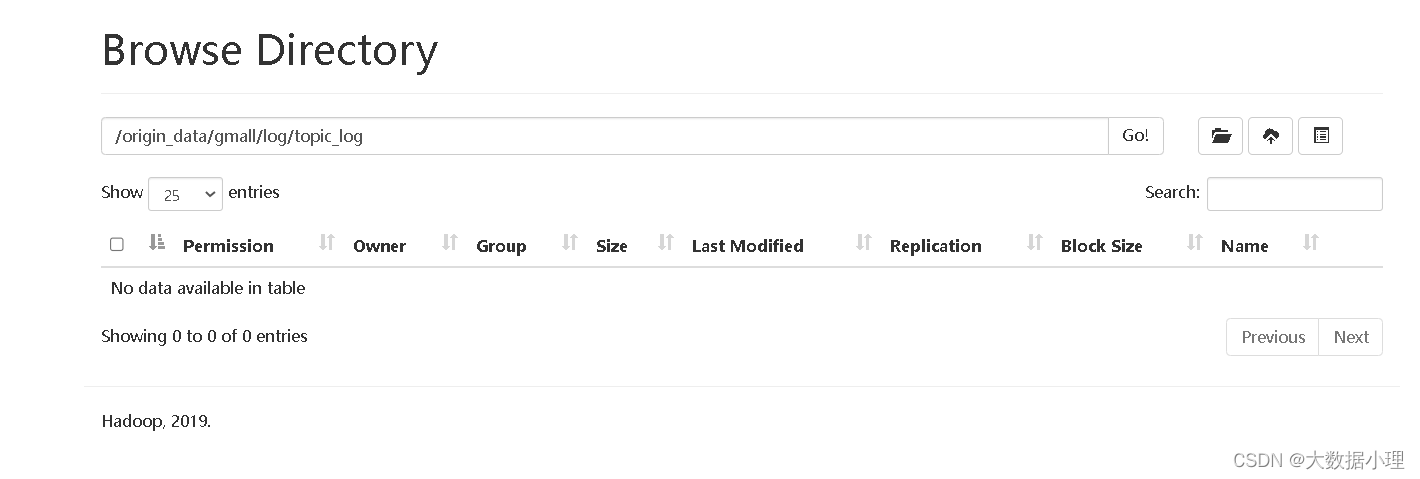

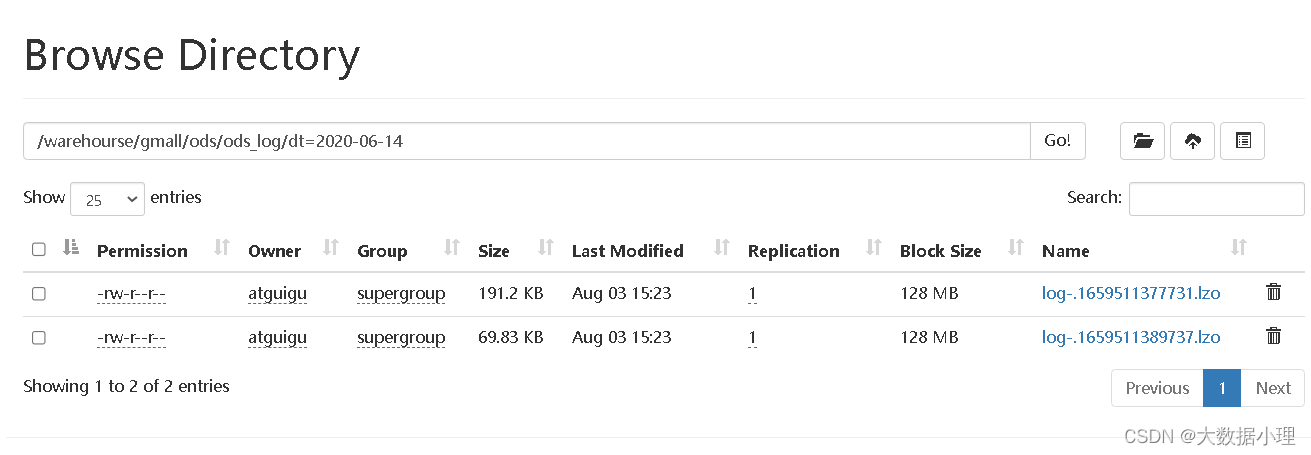

After executing the script, the files in the original path are gone,剪切到了ODSlayer in the log layer

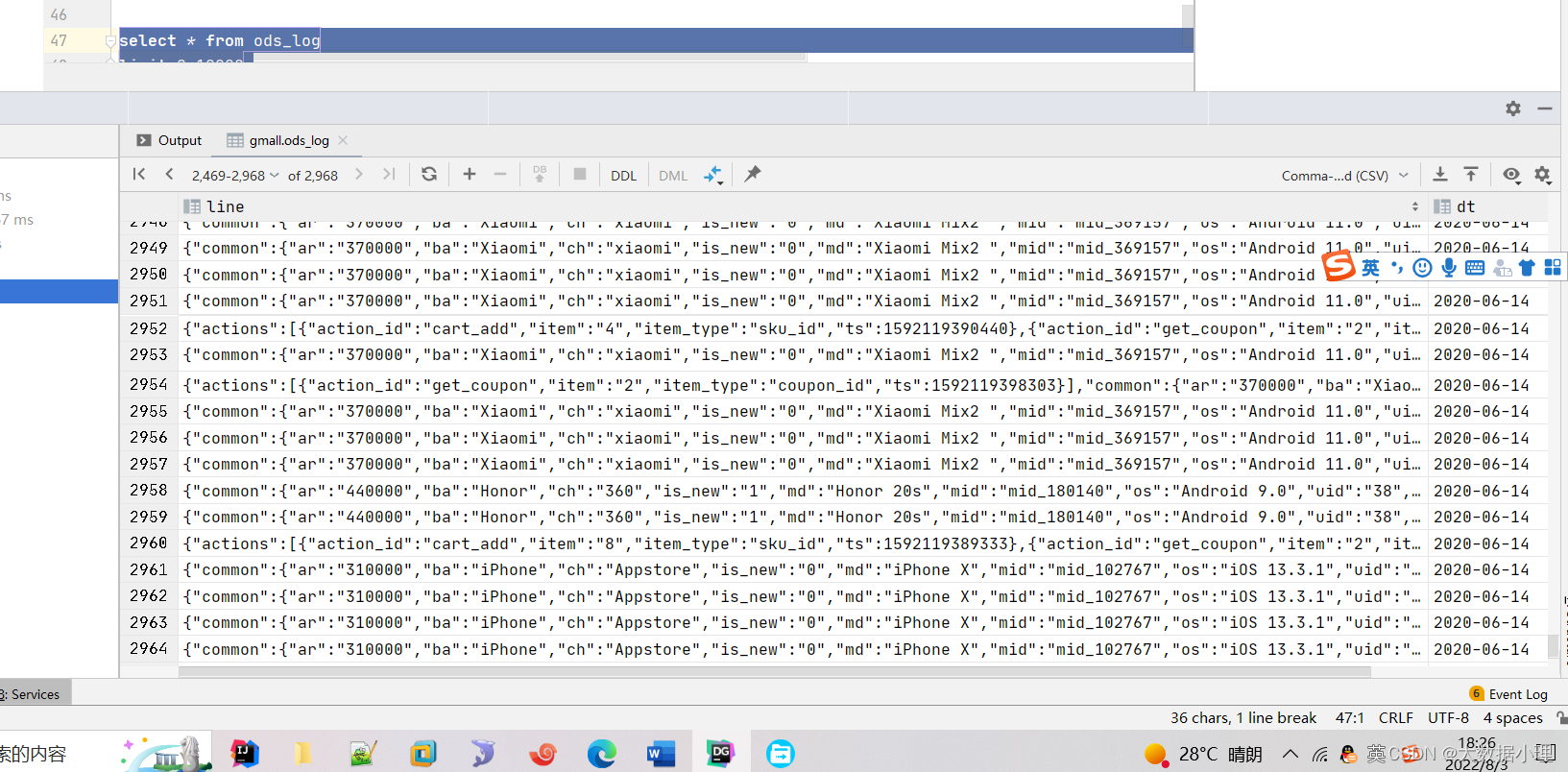

通过datagripYou can see that the data is loaded into the table

Double-click a table to view table data

边栏推荐

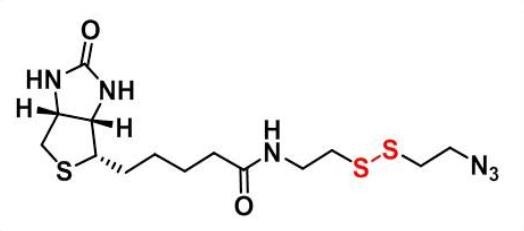

- CAS:1620523-64-9_Azide-SS-biotin_生物素-二硫-叠氮

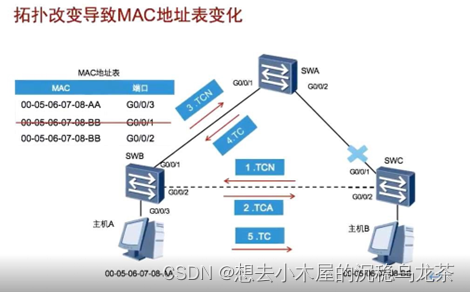

- 现网设备兼容SRv6网络演进

- [kali-vulnerability scanning] (2.1) Nessus lifts IP restrictions, scans quickly without results, and plugins are deleted (middle)

- AI首席架构师13-AICA-智能文档分析技术在行业场景中的应用

- 『百日百题 · 基础篇』备战面试,坚持刷题 第四话——循环语句!

- 剑指 Offer 16. 数值的整数次方

- STP生成树

- 易基因|RNA m5C甲基化测序(RNA-BS)技术介绍

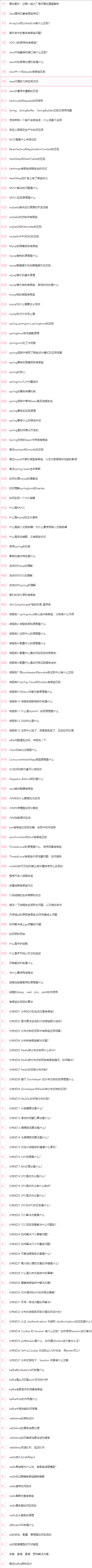

- 尚医通项目总结

- 太香了! 阿里 Redis 速成笔记, 从头到尾全是精华!

猜你喜欢

随机推荐

AI首席架构师13-AICA-智能文档分析技术在行业场景中的应用

Zero trust, which has been popular for more than ten years, why can't it be implemented?

业界新标杆!阿里开源自研高并发编程核心笔记(2022 最新版)

软考系统分析师备考经验分享:论持久战

ES、Kibana 8.0安装

Soft exam system analysts note experience sharing: theory of protracted war

聚焦开源与联合共创|麒麟软件出席开源峰会欧拉分论坛

XSS online shooting range---haozi

461. 汉明距离

XSS holes emersion

检测和控制影子IT的五个步骤

『百日百题 · 基础篇』备战面试,坚持刷题 第四话——循环语句!

基于data.table的tidyverse?

主板设计中:网络变压器与RJ45网口之间应该保持什么样的距离?

模板字符串

易基因|RNA m5C甲基化测序(RNA-BS)技术介绍

2022年全国职业院校技能大赛网络安全 B模块 任务十windows操作系统渗透测试 国赛原题

分分钟教你读取 resources 目录下的文件路径

PyCharm function automatically add comments without parameters

深度学习怎么入门?零基础快速入门深度学习