当前位置:网站首页>spark集群部署(第三弹)

spark集群部署(第三弹)

2022-08-05 08:07:00 【发量不足】

目录

3.测试spark HA集群,为演示是否解决单点故障问题,关闭master节点的master进程

spark集群部署

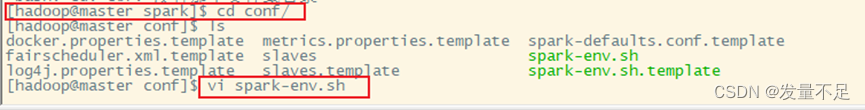

1 修改spark-env.sh配置文件

$ssh master

$cd opt/module/spark/conf

$vi spark-env.sh

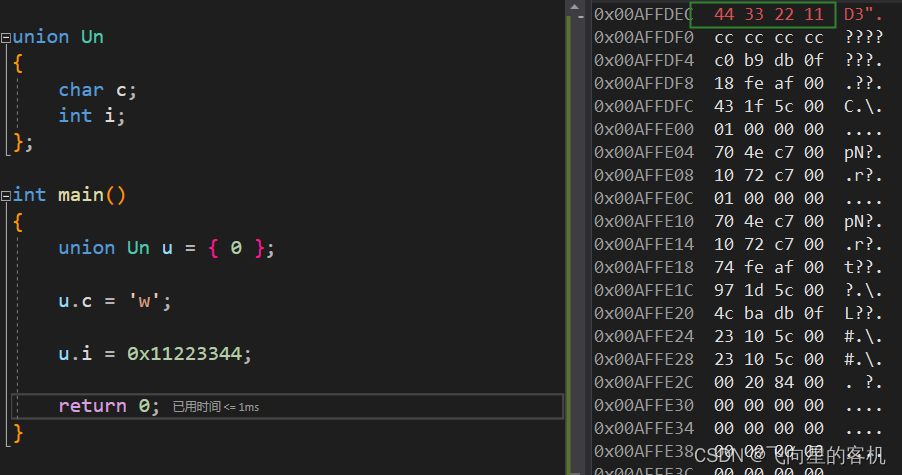

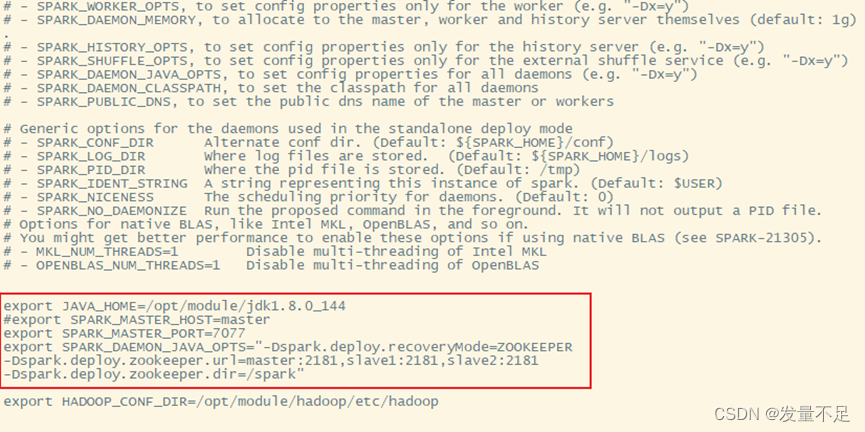

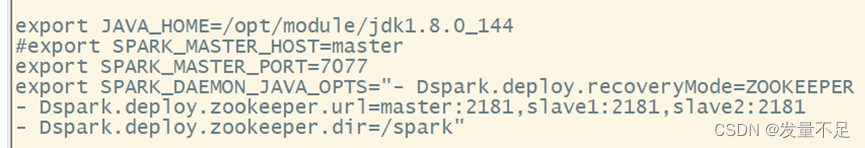

步骤1 将指定master节点配置参数注释‘#’,添加SPARK_DAEMON_JAVA_OPTS配置参数

export JAVA_HOME=/opt/module/jdk1.8.0_144

#export SPARK_MASTER_HOST=master

export SPARK_MASTER_PORT=7077

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=master:2181,slave1:2181,slave2:2181

-Dspark.deploy.zookeeper.dir=/spark"

(1)spark.deploy.recoveryMode=ZOOKEEPER:设置zookeeper去启用备用master模式

(2)spark.deploy.zookeeper.url=master:指定zookeeper的server地址

(3)spark.deploy.zookeeper.dir:保存集群元数据信息的文件和目录

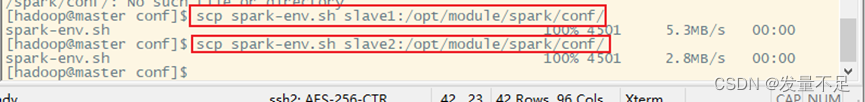

将spark-env.sh分发至slave1和slave2节点上,保证配置文件统一

scp spark-env.sh slave1:/opt/module/spark/conf/

scp spark-env.sh slave2:/opt/module/spark/conf/

2 启动spark HA集群

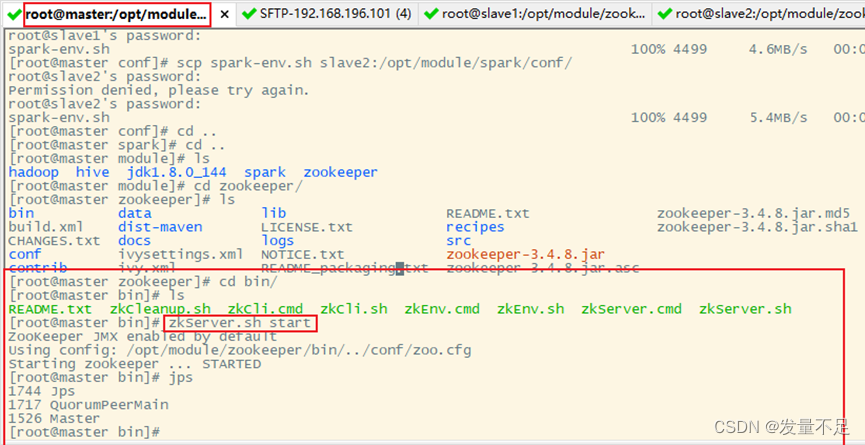

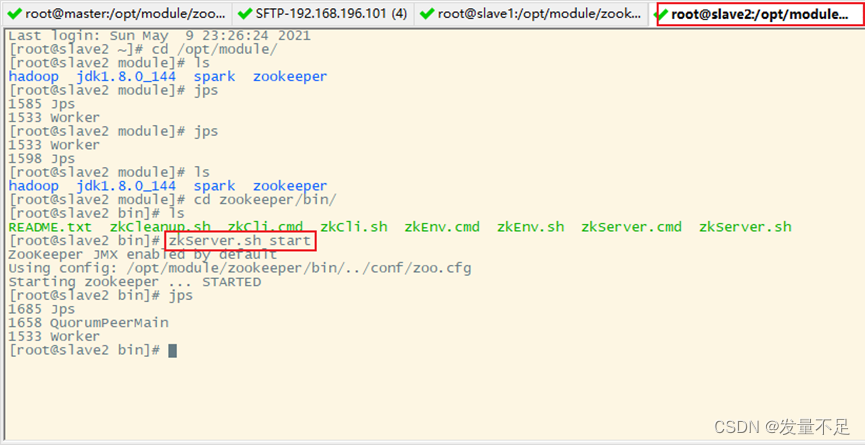

$cd /opt/module/zookeeper/bin

$ zkServer.sh start

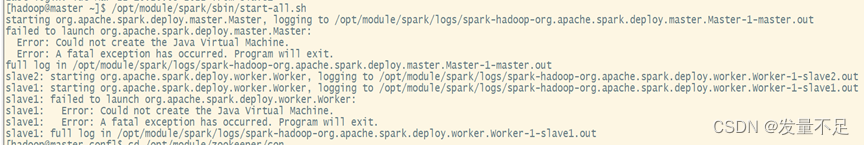

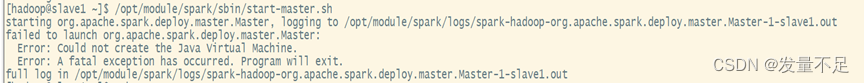

解决:配置问题,自己把spark-env.sh配置内容里的横杆空格了

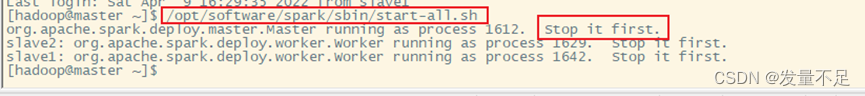

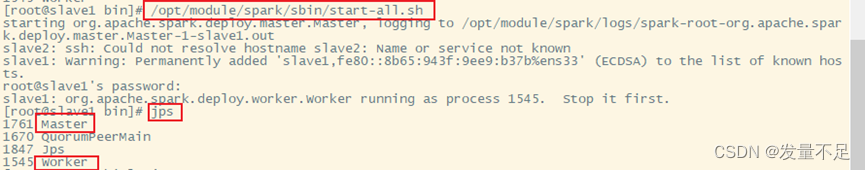

问题2 在slave1节点启动master服务报 stop it first(意思是要你先停止这个,才能开启master,也可以不去停止)

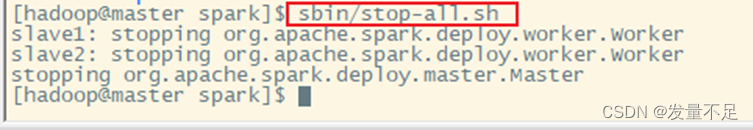

$cd opt/software/spark

$sbin/stop-all.sh

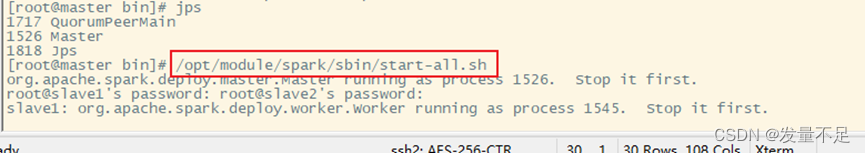

解决以上的问题后,重新在master节点启动spark集群与在slave节点单独启动master服务

在master节点上单独启动spark服务

$/opt/module/spark/sbin/start-all.sh

在slave1节点上单独启动Master服务

$/opt/module/spark/sbin/start-master.sh

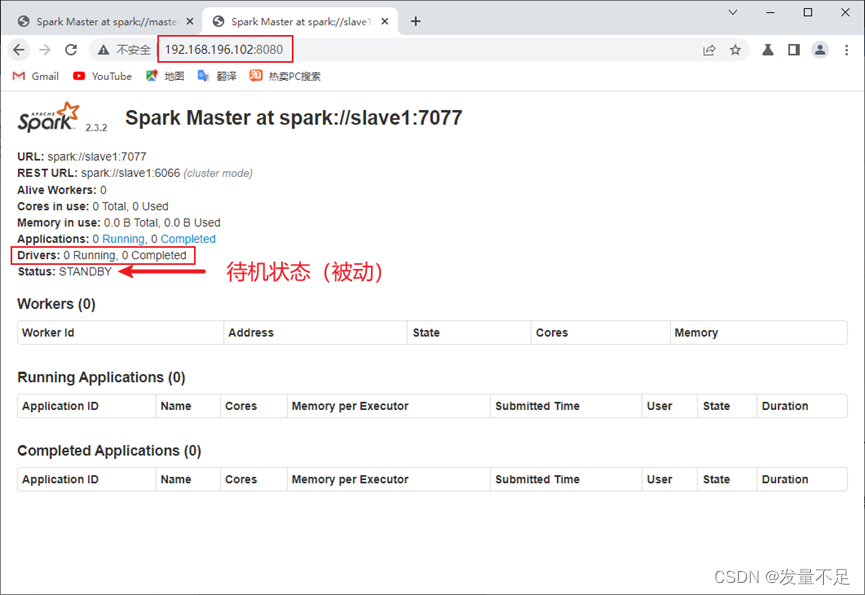

步骤2 访问http://192.168.196.102(slave1):8080,查看备用master节点状态

Status:STANDBY # 说明spark HA配置完成

3.测试spark HA集群,为演示是否解决单点故障问题,关闭master节点的master进程

$ /opt/module/spark/sbin/stop-master.sh

边栏推荐

猜你喜欢

随机推荐

青苹果论坛重新开放

生命的颜色占卜

强网杯2022 pwn 赛题解析——house_of_cat

行业应用软件项目经理三步曲

外企Office常用英语

P1160 队列安排

线性代数对角化

图片地址转为base64

每月稳定干2万

控制器-----controller

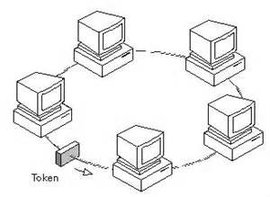

Ethernet Principle

【无标题】长期招聘硬件工程师-深圳宝安

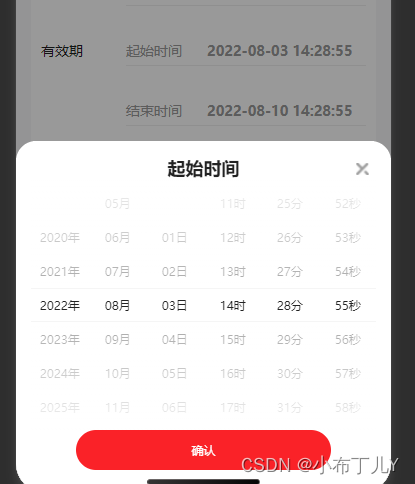

uniapp time component encapsulates year-month-day-hour-minute-second

C-Eighty seven(背包+bitset)

Support touch screen slider carousel plugin

撕裂寂寞

P1103 书本整理

学习机赛道加速:请“卷”产品,不要“卷”营销

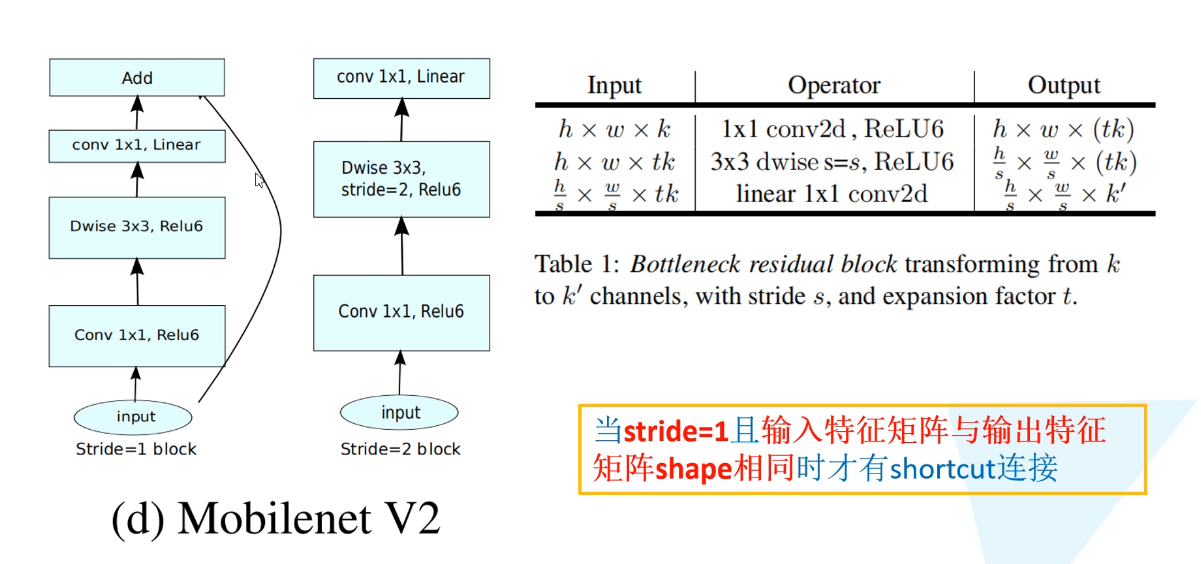

MobileNetV2架构解析

配合屏幕录像专家,又小又清晰!