当前位置:网站首页>[300+ selected big factory interview questions continue to share] Big data operation and maintenance sharp knife interview questions column (10)

[300+ selected big factory interview questions continue to share] Big data operation and maintenance sharp knife interview questions column (10)

2022-08-02 19:03:00 【Big Data Research Institute】

持续分享有用、有价值、精选的优质大数据面试题

致力于打造全网最全的大数据面试专题题库

91、首次启动 HDFS 时,The command that must be formatted?

参考答案:

bin/hdfs namenode -format或者bin/hadoop namenode –format

92、单独启停HDFS 进程命令?

参考答案:

1)启停NameNode

bin/hdfs --daemon start namenode

bin/hdfs --daemon stop namenode

2)启停DataNode

bin/hdfs --daemon start datanode

bin/hdfs --daemon stop datanode

93、NameNodeWhat are the main functions of ?

参考答案:

One is to manage the metadata information of file system files(包括文件名称、大小、位置、属性、创建时间、修改时间等等).

The second is to maintain the correspondence between files and blocks and the correspondence between blocks and nodes.

The third is to maintain the user's operation information on the file(文件的增删改查).

94、一个datanode 宕机,怎么恢复?

参考答案:

Datanode宕机了后,If it is a short downtime,Script monitoring can be implemented,将它启动起来.如果是长时间宕机了,那么datanode上的数据应该已经被备份到其他机器了,那这台datanode就是一台新的datanode了,Delete all his data files and state files,重新启动.

95、Hadoop 的 namenode 宕机,怎么解决?

参考答案:

(1)先分析宕机后的损失,宕机后直接导致client无法访问,内存中的元数据丢失,But the metadata on the hard drive should still be there,如果只是节点挂了,重启即可.

(2)如果是机器挂了,重启机器后看节点是否能重启,不能重启就要找到原因修复了.But the final solution should be to take this into account in the early stages of designing the cluster,做namenode的HA.

提高容错:

第一种方式是将持久化存储在本地硬盘的文件系统元数据备份.

第二种方式是运行一个辅助的NameNode(Secondary Namenode).

第三种 zookeeper提供的高可用(ha)机制.

96、hadoop出现文件块丢失怎么处理?

参考答案:

First need to locate where the data block is lost,可以通过查看日志进行检查和排除,找到文件块丢失的位置后,如果文件不是很重要可以直接删除,Then re-copy it to the previous copy of the cluster,如果删除不了,Every cluster will have backups,Need to restore backup.

97、当hdfsWhen there are too many small files,如何合并小文件?

参考答案:

(1)当每个小文件数据量比较小的时候,可以通过命令的方式进行小文件的合并如:

hdfs dfs -cat hdfs://mycluster/logs/*.log | hdfs dfs -appendToFile - hdfs://mycluster/logs/largeFile.log.

(2)It is recommended to use it when the amount of data is relatively largeMR进行小文件的合并.

98、hdfs Common data compression algorithms?

参考答案:

(1) Gzip 压缩

(2)Bzip2 压缩

(3)Lzo 压缩

(4)Snappy 压缩

99、有180的文件写入HDFS是先写128M 复制完之后再写52M 还是全部写完再复制?

参考答案:

HDFS上在写入数据的时候,首先会对数据切块,然后从客户端到datanode形成一个管道,在至少将一个文件写入hdfs上后,表示文件写入成功,然后进行复制备份操作,所以是全部写完再复制.

100、为什么会产生YARN,它解决了什么问题?有什么优势?

参考答案:

(1)产生原因

MapReduce存在的问题:

1)JobTracker 单点故障.

2)JobTracker 承受的访问压力大,影响系统的扩展性.

3)不支持MapReduce之外的计算框架,比如Storm、Spark、Flink.

(2)解决的问题

1)yarn 解决了JobTracker Overload problem, 将MR1中JobTracker的资源管理和作业调度两个功能分开,分别由ResourceManager和ApplicationMaster进程来实现.

2)支持更多的计算框架,MapReduce storm Spark Flink都可以运行在yarn上面.

(3)优势

1)更快地MapReduce计算.

2)对多框架支持.

3)框架升级更容易.

持续分享有用、有价值、精选的优质大数据面试题

致力于打造全网最全的大数据面试专题题库

边栏推荐

猜你喜欢

随机推荐

JZ9 用两个栈实现队列

DSP-ADAU1452输入通道配置

PostGresql listen与notify命令

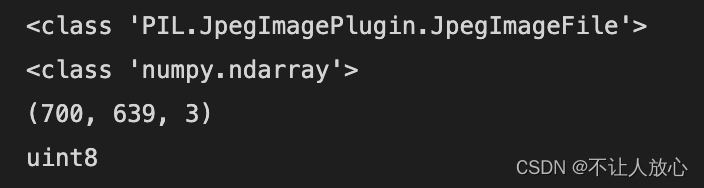

基于深度学习的机器人目标识别和跟踪

小程序实现手写左右翻页和动态修改横向滚动条位置

融云「 IM 进阶实战高手课」系列直播上线

【二】通过props进行传值,子页面多种方式接收

Default username and password (SQL)

【genius_platform软件平台开发】第七十五讲:YUY2转RGB24实现源码

JZ40 最小的K个数

红蓝对抗经验分享:CS免杀姿势

[LeetCode]剑指 Offer 32 - II. 从上到下打印二叉树 II

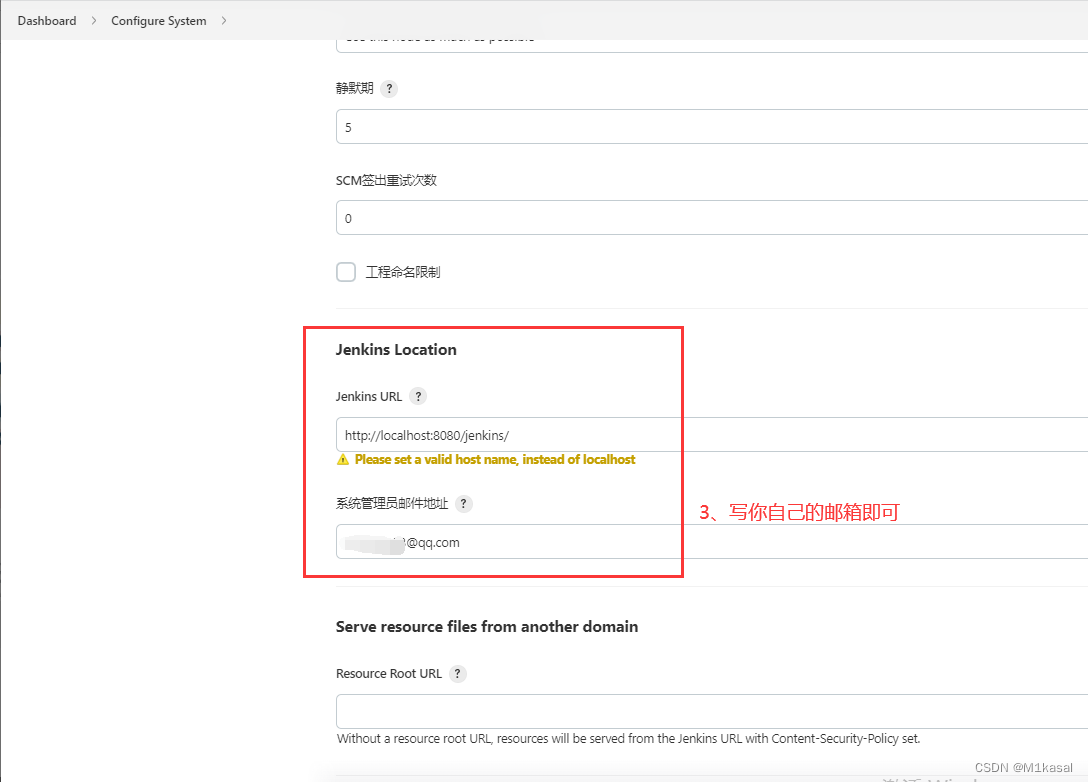

持续交付(一)JenkinsAPI接口调用

Locking and concurrency control (a)

es6 map使用场景

金仓数据库 OCCI 迁移指南(4. KingbaseES 的 OCCI 迁移指南)

牛客的课程订单分析[分组统计时如何取指定行字段?]

Summary of CNN classic models [easy to understand]

分类实验报告作业

synchronized已经不在臃肿了,放下对他的成见之初识轻量级锁