当前位置:网站首页>dataframe 常用操作

dataframe 常用操作

2022-08-05 05:15:00 【sc0024】

1、读取csv

import pandas as pd

df=pd.read_csv('/data1/littlesc/Uplift/criteo-uplift-v2.1.csv')

2、返回数据的行数

df.shape[0]

3、给某一列/某些列改名

df = df.rename(columns={

'treatment':'treatment_label'})

4、筛选

df_t = df[df['treatment_label']==1]

5、划分训练集和验证集

from sklearn.model_selection import train_test_split

df_train, df_test = train_test_split(df_use, test_size=0.3, random_state=111)

6、把两个列名一样的df竖直拼接起来

df = df_c.append(df_t_use, ignore_index=True)

7、reset_index

df_use=df_use.reset_index(drop=True)

8、去掉某一列或某些列

df_train=df_train.drop(columns=['treatment_group_key'])

9、将数值型转为字符串

df_train['upliftScore'] = df_train['upliftScore'].apply(str)

10、将字符型转成数值型

matched["upliftScore"] = pd.to_numeric(matched["upliftScore"],errors='coerce')

10.5 float转int

df['Class'] = df['Class'].astype(int)

11、获取dataframe所有的列名

方法一:[column for column in df]

方法二:list(df)

12、获取列的数据类型

每一列:df.dtypes

某一列:df['id'].dtypes

13、缺失值处理

#删除nan行

df=df.dropna()

# 删除nan列

df=df.dropna(axis=1)

#这一行都是nan才删除

df=df.dropna(how='all')

#一行中有一个nan就删除这一行

df_use=df_use.dropna(axis=0,how='any')

# 将nan设置为0

df.fillna(0)

#使用下一行的值进行填充

df=df.fillna(method='bfill')

#使用上一行的值进行填充

df=df.fillna(method='ffill')

#删除gender这一列是NaN的数据

data=data.dropna(subset=['gender'])

#筛选gender是'М'或'Ж'的数据

gender = ['М', 'Ж']

genders = '|'.join(gender)

data = data[data['gender'].str.contains(genders)]

#查看含有nan的行

df[df.isna().any(axis=1)]

#查看不含有nan的行

df[~df.isna().any(axis=1)]

14、解除行列显示限制

pd.set_option('display.max_columns', None)

pd.set_option('display.max_rows', None)

15、随机采样

DataFrame.sample(n, frac, replace, weights, random_state, axis)

n: 要抽取的行数,需为整数值

frac:抽取的比列,需为小数值,比方说我们想随机抽取30%的数据,则设置frac=0.3即可。

replace:抽样后的数据是否代替原DataFrame(),默认为False

weights:默认为等概率加权

random_state:随机种子,本质是一个控制器,设置此值为任意实数,则每次随机的结果是一样的

axis:抽取数据的行还是列,axis=0的时是抽取行,axis=1时是抽取列

边栏推荐

- 怎样在Disciples门徒获得收益?

- 6k+ star,面向小白的深度学习代码库!一行代码实现所有Attention机制!

- AWS 常用服务

- Flink HA配置

- IDEA 配置连接数据库报错 Server returns invalid timezone. Need to set ‘serverTimezone‘ property.

- SQL(1) - Add, delete, modify and search

- 【Kaggle项目实战记录】一个图片分类项目的步骤和思路分享——以树叶分类为例(用Pytorch)

- Lecture 3 Gradient Tutorial Gradient Descent and Stochastic Gradient Descent

- day8字典作业

- ES6 新特性:Class 的继承

猜你喜欢

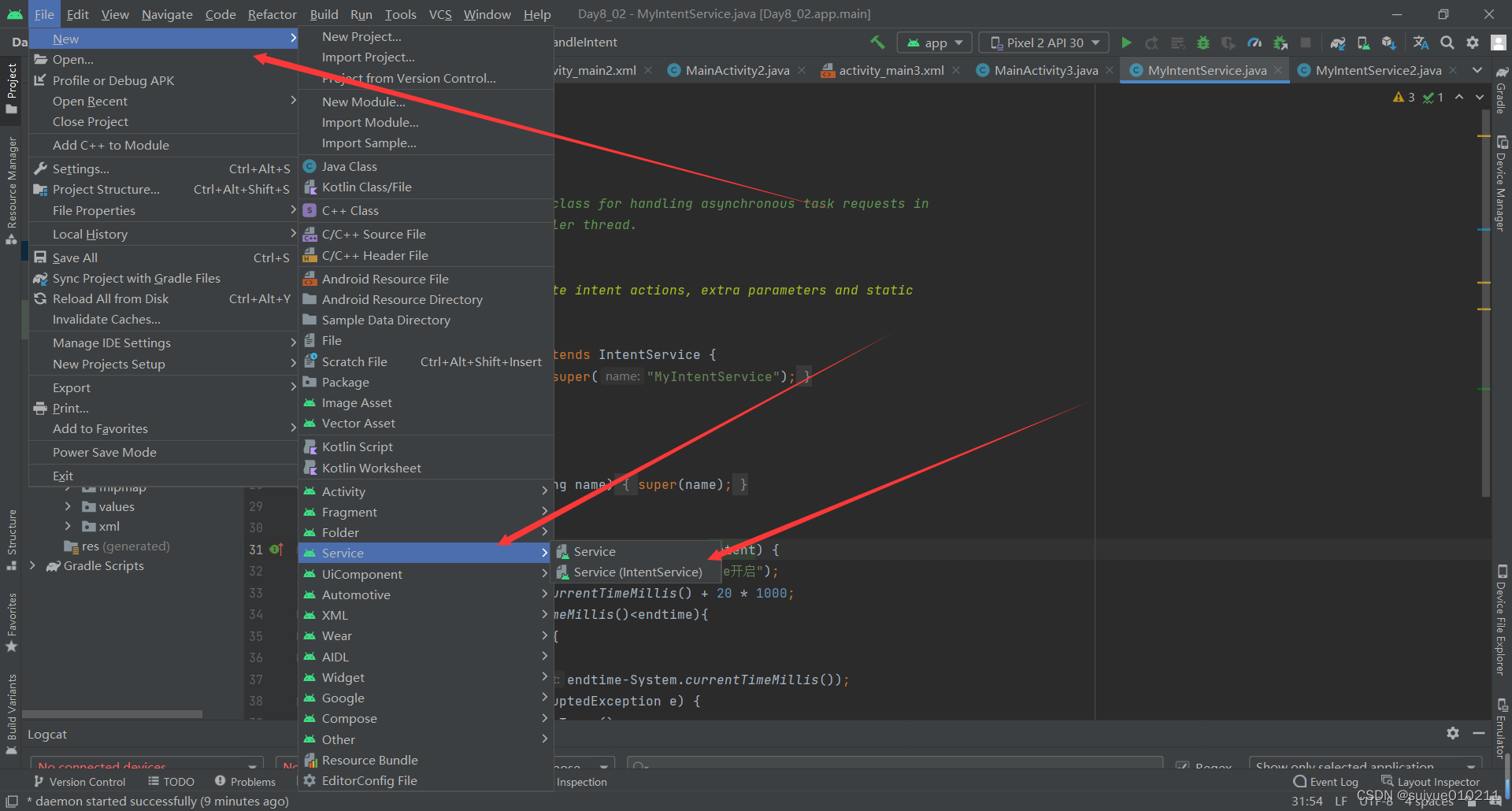

Thread handler handle IntentServvice handlerThread

如何停止flink job

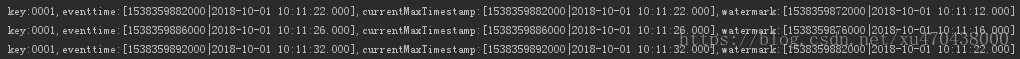

Flink EventTime和Watermarks案例分析

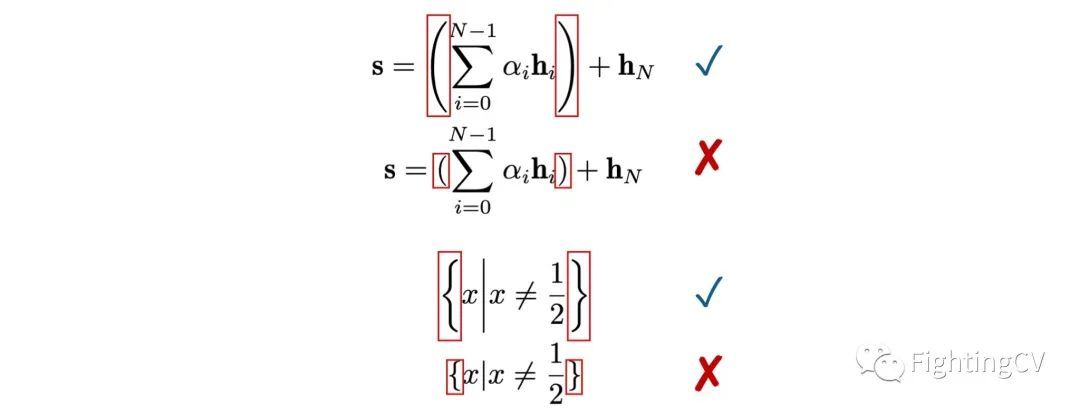

发顶会顶刊论文,你应该这样写作

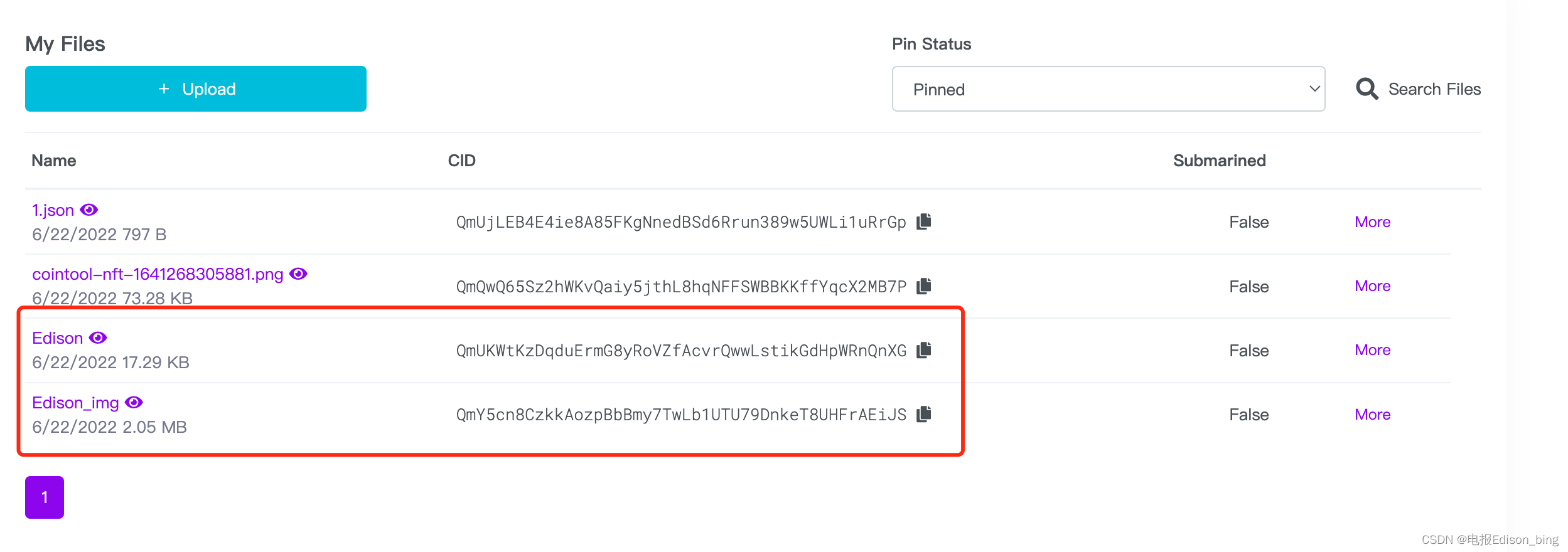

【零基础开发NFT智能合约】如何使用工具自动生成NFT智能合约带白名单可Mint无需写代码

![[Database and SQL study notes] 8. Views in SQL](/img/22/82f91388f06ef4f9986bf1e90800f7.png)

[Database and SQL study notes] 8. Views in SQL

Flink HA配置

原来何恺明提出的MAE还是一种数据增强

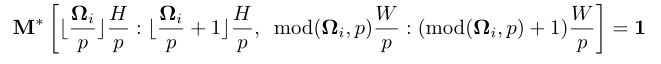

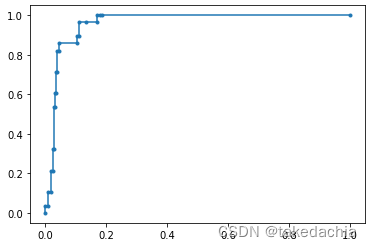

【论文精读】ROC和PR曲线的关系(The relationship between Precision-Recall and ROC curves)

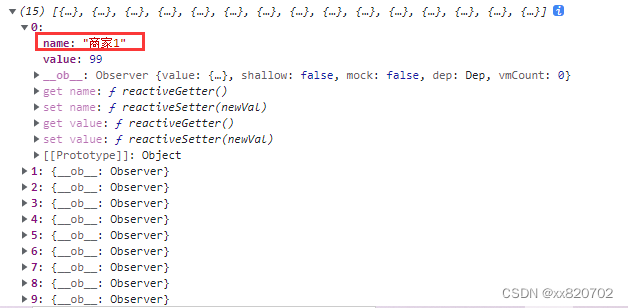

拿出接口数组对象中的所有name值,取出同一个值

随机推荐

flink yarn-session的两种使用方式

vscode要安装的插件

Redux

Map、WeakMap

flink实例开发-batch批处理实例

【Pytorch学习笔记】10.如何快速创建一个自己的Dataset数据集对象(继承Dataset类并重写对应方法)

【Over 16】Looking back at July

day6-列表作业

【Reading】Long-term update

Thread handler句柄 IntentServvice handlerThread

ES6 新特性:Class 的继承

AWS 常用服务

flink基本原理及应用场景分析

服务网格istio 1.12.x安装

Kubernetes常备技能

Lecture 3 Gradient Tutorial Gradient Descent and Stochastic Gradient Descent

【数据库和SQL学习笔记】9.(T-SQL语言)定义变量、高级查询、流程控制(条件、循环等)

[Remember 1] June 29, 2022 Brother and brother double pain

Calling Matlab configuration in pycharm: No module named 'matlab.engine'; 'matlab' is not a package

轻松接入Azure AD+Oauth2 实现 SSO