当前位置:网站首页>redisson bug分析

redisson bug分析

2022-07-06 11:45:00 【InfoQ】

1.背景

- jedis本身是基于阻塞I/O,且其方法调用都是同步的,程序流需要等到socket处理完I/O才能执行,不支持异步,jedis客户端实例不是线程安全的,需要通过连接池来使用jedis。

- redisson使用非阻塞的I/O和基于Netty框架的事件驱动的通信层,其方法调用是异步的。redisson的API是线程安全的,可以操作单个redisson连接来完成各种操作。

2. 问题分析

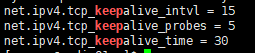

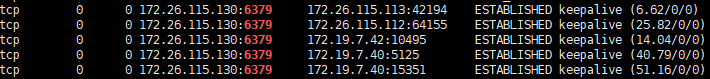

2.1 网络连接

net.ipv4.tcp_keepalive_time=30net.ipv4.tcp_keepalive_probesnet.ipv4.tcp_keepalive_intvlnet.ipv4.tcp_keepalive_intvl=15net.ipv4.tcp_keepalive_probes=5

# Close the connection after a client is idle for N seconds (0 to disable)

timeout 0

# TCP keepalive.

#

# If non-zero, use SO_KEEPALIVE to send TCP ACKs to clients in absence

# of communication. This is useful for two reasons:

#

# 1) Detect dead peers.

# 2) Take the connection alive from the point of view of network

# equipment in the middle.

#

# On Linux, the specified value (in seconds) is the period used to send ACKs.

# Note that to close the connection the double of the time is needed.

# On other kernels the period depends on the kernel configuration.

#

# A reasonable value for this option is 60 seconds.

tcp-keepalive 60

2.2 问题复现

2022-01-24 02:55:39.685 [http-nio-8080-exec-6] ERROR [o.a.c.c.C.[.[.[.[dispatcherServlet]:175] [TID:N/A] - Servlet.service() for servlet [dispatcherServlet] in context with path [/cmccplus] threw exception

org.springframework.dao.InvalidDataAccessApiUsageException: Unexpected exception while processing command; nested exception is org.redisson.client.RedisException: Unexpected exception while processing command

at org.redisson.spring.data.connection.RedissonExceptionConverter.convert(RedissonExceptionConverter.java:52)

at org.redisson.spring.data.connection.RedissonExceptionConverter.convert(RedissonExceptionConverter.java:35)

at org.springframework.data.redis.PassThroughExceptionTranslationStrategy.translate(PassThroughExceptionTranslationStrategy.java:44)

at org.redisson.spring.data.connection.RedissonConnection.transform(RedissonConnection.java:195)

at org.redisson.spring.data.connection.RedissonConnection.syncFuture(RedissonConnection.java:190)

at org.redisson.spring.data.connection.RedissonConnection.sync(RedissonConnection.java:356)

at org.redisson.spring.data.connection.RedissonConnection.write(RedissonConnection.java:722)

at org.redisson.spring.data.connection.RedissonConnection.setEx(RedissonConnection.java:530)

at org.springframework.data.redis.connection.DefaultStringRedisConnection.setEx(DefaultStringRedisConnection.java:1138)

at org.springframework.data.redis.core.DefaultValueOperations$8.potentiallyUsePsetEx(DefaultValueOperations.java:337)

at org.springframework.data.redis.core.DefaultValueOperations$8.doInRedis(DefaultValueOperations.java:330)

at org.springframework.data.redis.core.RedisTemplate.execute(RedisTemplate.java:223)

at org.springframework.data.redis.core.RedisTemplate.execute(RedisTemplate.java:190)

at org.springframework.data.redis.core.AbstractOperations.execute(AbstractOperations.java:97)

at org.springframework.data.redis.core.DefaultValueOperations.set(DefaultValueOperations.java:325)

at com.cmcc.hy.plus.biz.auth.JwtAuthenticationTokenFilter.doFilterInternal(JwtAuthenticationTokenFilter.java:150)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.RequestContextFilter.doFilterInternal(RequestContextFilter.java:100)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.FormContentFilter.doFilterInternal(FormContentFilter.java:93)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.boot.actuate.metrics.web.servlet.WebMvcMetricsFilter.doFilterInternal(WebMvcMetricsFilter.java:96)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.CharacterEncodingFilter.doFilterInternal(CharacterEncodingFilter.java:201)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.apache.catalina.core.StandardWrapperValve.invoke(StandardWrapperValve.java:197)

at org.apache.catalina.core.StandardContextValve.invoke(StandardContextValve.java:97)

at org.apache.catalina.authenticator.AuthenticatorBase.invoke(AuthenticatorBase.java:540)

at org.apache.catalina.core.StandardHostValve.invoke$original$j3CdN2QH(StandardHostValve.java:135)

at org.apache.catalina.core.StandardHostValve.invoke$original$j3CdN2QH$accessor$lXTjUmdl(StandardHostValve.java)

at org.apache.catalina.core.StandardHostValve$auxiliary$mFQ4Aq8A.call(Unknown Source)

at org.apache.skywalking.apm.agent.core.plugin.interceptor.enhance.InstMethodsInter.intercept(InstMethodsInter.java:86)

at org.apache.catalina.core.StandardHostValve.invoke(StandardHostValve.java)

at org.apache.catalina.valves.ErrorReportValve.invoke(ErrorReportValve.java:92)

at org.apache.catalina.core.StandardEngineValve.invoke(StandardEngineValve.java:78)

at org.apache.catalina.connector.CoyoteAdapter.service(CoyoteAdapter.java:357)

at org.apache.coyote.http11.Http11Processor.service(Http11Processor.java:382)

at org.apache.coyote.AbstractProcessorLight.process(AbstractProcessorLight.java:65)

at org.apache.coyote.AbstractProtocol$ConnectionHandler.process(AbstractProtocol.java:895)

at org.apache.tomcat.util.net.NioEndpoint$SocketProcessor.doRun(NioEndpoint.java:1732)

at org.apache.tomcat.util.net.SocketProcessorBase.run(SocketProcessorBase.java:49)

at org.apache.tomcat.util.threads.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1191)

at org.apache.tomcat.util.threads.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:659)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

Caused by: org.redisson.client.RedisException: Unexpected exception while processing command

at org.redisson.command.CommandAsyncService.convertException(CommandAsyncService.java:328)

at org.redisson.command.CommandAsyncService.get(CommandAsyncService.java:128)

at org.redisson.spring.data.connection.RedissonConnection.syncFuture(RedissonConnection.java:188)

... 50 common frames omitted

Caused by: java.lang.NullPointerException: null

at org.redisson.client.handler.CommandEncoder.encode(CommandEncoder.java:130)

at org.redisson.client.handler.CommandEncoder.encode(CommandEncoder.java:99)

at org.redisson.client.handler.CommandEncoder.encode(CommandEncoder.java:55)

at io.netty.handler.codec.MessageToByteEncoder.write(MessageToByteEncoder.java:107)

at org.redisson.client.handler.CommandEncoder.write(CommandEncoder.java:75)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite0(AbstractChannelHandlerContext.java:738)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite(AbstractChannelHandlerContext.java:730)

at io.netty.channel.AbstractChannelHandlerContext.write(AbstractChannelHandlerContext.java:816)

at io.netty.channel.AbstractChannelHandlerContext.write(AbstractChannelHandlerContext.java:723)

at io.netty.handler.codec.MessageToByteEncoder.write(MessageToByteEncoder.java:120)

at org.redisson.client.handler.CommandBatchEncoder.write(CommandBatchEncoder.java:45)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite0(AbstractChannelHandlerContext.java:738)

at io.netty.channel.AbstractChannelHandlerContext.invokeWriteAndFlush(AbstractChannelHandlerContext.java:801)

at io.netty.channel.AbstractChannelHandlerContext.write(AbstractChannelHandlerContext.java:814)

at io.netty.channel.AbstractChannelHandlerContext.writeAndFlush(AbstractChannelHandlerContext.java:794)

at org.redisson.client.handler.CommandsQueue.write(CommandsQueue.java:84)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite0(AbstractChannelHandlerContext.java:738)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite(AbstractChannelHandlerContext.java:730)

at io.netty.channel.AbstractChannelHandlerContext.write(AbstractChannelHandlerContext.java:816)

at io.netty.channel.AbstractChannelHandlerContext.write(AbstractChannelHandlerContext.java:723)

at io.netty.channel.ChannelDuplexHandler.write(ChannelDuplexHandler.java:106)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite0(AbstractChannelHandlerContext.java:738)

at io.netty.channel.AbstractChannelHandlerContext.invokeWrite(AbstractChannelHandlerContext.java:730)

at io.netty.channel.AbstractChannelHandlerContext.access$1900(AbstractChannelHandlerContext.java:38)

at io.netty.channel.AbstractChannelHandlerContext$AbstractWriteTask.write(AbstractChannelHandlerContext.java:1081)

at io.netty.channel.AbstractChannelHandlerContext$WriteAndFlushTask.write(AbstractChannelHandlerContext.java:1128)

at io.netty.channel.AbstractChannelHandlerContext$AbstractWriteTask.run(AbstractChannelHandlerContext.java:1070)

at io.netty.util.concurrent.AbstractEventExecutor.safeExecute(AbstractEventExecutor.java:163)

at io.netty.util.concurrent.SingleThreadEventExecutor.runAllTasks(SingleThreadEventExecutor.java:404)

at io.netty.channel.nio.NioEventLoop.run(NioEventLoop.java:446)

at io.netty.util.concurrent.SingleThreadEventExecutor$5.run(SingleThreadEventExecutor.java:884)

at io.netty.util.concurrent.FastThreadLocalRunnable.run(FastThreadLocalRunnable.java:30)

... 1 common frames omitted

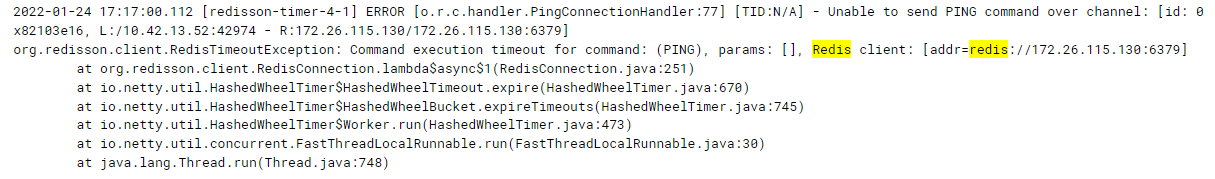

[redisson-timer-4-1] ERROR [o.r.c.handler.PingConnectionHandler:77] [TID: N/A] - Unable to send PING command over channel: [id: 0x3564ed6a, L:/2.0.4.28:61450 - R:172.21.41.10/172.21.41.10:6379]

org.redisson.client.RedisTimeoutException: Command execution timeout for command: (PING), params: [], Redis client: [addr=redis://172.21.41.10:6379]

at org.redisson.client.RedisConnection.lambda$async$1(RedisConnection.java:251)

at io.netty.util.HashedWheelTimer$HashedWheelTimeout.expire(HashedWheelTimer.java:670)

at io.netty.util.HashedWheelTimer$HashedWheelBucket.expireTimeouts(HashedWheelTimer.java:745)

at io.netty.util.HashedWheelTimer$Worker.run(HashedWheelTimer.java:473)

at io.netty.util.concurrent.FastThreadLocalRunnable.run(FastThreadLocalRunnable.java:30)

at java.lang.Thread.run(Thread.java:748)

private void sendPing(ChannelHandlerContext ctx) {

RedisConnection connection = RedisConnection.getFrom(ctx.channel());

RFuture<String> future;

if (connection.getUsage() == 0) {

future = connection.async(StringCodec.INSTANCE, RedisCommands.PING);

} else {

future = null;

}

config.getTimer().newTimeout(timeout -> {

if (connection.isClosed() || ctx.isRemoved()) {

return;

}

if (connection.getUsage() == 0

&& future != null

&& (future.cancel(false) || !future.isSuccess())) {

ctx.channel().close();

if (future.cause() != null && !future.isCancelled()) {

log.error("Unable to send PING command over channel: " + ctx.channel(), future.cause());

}

log.debug("channel: {} closed due to PING response timeout set in {} ms", ctx.channel(), config.getPingConnectionInterval());

} else {

sendPing(ctx);

}

}, config.getPingConnectionInterval(), TimeUnit.MILLISECONDS);

public void channelInactive(ChannelHandlerContext ctx) throws Exception {

RedisConnection connection = RedisConnection.getFrom(ctx.channel());

if (connection != null) {

connection.fireDisconnected();

if (!connection.isClosed()) {

if (connection.isFastReconnect()) {

tryReconnect(connection, 1);

} else {

reconnect(connection, 1);

}

}

}

ctx.fireChannelInactive();

}

2.3 源码分析

<T> T write(byte[] key, Codec codec, RedisCommand<?> command, Object... params) {

RFuture<T> f = executorService.writeAsync(key, codec, command, params);

indexCommand(command);

return sync(f);

}

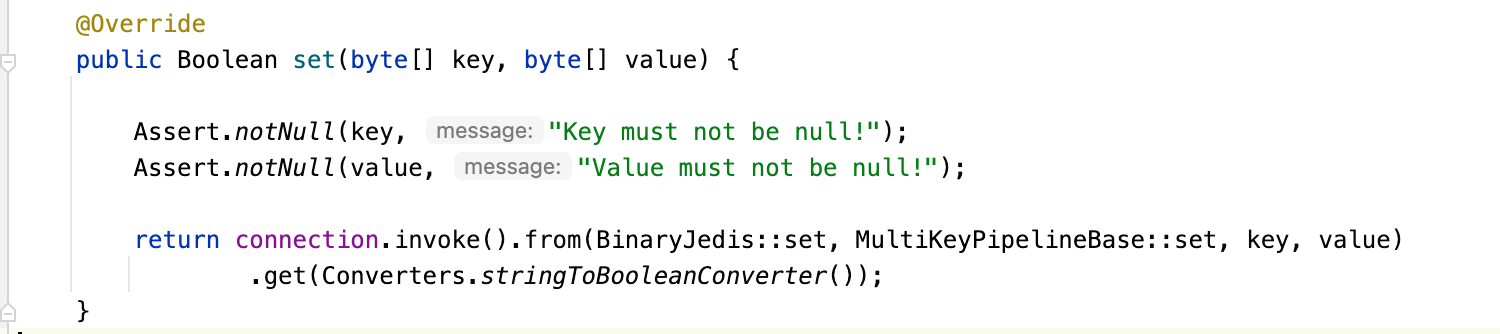

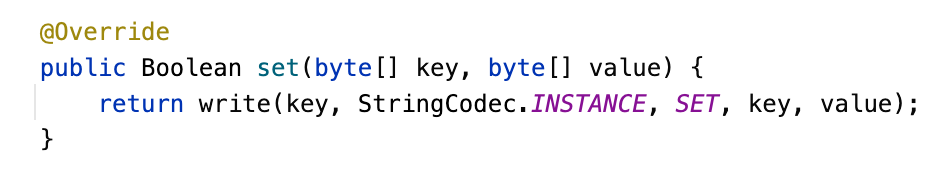

executorService.writeAsyncsyncRedisCommandparamswriteAsyncCommandEncoderCommandEncoderMessageToByteEncoder @Override

protected void encode(ChannelHandlerContext ctx, CommandData<?, ?> msg, ByteBuf out) throws Exception {

try {

out.writeByte(ARGS_PREFIX);

int len = 1 + msg.getParams().length;

if (msg.getCommand().getSubName() != null) {

len++;

}

out.writeCharSequence(Long.toString(len), CharsetUtil.US_ASCII);

out.writeBytes(CRLF);

writeArgument(out, msg.getCommand().getName().getBytes(CharsetUtil.UTF_8));

if (msg.getCommand().getSubName() != null) {

writeArgument(out, msg.getCommand().getSubName().getBytes(CharsetUtil.UTF_8));

}

for (Object param : msg.getParams()) {

ByteBuf buf = encode(param);

writeArgument(out, buf);

if (!(param instanceof ByteBuf)) {

buf.release();

}

}

if (log.isTraceEnabled()) {

String info = out.toString(CharsetUtil.UTF_8);

if (RedisCommands.AUTH.equals(msg.getCommand())) {

info = info.substring(0, info.indexOf(RedisCommands.AUTH.getName()) + RedisCommands.AUTH.getName().length()) + "(password masked)";

}

log.trace("channel: {} message: {}", ctx.channel(), info);

}

} catch (Exception e) {

msg.tryFailure(e);

throw e;

}

}

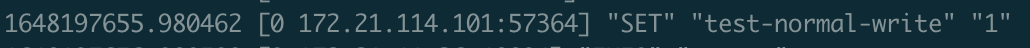

encodemsg.tryFailure try {

stringRedisTemplate.opsForValue().set("test-null", null);

} catch (Exception e) {

log.error("write null", e);

}

try {

stringRedisTemplate.opsForValue().set("test-normal-write", "1");

} catch (Exception e) {

log.error("write normal", e);

}

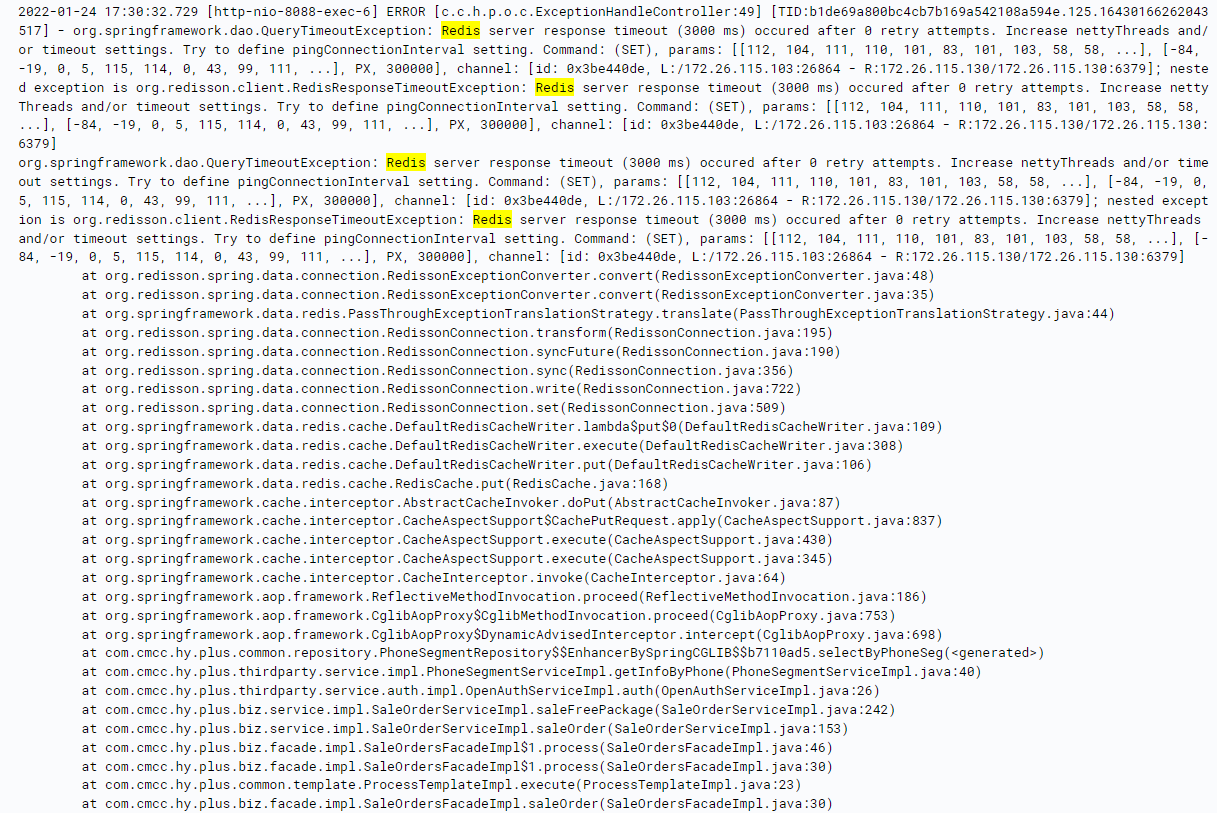

org.springframework.dao.QueryTimeoutException: Redis server response timeout (3000 ms) occured after 0 retry attempts. Increase nettyThreads and/or timeout settings. Try to define pingConnectionInterval setting. Command: (SET), params: [[116, 101, 115, 116, 45, 110, 111, 114, 109, 97, ...], [49]], channel: [id: 0x5fc67cb9, L:/2.0.4.190:55103 - R:172.21.41.10/172.21.41.10:6379]; nested exception is org.redisson.client.RedisResponseTimeoutException: Redis server response timeout (3000 ms) occured after 0 retry attempts. Increase nettyThreads and/or timeout settings. Try to define pingConnectionInterval setting. Command: (SET), params: [[116, 101, 115, 116, 45, 110, 111, 114, 109, 97, ...], [49]], channel: [id: 0x5fc67cb9, L:/2.0.4.190:55103 - R:172.21.41.10/172.21.41.10:6379]

at org.redisson.spring.data.connection.RedissonExceptionConverter.convert(RedissonExceptionConverter.java:48)

at org.redisson.spring.data.connection.RedissonExceptionConverter.convert(RedissonExceptionConverter.java:35)

at org.springframework.data.redis.PassThroughExceptionTranslationStrategy.translate(PassThroughExceptionTranslationStrategy.java:44)

at org.redisson.spring.data.connection.RedissonConnection.transform(RedissonConnection.java:195)

at org.redisson.spring.data.connection.RedissonConnection.syncFuture(RedissonConnection.java:190)

at org.redisson.spring.data.connection.RedissonConnection.sync(RedissonConnection.java:356)

at org.redisson.spring.data.connection.RedissonConnection.write(RedissonConnection.java:722)

at org.redisson.spring.data.connection.RedissonConnection.set(RedissonConnection.java:490)

at org.springframework.data.redis.connection.DefaultStringRedisConnection.set(DefaultStringRedisConnection.java:1102)

at org.springframework.data.redis.core.DefaultValueOperations$7.inRedis(DefaultValueOperations.java:309)

at org.springframework.data.redis.core.AbstractOperations$ValueDeserializingRedisCallback.doInRedis(AbstractOperations.java:61)

at org.springframework.data.redis.core.RedisTemplate.execute(RedisTemplate.java:223)

at org.springframework.data.redis.core.RedisTemplate.execute(RedisTemplate.java:190)

at org.springframework.data.redis.core.AbstractOperations.execute(AbstractOperations.java:97)

at org.springframework.data.redis.core.DefaultValueOperations.set(DefaultValueOperations.java:305)

at com.cmcc.hy.plus.job.controller.TestController.redis(TestController.java:47)

at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:62)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:43)

at java.lang.reflect.Method.invoke(Method.java:498)

at org.springframework.web.method.support.InvocableHandlerMethod.doInvoke(InvocableHandlerMethod.java:205)

at org.springframework.web.method.support.InvocableHandlerMethod.invokeForRequest(InvocableHandlerMethod.java:150)

at org.springframework.web.servlet.mvc.method.annotation.ServletInvocableHandlerMethod.invokeAndHandle(ServletInvocableHandlerMethod.java:117)

at org.springframework.web.servlet.mvc.method.annotation.RequestMappingHandlerAdapter.invokeHandlerMethod(RequestMappingHandlerAdapter.java:895)

at org.springframework.web.servlet.mvc.method.annotation.RequestMappingHandlerAdapter.handleInternal(RequestMappingHandlerAdapter.java:808)

at org.springframework.web.servlet.mvc.method.AbstractHandlerMethodAdapter.handle(AbstractHandlerMethodAdapter.java:87)

at org.springframework.web.servlet.DispatcherServlet.doDispatch(DispatcherServlet.java:1067)

at org.springframework.web.servlet.DispatcherServlet.doService(DispatcherServlet.java:963)

at org.springframework.web.servlet.FrameworkServlet.processRequest(FrameworkServlet.java:1006)

at org.springframework.web.servlet.FrameworkServlet.doPost(FrameworkServlet.java:909)

at javax.servlet.http.HttpServlet.service(HttpServlet.java:681)

at org.springframework.web.servlet.FrameworkServlet.service(FrameworkServlet.java:883)

at javax.servlet.http.HttpServlet.service(HttpServlet.java:764)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:227)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.apache.tomcat.websocket.server.WsFilter.doFilter(WsFilter.java:53)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at com.cmcc.hy.plus.common.filter.LoggingFilter.doFilterInternal(LoggingFilter.java:243)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.RequestContextFilter.doFilterInternal(RequestContextFilter.java:100)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.FormContentFilter.doFilterInternal(FormContentFilter.java:93)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.boot.actuate.metrics.web.servlet.WebMvcMetricsFilter.doFilterInternal(WebMvcMetricsFilter.java:96)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.springframework.web.filter.CharacterEncodingFilter.doFilterInternal(CharacterEncodingFilter.java:201)

at org.springframework.web.filter.OncePerRequestFilter.doFilter(OncePerRequestFilter.java:117)

at org.apache.catalina.core.ApplicationFilterChain.internalDoFilter(ApplicationFilterChain.java:189)

at org.apache.catalina.core.ApplicationFilterChain.doFilter(ApplicationFilterChain.java:162)

at org.apache.catalina.core.StandardWrapperValve.invoke(StandardWrapperValve.java:197)

at org.apache.catalina.core.StandardContextValve.invoke(StandardContextValve.java:97)

at org.apache.catalina.authenticator.AuthenticatorBase.invoke(AuthenticatorBase.java:540)

at org.apache.catalina.core.StandardHostValve.invoke(StandardHostValve.java:135)

at org.apache.catalina.valves.ErrorReportValve.invoke(ErrorReportValve.java:92)

at org.apache.catalina.core.StandardEngineValve.invoke(StandardEngineValve.java:78)

at org.apache.catalina.connector.CoyoteAdapter.service(CoyoteAdapter.java:357)

at org.apache.coyote.http11.Http11Processor.service(Http11Processor.java:382)

at org.apache.coyote.AbstractProcessorLight.process(AbstractProcessorLight.java:65)

at org.apache.coyote.AbstractProtocol$ConnectionHandler.process(AbstractProtocol.java:895)

at org.apache.tomcat.util.net.NioEndpoint$SocketProcessor.doRun(NioEndpoint.java:1732)

at org.apache.tomcat.util.net.SocketProcessorBase.run(SocketProcessorBase.java:49)

at org.apache.tomcat.util.threads.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1191)

at org.apache.tomcat.util.threads.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:659)

at org.apache.tomcat.util.threads.TaskThread$WrappingRunnable.run(TaskThread.java:61)

at java.lang.Thread.run(Thread.java:748)

Caused by: org.redisson.client.RedisResponseTimeoutException: Redis server response timeout (3000 ms) occured after 0 retry attempts. Increase nettyThreads and/or timeout settings. Try to define pingConnectionInterval setting. Command: (SET), params: [[116, 101, 115, 116, 45, 110, 111, 114, 109, 97, ...], [49]], channel: [id: 0x5fc67cb9, L:/2.0.4.190:55103 - R:172.21.41.10/172.21.41.10:6379]

at org.redisson.command.RedisExecutor.lambda$scheduleResponseTimeout$5(RedisExecutor.java:341)

at io.netty.util.HashedWheelTimer$HashedWheelTimeout.expire(HashedWheelTimer.java:670)

at io.netty.util.HashedWheelTimer$HashedWheelBucket.expireTimeouts(HashedWheelTimer.java:745)

at io.netty.util.HashedWheelTimer$Worker.run(HashedWheelTimer.java:473)

at io.netty.util.concurrent.FastThreadLocalRunnable.run(FastThreadLocalRunnable.java:30)

... 1 common frames omitted

org.redisson.command.RedisExecutor#scheduleResponseTimeout TimerTask timeoutResponseTask = timeout -> {

if (isResendAllowed(attempt, attempts)) {

if (!attemptPromise.cancel(false)) {

return;

}

connectionManager.newTimeout(t -> {

attempt++;

if (log.isDebugEnabled()) {

log.debug("attempt {} for command {} and params {}",

attempt, command, LogHelper.toString(params));

}

mainPromiseListener = null;

execute();

}, retryInterval, TimeUnit.MILLISECONDS);

return;

}

attemptPromise.tryFailure(

new RedisResponseTimeoutException("Redis server response timeout (" + timeoutAmount + " ms) occured"

+ " after " + attempt + " retry attempts. Increase nettyThreads and/or timeout settings. Try to define pingConnectionInterval setting. Command: "

+ LogHelper.toString(command, params) + ", channel: " + connection.getChannel()));

};

timeout = connectionManager.newTimeout(timeoutResponseTask, timeoutTime, TimeUnit.MILLISECONDS);

scheduleResponseTimeoutorg.redisson.command.RedisExecutor#checkWriteFuturecheckWriteFuture connectionFuture.onComplete((connection, e) -> {

if (connectionFuture.isCancelled()) {

connectionManager.getShutdownLatch().release();

return;

}

if (!connectionFuture.isSuccess()) {

connectionManager.getShutdownLatch().release();

exception = convertException(connectionFuture);

return;

}

sendCommand(attemptPromise, connection);

writeFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(ChannelFuture future) throws Exception {

checkWriteFuture(writeFuture, attemptPromise, connection);

}

});

});

writeFuturecheckWriteFuturescheduleResponseTimeout

CommandEncoderorg.redisson.client.handler.RedisChannelInitializer#initChannel @Override

protected void initChannel(Channel ch) throws Exception {

initSsl(config, ch);

if (type == Type.PLAIN) {

ch.pipeline().addLast(new RedisConnectionHandler(redisClient));

} else {

ch.pipeline().addLast(new RedisPubSubConnectionHandler(redisClient));

}

ch.pipeline().addLast(

connectionWatchdog,

CommandEncoder.INSTANCE,

CommandBatchEncoder.INSTANCE);

if (type == Type.PLAIN) {

ch.pipeline().addLast(new CommandsQueue());

} else {

ch.pipeline().addLast(new CommandsQueuePubSub());

}

if (pingConnectionHandler != null) {

ch.pipeline().addLast(pingConnectionHandler);

}

if (type == Type.PLAIN) {

ch.pipeline().addLast(new CommandDecoder(config.getAddress().getScheme()));

} else {

ch.pipeline().addLast(new CommandPubSubDecoder(config));

}

ch.pipeline().addLast(new ErrorsLoggingHandler());

config.getNettyHook().afterChannelInitialization(ch);

}

pingConnectionHandlerCommandEncoderconnectionWatchdogErrorsLoggingHandler -> CommandsQueue -> CommandBatchEncoder -> CommandEncoder

RedisConnectionHandler -> ConnectionWatchdog -> PingConnectionHandler -> CommandDecoder -> ErrorsLoggingHandler

CommandEncoderCommandDecoderCommandDecoder protected QueueCommand getCommand(ChannelHandlerContext ctx) {

Queue<QueueCommandHolder> queue = ctx.channel().attr(CommandsQueue.COMMANDS_QUEUE).get();

QueueCommandHolder holder = queue.peek();

if (holder != null) {

return holder.getCommand();

}

return null;

}

QueueCommandHolderCommandsQueue @Override

public void write(ChannelHandlerContext ctx, Object msg, ChannelPromise promise) throws Exception {

if (msg instanceof QueueCommand) {

QueueCommand data = (QueueCommand) msg;

QueueCommandHolder holder = new QueueCommandHolder(data, promise);

Queue<QueueCommandHolder> queue = ctx.channel().attr(COMMANDS_QUEUE).get();

while (true) {

if (lock.compareAndSet(false, true)) {

try {

queue.add(holder);

ctx.writeAndFlush(data, holder.getChannelPromise());

} finally {

lock.set(false);

}

break;

}

}

} else {

super.write(ctx, msg, promise);

}

}

protected void sendNext(Channel channel) {

Queue<QueueCommandHolder> queue = channel.attr(CommandsQueue.COMMANDS_QUEUE).get();

queue.poll();

state(null);

}

CommandEncodeCommandDecoderCommandsQueueCommandEncoderQueueCommandPinConnectionHandlerConnectionWatchDog- 和jedis一样,在set等操作开始前进行前置的判空校验;

- 在

CommandEncoder的encode抛出异常时,使用final语句将queue中的QueueCommandHolder推出。

3.总结

边栏推荐

- Learning and Exploration - function anti shake

- 【计算情与思】扫地僧、打字员、信息恐慌与奥本海默

- Leetcode 30. 串联所有单词的子串

- LeetCode_格雷编码_中等_89.格雷编码

- Lick the dog until the last one has nothing (simple DP)

- Use of deg2rad and rad2deg functions in MATLAB

- 关于图像的读取及处理等

- zabbix 代理服务器 与 zabbix-snmp 监控

- 学习探索-函数防抖

- MySQL information Schema Learning (i) - - General table

猜你喜欢

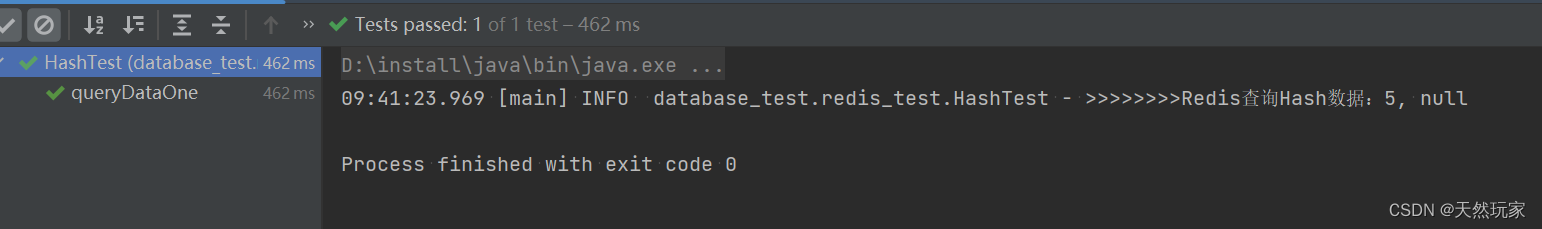

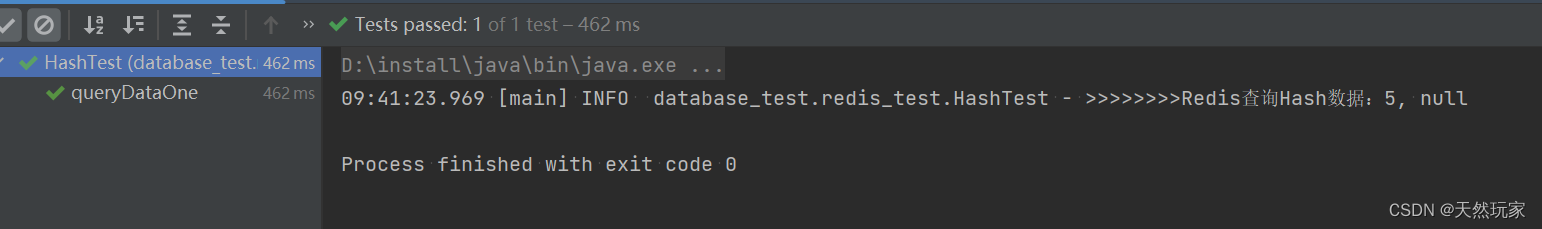

Systematic and detailed explanation of redis operation hash type data (with source code analysis and test results)

Chic Lang: attributeerror: partially initialized module 'CV2' has no attribute 'GAPI_ wip_ gst_ GStreamerPipe

反射及在运用过程中出现的IllegalAccessException异常

10 schemes to ensure interface data security

学习打卡web

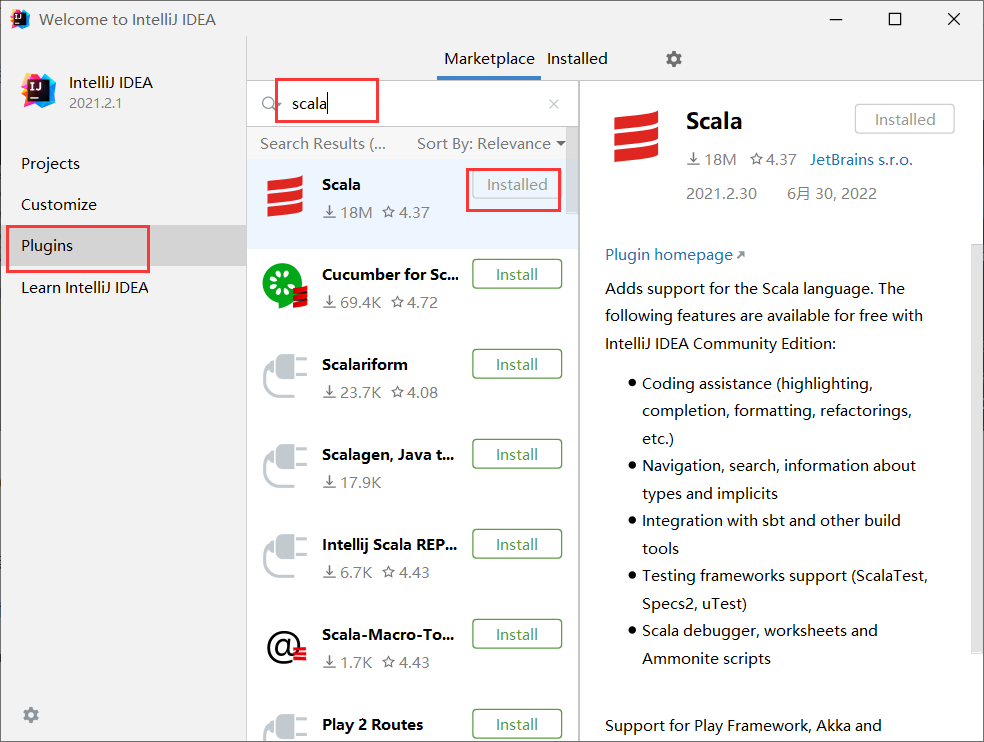

Spark foundation -scala

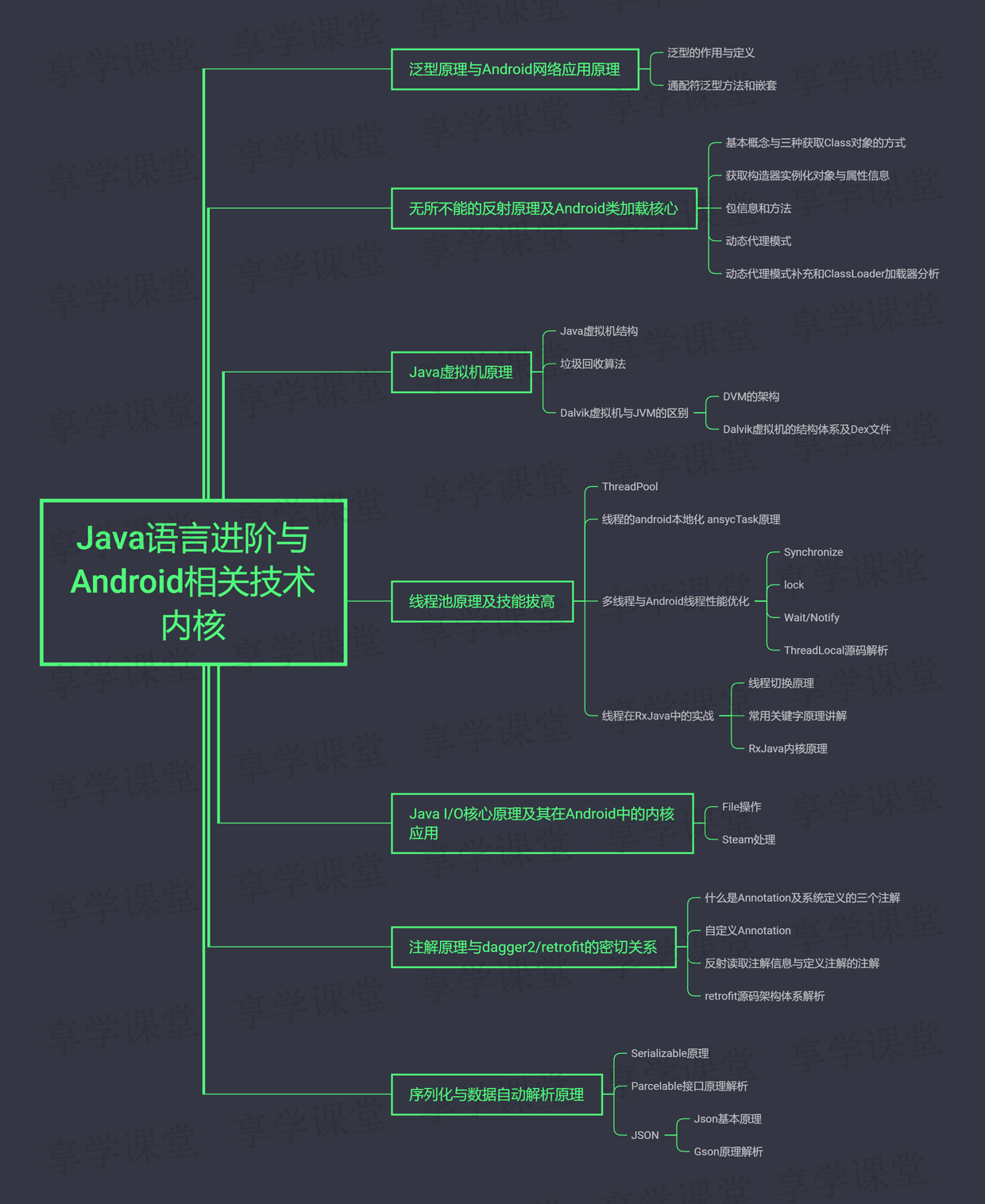

深入浅出,面试突击版

系统性详解Redis操作Hash类型数据(带源码分析及测试结果)

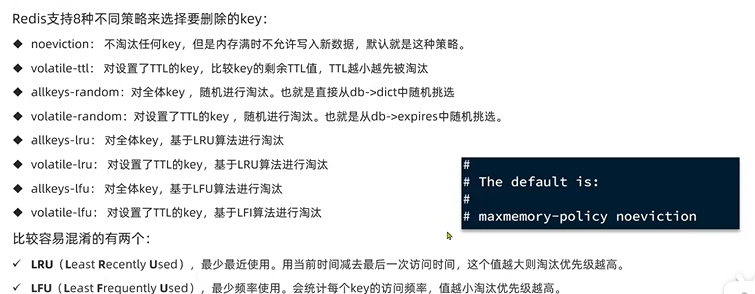

黑馬--Redis篇

冒烟测试怎么做

随机推荐

Mathematical knowledge -- code implementation of Gaussian elimination (elementary line transformation to solve equations)

Looting iii[post sequence traversal and backtracking + dynamic planning]

About image reading and processing, etc

Sanmian ant financial successfully got the offer, and has experience in Android development agency recruitment and interview

[玩转Linux] [Docker] MySQL安装和配置

Tensorflow2.0 self defined training method to solve function coefficients

Application of clock wheel in RPC

Druid 数据库连接池 详解

Dom 操作

Yyds dry goods inventory leetcode question set 751 - 760

学习探索-函数防抖

黑馬--Redis篇

Computer network: sorting out common network interview questions (I)

Mysql Information Schema 學習(一)--通用錶

[translation] micro survey of cloud native observation ability. Prometheus leads the trend, but there are still obstacles to understanding the health of the system

Understand yolov1 Part II non maximum suppression (NMS) in prediction stage

Vmware虚拟机无法打开内核设备“\\.\Global\vmx86“的解决方法

MATLAB中deg2rad和rad2deg函数的使用

Carte de réflexion + code source + notes + projet, saut d'octets + jd + 360 + tri des questions d'entrevue Netease

1805. Number of different integers in the string