当前位置:网站首页>spark调优(三):持久化减少二次查询

spark调优(三):持久化减少二次查询

2022-07-07 14:13:00 【InfoQ】

1. 起因

2. 优化开始

df = sc.sql(sql)

df1 = df.persist()

df1.createOrReplaceTempView(temp_table_name)

subdf = sc.sql(select * from temp_table_name)

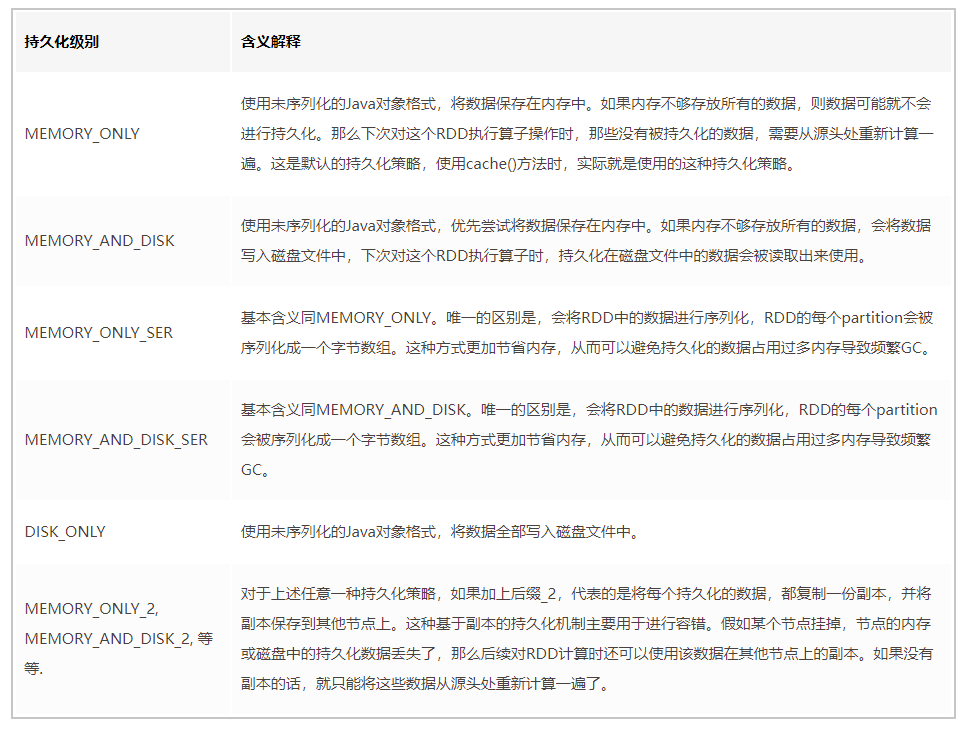

- 默认情况下,性能最高的当然是MEMORY_ONLY,但前提是你的内存必须足够足够大,可以绰绰有余地存放下整个RDD的所有数据。因为不进行序列化与反序列化操作,就避免了这部分的性能开销;对这个RDD的后续算子操作,都是基于纯内存中的数据的操作,不需要从磁盘文件中读取数据,性能也很高;而且不需要复制一份数据副本,并远程传送到其他节点上。但是这里必须要注意的是,在实际的生产环境中,恐怕能够直接用这种策略的场景还是有限的,如果RDD中数据比较多时(比如几十亿),直接用这种持久化级别,会导致JVM的OOM内存溢出异常。

- 如果使用MEMORY_ONLY级别时发生了内存溢出,那么建议尝试使用MEMORY_ONLY_SER级别。该级别会将RDD数据序列化后再保存在内存中,此时每个partition仅仅是一个字节数组而已,大大减少了对象数量,并降低了内存占用。这种级别比MEMORY_ONLY多出来的性能开销,主要就是序列化与反序列化的开销。但是后续算子可以基于纯内存进行操作,因此性能总体还是比较高的。此外,可能发生的问题同上,如果RDD中的数据量过多的话,还是可能会导致OOM内存溢出的异常。

- 如果纯内存的级别都无法使用,那么建议使用MEMORY_AND_DISK_SER策略,而不是MEMORY_AND_DISK策略。因为既然到了这一步,就说明RDD的数据量很大,内存无法完全放下。序列化后的数据比较少,可以节省内存和磁盘的空间开销。同时该策略会优先尽量尝试将数据缓存在内存中,内存缓存不下才会写入磁盘。

- 通常不建议使用DISK_ONLY和后缀为_2的级别:因为完全基于磁盘文件进行数据的读写,会导致性能急剧降低,有时还不如重新计算一次所有RDD。后缀为_2的级别,必须将所有数据都复制一份副本,并发送到其他节点上,数据复制以及网络传输会导致较大的性能开销,除非是要求作业的高可用性,否则不建议使用。

结束语

边栏推荐

- Shandong old age Expo, 2022 China smart elderly care exhibition, smart elderly care and aging technology exhibition

- MySQL中, 如何查询某一天, 某一月, 某一年的数据

- Lecturer solicitation order | Apache seatunnel (cultivating) meetup sharing guests are in hot Recruitment!

- Shader_ Animation sequence frame

- [excelexport], Excel to Lua, JSON, XML development tool

- 通知Notification使用全解析

- laravel中将session由文件保存改为数据库保存

- 2022第四届中国(济南)国际智慧养老产业展览会,山东老博会

- JS modularization

- 2022山东智慧养老展,适老穿戴设备展,养老展,山东老博会

猜你喜欢

企业级日志分析系统ELK

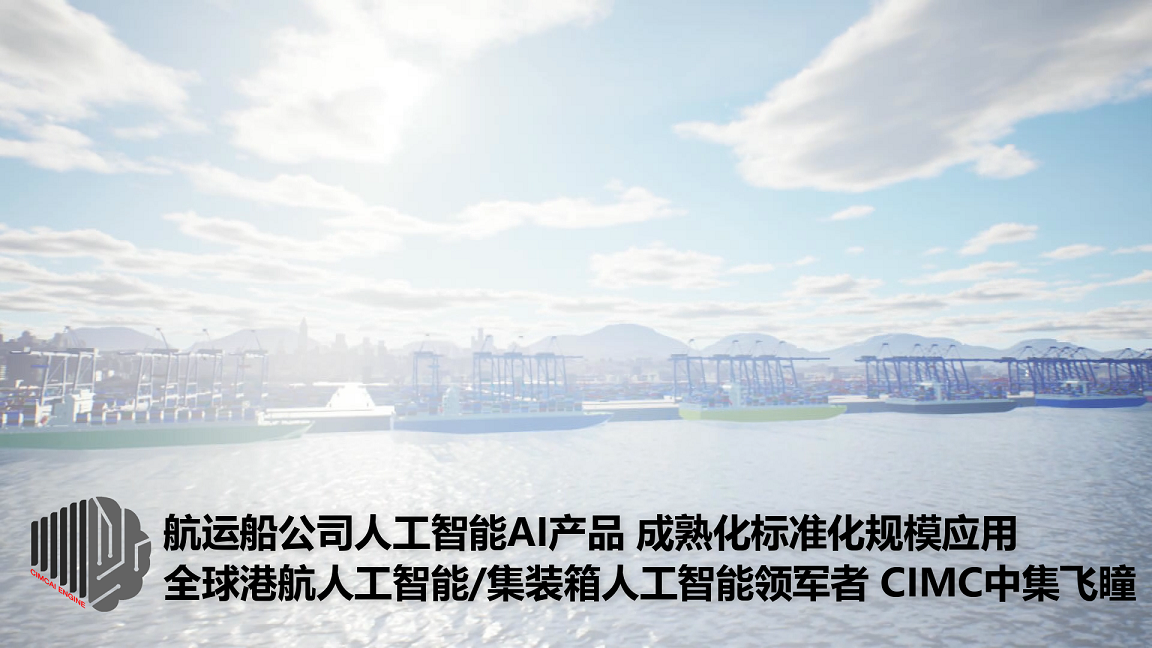

Shipping companies' AI products are mature, standardized and applied on a large scale. CIMC, the global leader in port and shipping AI / container AI, has built a benchmark for international shipping

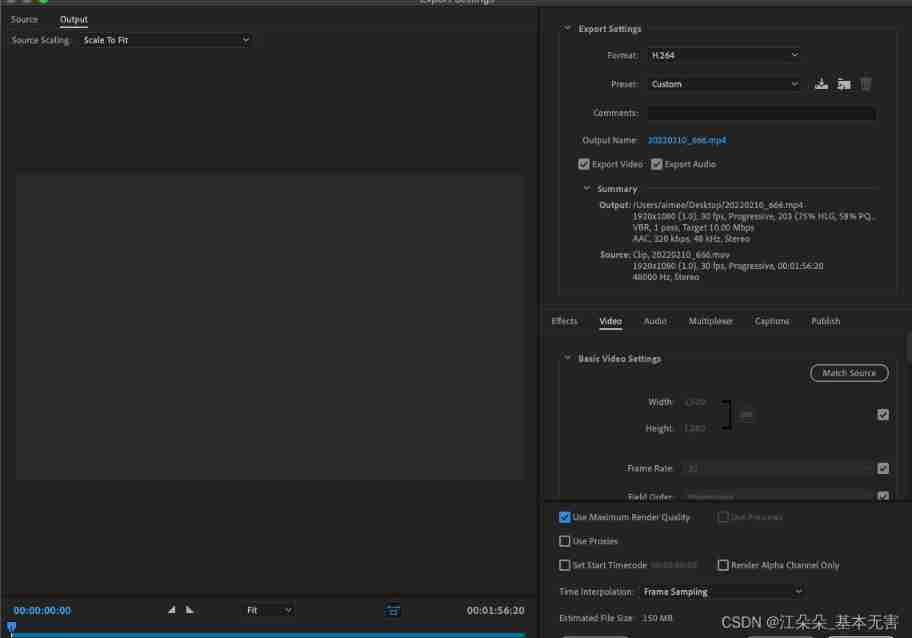

AE learning 01: AE complete project summary

2022第四届中国(济南)国际智慧养老产业展览会,山东老博会

Apache Doris刚“毕业”:为什么应关注这种SQL数据仓库?

SPI master rx time out中断

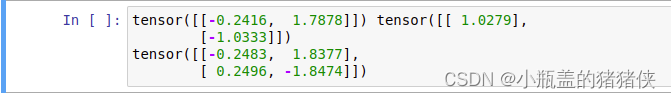

Multiplication in pytorch: mul (), multiply (), matmul (), mm (), MV (), dot ()

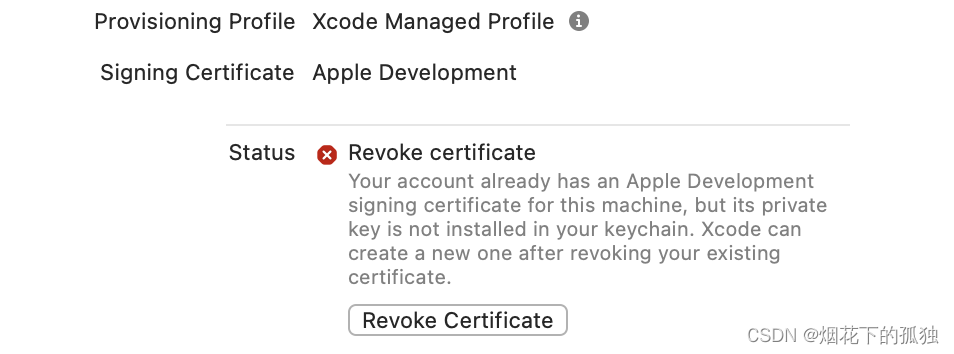

Xcode Revoke certificate

Enterprise log analysis system elk

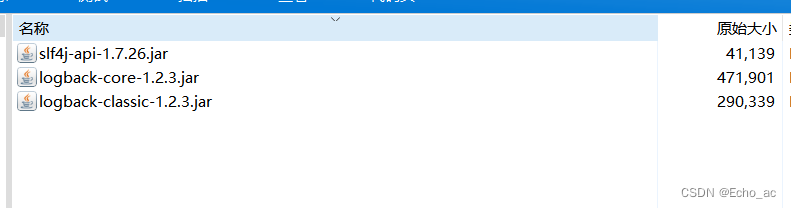

Logback日志框架第三方jar包 免费获取

随机推荐

Mysql database basic operation DQL basic query

laravel post提交数据时显示异常

【花雕体验】15 尝试搭建Beetle ESP32 C3之Arduino开发环境

leetcode 241. Different ways to add parentheses design priority for operational expressions (medium)

企业级日志分析系统ELK

What is the difference between IP address and physical address

Laravel5.1 路由 -路由分组

Laravel 服务提供者实例教程 —— 创建 Service Provider 测试实例

You Yuxi, coming!

星瑞格数据库入围“2021年度福建省信息技术应用创新典型解决方案”

TCP framework___ Unity

[flower carving experience] 15 try to build the Arduino development environment of beetle esp32 C3

通知Notification使用全解析

一个普通人除了去工厂上班赚钱,还能干什么工作?

山东老博会,2022中国智慧养老展会,智能化养老、适老科技展

prometheus api删除某个指定job的所有数据

Use moviepy Editor clips videos and intercepts video clips in batches

招标公告:福建省农村信用社联合社数据库审计系统采购项目(重新招标)

asyncio 概念和用法

A link opens the applet code. After compilation, it is easy to understand