当前位置:网站首页>GFS Distributed File System

GFS Distributed File System

2022-07-05 23:35:00 【Les oranges sont délicieuses.】

Catalogue des articles

- Un.、GlusterFSIntroduction

- 2.、GlusterFSType de volume pour

- Trois、DéploiementGlusterFSCluster

- Préparation de l'expérience

- 1、Changer le nom du noeud

- 2、Le noeud monte le disque,Installer une source locale

- 3、Ajouter un noeud pour créer un Cluster

- 4、Créer un volume distribué

- 5、Créer un volume de bande

- 6、Créer un volume de réplication

- 7、Créer un volume de bande distribué

- 8、DéploiementglusterClient

- 9、Voir la distribution des fichiers

- 1、Voir la distribution des fichiers

- 2、Essais destructifs

- Quatre、Autres commandes de maintenance

Un.、GlusterFSIntroduction

- GFS.Est un système de fichiers distribués extensible

- Par le serveur de stockage、Client etNFS/SambaPasserelle de stockage(Facultatif,Choisissez d'utiliser au besoin)Composition.

- Aucun composant de serveur de métadonnées,Cela contribue à améliorer les performances de l'ensemble du système、Fiabilité et stabilité.

MFS

Les systèmes de fichiers distribués traditionnels utilisent principalement des métaserveurs pour stocker des métadonnées,Les métadonnées contiennent des informations de répertoire sur le noeud de stockage、Structure du Répertoire, etc.Une telle conception est très efficace dans la navigation des répertoires,Mais il y a aussi des défauts,Par exemple, un seul point de défaillance.En cas de défaillance du serveur de métadonnées,Même si les noeuds sont redondants,Tout le système de stockage va s'écraser.Et GlusterFSLe système de fichiers distribués est basé sur une conception sans métaserveur,Forte extensibilité horizontale des données,Haute fiabilité et efficacité de stockage.

GclusterFsEn même temps,Scale-out(Extensions horizontales)Solutions de stockageGlusterAu cœur de,Forte capacité d'échelle horizontale pour le stockage des données,Nombre supportable par extensionPBCapacité de stockage et traitement de milliers de clients.

GlusterFSSupport avecTCP/IPOuInfiniBandRDMARéseau(Une technologie qui supporte les liaisons simultanées multiples,Avec une large bande passante、Faible délai、Caractéristiques de haute extensibilité)Rassembler des ressources de stockage physiquement dispersées,Services de stockage unifiés,Et utiliser un espace de noms global unifié pour gérer les données.

1 、GlusterFsCaractéristiques

Extensibilité et haute performance

GlusterFsTirer parti de la double fonctionnalité pour fournir des solutions de stockage de grande capacité.

(1)Scale-OutL'architecture permet d'améliorer la capacité de stockage et les performances en augmentant simplement les noeuds de stockage(Disque、Calcul etI/oLes ressources peuvent être augmentées indépendamment),Soutien10GbEEtInfiniBandEt l'interconnexion des réseaux à grande vitesse.

(2)ClusterUn hachage élastique(ElasticHash)C'est réglé.GlusterFSDépendance vis - à - vis du serveur de métadonnées,Amélioration des points de défaillance uniques et des goulets d'étranglement de performance,L'accès parallèle aux données est réellement réalisé.GlusterFSL'algorithme de hachage élastique peut être utilisé pour localiser intelligemment n'importe quel fragment de données dans le pool de stockage(Stocker les données fragmentées sur différents noeuds),Il n'est pas nécessaire de consulter l'index ou de demander au serveur de métadonnées.Disponibilité élevée

GlusterFSLes fichiers peuvent être copiés automatiquement,Comme un miroir ou une copie multiple,Pour s'assurer que les données sont toujours accessibles,Accès normal même en cas de panne matérielle.

Lorsque les données sont incohérentes,La fonction d'auto - guérison restaure les données dans le bon état,La réparation des données est effectuée progressivement en arrière - plan,Il y a peu de charge de performance.

GlusterFSPeut supporter tout le stockage,Parce qu'il n'a pas conçu son propre format de fichier de données privé,Au lieu de cela, il s'agit d'un système de fichiers disque qui adopte la norme dominante dans le système d'exploitation(Par exemple:EXT3、XFSAttendez.)Pour stocker des fichiers,Ainsi, les données peuvent être accédées en utilisant l'accès traditionnel au disque.Espace de noms global unifié

Dans le stockage distribué,Consolider les espaces de noms de tous les noeuds en un espace de noms unifié,La capacité de stockage de tous les noeuds de l'ensemble du système dans un grand pool de stockage virtuel,Permet à l'hôte frontal d'accéder à ces noeuds pour effectuer des opérations de lecture et d'écriture de données.Gestion flexible du volume

GlusterFsEn stockant les données dans un volume logique,Les volumes logiques sont séparés logiquement du pool de stockage logique.

Les pools de stockage logiques peuvent être ajoutés et supprimés en ligne,Pas d'interruption d'activité.Les volumes logiques peuvent croître et diminuer en ligne en fonction de la demande,Et peut réaliser l'équilibrage de charge dans plusieurs noeuds.

La configuration du système de fichiers peut également être modifiée et appliquée en ligne en temps réel,Cela permet de s'adapter aux changements des conditions de charge de travail ou au réglage des performances en ligne.Basé sur un protocole standard

GlusterFSSupport de service de stockage NFS、CIFS、HPTP、FTP、SMB Et GlusterProtocole natif,Tout à fait POSIXCritères(Interface os portable)Compatible avec.

L'application existante n'a pas besoin d'être modifiée pourGluster Accès aux données,Vous pouvez également utiliser unAPIEffectuer des visites.

2、GlusterFSTerminologie

- Brick(Bloc de stockage) :

Une partition privée fournie par un hôte dans un pool d'hôtes de confiance pour le stockage physique,- Oui.GlusterFSUnit é de stockage de base en,En même temps,

Répertoire de stockage fourni à l'extérieur sur le serveur dans le pool de stockage de confiance .

Le format du Répertoire de stockage se compose du chemin absolu du serveur et du Répertoire,Représenté parSERVER:EXPORT,Par exemple:20.0.0.12:

/ data/ mydir/. - volume(Volume logique):

Un volume logique est un ensemble deBrick Collection de.Un volume est un dispositif logique pour le stockage de données,Similaire àLVMVolume logique dans.La plupartGlusterLes opérations administratives sont effectuées sur le volume. - FUSE:

C'est un module du noyau,Permettre aux utilisateurs de créer leurs propres systèmes de fichiers,Pas besoin de modifier le Code du noyau. - VFS:

L'espace du noyau est l'interface fournie par l'Espace utilisateur pour accéder au disque. - Glusterd (Processus de gestion de fond) :

Exécuter sur chaque noeud du cluster de stockage.

3、Architecture modulaire de la pile

- GlusterFS Utilisation de la modularisation、 Architecture de pile dimensionnelle .

- Grâce à diverses combinaisons de modules,Pour réaliser des fonctions complexes.Par exempleReplicateLe module peut être réaliséRATD1,StripeLe module peut être réalisé RAID0,Grâce à une combinaison des deuxRAID10 EtRAID01,Plus de performance et de fiabilité.

4、GlusterfsFlux de travail pour

- (1)Le client ou l'application passe parGlusterfsPoint de montage pour accéder aux données.

- (2)linuxLe noyau du système passeVFSAPIRéception et traitement des demandes.

- (3)VFSSoumettre les données àFUSESystème de fichiers du noyau,Et enregistrer un système de fichiers réel avec le systèmeFSE,EtFUSLe système de fichiers passe les données à traversldev/fuseLa documentation relative à l'équipement a été soumise àGlusterFs clientFin.Vous pouvezFUSELe système de fichiers est interprété comme un agent.

- (4)GlusterFs client Dès réception des données,clientTraitement des données selon la configuration du profil.

- (5)Passe.GlusterFS client Après traitement,Transfert de données à distance via le réseau GlusterFS server,Et écrire des données sur le périphérique de stockage du serveur.

5、élasticité HASH Algorithmes

élasticité HASH L'algorithme est Davies-Meyer Réalisation concrète de l'algorithme,Adoption HASH L'algorithme peut obtenir un 32 De la plage entière de bits hash Valeur,Supposons qu'il y ait N Unités de stockage Brick,Et 32 La plage entière de bits sera divisée en N Sous - espaces consécutifs,Un par espace Brick.

Lorsque l'utilisateur ou l'application accède à un espace de noms,En calculant cet espace de noms HASH Valeur,Selon HASH La valeur correspond à 32 L'espace entier bitwise localise où se trouvent les données Brick.

élasticité HASH Avantages de l'algorithme:

- Les données garanties sont réparties uniformément sur chaque Brick Moyenne.

- La dépendance vis - à - vis du serveur de métadonnées a été résolue,.Cela résout les problèmes de point unique et les goulets d'étranglement d'accès.

2.、GlusterFSType de volume pour

GlusterFS Prise en charge de sept volumes,C'est - à - dire les volumes distribués、Bobine de bande、Copier le volume、Rouleaux à bandes distribuées、Volumes de réplication distribués、Volume de réplication des bandes et volume de réplication des bandes distribuées.

Volume distribué(Par défaut):Adoption du documentHASHL'algorithme est distribué à tousBrick ServerAllez.,Ce genre de volume estGFSBase;Sur la base des documentsHASHAlgorithme de hachage à différentsBrick,En fait, il a juste augmenté l'espace disque,Pas tolérant les défauts,Au niveau du fichierRAID 0

Bobine de bande(Par défaut):SimilaireRAID 0,Les fichiers sont divisés en bases de données et distribués par sondage à plusieursBrick ServerAllez.,Stockage de fichiers en blocs,Prise en charge du stockage de fichiers volumineux,Plus le fichier est grand,Plus l'efficacité de lecture est élevée

Copier le volume(Replica volume):Synchroniser les fichiers en plusieursBrickAllez.,Pour avoir plusieurs copies de fichiers,Au niveau du fichierRAID 1,Tolérance aux défauts.Parce que les données sont disperséesBrickMoyenne,Donc la lecture a été grandement améliorée,Mais les performances d'écriture ont diminué

Rouleaux à bandes distribuées(Distribute Stripe volume):Brick ServerLa quantité est le nombre de bandes(Distribution des blocs de donnéesBrickNombre)Multiple de,Caractéristiques des rouleaux et des bandes distribués

Volumes de réplication distribués(Distribute Replica volume):Brick ServerLe nombre est le nombre de miroirs(Copie des données Nombre)Multiple de,Caractéristiques des volumes distribués et des volumes de réplication

Volume de copie de bande(Stripe Replca volume):SimilaireRAID 10,Caractéristiques des volumes de bande et de copie

Volume de réplication des bandes distribuées(Distribute Stripe Replicavolume):Les volumes composés des trois volumes de base sont généralement utilisés dans les classesMap ReduceApplication.

Trois、DéploiementGlusterFSCluster

Préparation de l'expérience

node1Serveur:20.0.0.10

node2Serveur:20.0.0.5

node3Serveur:20.0.0.6

node4Serveur:20.0.0.7

Noeud client:20.0.0.12

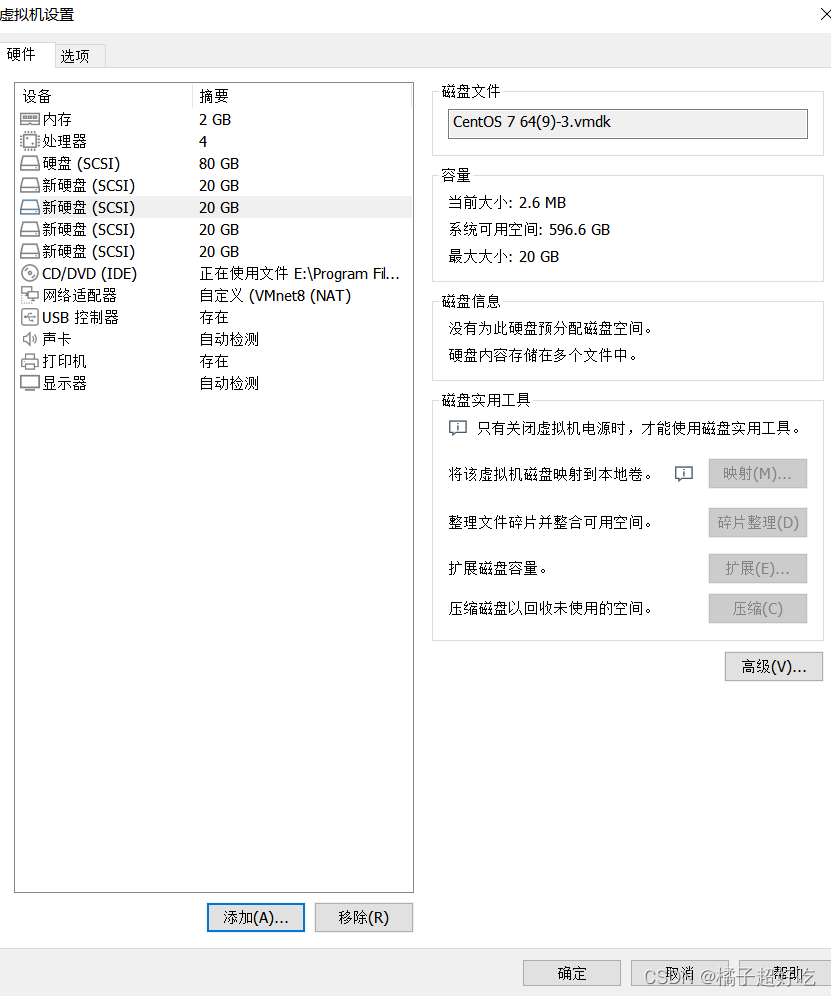

Quatre machines virtuelles ajoutées 4Carte réseau bloc,Faites des expériences seulement,Pas besoin d'être trop grand

1、Changer le nom du noeud

##Modifier le nom d'hôte

hostname node1

su

hostname node2

su

hostname node3

su

hostname node4

su

2、Le noeud monte le disque,Installer une source locale

cd /opt

vim /fdisk.sh

#!/bin/bash

NEWDEV=`ls /dev/sd* | grep -o 'sd[b-z]' | uniq`

for VAR in $NEWDEV

do

echo -e "n\np\n\n\n\nw\n" | fdisk /dev/$VAR &> /dev/null

mkfs.xfs /dev/${

VAR}"1" &> /dev/null

mkdir -p /data/${

VAR}"1" &> /dev/null

echo "/dev/${VAR}"1" /data/${VAR}"1" xfs defaults 0 0" >> /etc/fstab

done

mount -a &> /dev/null

chmod +x /opt/fdisk.sh

cd /opt/

./fdisk.sh

[[email protected] /opt] # echo "20.0.0.10 node1" >> /etc/hosts

[[email protected] /opt] # echo "20.0.0.5 node2" >> /etc/hosts

[[email protected] /opt] # echo "20.0.0.6 node3" >> /etc/hosts

[[email protected] /opt] # echo "20.0.0.7 node4" >> /etc/hosts

[[email protected] /opt] # ls

fdisk.sh rh

[[email protected] /opt] # rz -E

rz waiting to receive.

[[email protected] /opt] # ls

fdisk.sh gfsrepo.zip rh

[[email protected] /opt] # unzip gfsrepo.zip

[[email protected] /opt] # cd /etc/yum.repos.d/

[[email protected] /etc/yum.repos.d] # ls

local.repo repos.bak

[[email protected] /etc/yum.repos.d] # mv * repos.bak/

mv: Impossible de mettre le répertoire"repos.bak" Passer à son propre sous - répertoire"repos.bak/repos.bak" En bas.

[[email protected] /etc/yum.repos.d] # ls

repos.bak

[[email protected] /etc/yum.repos.d] # vim glfs.repo

[glfs]

name=glfs

baseurl=file:///opt/gfsrepo

gpgcheck=0

enabled=1

[[email protected] /etc/yum.repos.d] # yum clean all && yum makecache

Plug - in chargé:fastestmirror, langpacks

Nettoyage des sources logicielles: glfs

Cleaning up everything

Maybe you want: rm -rf /var/cache/yum, to also free up space taken by orphaned data from disabled or removed repos

Plug - in chargé:fastestmirror, langpacks

glfs | 2.9 kB 00:00:00

(1/3): glfs/filelists_db | 62 kB 00:00:00

(2/3): glfs/other_db | 46 kB 00:00:00

(3/3): glfs/primary_db | 92 kB 00:00:00

Determining fastest mirrors

Mise en cache des métadonnées établie

[[email protected] /etc/yum.repos.d] # yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdma

[[email protected] /etc/yum.repos.d] # systemctl start glusterd.service

[[email protected] /etc/yum.repos.d] # systemctl enable glusterd.service

Created symlink from /etc/systemd/system/multi-user.target.wants/glusterd.service to /usr/lib/systemd/system/glusterd.service.

[[email protected] /etc/yum.repos.d] # systemctl status glusterd.service

3、Ajouter un noeud pour créer un Cluster

Ajouter un noeud au pool de confiance de stockage

[[email protected] ~] # gluster peer probe node1

peer probe: success. Probe on localhost not needed

[[email protected] ~] # gluster peer probe node2

peer probe: success.

[[email protected] ~] # gluster peer probe node3

peer probe: success.

[[email protected] ~] # gluster peer probe node4

peer probe: success.

[[email protected] ~] # gluster peer status

Number of Peers: 3

Hostname: node2

Uuid: 2ee63a35-6e83-4a35-8f54-c9c0137bc345

State: Peer in Cluster (Connected)

Hostname: node3

Uuid: e63256a9-6700-466f-9279-3e3efa3617ec

State: Peer in Cluster (Connected)

Hostname: node4

Uuid: 9931effa-92a6-40c7-ad54-7361549dd96d

State: Peer in Cluster (Connected)

4、Créer un volume distribué

#Créer un volume distribué,Aucun type spécifié,Par défaut, les volumes distribués sont créés

[[email protected] ~] # gluster volume create dis-volume node1:/data/sdb1 node2:/data/sdb1 force

volume create: dis-volume: success: please start the volume to access data

[[email protected] ~] # gluster volume list

dis-volume

[[email protected] ~] # gluster volume start dis-volume

volume start: dis-volume: success

[[email protected] ~] # gluster volume info dis-volume

Volume Name: dis-volume

Type: Distribute

Volume ID: 8f948537-5ac9-4091-97eb-0bdcf142f4aa

Status: Started

Snapshot Count: 0

Number of Bricks: 2

Transport-type: tcp

Bricks:

Brick1: node1:/data/sdb1

Brick2: node2:/data/sdb1

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

5、Créer un volume de bande

#Le type spécifié est stripe,La valeur est 2,Et il est suivi par 2 - Oui. Brick Server,Donc ce que vous créez est un volume de bande

[[email protected] ~] # gluster volume create stripe-volume stripe 2 node1:/data/sdc1 node2:/data/sdc1 force

volume create: stripe-volume: success: please start the volume to access data

[[email protected] ~] # gluster volume start stripe-volume

volume start: stripe-volume: success

[[email protected] ~] # gluster volume info stripe-volume

Volume Name: stripe-volume

Type: Stripe

Volume ID: b1185b78-d396-483f-898e-3519d3ef8e37

Status: Started

Snapshot Count: 0

Number of Bricks: 1 x 2 = 2

Transport-type: tcp

Bricks:

Brick1: node1:/data/sdc1

Brick2: node2:/data/sdc1

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

6、Créer un volume de réplication

#Le type spécifié est replica,La valeur est 2,Et il est suivi par 2 - Oui. Brick Server,Donc ce que vous créez est un volume de réplication

[[email protected] ~] # gluster volume create rep-volume replica 2 node3:/data/sdb1 node4:/data/sdb1 force

volume create: rep-volume: success: please start the volume to access data

[[email protected] ~] # gluster volume start rep-volume

volume start: rep-volume: success

[[email protected] ~] # gluster volume info rep-volume

Volume Name: rep-volume

Type: Replicate

Volume ID: 9d39a2a6-b71a-44a5-8ea5-5259d8aef518

Status: Started

Snapshot Count: 0

Number of Bricks: 1 x 2 = 2

Transport-type: tcp

Bricks:

Brick1: node3:/data/sdb1

Brick2: node4:/data/sdb1

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

7、Créer un volume de bande distribué

#Le type spécifié est stripe,La valeur est 2,Et il est suivi par 4 - Oui. Brick Server,- Oui. 2 Deux fois plus.,Donc ce que vous créez est un volume de bande distribué

[[email protected] ~] # gluster volume create dis-stripe stripe 2 node1:/data/sdd1 node2:/data/sdd1 node3:/data/sdd1 node4:/data/sdd1 force

volume create: dis-stripe: success: please start the volume to access data

[[email protected] ~] # gluster volume start dis-stripe

volume start: dis-stripe: success

[[email protected] ~] # gluster volume info dis-stripe

Volume Name: dis-stripe

Type: Distributed-Stripe

Volume ID: beb7aa78-78d1-435f-8d29-c163878c73f0

Status: Started

Snapshot Count: 0

Number of Bricks: 2 x 2 = 4

Transport-type: tcp

Bricks:

Brick1: node1:/data/sdd1

Brick2: node2:/data/sdd1

Brick3: node3:/data/sdd1

Brick4: node4:/data/sdd1

Options Reconfigured:

transport.address-family: inet

nfs.disable: on

8、DéploiementglusterClient

[[email protected] ~]#systemctl stop firewalld

[[email protected] ~]#setenforce 0

[[email protected] ~]#cd /opt

[[email protected] opt]#ls

rh

[[email protected] opt]#rz -E

rz waiting to receive.

[[email protected] opt]#ls

gfsrepo.zip rh

[[email protected] opt]#unzip gfsrepo.zip

[[email protected] opt]#cd /etc/yum.repos.d/

[[email protected] yum.repos.d]#ls

local.repo repos.bak

[[email protected] yum.repos.d]#mv * repos.bak/

mv: Impossible de mettre le répertoire"repos.bak" Passer à son propre sous - répertoire"repos.bak/repos.bak" En bas.

[[email protected] yum.repos.d]#ls

repos.bak

[[email protected] yum.repos.d]#vim glfs.repo

[glfs]

name=glfs

baseurl=file:///opt/gfsrepo

gpgcheck=0

enabled=1

[[email protected] yum.repos.d]#yum clean all && yum makecache

[[email protected] yum.repos.d]#yum -y install glusterfs glusterfs-fuse

[[email protected] yum.repos.d]#mkdir -p /test/{

dis,stripe,rep,dis_stripe,dis_rep}

[[email protected] yum.repos.d]#cd /test/

[[email protected] test]#ls

dis dis_rep dis_stripe rep stripe

[[email protected] test]#

[[email protected] test]#echo "20.0.0.10 node1" >> /etc/hosts

[[email protected] test]#echo "20.0.0.5 node2" >> /etc/hosts

[[email protected] test]#echo "20.0.0.6 node3" >> /etc/hosts

[[email protected] test]#echo "20.0.0.7 node4" >> /etc/hosts

[[email protected] test]#mount.glusterfs node1:dis-volume /test/dis

[[email protected] test]#mount.glusterfs node1:stripe-volume /test/stripe

[[email protected] test]#mount.glusterfs node1:rep-volume /test/rep

[[email protected] test]#mount.glusterfs node1:dis-stripe /test/dis_stripe

[[email protected] test]#mount.glusterfs node1:dis-rep /test/dis_rep

[[email protected] test]#

[[email protected] test]#df -h

Système de fichiers Capacité Utilisé Disponible Utilisé% Point de montage

/dev/sda2 16G 3.5G 13G 22% /

devtmpfs 898M 0 898M 0% /dev

tmpfs 912M 0 912M 0% /dev/shm

tmpfs 912M 18M 894M 2% /run

tmpfs 912M 0 912M 0% /sys/fs/cgroup

/dev/sda5 10G 37M 10G 1% /home

/dev/sda1 10G 174M 9.9G 2% /boot

tmpfs 183M 4.0K 183M 1% /run/user/42

tmpfs 183M 40K 183M 1% /run/user/0

/dev/sr0 4.3G 4.3G 0 100% /mnt

node1:dis-volume 6.0G 65M 6.0G 2% /test/dis

node1:stripe-volume 8.0G 65M 8.0G 1% /test/stripe

node1:rep-volume 3.0G 33M 3.0G 2% /test/rep

node1:dis-stripe 21G 130M 21G 1% /test/dis_stripe

node1:dis-rep 11G 65M 11G 1% /test/dis_rep

[[email protected] test]#cd /opt

[[email protected] opt]#dd if=/dev/zero of=/opt/demo1.log bs=1M count=40

C'est enregistré.40+0 Lire dans

C'est enregistré.40+0 Écrire

41943040Octets(42 MB)Copié,0.0311576 Secondes,1.3 GB/Secondes

[[email protected] opt]#dd if=/dev/zero of=/opt/demo2.log bs=1M count=40

C'est enregistré.40+0 Lire dans

C'est enregistré.40+0 Écrire

41943040Octets(42 MB)Copié,0.182058 Secondes,230 MB/Secondes

[[email protected] opt]#dd if=/dev/zero of=/opt/demo3.log bs=1M count=40

C'est enregistré.40+0 Lire dans

C'est enregistré.40+0 Écrire

41943040Octets(42 MB)Copié,0.196193 Secondes,214 MB/Secondes

[[email protected] opt]#dd if=/dev/zero of=/opt/demo4.log bs=1M count=40

C'est enregistré.40+0 Lire dans

C'est enregistré.40+0 Écrire

41943040Octets(42 MB)Copié,0.169933 Secondes,247 MB/Secondes

[[email protected] opt]#dd if=/dev/zero of=/opt/demo5.log bs=1M count=40

C'est enregistré.40+0 Lire dans

C'est enregistré.40+0 Écrire

41943040Octets(42 MB)Copié,0.181712 Secondes,231 MB/Secondes

[[email protected] opt]#

[[email protected] opt]#ls -lh /opt

[[email protected] opt]#cp demo* /test/dis

[[email protected] opt]#cp demo* /test/stripe/

[[email protected] opt]#cp demo* /test/rep/

[[email protected] opt]#cp demo* /test/dis_stripe/

[[email protected] opt]#cp demo* /test/dis_rep/

[[email protected] opt]#cd /test/

[[email protected] test]#tree

.

├── dis

│ ├── demo1.log

│ ├── demo2.log

│ ├── demo3.log

│ ├── demo4.log

│ └── demo5.log

├── dis_rep

│ ├── demo1.log

│ ├── demo2.log

│ ├── demo3.log

│ ├── demo4.log

│ └── demo5.log

├── dis_stripe

│ ├── demo1.log

│ ├── demo2.log

│ ├── demo3.log

│ ├── demo4.log

│ └── demo5.log

├── rep

│ ├── demo1.log

│ ├── demo2.log

│ ├── demo3.log

│ ├── demo4.log

│ └── demo5.log

└── stripe

├── demo1.log

├── demo2.log

├── demo3.log

├── demo4.log

└── demo5.log

5 directories, 25 files

[[email protected] test]#

9、Voir la distribution des fichiers

1、Voir la distribution des fichiers

##Voir la distribution des fichiers distribués

[[email protected] ~] # ls -lh /data/sdb1

Consommation totale 160M

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo3.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo4.log

[[email protected] ~]#ll -h /data/sdb1

Consommation totale 40M

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo5.log

##Voir la distribution des fichiers de volume de bande

[[email protected] ~] # ls -lh /data/sdc1

Consommation totale 100M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo3.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo5.log

[[email protected] ~]#ll -h /data/sdc1

Consommation totale 100M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo3.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo5.log

##Voir la distribution des fichiers de volume de réplication

[[email protected] ~]#ll -h /data/sdb1

Consommation totale 200M

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo3.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo5.log

[[email protected] ~]#ll -h /data/sdb1

Consommation totale 200M

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo3.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 40M 7Mois 4 20:47 demo5.log

##Voir la distribution des volumes de bandes distribuées

[[email protected] ~] # ll -h /data/sdd1

Consommation totale 60M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo3.log

[[email protected] ~]#ll -h /data/sdd1

Consommation totale 60M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo1.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo2.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo3.log

[[email protected] ~]#ll -h /data/sdd1

Consommation totale 40M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo5.log

[[email protected] ~]#ll -h /data/sdd1

Consommation totale 40M

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo4.log

-rw-r--r--. 2 root root 20M 7Mois 4 20:47 demo5.log

2、Essais destructifs

#1、En attente node2 Noeud ou arrêtglusterdService pour simuler une défaillance

[[email protected] ~]# systemctl stop glusterd.service

#2、Vérifier si le fichier est correct sur le client

#Affichage des données du volume distribué

[[email protected] test]# ll /test/dis/ # Trouvé moins sur le client demo5.logDocumentation,Celui - ci estnode2Oui.

Consommation totale 163840

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo1.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo2.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo3.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo4.log

#Bobine de bande

[[email protected] test]# cd /test/stripe/ #Impossible d'accéder,Le volume de bande n'est pas redondant

[[email protected] stripe]# ll

Consommation totale 0

#Rouleaux à bandes distribuées

[[email protected] test]# ll /test/dis_stripe/ #Impossible d'accéder,Les rouleaux de bandes distribuées ne sont pas redondants

Consommation totale 40960

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo5.log

#Volumes de réplication distribués

[[email protected] test]# ll /test/dis_rep/ #Accessible, Les volumes de réplication distribués sont redondants

Consommation totale 204800

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo1.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo2.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo3.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo4.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo5.log

#En attente node2 Et node4 Noeud,Vérifier si le fichier est correct sur le client

#Tester le bon volume de réplication

[[email protected] rep]# ls -l /test/rep/ #Test OK sur le client,Données disponibles

Consommation totale 204800

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo1.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo2.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo3.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo4.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:48 demo5.log

#Vérifier si le volume de bande distribué est normal

[[email protected] dis_stripe]# ll /test/dis_stripe/ # Il n'y a pas de données pour le test sur le client

Consommation totale 0

#Tester le bon fonctionnement des volumes de réplication distribués

[[email protected] dis_rep]# ll /test/dis_rep/ #Test OK sur le client,Données disponibles

Consommation totale 204800

-rw-r--r-- 1 root root 41943040 7Mois 4 20:49 demo1.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:49 demo2.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:49 demo3.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:49 demo4.log

-rw-r--r-- 1 root root 41943040 7Mois 4 20:49 demo5.log

Quatre、Autres commandes de maintenance

1.VoirGlusterFSVol.

gluster volume list

2.Voir les informations pour tous les volumes

gluster volume info

3.Voir l'état de tous les volumes

gluster volume status

4.Arrêter un volume

gluster volume stop dis-stripe

5.Supprimer un volume,Attention!:Lors de la suppression d'un volume,Il faut d'abord arrêter le volume,Et aucun hôte dans le pool de confiance ne peut être en état d'arrêt,Sinon, la suppression n'a pas réussi

gluster volume delete dis-stripe

6.Définir le contrôle d'accès pour le volume

##Refuser seulement

gluster volume set dis-rep auth.allow 20.0.0.20

##Uniquement autorisé

gluster volume set dis-rep auth.allow 20.0.0.* #Paramètres20.0.0.0Tous les segments du réseauIPToutes les adresses sont accessiblesdis-repVol.(Volumes de réplication distribués)

边栏推荐

- Mathematical formula screenshot recognition artifact mathpix unlimited use tutorial

- Différence entre hors bande et en bande

- poj 2762 Going from u to v or from v to u? (推断它是否是一个薄弱环节图)

- Dynamic planning: robbing families and houses

- Creative mode 1 - single case mode

- Idea rundashboard window configuration

- The PostgreSQL column reference 'ID' is ambiguous - PostgreSQL column reference'id'is ambiguous

- 【LeetCode】5. Valid Palindrome·有效回文

- When to use useImperativeHandle, useLayoutEffect, and useDebugValue

- Spire Office 7.5.4 for NET

猜你喜欢

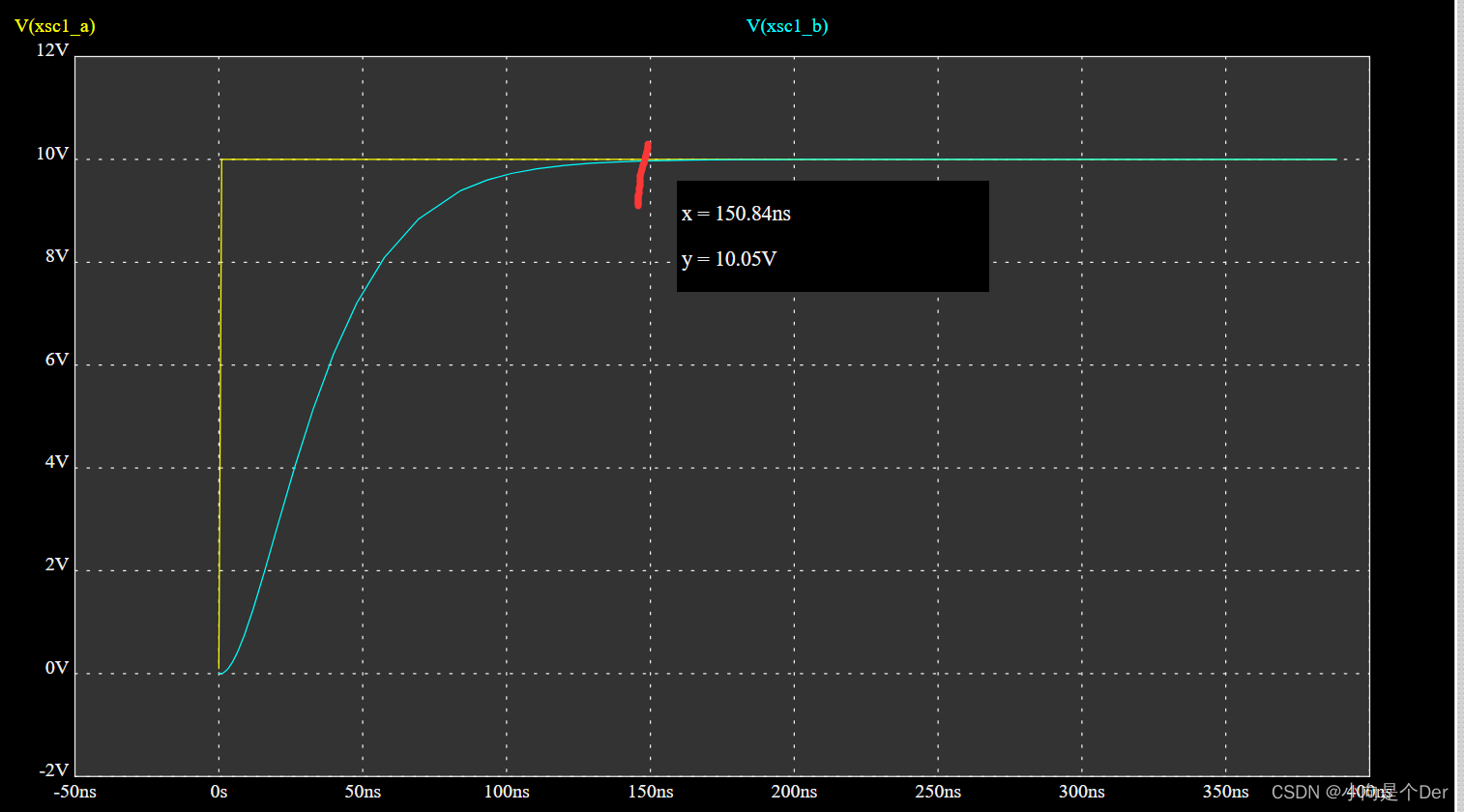

【经典控制理论】自控实验总结

From the perspective of quantitative genetics, why do you get the bride price when you get married

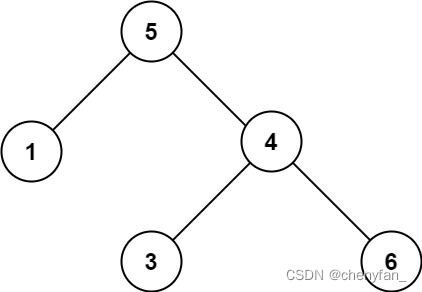

98. 验证二叉搜索树 ●●

无刷驱动设计——浅谈MOS驱动电路

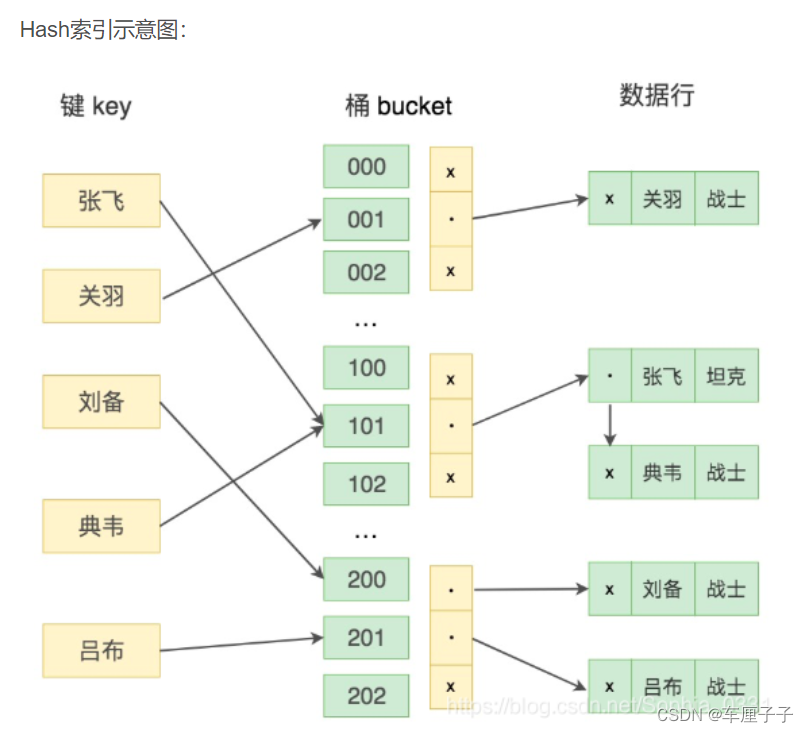

Basic knowledge of database (interview)

Xinyuan & Lichuang EDA training camp - brushless motor drive

Rasa 3.x 学习系列-Rasa X 社区版(免费版) 更改

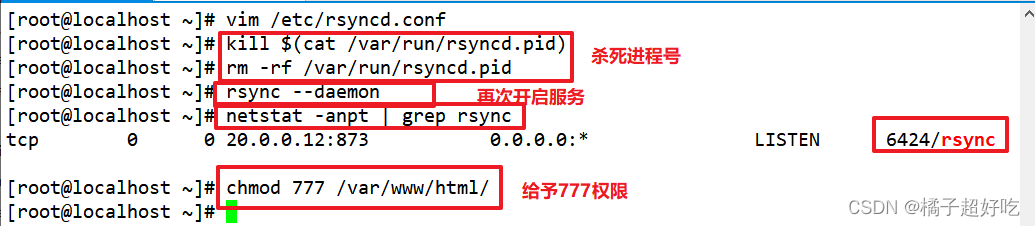

rsync远程同步

LabVIEW打开PNG 图像正常而 Photoshop打开得到全黑的图像

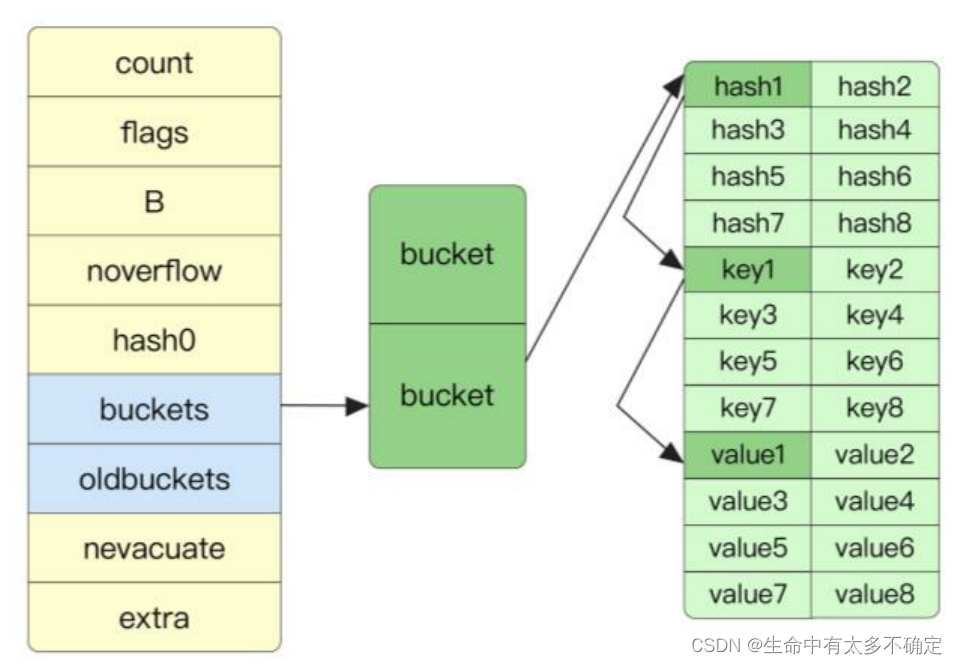

Go语言实现原理——Map实现原理

随机推荐

Sum of two numbers, sum of three numbers (sort + double pointer)

Latex multiple linebreaks

The maximum happiness of the party

[classical control theory] summary of automatic control experiment

424. 替换后的最长重复字符 ●●

保研笔记二 软件工程与计算卷二(13-16章)

Naoqi robot summary 26

Use of metadata in golang grpc

LabVIEW打开PNG 图像正常而 Photoshop打开得到全黑的图像

【LeetCode】5. Valid Palindrome·有效回文

Debian 10 installation configuration

How to improve eloquence

Attacking technology Er - Automation

Solution to the packaging problem of asyncsocket long connecting rod

GFS分布式文件系统

SpreadJS 15.1 CN 与 SpreadJS 15.1 EN

idea 连接mysql ,直接贴配置文件的url 比较方便

Go language introduction detailed tutorial (I): go language in the era

Basic knowledge of database (interview)

TVS管 与 稳压二极管参数对比