当前位置:网站首页>干货!基于序列超图神经网络的信息扩散预测

干货!基于序列超图神经网络的信息扩散预测

2022-06-11 19:28:00 【AITIME论道】

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

扩散级联预测是理解信息在社交网络上传播的关键。大多数方法通常集中在单个级联中受感染用户的顺序或结构上,因此忽略了全局用户和级联的依赖性,限制了预测性能。而当前引入社交网络的策略只能获取到用户之间的社会同质性,不足以描述他们的偏好。

为了解决上述问题,我们提出了一种新的信息扩散预测方法,名为记忆增强序列超图注意网络(MS-HGAT)。

具体来说,在学习用户全局依赖方面,我们不仅利用他们的友谊关系,也考虑他们在级联层面的交互关系。此外,为了动态捕获用户的偏好,我们将扩散超图分为基于时间戳的一系列子图,构建超图注意力网络来学习序列超图,并利用门控融合策略将其连接起来。

此外,还提出了一个记忆增强的嵌入查找模块,用于将学习到的用户表示捕获到特定的级联嵌入空间上,从而突出级联内部的序列信息。

本期AI TIME PhD直播间,我们邀请到西安交通大学2019级直博生——孙菱,为我们带来报告分享《基于序列超图神经网络的信息扩散预测》。

孙菱:

西安交通大学2019级直博生,师从饶元教授。主要研究方向为面向社交媒体的信息传播建模、虚假信息检测及干预方法,相关工作发表在AAAI、IJCAI、ACL等国际会议。

研究背景

信息扩散预测

给定:历史扩散数据(级联树:复杂、难以获取,级联序列)

任务:

● 微观层面:

研究动机

基于表示学习的方法:

目前的问题都是基于传播模式固定,但在真实的在信息场景下可能不会遵循预定义好的模式。目前的方法主要有两个问题:

1. 大多数研究忽略了用户在信息消费过程中的全局依赖

我们的解决办法:同时挖掘全局的友谊关系和全局扩散交互关系

上述网络中的不同用户可能存在级联交互。

2. 几乎没有模型能够深入学习用户和级联之间的动态联系

我们的解决办法:建立一系列超图动态学习特定时间间隔内用户和级联的交互关系。

超图中的一条边可能包含多个点,我们通过构建一系列的超图来表示不同时间间隔内用户在全局层面的交互并学习其动态偏好。

MS-HGAT模型

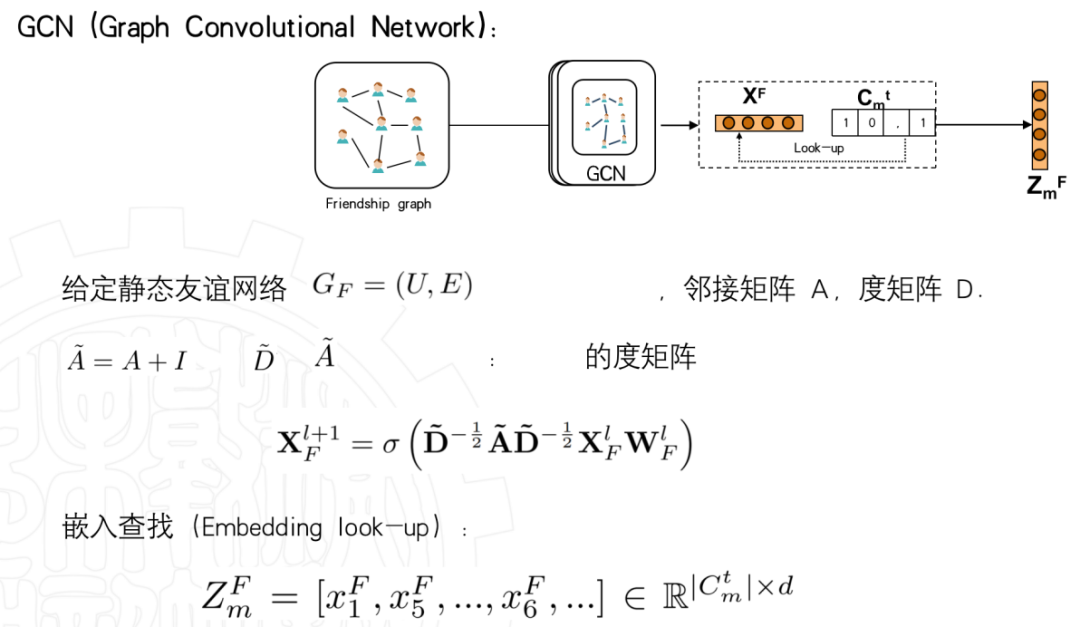

第一部分是静态的学习用户关系网络;

第二部分是动态的用一系列传播的超图来学习其动态的交互行为;记忆增强的嵌入查找模块是将静态和动态学到的用户表示存在记忆块中以便后续查找。

MS-HGAT

Module1:用户静态依赖学习

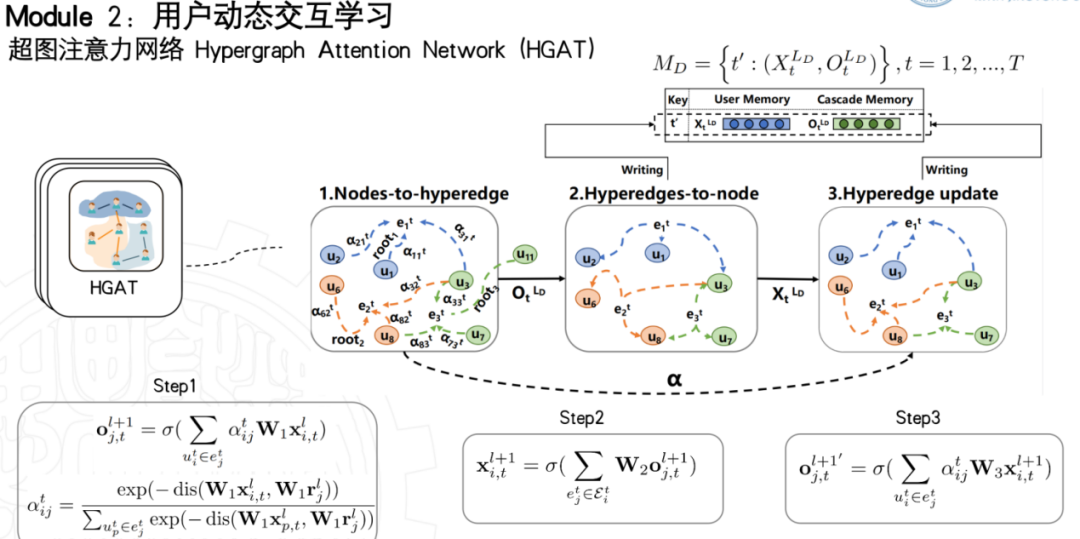

第二个模块是本研究的主要创新,主要是学习用户动态交互。

第一步,由于用户1,2,3同时参与了超边,我们根据这3个用户与该条超边上的根(root)用户的距离,计算注意力系数,并加权聚合为超边的表示。

第二步,是超边聚合回点的一个过程。我们第一步聚合到了边上,学到了3条级联的特征,再返回到点上。即将全局范围内学到的边的特征再返回给节点。我们最终就能学习到用户的交互偏好。不过,这个超图学习的是短时间的用户交互行为,就没有额外计算注意力而是直接计算了平均聚合。

第三步,是更新。即再次进行点到边的聚合,以更新超边的表示,然后存入记忆模块中。

记忆模块主要保存用户和超边的特征,以便于后续查找。

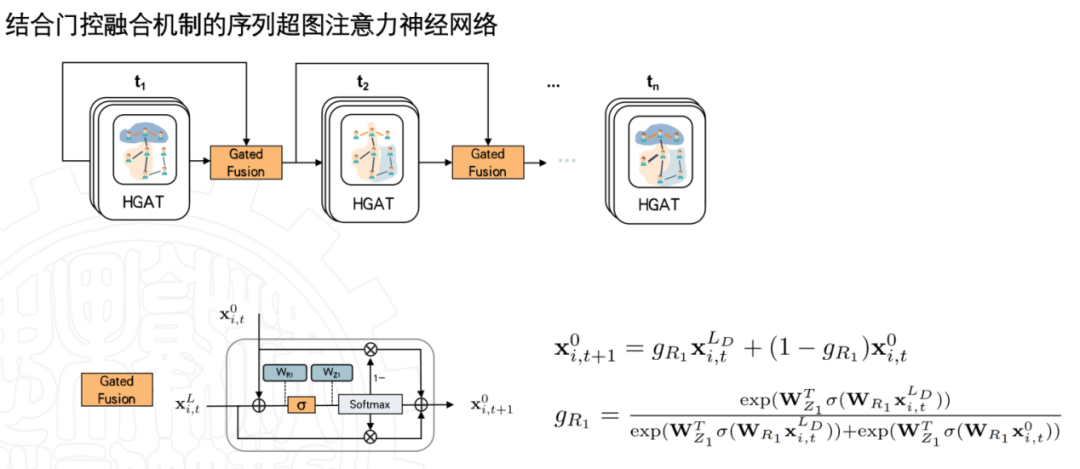

全局扩散的超图是根据时间戳分为几个子图的,子图的连接是通过一个自适应的融合门机制。

我们把前一时刻的输入和输出做了聚合来作为下一个阶段的输入。

最后进行嵌入查找,给定特定的级联,在记忆模块中分别查找静态和动态的表示特征。动态查找方面需要将用户角度和级联角度的结果进行融合。

我们在交互网络分别学到静态和动态的级联表示,但是图神经网络无法学习到参与的用户之间的序列关系。

因此,我们引入了transformer中的自注意力解码器模块,进一步学习级联内部的交互关系。

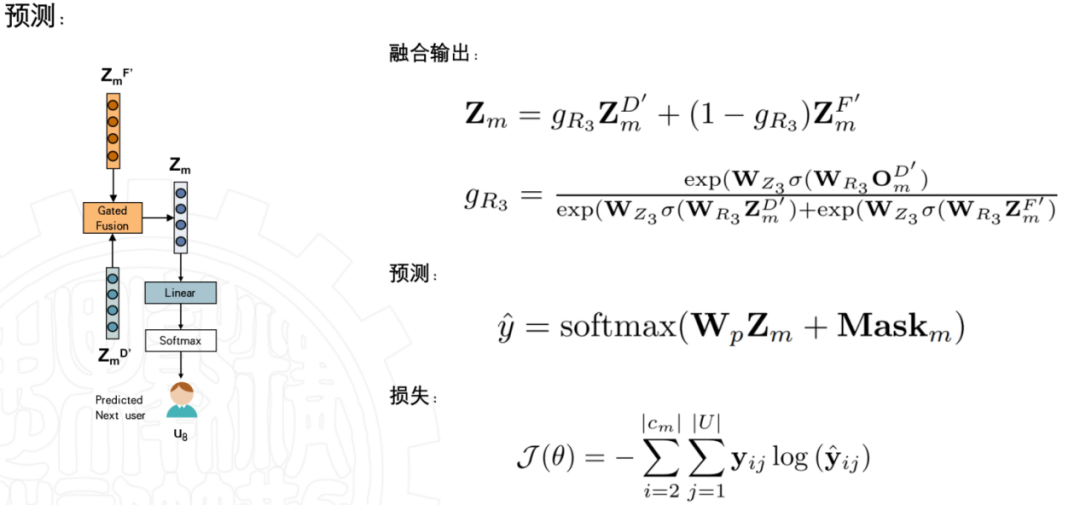

最后,我们同样用这两种表示通过自适应的融合方法,得到的输出就是我们最终获得的级联表示,根据该表示,我们预测下一个会是哪个用户加入到级联中来。

实验

● RQ1:MS-HGAT是否优于最先进的信息扩散预测方法?

● RQ2:训练集的数量和质量如何影响模型的预测性能?

● RQ3:用户关系和我们的学习策略如何影响MS-HGAT的预测性能?

我们通过修改K值,来看模型在K取不同值时候的表现。

我们同样可以看到,用到全局用户和交互关系的方法比仅仅利用级联来做预测要好一些。

上述实验结果也说明,我们的模型进行了更为深入的特征捕获。

我们调整了可训练级联的最大长度,从实验可见我们的模型在任何长度的级联上都可以取得很好效果。

在消融实验之中,我们分别对模块进行删减并分析了他们的影响。

首先就移除了社交网络图,第二个移除了扩散网络图,第三个和第四个分别移除了用户的记忆力模块和级联的记忆力模块,第五个将所有的门控融合机制转化成了拼接的简单形式。

未来工作方向

● 使用超图来描述树状级联,而不仅仅是序列。

● 将信息内容与扩散特征相结合。

● 考虑社交平台中的多样化用户行为(例如“点赞”和“评论”)

提

醒

论文题目:

MS-HGAT: Memory-enhanced Sequential Hypergraph Attention Network for Information Diffusion Prediction

论文链接:

https://www.aaai.org/AAAI22Papers/AAAI-4362.SunL.pdf

点击“阅读原文”,即可观看本场回放

整理:林 则

作者:孙 菱

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了600多位海内外讲者,举办了逾300场活动,超210万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看回放!

边栏推荐

- Flask CKEditor 富文本编译器实现文章的图片上传以及回显,解决路径出错的问题

- MOS transistor 24n50 parameters of asemi, 24n50 package, 24n50 size

- [solution] codeforces round 798 (Div. 2)

- Review of software testing technology

- Operator new and placement new

- 激活函数公式、导数、图像笔记

- Go语言入门(六)——循环语句

- Cf:g. count the trains [sortedset + bisect + simulation maintaining strict decreasing sequence]

- 【Multisim仿真】利用运算放大器产生方波、三角波发生器

- Merge multiple binary search trees

猜你喜欢

vs2010链接sql2008数据库时无法打开

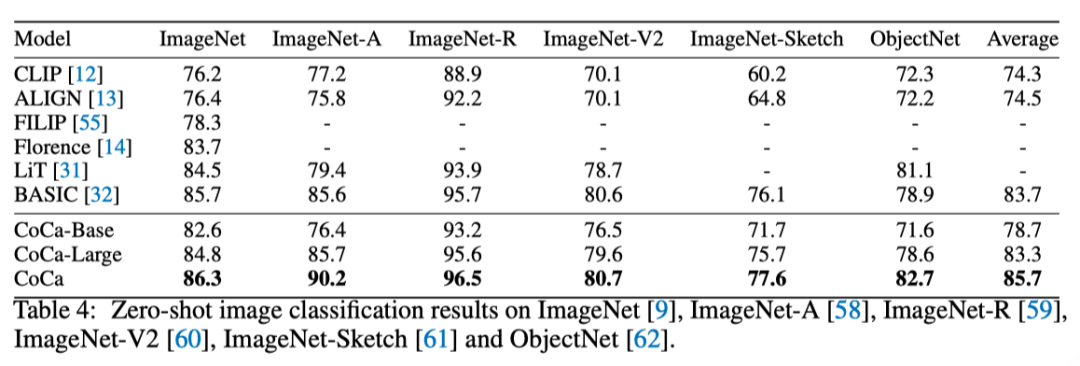

谷歌提出超强预训练模型CoCa,在ImageNet上微调Top-1准确率达91%!在多个下游任务上SOTA!...

Multimodal learning toolkit paddlemm based on propeller

Understand how to get started with machine learning to quantify transactions?

使用贝叶斯优化进行深度神经网络超参数优化

Experience of remote office communication under epidemic situation | community essay solicitation

Hospital intelligent infusion management system source code hospital source code

Pyqt5 tips - button vertical display method, QT designer sets button vertical display.

![[assembly] analysis of Experiment 7 of the fourth edition of assembly language](/img/ac/a3c5bfeb2dcb93b123dd337993bab3.jpg)

[assembly] analysis of Experiment 7 of the fourth edition of assembly language

《经济学人》:WTO MC12重启 数字经济成为全球经济复苏和增长的核心引擎

随机推荐

【求助】請問如何讓微信公眾號文章在外部瀏覽器中打開後還能顯示下方的精選留言?

SLAM APP

Introduction to ieda bottom menu

Introduction to go language (VI) -- loop statement

vs2010链接sql2008数据库时无法打开

[signal denoising] speech adaptive denoising based on nonlinear filter with matlab code

Key contents that wwdc22 developers need to pay attention to

Hyper parameter optimization of deep neural networks using Bayesian Optimization

Flask CKEditor 富文本编译器实现文章的图片上传以及回显,解决路径出错的问题

Unsupervised image classification code analysis notes of scan:learning to classify images without (1): simclr

pstack和dmesg

09-MySQL锁

collect.stream().collect()方法的使用

Pymysql uses cursor operation database method to encapsulate!!!

Highcharts sets the histogram width, gradient, fillet, and data above the column

CMU 15-445 数据库课程第五课文字版 - 缓冲池

01. Telecommunications_ Field business experience

Review of software testing technology

E-commerce (njupt)

Image transformation torchvision Transforms notes