当前位置:网站首页>【Attention演变史】翻译模型seq2seq (第二弹)

【Attention演变史】翻译模型seq2seq (第二弹)

2022-08-04 19:13:00 【Petersburg】

在上一篇文章中我们简要地说了一下RNN是个什么东西,具体数据在模型上时怎么跑出结果的,简单而言我们把RNN的内部看成一个箱子,把输入的词汇一个一个往里放,并根据每一步的输出同步作为下一步的输入,从而达到综合前面的句意和当前的词义的效果。这篇文章我们主要介绍翻译任务的经典模型之一seq2eq。

翻译到底是个啥

千百年来翻译从来都是个苦逼的活,你不但要精通本国的语言,还要精通国外的语言,争取满足各位水平参差不齐但是要求统一很高的看官,达到“信达雅”的标准。我们抽象地来看翻译这件事情,一个人要翻译中文的一本书,比如《论语》

- 他看到了“学而时习之,不亦说乎”

- 在他的脑子里,看到的这句话形成了一个容易理解的、直观的东西:我学习,然后有规律的每天复习以前的知识,这种事儿还是挺爽的。

- 同样在脑子里,他开始尝试用英文的每个字词来对应直观理解的意思,比如“study everyday and review regularly, isn’t it something delightful?”

- 最终他决定落在笔头上,把上述简单的初中词汇、高中语法,逐个替换为GRE/GMAT词汇,以让人看不懂为目的的语法,输出出来。

用流程图来理解这个过程很简单,我得到这句话 -> 我理解这句话 -> 我对应这句话 -> 我输出这句话。

Encoder - Decoder

有了前面的铺垫,这里理解这个模型设计就直白很多了。我们的输入以及输出都是自然语言,比如中文、英文、阿拉伯文这种我们读得懂的文字,同时计算机处理的是数字、向量。我们这里略过单词的向量话不谈,假设我们已经得到了输入的待翻译句子的逐单词的向量表示。

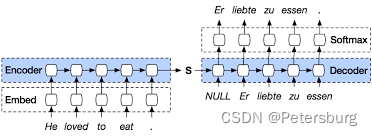

我们需要两个RNN,就如本部分的标题,一个取名叫Encoder,他的兄弟叫Decoder。翻译成人话,就很像二战时候的信息传送,传送方把信息加密后传递出去,接收方用一定的方法还原出来。

Encoder这里的任务就是跑一遍我们之前说过的RNN,拿到一个语义向量,作为Decoder的输入之一。对应上面提到的前两步,得到这句话和理解这句话。

Decoder的任务就是我们要把语义向量分析出来,输出为目标语言的文字。这块对应后面两步,对应每个理解和输出成目标语句。

图中左边是英语的encoder,右边是法语的decoder。至于这块的RNN,我们通常都会选用LSTM或者GRU。

边栏推荐

猜你喜欢

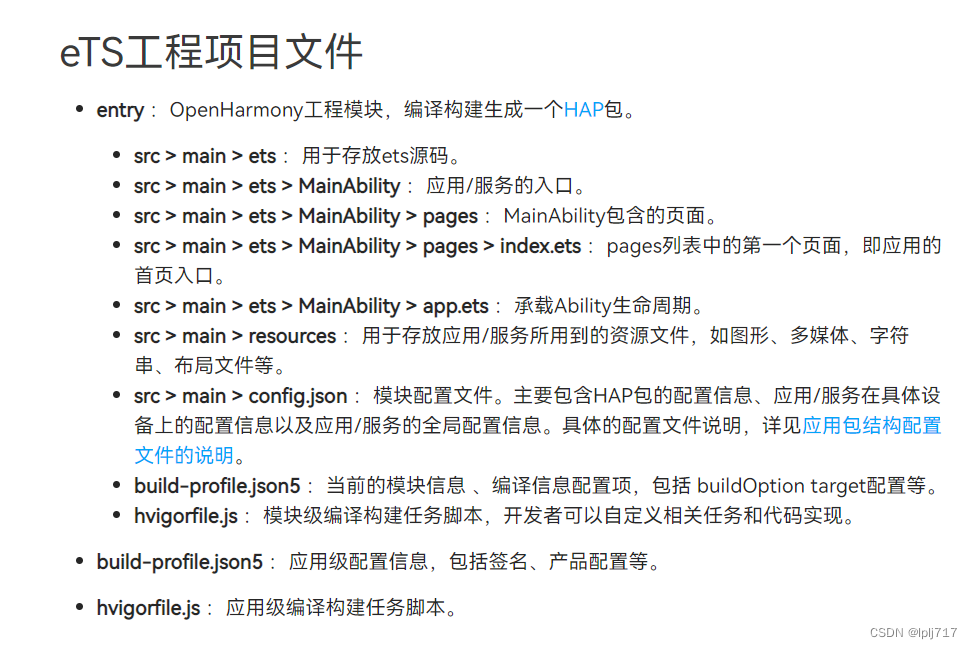

openharmony代码框架初识(2)

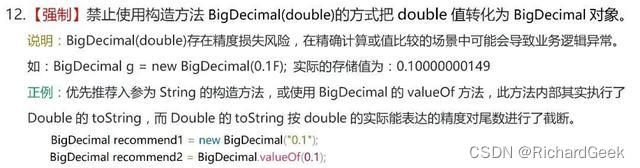

BigDecimal 使用注意!!“别踩坑”

百度智能云重庆工业互联网平台正式亮相,深耕重庆,辐射西南

Orthodontic MIA micro-implant anchorage technology China 10th anniversary exchange meeting was held in Shenyang

量化交易机器人系统开发

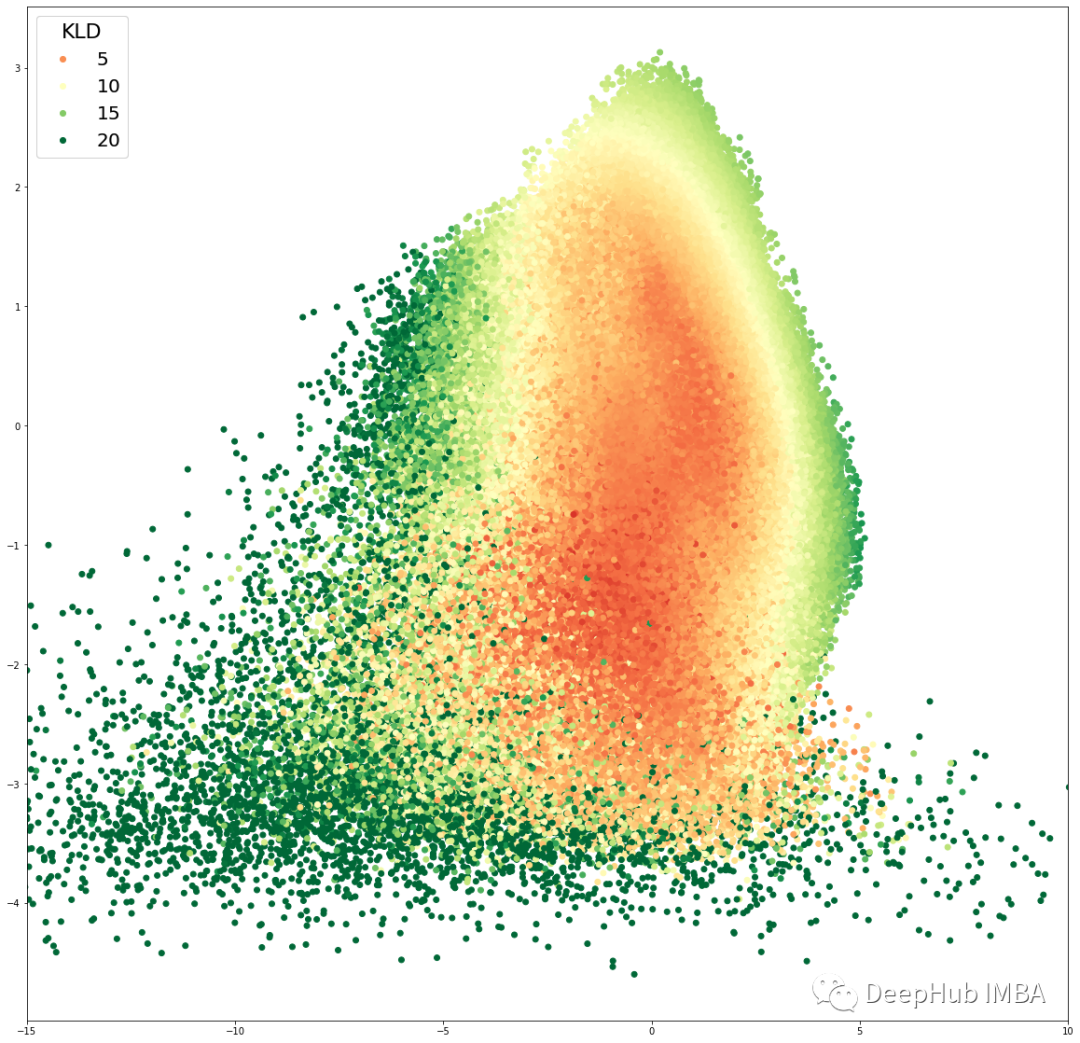

在表格数据集上训练变分自编码器 (VAE)示例

企业应当实施的5个云安全管理策略

Finger Vein Recognition-matlab

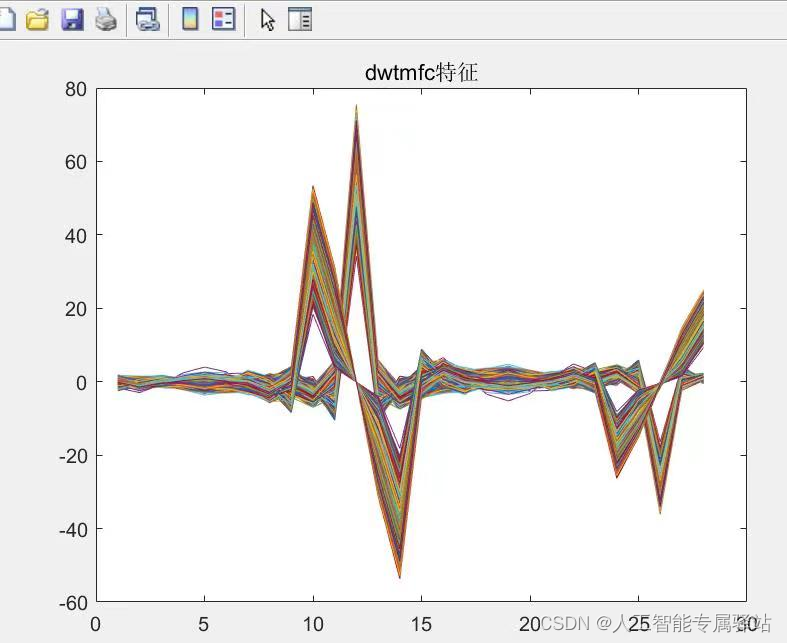

VQ Realization of Wavelet Extraction Features

在线生成接口文档

随机推荐

作业8.3 线程同步互斥机制条件变量

什么是内部客户服务?

MySQL远程备份策略举例

网络运维管理从基础到实战-自用笔记(1)构建综合园区网、接入互联网

哈佛架构 VS 冯·诺依曼架构

[Latest Information] 2 new regions will announce the registration time for the soft exam in the second half of 2022

译文推荐|Apache Pulsar 隔离系列(四):单集群隔离策略

curl命令的那些事

动手学深度学习_VggNet

ros2订阅esp32发布的电池电压数据-补充

入门:人脸专集1 | 级联卷积神经网络用于人脸检测(文末福利)

server

正畸MIA微种植体支抗技术中国10周年交流会在沈举办

Storage resource activation system to help new infrastructure

如何封装 svg

天呐,七夕我收到9份告白~

判断字符串中是否包含中文

关于使用腾讯云HiFlow场景连接器每天提醒签到打卡

JS: 数组和树的相互转换

HCIA-R&S自用笔记(22)STP状态与计时器、STP拓扑变化、STP配置及实验