当前位置:网站首页>基于GPT的隐变量表征解码结构

基于GPT的隐变量表征解码结构

2022-08-02 14:07:00 【3A是个坏同志】

有时候我们想要用GPT(的一部分)作为预训练的隐变量解码器,应该怎么办呢?最近看论文,总结了三种隐变量注入(code injection)的方式。

1. Cheng X , Xu W , Wang T , et al. Variational Semi-Supervised Aspect-Term Sentiment Analysis via Transformer[C]// Proceedings of the 23rd Conference on Computational Natural Language Learning (CoNLL). 2019.

这篇文章用的方法是将隐变量添加到每个输入token中。原文是将每个token表示为隐变量和原嵌入的和,然后使用reconstruction任务微调解码器。

2. Ziegler Z M , Melas-Kyriazi L , Gehrmann S , et al. Encoder-Agnostic Adaptation for Conditional Language Generation[J]. 2019.

这篇文章探索了使自然语言预训练语言模型适应任意条件输入的方法。作者观察到,预训练transformer模型对微调过程中的大参数变化非常敏感。因此提出了一种直接将任意条件(arbitrary conditioning)注入self-attention的适应方法,并称之为pseudo self-attention(伪自注意)。主要思路是在每层基础上注入隐变量。其与其它几种注入结构区别简图如下:

a训练了一个新的transformer解码器;b训练了一个新的context attention layer;伪自注意只修改了self-attention层的一部分(图中绿色表示只使用预训练权重初始化,灰色表示从头训练,红色向量表示每一层的target activation,蓝色向量表示编码器输出的源特征)

具体来讲,作者通过一个线性层将隐变量 投影到

投影到 ,这样就可以将其拆分成L个向量

,这样就可以将其拆分成L个向量![[z_1,......,z_l]](http://img.inotgo.com/imagesLocal/202208/02/202208021402503241_15.gif) 。其中

。其中 被送入第

被送入第 个自注意力block。如下图所示:

个自注意力block。如下图所示:

浅红色为隐变量的键和值

伪自注意可以通过以下方式将隐变量吸收到预训练的GPT2自注意力结构中,对于每个自注意层,有:

为了表示方便,这里的z指的是 (行向量)。其中

(行向量)。其中 为原始的输入嵌入。

为原始的输入嵌入。 和

和 为具有被投影的隐变量

为具有被投影的隐变量 和

和 (来自z(即

(来自z(即 )填充的第一行?)的增广的键和值。

)填充的第一行?)的增广的键和值。 表示按行连接。

表示按行连接。

3. Wang T , Wan X . T-CVAE: Transformer-Based Conditioned Variational Autoencoder for Story Completion[C]// Twenty-Eighth International Joint Conference on Artificial Intelligence (IJCAI-19). 2019.

该文章使用的方法在最后一层注入,文章的模型结构如下图:

在原始GPT2中,来自最后一个注意力层的嵌入向量 通过线性头投影到pre-softmax logit向量

通过线性头投影到pre-softmax logit向量 (V是词表大小)。想在这个时候注入隐变量,需要学习一个新的共享线性头,以便将

(V是词表大小)。想在这个时候注入隐变量,需要学习一个新的共享线性头,以便将 投影到

投影到 。最终把

。最终把 送入softmax。原文中的具体过程为:

送入softmax。原文中的具体过程为:

![C_t=tanh([z,D_{out,t}^{L}]W_c)](http://img.inotgo.com/imagesLocal/202112/07/20211207062637501c_6.gif%3Dtanh%28%5Bz%2CD_%7Bout%2Ct%7D%5E%7BL%7D%5DW_c%29)

其中D为解码器输出, 为参数矩阵,

为参数矩阵, 为合并z与解码器状态的组合层在时间步t上的输出。并进一步馈送到线性头和softmax获得概率分布。

为合并z与解码器状态的组合层在时间步t上的输出。并进一步馈送到线性头和softmax获得概率分布。

扩展阅读:基于预训练语言模型的文本生成研究综述_zenRRan的博客-CSDN博客 第五节,使用预训练语言模型进行文本生成的常用微调策略_3A的奇奇怪怪圣地-CSDN博客

边栏推荐

猜你喜欢

随机推荐

2.RecyclerView基本使用

5.使用RecyclerView优雅的实现瀑布流效果

LLVM系列第六章:函数返回值Return

两个surfaceview的重叠效果类似直播效果中的视频和讲义实践

OpenCart迁移到其他服务器

Scala学习总结

AAPT: error: duplicate value for resource ‘attr/xxx‘ with config ‘‘, file failed to compile.

getUserProfile接口不显示用户性别和地区

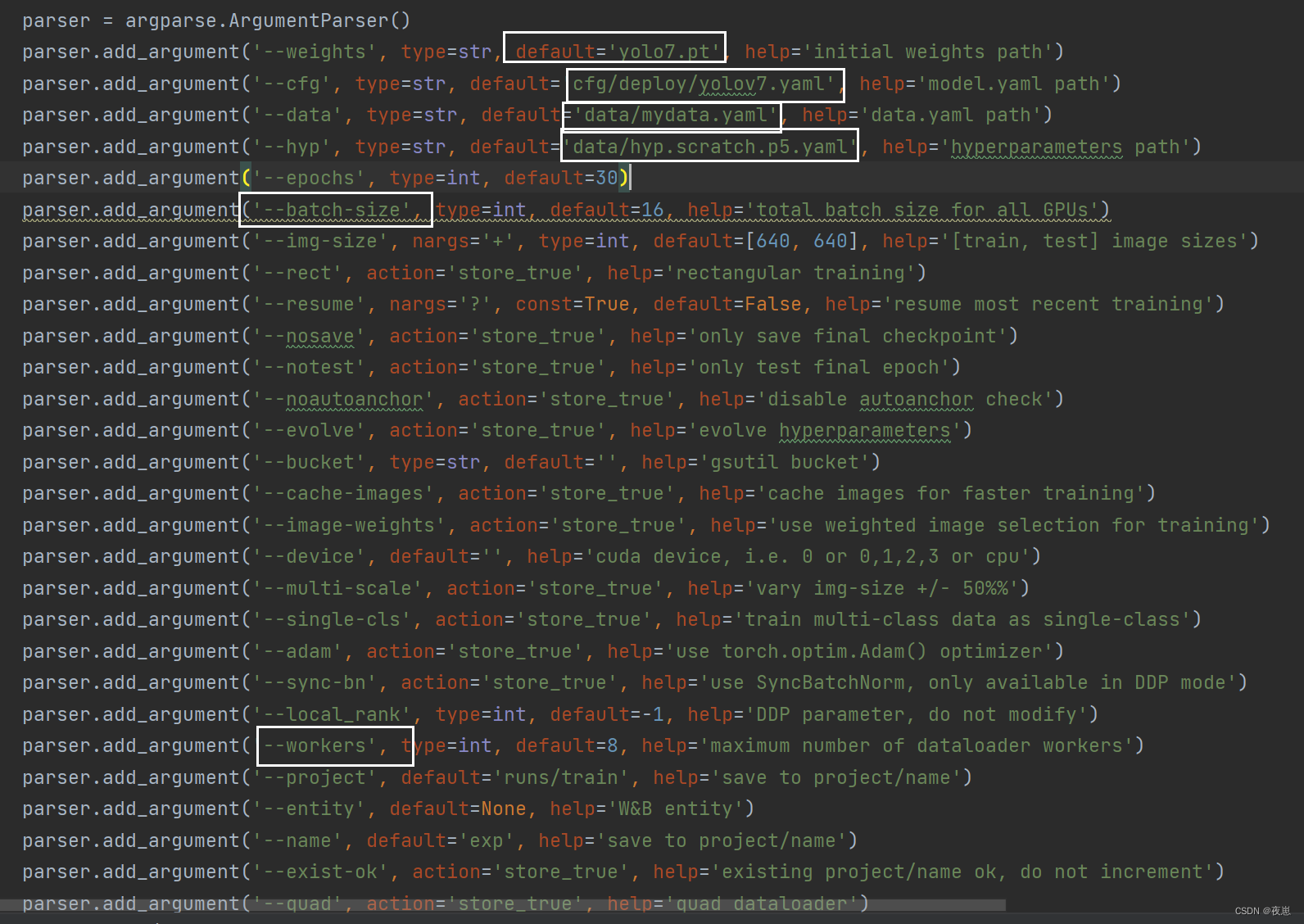

记录Yolo-tiny-v4的权重提取和中间层结果提取

RN开发时遇到的问题

VS Code远程开发及免密配置

MySQL知识总结 (二) 存储引擎

Kubernetes介绍

St. Regis Takeaway Notes - Lecture 05 Getting Started with Redis

浮点数的运算方法

spark资源调度和任务调度

什么是 Web 3.0:面向未来的去中心化互联网

文本匹配任务

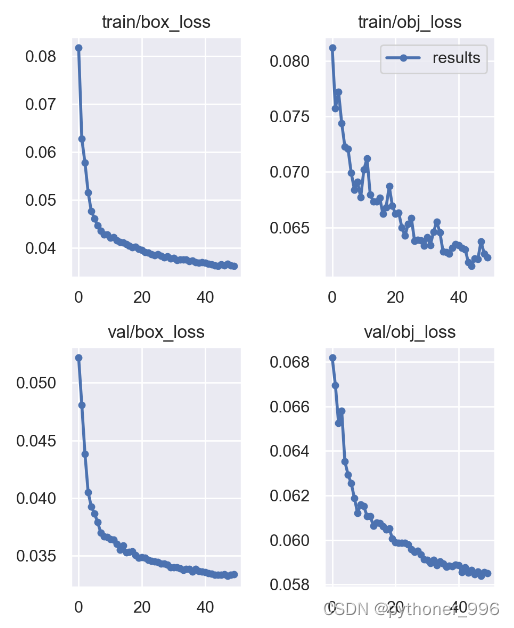

【目标检测】YOLO v5 吸烟行为识别检测

MapReduce流程