当前位置:网站首页>评估方法的优缺点

评估方法的优缺点

2022-07-06 09:11:00 【一曲无痕奈何】

1、过拟合:当学习器把训练样本学的太好,很可能把已经训练的样本特点当做了所有潜在样本都会有的一般性质,这样就会导致泛华能力下降(泛化能力指学习的模型应用在未知的样本中的能力)。

2、欠拟合:指学习能力低下,认为很一般的特点都是所有的特点。

评估方法:

- 留出法:若训练集包含绝大多数样本,则训练出的样本可能就接近想要的训练模型,但是由于测试集较小,评估结果可能就不够准确,基本划分的数据集的模式:2:1,4:1前面分别用做训练,后面的用作测试。

- 交叉验证法:等分,分层采样,取均值,缺陷则是:在数据集较大开销太大,花费时间较多。

- 自助法:循环从整体数据中取放进样例中,又放回的抽取,最终初始数据有0.368的样本未出现,用于测试。自助法能从初始数据集中出现的样本用于测试,这样的测试也称为包外估计。优点:自助法在数据集较小,难以有效划分训练\测试集时候很有用,能从初始数据集中产生多个不同的训练集,缺点:但是改变了数据集分布,这会引入估计偏差。

但是在初始数据量足够时候,留出法和交叉验证法更常用。

调参与最终参数模型:

调参的一般准则:对每个参数选定一个范围和一个变化的步长,这是这是在计算开销与性能的折中方案。

性能度量:衡量模型泛华能力的度量,性能不仅取决于算法和数据,还决定任务需求。

回归任务最常用的性能度量:均方误差。

查全率 (TP/(TP+FN))、查准率(TP/(TP+FP)):TP真正例 FP假正例 TN真反例 FN假反例。

F1是基于查全率与查准率的调和平均定义的:2*TP/(样例总数+TP-TN)

ROC:受试工作特征。 横轴TPR(真正例)=TP/(TP+FN),纵轴FPR(假正例):FP/(TN+FP)。

规范化:将不同变化范围的值映射到相同固定范围内,常见的是[0,1],也称归一化。

偏差:期望输出与真实标记的差别,刻画学习算法本身的拟合能力。

泛化误差可分解为偏差、方差(度量了同样大小训练集的变动所导致的学习性能的变化吗,刻画了数据扰动所造成的影响)、与噪声(表达了在当前任务上任何学习算法所能达到的期望泛化误差的下界)之和。

边栏推荐

- MySQL real battle optimization expert 11 starts with the addition, deletion and modification of data. Review the status of buffer pool in the database

- Random notes

- 17 medical registration system_ [wechat Payment]

- CAPL script pair High level operation of INI configuration file

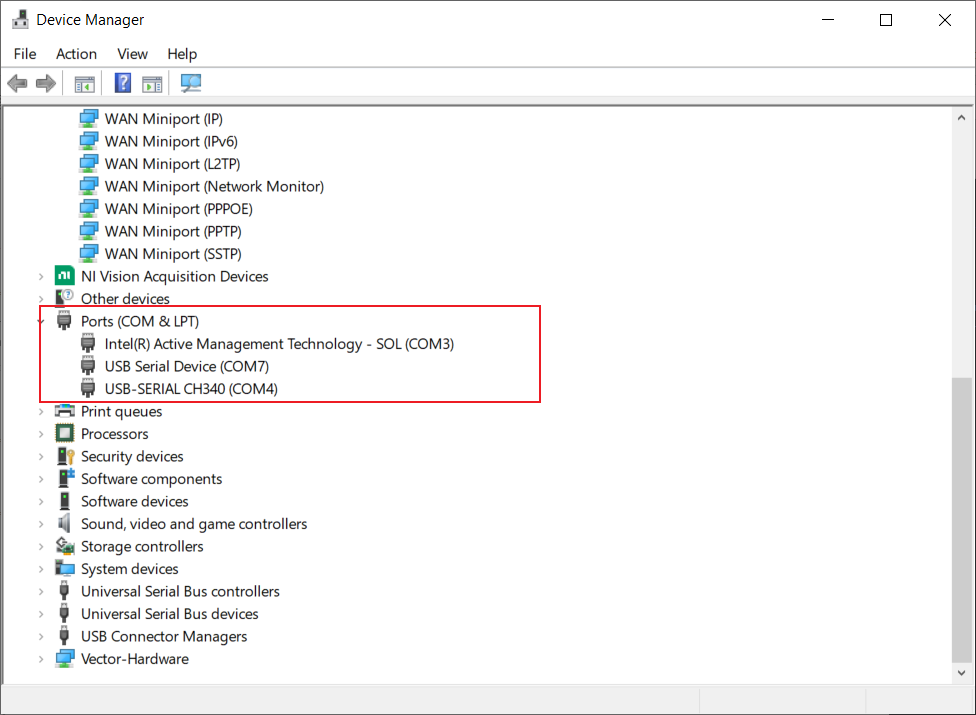

- Canoe cannot automatically identify serial port number? Then encapsulate a DLL so that it must work

- Not registered via @enableconfigurationproperties, marked (@configurationproperties use)

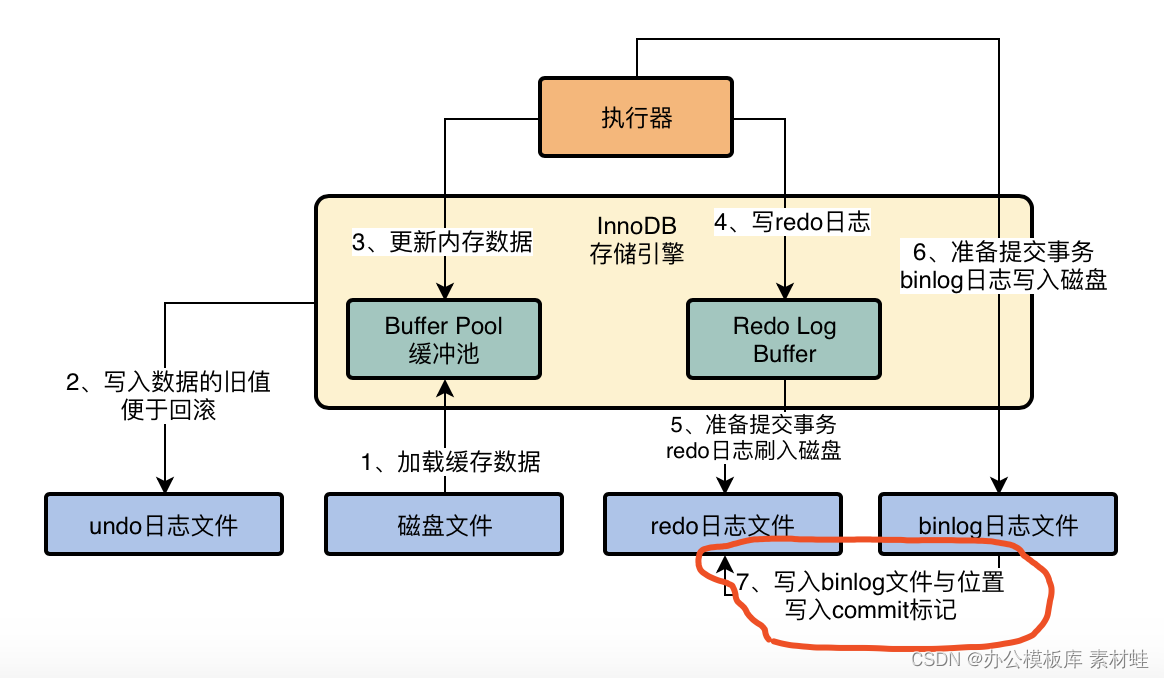

- MySQL Real Time Optimization Master 04 discute de ce qu'est binlog en mettant à jour le processus d'exécution des déclarations dans le moteur de stockage InnoDB.

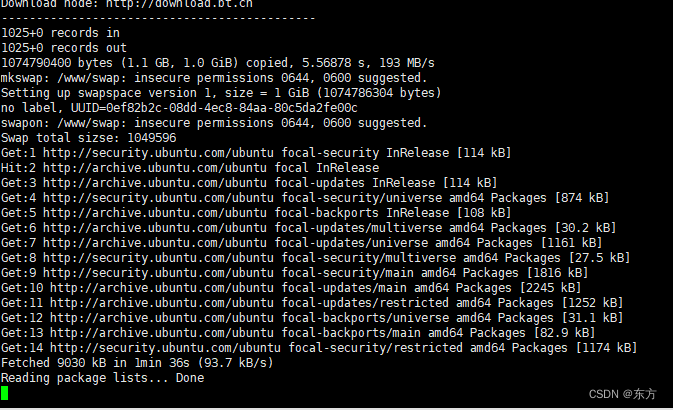

- Installation de la pagode et déploiement du projet flask

- MySQL storage engine

- History of object recognition

猜你喜欢

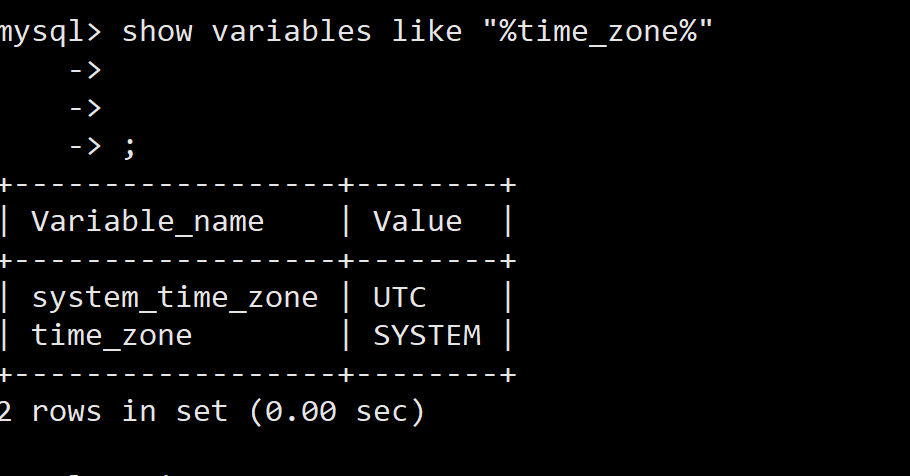

Docker MySQL solves time zone problems

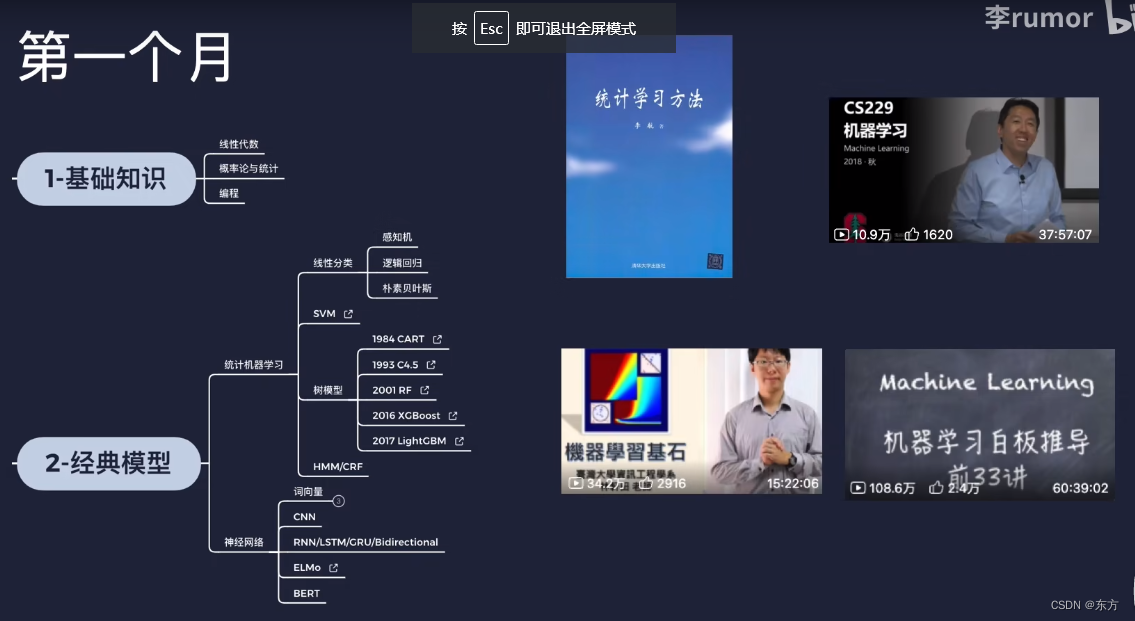

AI的路线和资源

Canoe cannot automatically identify serial port number? Then encapsulate a DLL so that it must work

![[one click] it only takes 30s to build a blog with one click - QT graphical tool](/img/f0/52e1ea33a5abfce24c4a33d107ea05.jpg)

[one click] it only takes 30s to build a blog with one click - QT graphical tool

寶塔的安裝和flask項目部署

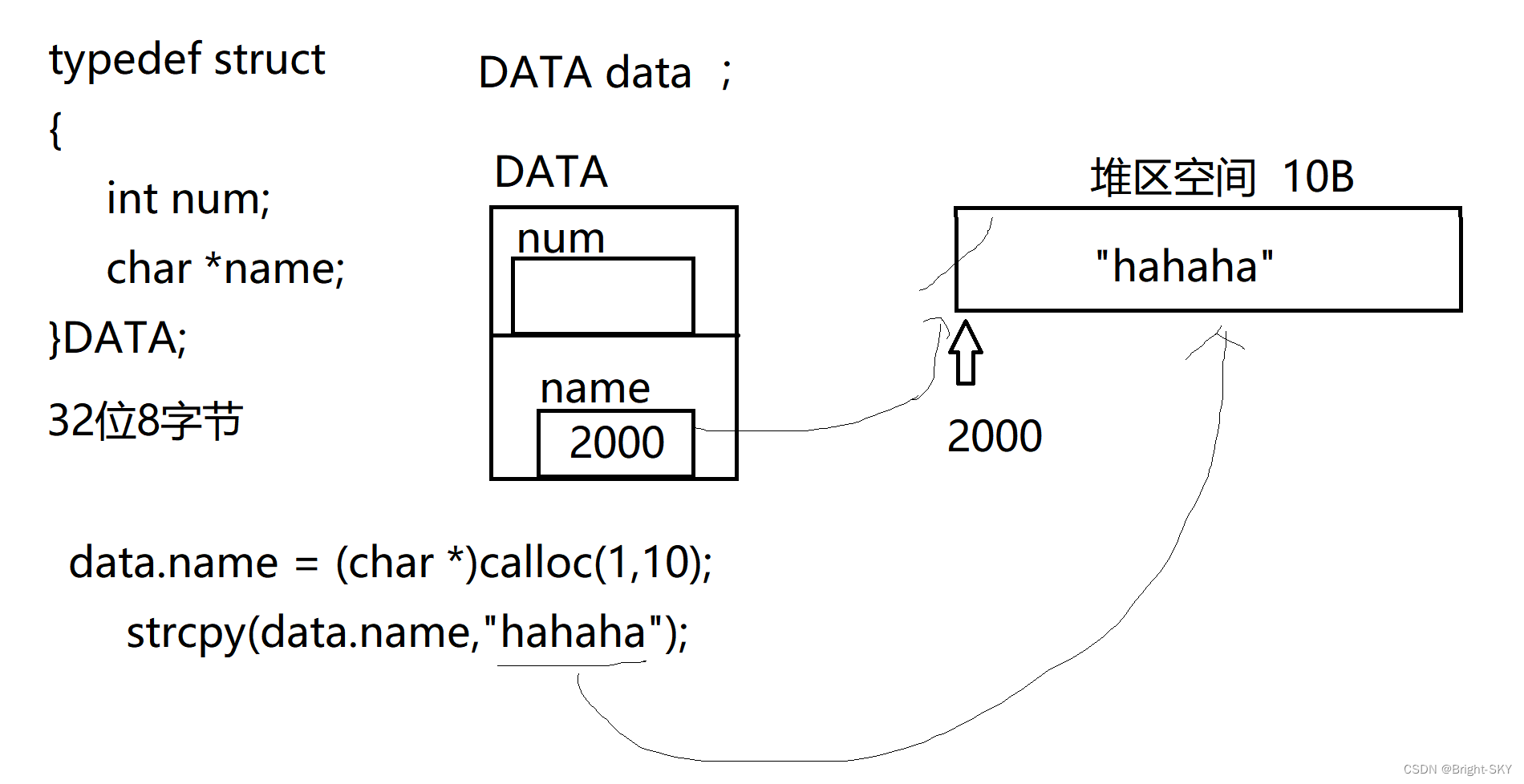

C杂讲 浅拷贝 与 深拷贝

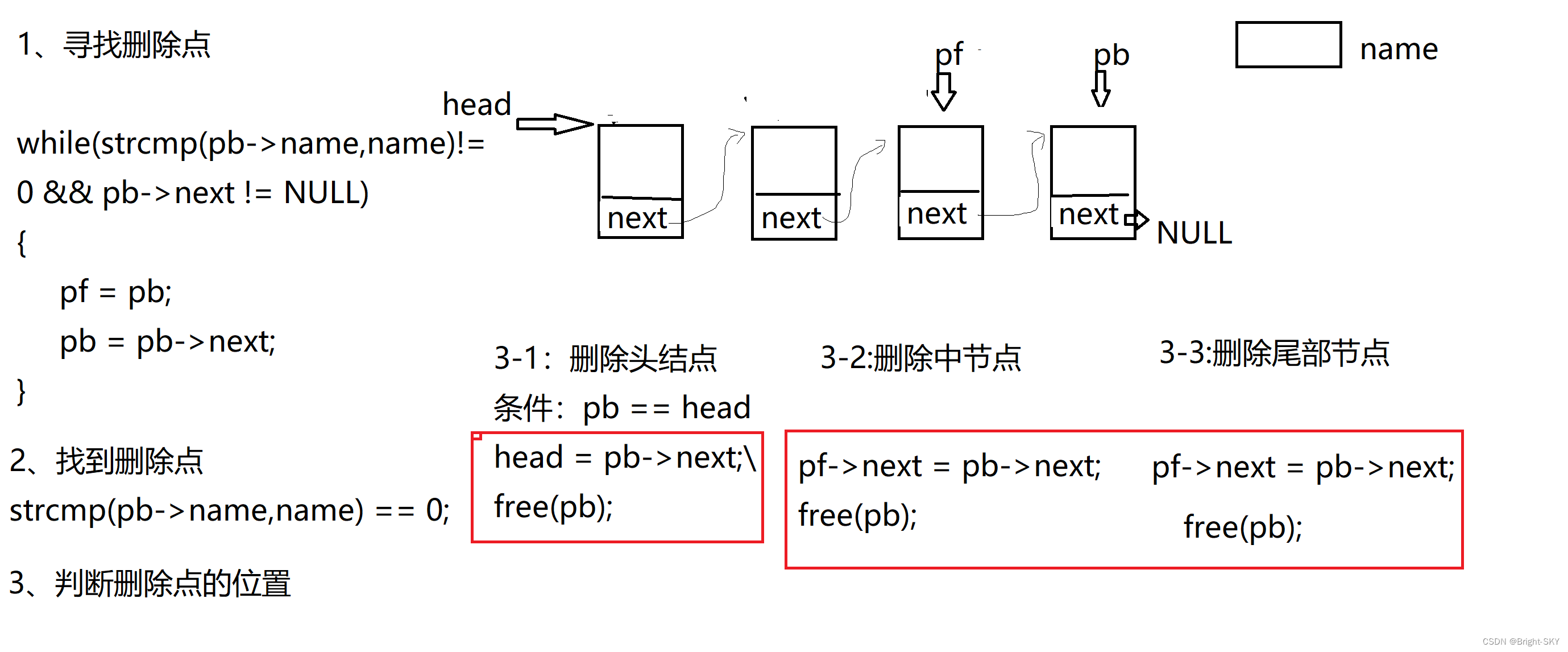

C miscellaneous dynamic linked list operation

实现微信公众号H5消息推送的超级详细步骤

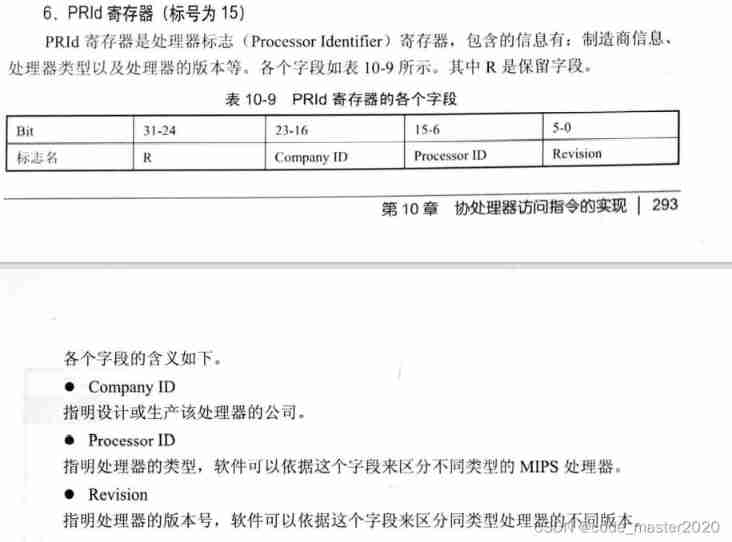

Write your own CPU Chapter 10 - learning notes

MySQL实战优化高手04 借着更新语句在InnoDB存储引擎中的执行流程,聊聊binlog是什么?

随机推荐

Const decorated member function problem

Competition vscode Configuration Guide

Tianmu MVC audit I

MySQL实战优化高手11 从数据的增删改开始讲起,回顾一下Buffer Pool在数据库里的地位

实现微信公众号H5消息推送的超级详细步骤

Super detailed steps for pushing wechat official account H5 messages

jar运行报错no main manifest attribute

How to make shell script executable

MySQL实战优化高手06 生产经验:互联网公司的生产环境数据库是如何进行性能测试的?

Download and installation of QT Creator

MySQL实战优化高手02 为了执行SQL语句,你知道MySQL用了什么样的架构设计吗?

Hugo blog graphical writing tool -- QT practice

History of object recognition

Software test engineer development planning route

Ueeditor internationalization configuration, supporting Chinese and English switching

docker MySQL解决时区问题

Some thoughts on the study of 51 single chip microcomputer

Solution to the problem of cross domain inaccessibility of Chrome browser

MySQL实战优化高手08 生产经验:在数据库的压测过程中,如何360度无死角观察机器性能?

Compress decompress