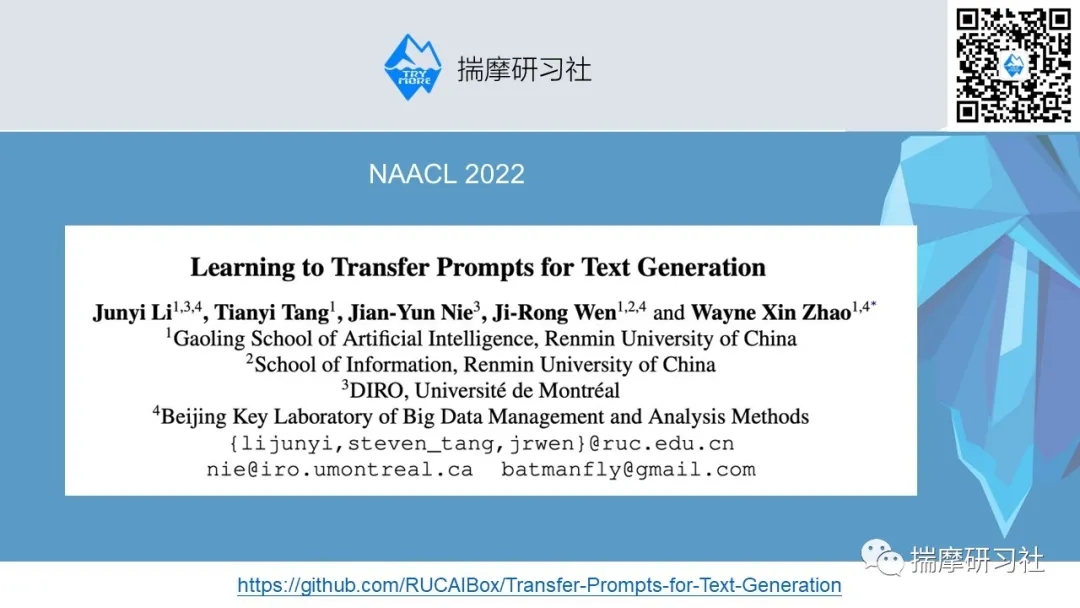

当前位置:网站首页>NAACL-22 | 在基于Prompt的文本生成任务上引入迁移学习的设置

NAACL-22 | 在基于Prompt的文本生成任务上引入迁移学习的设置

2022-07-04 21:33:00 【智源社区】

预训练语言模型通过微调的方式在文本生成任务中取得了显著的进展,但是在数据稀疏的场景下,通常无法直接进行微调。因此,本文提出基于prompt的迁移学习的设定。作者先为源领域上的不同任务分别学习一个prompt,从而构造prompt池,然后在目标任务进行迁移。为了同时考虑任务层面和实例层面的信息,作者设计了一个自适应的注意力机制,对于目标任务中的每个实例样本,模型都会为其选择与其最相关的源任务的prompt。作者在多种生成任务和数据集上进行了实验,结果表明作者提出的迁移方法可以很好地提高目标任务上的生成效果。

论文标题:

Learning to Transfer Prompts for Text Generation

论文链接:

https://arxiv.org/abs/2205.01543

边栏推荐

- Solve the problem of data disorder caused by slow asynchronous interface

- 股票开户流程是什么?使用同花顺手机炒股软件安全吗?

- Shutter WebView example

- TCP三次握手,四次挥手,你真的了解吗?

- 解析互联网时代的创客教育技术

- Representation of confidence interval

- HDU - 1078 FatMouse and Cheese(记忆化搜索DP)

- VS2019 C# release下断点调试

- Jerry's ad series MIDI function description [chapter]

- 股票开户佣金最低多少,炒股开户佣金最低网上开户安全吗

猜你喜欢

随机推荐

Delphi soap WebService server-side multiple soapdatamodules implement the same interface method, interface inheritance

gtest从一无所知到熟练使用(3)什么是test suite和test case

Numpy vstack and column_ stack

[ 每周译Go ] 《How to Code in Go》系列文章上线了!!

开户哪家券商比较好?网上开户安全吗

Flutter WebView示例

QT—双缓冲绘图

一文掌握数仓中auto analyze的使用

类方法和类变量的使用

MongoDB中的索引操作总结

Enlightenment of maker thinking in Higher Education

【C語言】符號的深度理解

Kubedm initialization error: [error cri]: container runtime is not running

Three or two things about the actual combat of OMS system

Spatiotemporal prediction 3-graph transformer

LambdaQueryWrapper用法

EhLib 数据库记录的下拉选择

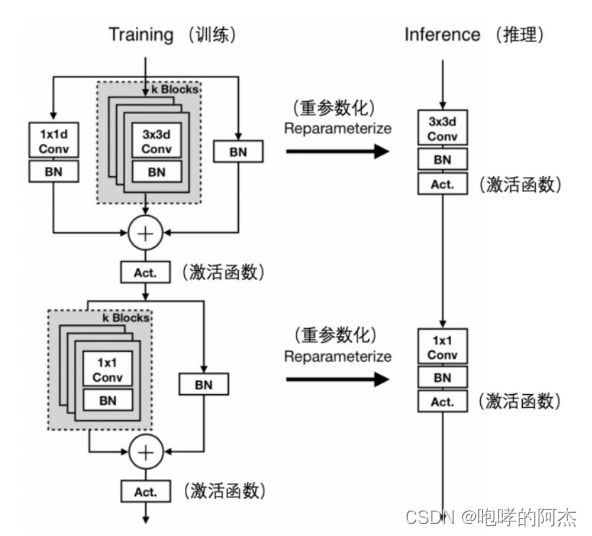

From repvgg to mobileone, including mobileone code

历史最全混合专家(MOE)模型相关精选论文、系统、应用整理分享

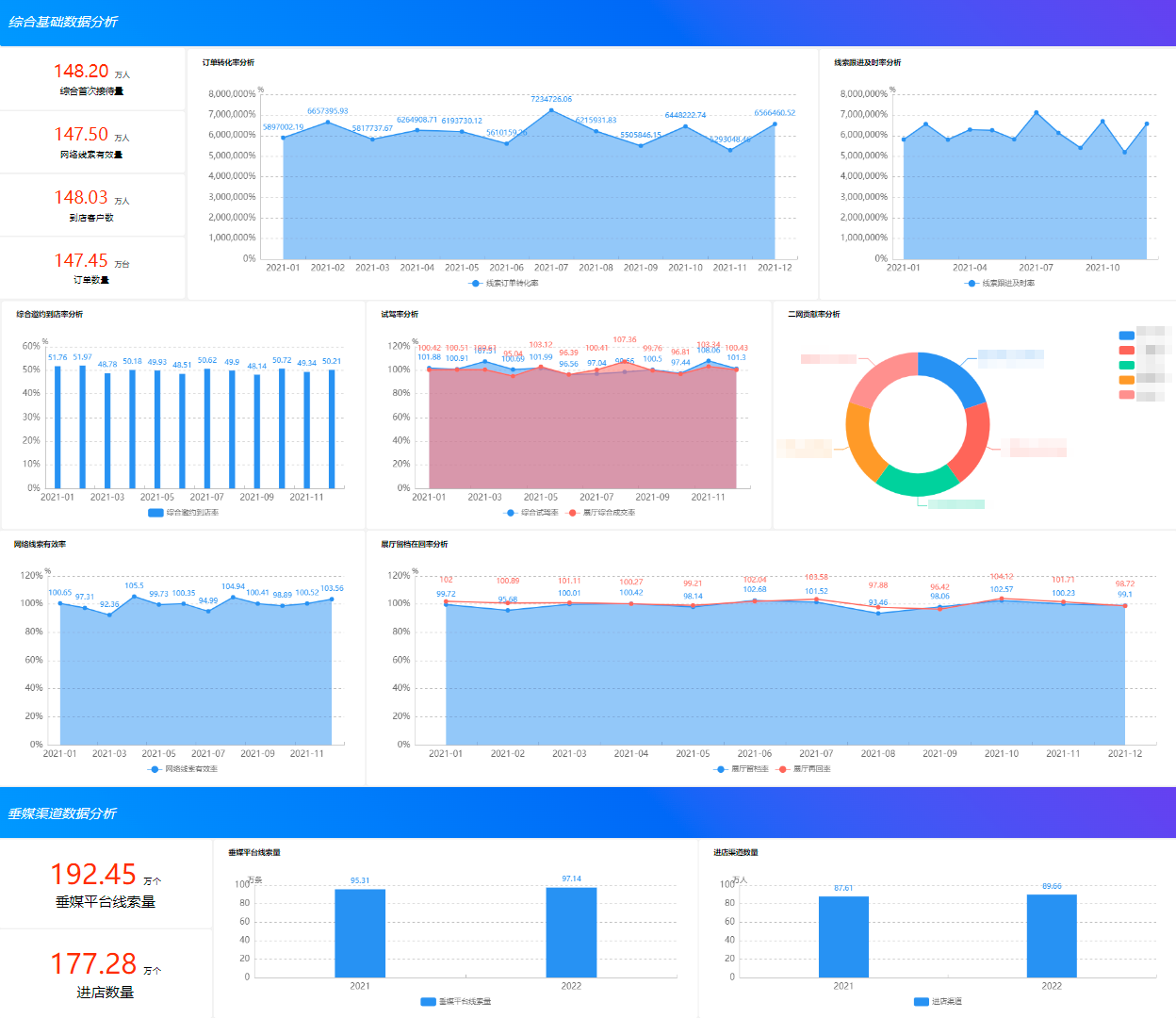

Bizchart+slider to realize grouping histogram