当前位置:网站首页>云原生(三十二) | Kubernetes篇之平台存储系统介绍

云原生(三十二) | Kubernetes篇之平台存储系统介绍

2022-07-06 15:39:00 【Lansonli】

文章目录

Kubernetes平台存储系统介绍

存储系统是个专业性的整个体系,我们只用常见方式搭建,具体优化需要参照公司自己的产品等各种进行调整

一、Ceph

官方网址:https://ceph.io/

1、基本概念

Ceph可以有

Ceph对象存储:键值存储,其接口就是简单的GET,PUT,DEL等。如七牛,阿里云oss等

Ceph块设备:AWS的EBS,青云的云硬盘和阿里云的盘古系统,还有Ceph的RBD(RBD是Ceph面向块存储的接口)

Ceph文件系统:它比块存储具有更丰富的接口,需要考虑目录、文件属性等支持,实现一个支持并行化的文件存储应该是最困难的。

一个Ceph存储集群需要

至少一个Ceph监视器、Ceph管理器、Ceph OSD(对象存储守护程序)

需要运行Ceph文件系统客户端,则需要部署 Ceph Metadata Server。

Monitors: Ceph Monitor (

ceph-mon) 监视器:维护集群状态信息维护集群状态的映射,包括监视器映射,管理器映射,OSD映射,MDS映射和CRUSH映射。

这些映射是Ceph守护程序相互协调所必需的关键群集状态。

监视器还负责管理守护程序和客户端之间的身份验证。

通常至少需要三个监视器才能实现冗余和高可用性。

Managers: Ceph Manager 守护进程(

ceph-mgr) : 负责跟踪运行时指标和Ceph集群的当前状态Ceph Manager守护进程(ceph-mgr)负责跟踪运行时指标和Ceph集群的当前状态

包括存储利用率,当前性能指标和系统负载。

Ceph Manager守护程序还托管基于python的模块,以管理和公开Ceph集群信息,包括基于Web的Ceph Dashboard和REST API。

通常,至少需要两个管理器才能实现高可用性。

Ceph OSDs: Ceph OSD (对象存储守护进程,

ceph-osd) 【存储数据】通过检查其他Ceph OSD守护程序的心跳来存储数据,处理数据复制,恢复,重新平衡,并向Ceph监视器和管理器提供一些监视信息。

通常至少需要3个Ceph OSD才能实现冗余和高可用性。

MDSs: Ceph Metadata Server (MDS,

ceph-mdsceph元数据服务器)存储能代表 Ceph File System 的元数据(如:Ceph块设备和Ceph对象存储不使用MDS).

Ceph元数据服务器允许POSIX文件系统用户执行基本命令(如ls,find等),而不会给Ceph存储集群带来巨大负担

二、Rook

1、基本概念

Rook是云原生平台的存储编排工具

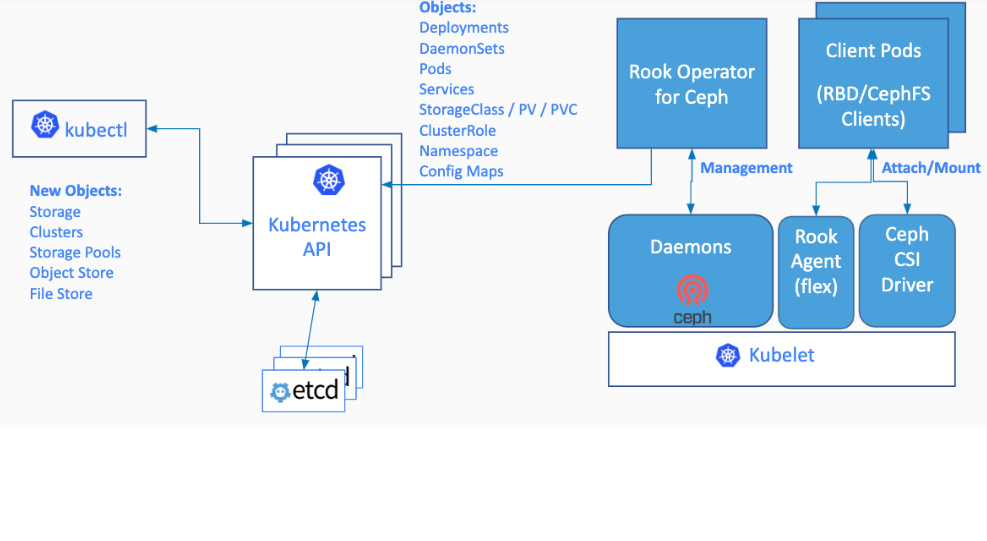

Rook工作原理如下:

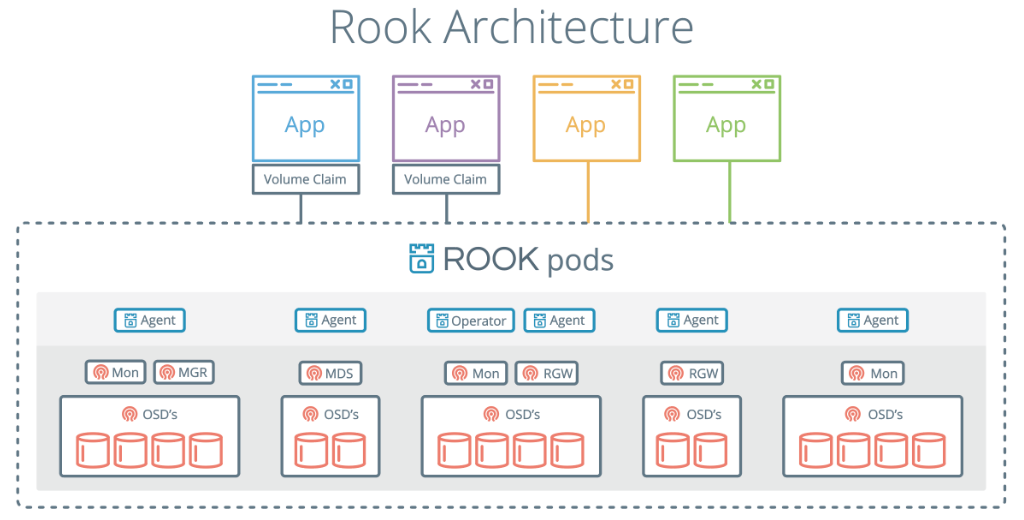

Rook架构如下

RGW:为Restapi Gateway

2、operator是什么

k8s中operator+CRD(CustomResourceDefinitions【k8s自定义资源类型】),可以快速帮我们部署一些有状态应用集群,如redis,mysql,Zookeeper等。

Rook的operator是我们k8s集群和存储集群之间进行交互的解析器

CRD:CustomResourceDefinitions (自定义资源);如:Itdachang

operator:这个能处理自定义资源类型

- 博客主页:https://lansonli.blog.csdn.net

- 欢迎点赞 收藏 留言 如有错误敬请指正!

- 本文由 Lansonli 原创,首发于 CSDN博客

- 停下休息的时候不要忘了别人还在奔跑,希望大家抓紧时间学习,全力奔赴更美好的生活

边栏推荐

- Redis persistence mechanism

- ICLR 2022 | pre training language model based on anti self attention mechanism

- How to use flexible arrays?

- Traversal of a tree in first order, middle order, and then order

- C three ways to realize socket data reception

- Aardio - Method of batch processing attributes and callback functions when encapsulating Libraries

- memcached

- asp读取oracle数据库问题

- 安全保护能力是什么意思?等保不同级别保护能力分别是怎样?

- 第十九章 使用工作队列管理器(二)

猜你喜欢

MySQL中正则表达式(REGEXP)使用详解

Aardio - does not declare the method of directly passing float values

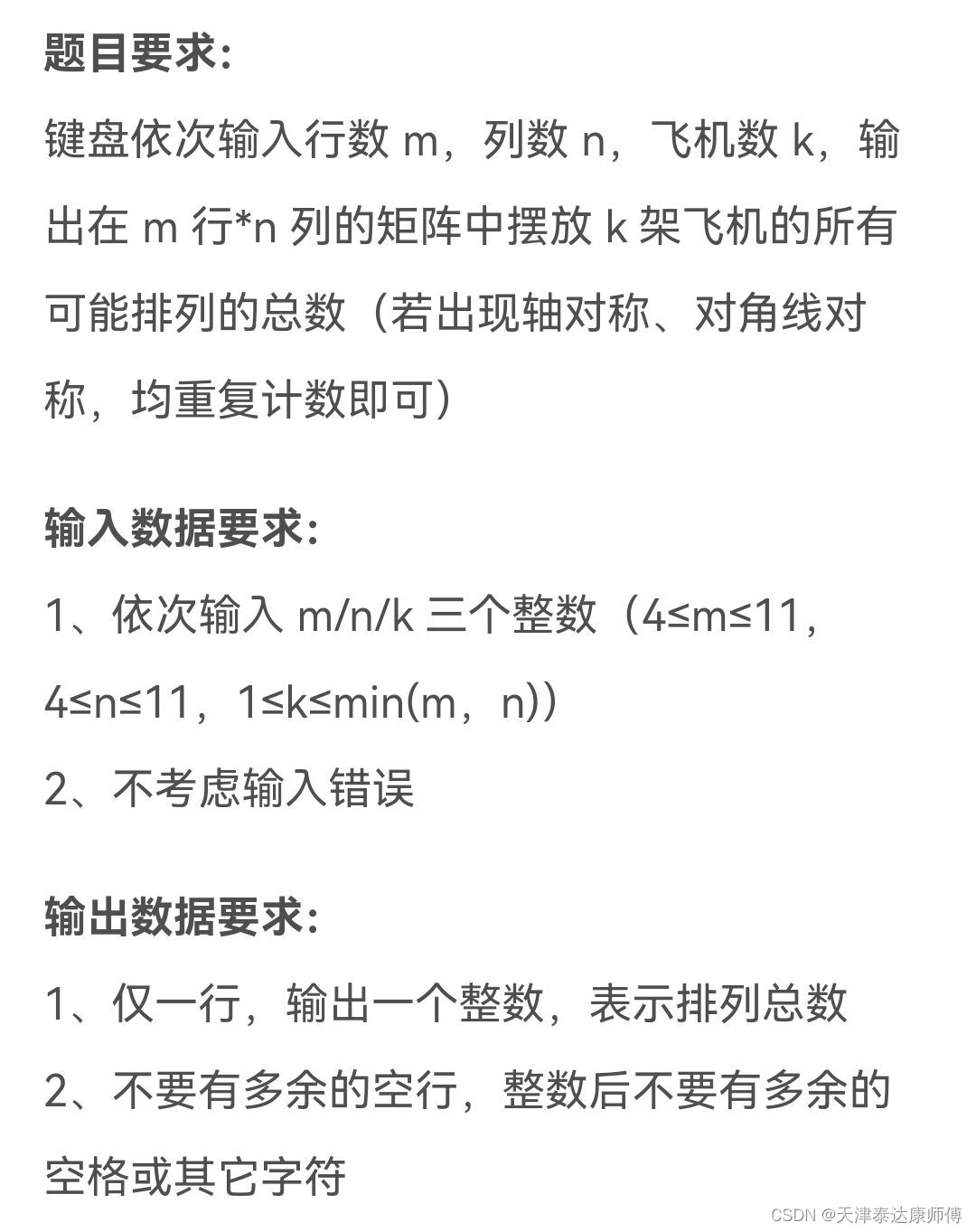

机试刷题1

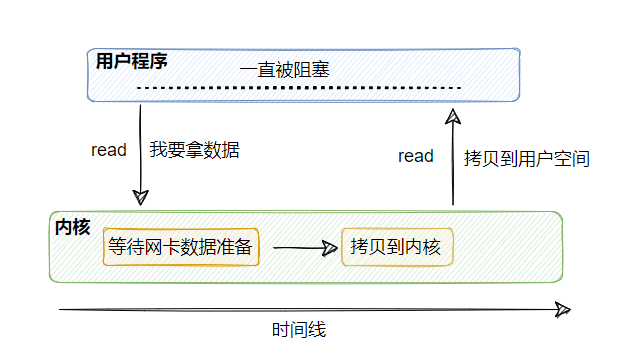

让我们,从头到尾,通透网络I/O模型

dockermysql修改root账号密码并赋予权限

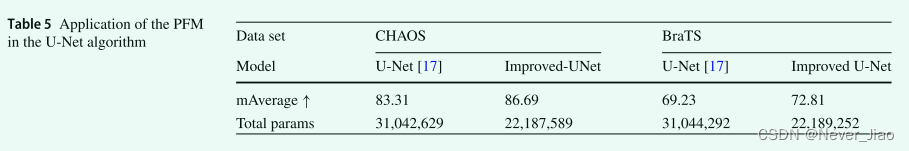

DR-Net: dual-rotation network with feature map enhancement for medical image segmentation

Slide the uniapp to a certain height and fix an element to the top effect demo (organize)

![[compilation principle] LR (0) analyzer half done](/img/ec/b13913b5d5c5a63980293f219639a4.png)

[compilation principle] LR (0) analyzer half done

uniapp滑动到一定的高度后固定某个元素到顶部效果demo(整理)

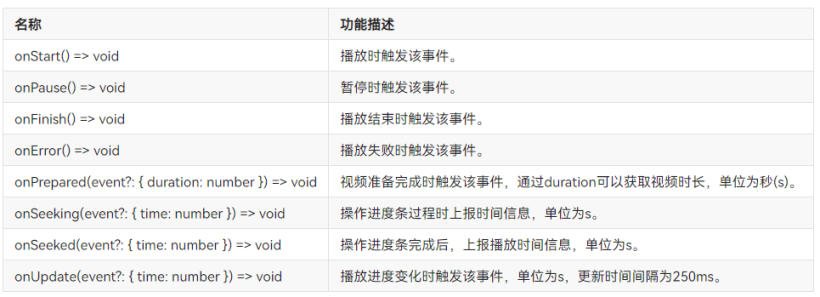

Dayu200 experience officer homepage AITO video & Canvas drawing dashboard (ETS)

随机推荐

DR-Net: dual-rotation network with feature map enhancement for medical image segmentation

(shuttle) navigation return interception: willpopscope

安全保护能力是什么意思?等保不同级别保护能力分别是怎样?

Jafka source analysis processor

Use ECs to set up an agent

How big is the empty structure?

What can be done for traffic safety?

Let's see through the network i/o model from beginning to end

How to confirm the storage mode of the current system by program?

ICLR 2022 | pre training language model based on anti self attention mechanism

Aardio - integrate variable values into a string of text through variable names

【全网首发】Redis系列3:高可用之主从架构的

(flutter2) as import old project error: inheritfromwidgetofexacttype

UVa 11732 – strcmp() Anyone?

动作捕捉用于蛇运动分析及蛇形机器人开发

The application of machine learning in software testing

[compilation principle] LR (0) analyzer half done

C three ways to realize socket data reception

Financial professionals must read book series 6: equity investment (based on the outline and framework of the CFA exam)

为了交通安全,可以做些什么?