当前位置:网站首页>spark调优(一):从hql转向代码

spark调优(一):从hql转向代码

2022-07-05 10:58:00 【InfoQ】

1. 起因

SELECT id,name,

max(score1),

sum(score2),

avg(score3)

FROM table

GROUP BY id,name

snappy压缩,原始数据500G

280亿条数据

第一步Shuffle Write 800G

接下来的任务预估需要8个小时跑完

2.优化开始

--conf spark.storage.memoryFraction=0.7

--conf spark.executor.heartbeatInterval=240

--conf spark.locality.wait=60

-XX:+UseG1GC

dataset.repartition(20000)

3. 问题解决

Dataset<Row> ds = spark.sql(sql);

dsTag0200.javaRDD().mapPartitionsToPair(

数据转型

分组当key做成tuple2

此处我缓存了一些需要后面聚合的差值

).reduceByKey(

判断最大最小

sum的聚合操作使用差值直接聚合

一遍就可以直接输出最终结果

)

4 总结

结束语

边栏推荐

- DDRx寻址原理

- Dspic33ep clock initialization program

- Taro advanced

- Detailed explanation of DDR4 hardware schematic design

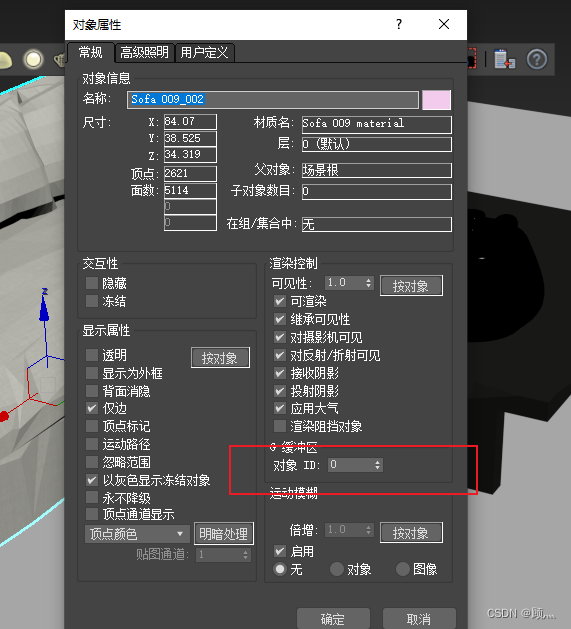

- About the use of Vray 5.2 (self research notes)

- msfconsole命令大全,以及使用说明

- 32:第三章:开发通行证服务:15:浏览器存储介质,简介;(cookie,Session Storage,Local Storage)

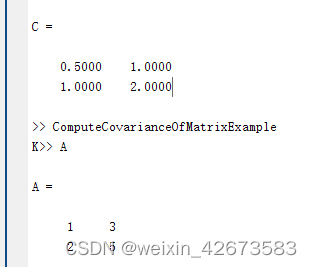

- Detailed explanation of MATLAB cov function

- SQL Server monitoring statistics blocking script information

- 关于vray5.2怎么关闭日志窗口

猜你喜欢

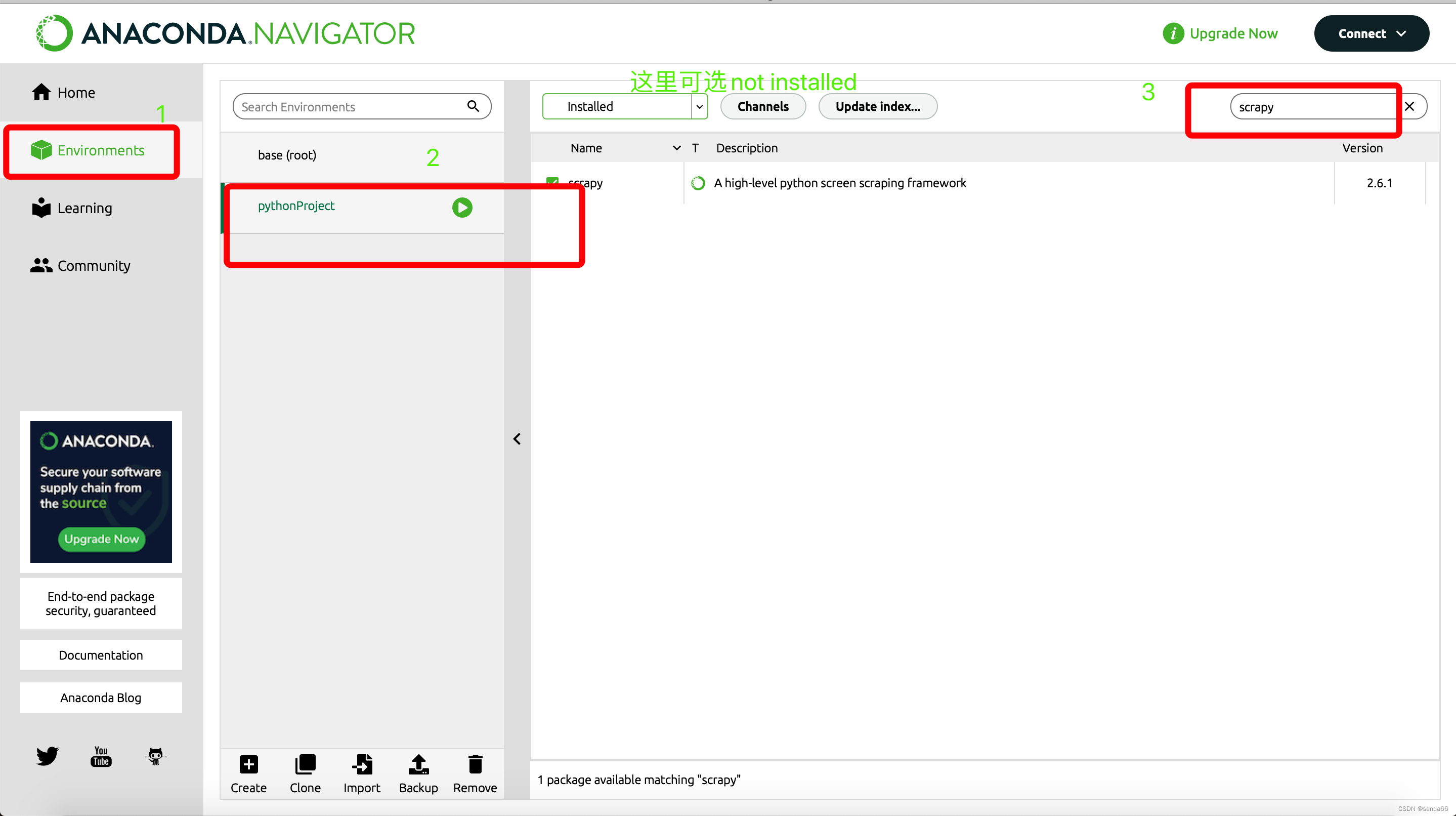

Modulenotfounderror: no module named 'scratch' ultimate solution

关于vray 5.2的使用(自研笔记)

如何让全彩LED显示屏更加节能环保

Basic testing process of CSDN Software Testing Introduction

Lombok 同时使⽤@Data和@Builder 的坑,你中招没?

Go-3-第一个Go程序

关于vray 5.2的使用(自研笔记)(二)

matlab cov函数详解

![[advertising system] parameter server distributed training](/img/8b/558c2fefbd16b580546003f3afeaf5.png)

[advertising system] parameter server distributed training

2022 mobile crane driver examination question bank and simulation examination

随机推荐

谈谈对Flink框架中容错机制及状态的一致性的理解

DOM//

Data types ntext and varchar are incompatible in the not equal to operator - 95 small pang

Beego cross domain problem solution - successful trial

九、磁盘管理

Leetcode 185 All employees with the top three highest wages in the Department (July 4, 2022)

小红书自研KV存储架构如何实现万亿量级存储与跨云多活

A mining of edu certificate station

Codeforces Round #804 (Div. 2)

基于昇腾AI丨以萨技术推出视频图像全目标结构化解决方案,达到业界领先水平

Basic testing process of CSDN Software Testing Introduction

Cron表达式(七子表达式)

How to close the log window in vray5.2

Dspic33ep clock initialization program

PWA (Progressive Web App)

C language current savings account management system

力扣(LeetCode)185. 部门工资前三高的所有员工(2022.07.04)

赛克瑞浦动力电池首台产品正式下线

websocket

四部门:从即日起至10月底开展燃气安全“百日行动”