当前位置:网站首页>6.Dropout应用

6.Dropout应用

2022-07-07 23:12:00 【booze-J】

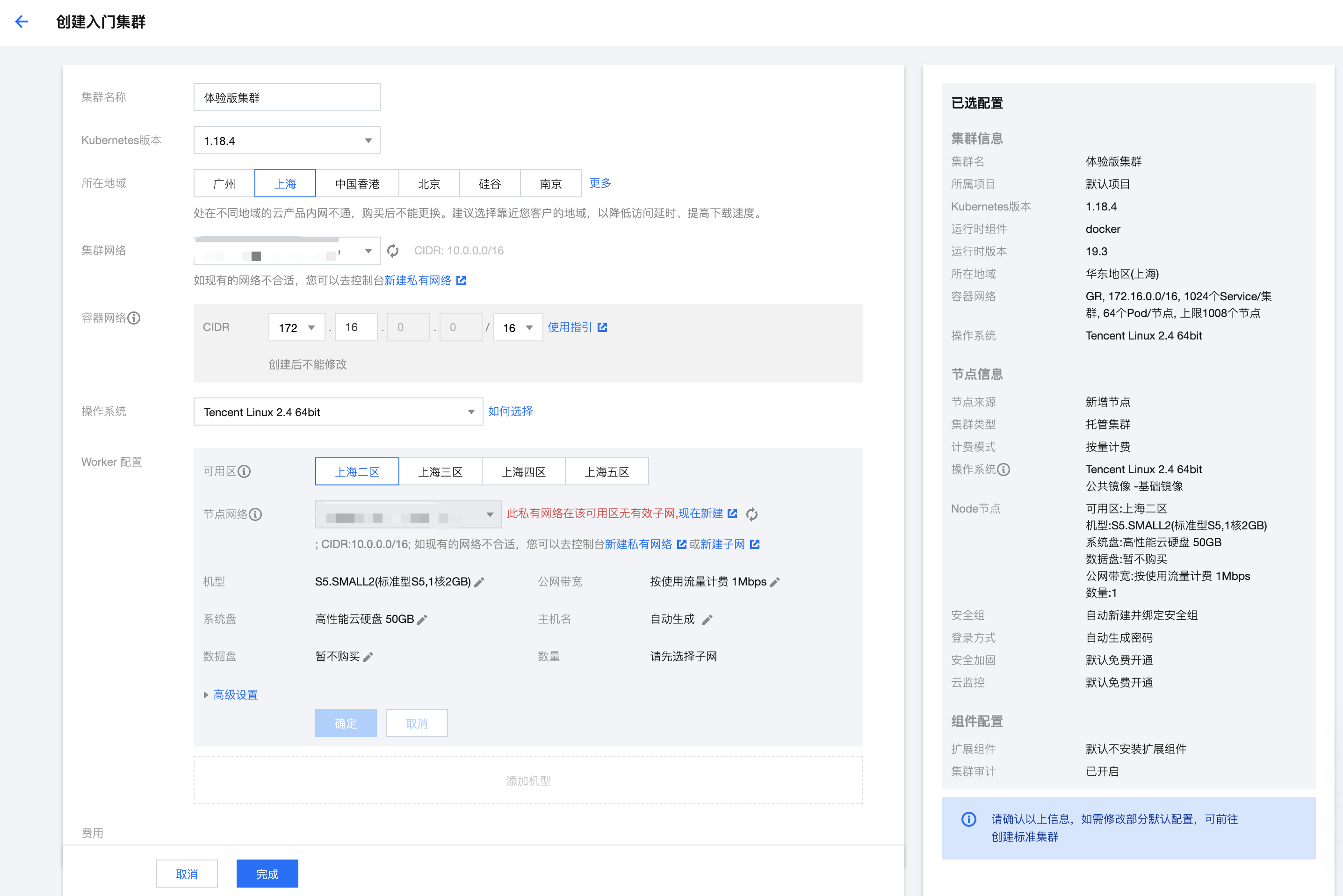

一、未使用Dropout的正常情况下

在4.交叉熵的代码的网络模型构建中添加一些隐藏层,并且输出训练集的损失和准确率。

将4.交叉熵中的

# 创建模型 输入784个神经元,输出10个神经元

model = Sequential([

# 定义输出是10 输入是784,设置偏置为1,添加softmax激活函数

Dense(units=10,input_dim=784,bias_initializer='one',activation="softmax"),

])

添加隐藏层修改为:

# 创建模型 输入784个神经元,输出10个神经元

model = Sequential([

# 定义输出是200 输入是784,设置偏置为1,添加softmax激活函数 第一个隐藏层有200个神经元

Dense(units=200,input_dim=784,bias_initializer='one',activation="tanh"),

# 第二个隐藏层有 100个神经元

Dense(units=100,bias_initializer='one',activation="tanh"),

Dense(units=10,bias_initializer='one',activation="softmax")

])

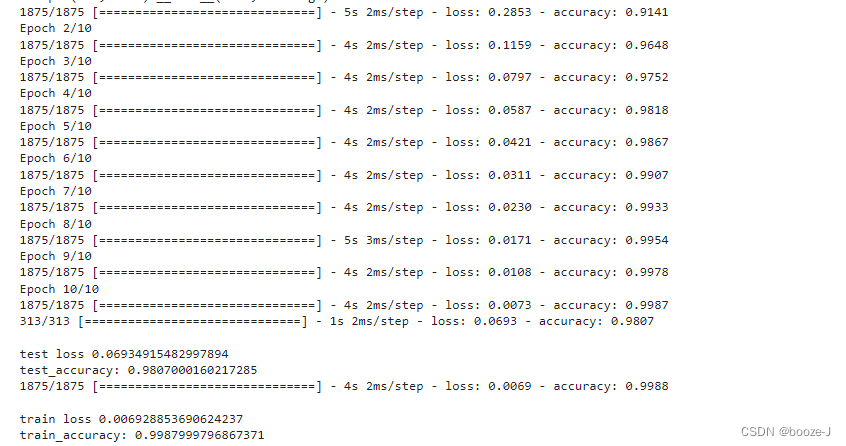

代码运行结果:

对比4.交叉熵的运行结果,可以发现添加更多隐藏层之后,模型测试的准确率大大提高,但是却出现了轻微的过拟合现象。

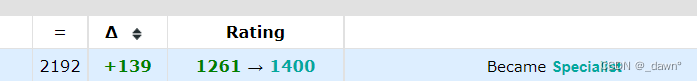

二、使用Dropout

在模型构建中添加Dropout:

# 创建模型 输入784个神经元,输出10个神经元

model = Sequential([

# 定义输出是200 输入是784,设置偏置为1,添加softmax激活函数 第一个隐藏层有200个神经元

Dense(units=200,input_dim=784,bias_initializer='one',activation="tanh"),

# 让40%的神经元不工作

Dropout(0.4),

# 第二个隐藏层有 100个神经元

Dense(units=100,bias_initializer='one',activation="tanh"),

# 让40%的神经元不工作

Dropout(0.4),

Dense(units=10,bias_initializer='one',activation="softmax")

])

使用Dropout之前需要先导入from keras.layers import Dropout

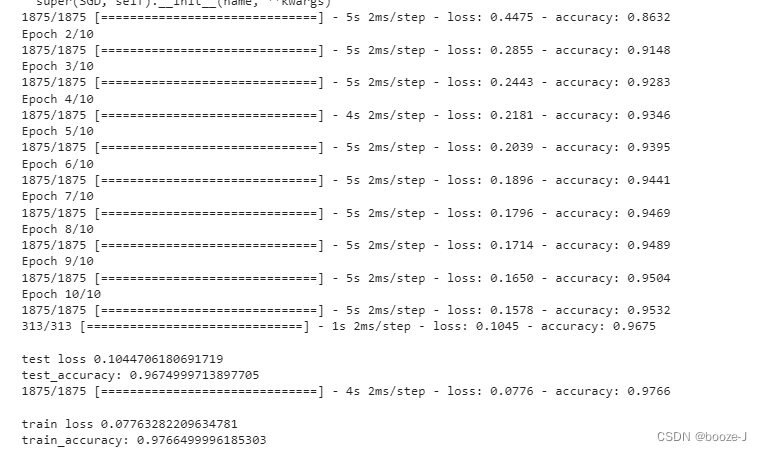

运行结果:

在这个例子中并不是说使用dropout会得到更好的效果,但是有些情况下,使用dropout是可以得到更好的效果。

但是使用dropout之后,测试准确率和训练准确率还是比较接近的,过拟合现象不是很明显。从训练结果中可以看到,训练过程中的准确率都低于最终模型测试训练集的准确率,这是因为使用dropout之后,每次训练都只是使用部分神经元进行训练,然后模型训练完之后,最后测试的时候,是使用所有神经元进行测试的,所以效果会更好。

完整代码

1.未使用Dropout情况的完整代码

代码运行平台为jupyter-notebook,文章中的代码块,也是按照jupyter-notebook中的划分顺序进行书写的,运行文章代码,直接分单元粘入到jupyter-notebook即可。

1.导入第三方库

import numpy as np

from keras.datasets import mnist

from keras.utils import np_utils

from keras.models import Sequential

from keras.layers import Dense,Dropout

from tensorflow.keras.optimizers import SGD

2.加载数据及数据预处理

# 载入数据

(x_train,y_train),(x_test,y_test) = mnist.load_data()

# (60000, 28, 28)

print("x_shape:\n",x_train.shape)

# (60000,) 还未进行one-hot编码 需要后面自己操作

print("y_shape:\n",y_train.shape)

# (60000, 28, 28) -> (60000,784) reshape()中参数填入-1的话可以自动计算出参数结果 除以255.0是为了归一化

x_train = x_train.reshape(x_train.shape[0],-1)/255.0

x_test = x_test.reshape(x_test.shape[0],-1)/255.0

# 换one hot格式

y_train = np_utils.to_categorical(y_train,num_classes=10)

y_test = np_utils.to_categorical(y_test,num_classes=10)

3.训练模型

# 创建模型 输入784个神经元,输出10个神经元

model = Sequential([

# 定义输出是200 输入是784,设置偏置为1,添加softmax激活函数 第一个隐藏层有200个神经元

Dense(units=200,input_dim=784,bias_initializer='one',activation="tanh"),

# 第二个隐藏层有 100个神经元

Dense(units=100,bias_initializer='one',activation="tanh"),

Dense(units=10,bias_initializer='one',activation="softmax")

])

# 定义优化器

sgd = SGD(lr=0.2)

# 定义优化器,loss_function,训练过程中计算准确率

model.compile(

optimizer=sgd,

loss="categorical_crossentropy",

metrics=['accuracy']

)

# 训练模型

model.fit(x_train,y_train,batch_size=32,epochs=10)

# 评估模型

# 测试集的loss和准确率

loss,accuracy = model.evaluate(x_test,y_test)

print("\ntest loss",loss)

print("test_accuracy:",accuracy)

# 训练集的loss和准确率

loss,accuracy = model.evaluate(x_train,y_train)

print("\ntrain loss",loss)

print("train_accuracy:",accuracy)

2.使用Dropout的完整代码

代码运行平台为jupyter-notebook,文章中的代码块,也是按照jupyter-notebook中的划分顺序进行书写的,运行文章代码,直接分单元粘入到jupyter-notebook即可。

1.导入第三方库

import numpy as np

from keras.datasets import mnist

from keras.utils import np_utils

from keras.models import Sequential

from keras.layers import Dense,Dropout

from tensorflow.keras.optimizers import SGD

2.加载数据及数据预处理

# 载入数据

(x_train,y_train),(x_test,y_test) = mnist.load_data()

# (60000, 28, 28)

print("x_shape:\n",x_train.shape)

# (60000,) 还未进行one-hot编码 需要后面自己操作

print("y_shape:\n",y_train.shape)

# (60000, 28, 28) -> (60000,784) reshape()中参数填入-1的话可以自动计算出参数结果 除以255.0是为了归一化

x_train = x_train.reshape(x_train.shape[0],-1)/255.0

x_test = x_test.reshape(x_test.shape[0],-1)/255.0

# 换one hot格式

y_train = np_utils.to_categorical(y_train,num_classes=10)

y_test = np_utils.to_categorical(y_test,num_classes=10)

3.训练模型

# 创建模型 输入784个神经元,输出10个神经元

model = Sequential([

# 定义输出是200 输入是784,设置偏置为1,添加softmax激活函数 第一个隐藏层有200个神经元

Dense(units=200,input_dim=784,bias_initializer='one',activation="tanh"),

# 让40%的神经元不工作

Dropout(0.4),

# 第二个隐藏层有 100个神经元

Dense(units=100,bias_initializer='one',activation="tanh"),

# 让40%的神经元不工作

Dropout(0.4),

Dense(units=10,bias_initializer='one',activation="softmax")

])

# 定义优化器

sgd = SGD(lr=0.2)

# 定义优化器,loss_function,训练过程中计算准确率

model.compile(

optimizer=sgd,

loss="categorical_crossentropy",

metrics=['accuracy']

)

# 训练模型

model.fit(x_train,y_train,batch_size=32,epochs=10)

# 评估模型

# 测试集的loss和准确率

loss,accuracy = model.evaluate(x_test,y_test)

print("\ntest loss",loss)

print("test_accuracy:",accuracy)

# 训练集的loss和准确率

loss,accuracy = model.evaluate(x_train,y_train)

print("\ntrain loss",loss)

print("train_accuracy:",accuracy)

边栏推荐

- Summary of the third course of weidongshan

- My best game based on wechat applet development

- Summary of weidongshan phase II course content

- Hotel

- Password recovery vulnerability of foreign public testing

- Su embedded training - Day3

- New library online | cnopendata China Star Hotel data

- Basic mode of service mesh

- 8道经典C语言指针笔试题解析

- letcode43:字符串相乘

猜你喜欢

New library launched | cnopendata China Time-honored enterprise directory

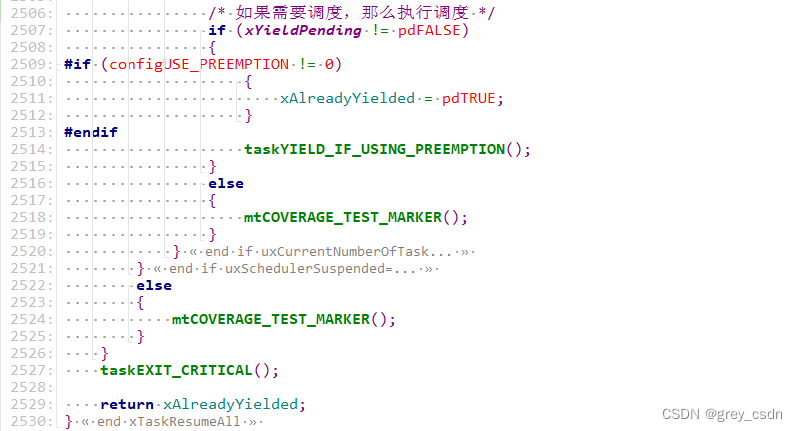

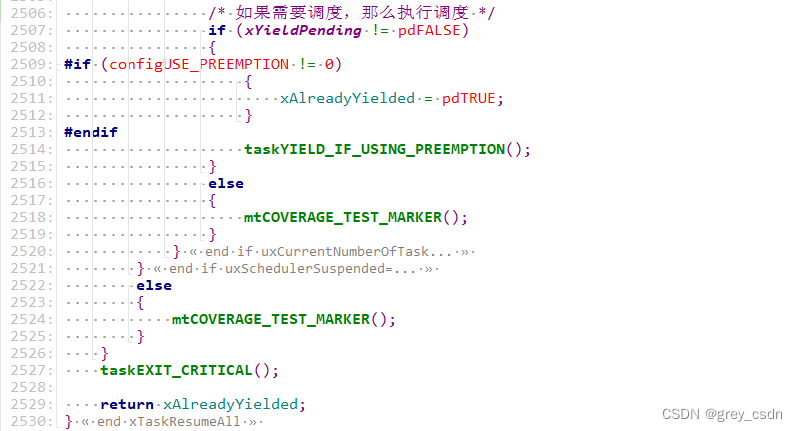

1293_FreeRTOS中xTaskResumeAll()接口的实现分析

他们齐聚 2022 ECUG Con,只为「中国技术力量」

1293_ Implementation analysis of xtask resumeall() interface in FreeRTOS

What has happened from server to cloud hosting?

Codeforces Round #804 (Div. 2)(A~D)

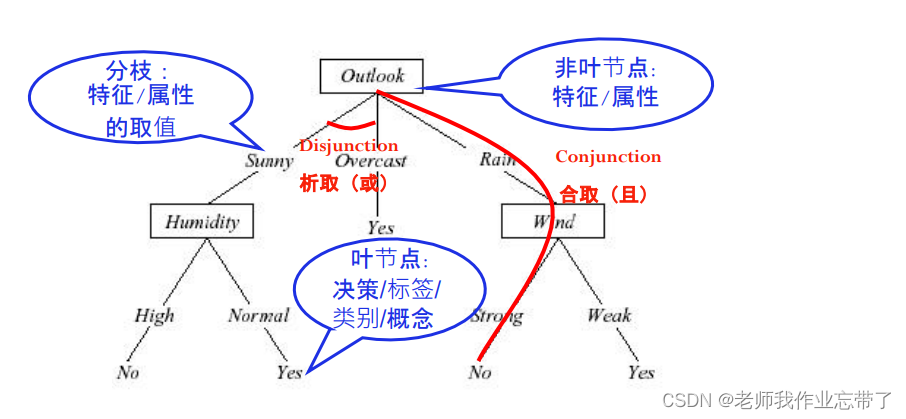

AI遮天传 ML-初识决策树

Class head up rate detection based on face recognition

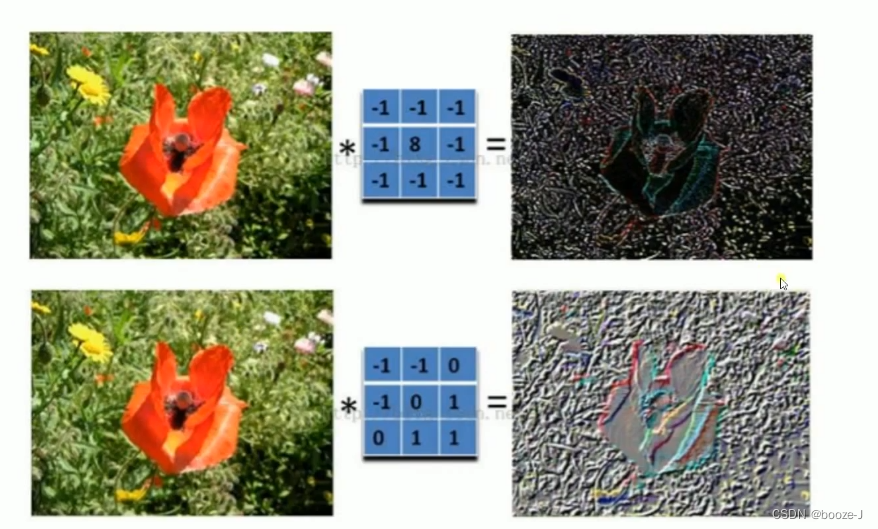

9.卷积神经网络介绍

华为交换机S5735S-L24T4S-QA2无法telnet远程访问

随机推荐

QT establish signal slots between different classes and transfer parameters

Tapdata 的 2.0 版 ,开源的 Live Data Platform 现已发布

Qt不同类之间建立信号槽,并传递参数

Introduction to paddle - using lenet to realize image classification method I in MNIST

基于微信小程序开发的我最在行的小游戏

From starfish OS' continued deflationary consumption of SFO, the value of SFO in the long run

Course of causality, taught by Jonas Peters, University of Copenhagen

Lecture 1: the entry node of the link in the linked list

C# 泛型及性能比较

How is it most convenient to open an account for stock speculation? Is it safe to open an account on your mobile phone

The weight of the product page of the second level classification is low. What if it is not included?

Basic types of 100 questions for basic grammar of Niuke

Interface test advanced interface script use - apipost (pre / post execution script)

Huawei switch s5735s-l24t4s-qa2 cannot be remotely accessed by telnet

接口测试进阶接口脚本使用—apipost(预/后执行脚本)

ABAP ALV LVC template

How to learn a new technology (programming language)

他们齐聚 2022 ECUG Con,只为「中国技术力量」

Semantic segmentation model base segmentation_ models_ Detailed introduction to pytorch

炒股开户怎么最方便,手机上开户安全吗