当前位置:网站首页>Recursive Fusion and Deformable Spatiotemporal Attention for Video Compression Artifact Reduction

Recursive Fusion and Deformable Spatiotemporal Attention for Video Compression Artifact Reduction

2022-07-04 06:53:00 【mytzs123】

code: https://github.com/zhaominyiz/RFDA-PyTorch.

包括两个主要组件:时空特征融合(STFF)模块,用于时间特征融合,质量增强(QE)模块,用于重建融合特征。而在STFF模块中,递归融合(RF)模块是在大时间范围内融合多帧的关键。

包括两个主要组件:时空特征融合(STFF)模块,用于时间特征融合,质量增强(QE)模块,用于重建融合特征。而在STFF模块中,递归融合(RF)模块是在大时间范围内融合多帧的关键。

ABSTRACT

人们提出了许多基于深度学习的算法来从低质量的压缩视频中恢复高质量的视频。其中,有的通过挖掘相邻帧的时空信息来恢复每帧缺失的细节。然而,这些方法的时间范围通常很窄,因此可能会丢失相邻帧之外的一些有用细节。在本文中,为了提高伪影去除率,一方面,我们提出了一种递归融合(RF)模块来建模长时间范围内的时间依赖性。具体而言,RF利用当前参考帧和之前的隐藏状态来进行更好的时空补偿。另一方面,我们设计了一个高效的可变形时空注意(DSTA)模块,使得该模型能够更加努力地恢复运动对象边界区域等伪影丰富的区域。大量实验表明,在MFQE 2.0数据集上,我们的方法在保真度和感知效果方面都优于现有方法.

1 INTRODUCTION

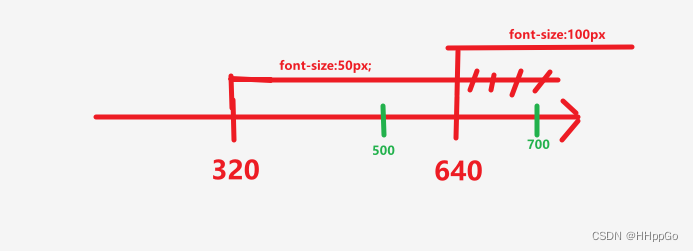

如今,有损视频压缩算法(例如H.264 \/视频压缩算法[28]和H.265 \/视频压缩算法[23])被广泛应用于减少视频存储和传输的成本。随着压缩率的增加,这些算法大大降低了比特率,但也引入了不需要的伪影,从而严重降低了体验质量(QoE)。此外,低质量压缩视频中的伪影也会损害面向下游视频的任务的性能(例如,动作识别和定位[29,43],视频摘要[1,32])。因此,视频压缩伪影减少成为多媒体领域的热门话题,其目的是减少引入的伪影并恢复严重压缩视频中丢失的细节[7、11、21、33、34、36]。近年来,出现了许多基于深度神经网络的压缩伪影去除方法,其性能有了显著的提高。这些工作大致分为三种类型:分别基于单个图像的工作[5、9、12、16、24、41],基于各种视频压缩优先级的工作[6、14、39],以及基于附加时间信息的工作[7、8、11、19-21、33-35、37]。具体而言,[9、16、41]是为增强JPEG质量而设计的。这些方法可以通过单独恢复每个帧来适应视频。[6、14、39]考虑到I \/P \/B帧是用不同的策略压缩的,应该由不同的模块处理,它们以单个帧作为输入,忽略了视频的时间信息。为了弥补这一缺陷,[11,21]利用两个最近的高质量峰值质量帧(PQF)作为参考帧,[19,20]利用深度卡尔曼滤波网络并从之前的帧捕获时空信息,[7,33]分别利用非局部convlsm和可变形卷积来捕获多个相邻帧之间的依赖关系。综上所述,最近的工作利用前面的帧、附近的PQFs或多个相邻帧作为参考帧来利用视频帧之间的时空信息。虽然这些方法在这方面取得了很大的进展,但它们的性能仍然受到时间范围狭窄的限制,这使得它们无法充分利用前面帧中的时空信息。

为了解决上述问题,一方面,我们提出了一种递归融合(RF)模块来减少视频压缩伪影。具体而言,为了在较大的时间范围内利用相关信息,我们开发了一种递归融合方案,并以有限的额外计算成本递归地将之前的补偿特征与当前特征相结合。图1示出了RF利用来自遥远帧的细节的示例。如我们所见,当不使用RF模块时,我们无法恢复第56帧中的细节,而我们使用RF模块的方法可以通过利用49-51帧中的相应区域成功恢复两个记分板之间区域的细节。这是由于射频模块的时间感受野增大所致。另一方面,在重建其高质量版本时,平等对待框架的不同区域是不合理的。例如:运动物体的边界区域通常会发生严重的畸变,因此在减少伪影方面应该受到更多的关注。因此,我们设计了一种有效且高效的可变形时空注意机制(DSTA),使模型能够更加关注帧中伪影丰富的区域。这里,在RF模块之后,帧之间的时空相关性被划分为不同的信道。因此,在可变形卷积运算之后,使用通道注意机制沿时间维度对齐空间信息。

本文的主要贡献总结如下:

1、我们提出了一种递归融合模块,可以在较大的时间范围内利用视频帧中更多的时空信息,但额外的计算成本有限。

2、我们开发了一种可变形的时空注意机制,以指导模型在每一帧中的伪影丰富区域。

3、我们在MFQE 2.0数据集上进行了大量实验,证明了该方法的优越性。

本文的其余部分组织如下:第2节回顾了相关工作,并强调了我们的方法与现有的基于多框架的方法之间的差异。第3节介绍了拟议方法的技术细节。第4节介绍了实证结果,包括与最新方法的性能比较和消融实验,第5节总结了本文。

2 RELATED WORK

在这一部分中,我们回顾了基于深度学习的视频压缩伪影减少的相关工作。根据领域知识和使用的输入帧数,现有方法大致可分为基于图像的方法、基于单帧的方法和基于多帧的方法。

Image-based approaches:这些方法旨在解决JPEG图像质量增强问题【5、9、10、13、16、17、40–42】。当应用于压缩视频时,这些方法会从视频中提取一帧,并在不了解视频压缩算法的情况下对其进行增强。例如,AR-CNN【9】引入了四个卷积层以减少JPEG压缩伪影。DnCNN【41】是一个具有批量归一化和剩余学习的深层模型。[5,40]采用小波\频域信息来增强视觉质量。NLRN【17】和RNAN【42】提出了具有剩余非局部注意机制的更深层次的网络,以捕获像素之间的长距离依赖关系。

Single-frame based approaches:在这些方法中,[6、14、26、38、39]利用视频压缩算法中不同编码模式的知识(例如I \/P \/B帧),并采用特殊策略来应对它们。具体而言,DS-CNN【39】和QECNN【38】提出了两个独立的模型,分别处理帧内编码和帧间编码模式。然而,这些方法忽略了视频空间的时间连续性,使得它们难以处理时间噪声。

Multi-frame based approaches:[19,20]将视频压缩伪影减少任务建模为卡尔曼滤波过程,并从增强的前帧捕获时间信息,以递归方式恢复当前帧。它们还将压缩码流中的量化预测残差作为强先验知识结合起来。然而,仅仅利用前帧的时间信息是不够的,因为B帧是通过使用前帧和后帧作为参考来压缩的。[11,21]使用附近的高质量帧(称为PQF)建立时间依赖关系。它们首先使用分类器检测PQF,然后将PQF作为参考帧来修复非PQF。在实现中,他们首先使用光流进行运动补偿,然后设计一个质量增强的重建网络。后来,[37]采用了一种改进的卷积LSTM来进一步利用大时间范围内帧的有用信息。利用非本地机制和可变形卷积网络分别捕获多个相邻帧中的时空相关性。最近,[34]采用参考帧建议和快速傅立叶变换(FFT)损耗来选择高质量参考帧,并专注于高频信息恢复。

Difference between our method and existing multi-frame based approaches:

利用时空信息已成为近年来视频增强工作的主流。然而,现有的方法受到时间范围的限制,无法从视频中挖掘出足够的信息。本文提出了一种新的递归融合模块,该模块利用前隐状态和当前特征来扩大接收野,提高恢复性能。此外,由于计算量巨大,传统的非局部注意在这项任务中效率低下,并且在每一帧中平等对待不同的区域。因此,我们进一步开发了一个高效的可变形时空注意(DSTA)模块来捕获伪影丰富的区域,并使模型更加关注这些区域,从而获得更好的恢复性能。

3 METHOD

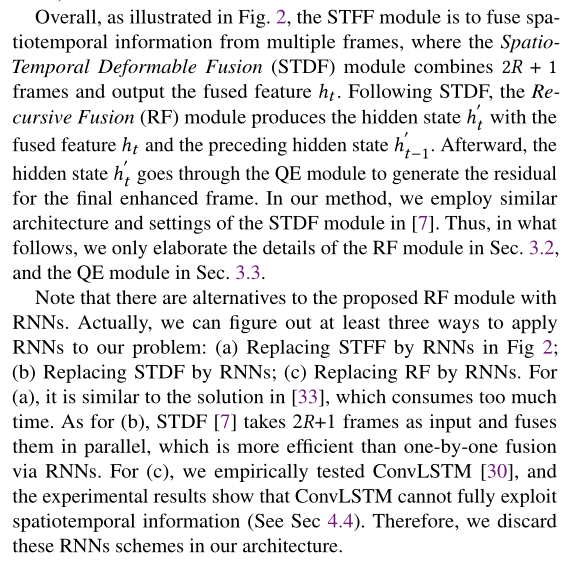

在本节中,我们将介绍我们的方法的技术细节。我们的方法的体系结构如图2所示。在详细描述之前,我们首先阐述了视频压缩伪影减少问题,并对该方法进行了概述。

3.1 Problem Formulation and Method Overview

给定压缩视频V=[ ,

, ,...,

,..., ]由T帧组成,

]由T帧组成,

3.2 Recursive Fusion Module

提出了递归融合(RF)模块通过引入前面的隐藏状态ℎt-1'来细化融合特征ℎt,如【7】所设计,STDF利用一个高效的基于U网的网络【22】来预测偏移场![]() 对于可变形卷积核,其中K 是可变形卷积层的核大小。然后,这些特定于位置的偏移量Δ引导可变形卷积网络有效地融合输入帧。

对于可变形卷积核,其中K 是可变形卷积层的核大小。然后,这些特定于位置的偏移量Δ引导可变形卷积网络有效地融合输入帧。

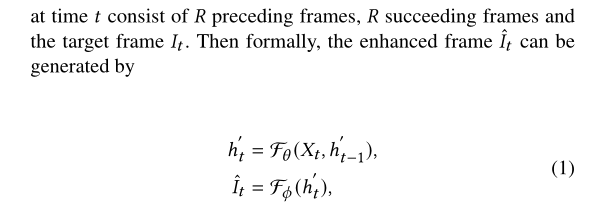

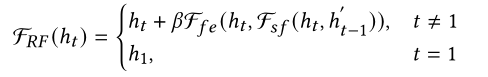

在[7]中,融合特征ℎt 直接馈入QE模块,而在本文中,我们建议对RF模块进行细化ℎt通过进一步利用帧的时空信息。具体来说,RF模块的核心思想是递归地利用前面的隐藏状态ℎt-1'作为调整当前功能的线索ℎt . RF模块的操作可以形式化为:

ℎt 是STDF的融合特征,Fsf是融合当前ℎt特征和隐藏特征ℎt-1' 的子融合模块,Ffe是一种特征提取器,旨在学习残差并为ℎt 提供其他学习信息. 在我们的实施过程中, 通过网格搜索设置为0.2。

通过网格搜索设置为0.2。

3.3 Deformable Spatiotemporal Attention

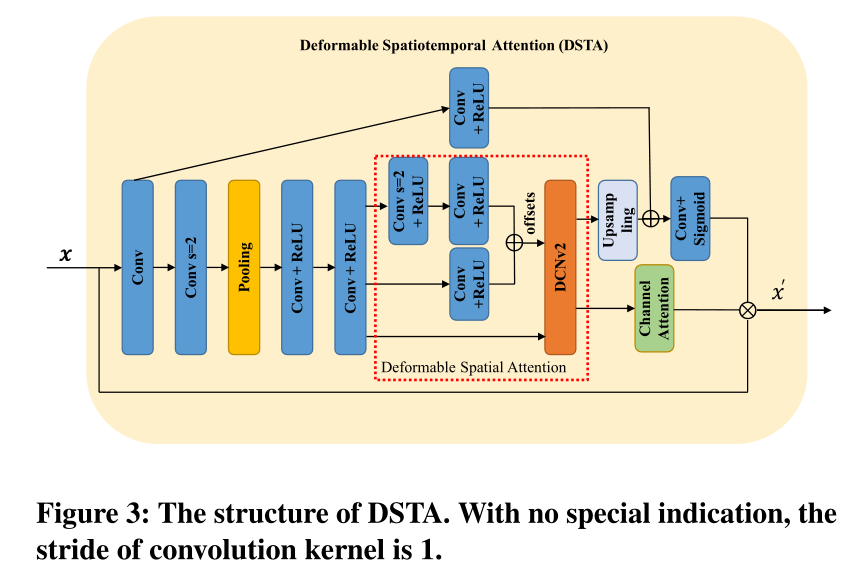

QE模块在这项任务中至关重要,因为它需要将隐藏状态解码为残差,从而重建高质量的帧。然而,QE模块在最近的工作中很少受到关注。为了提高QE模块的性能,本文设计了可变形时空注意(DSTA)机制。一般而言,QE部分利用隐藏状态ℎ ′ 从STFF作为输入并生成一个残差,该残差与压缩帧一起用于恢复压缩帧。

QE模块的结构可参考图2,其包括L+2个卷积层和L个DSTA块。同时,图3示出了DSTA块的结构。一般来说,DSTA是为了使模型更加关注伪影丰富的区域,例如帧中移动对象的边界,以便QE模块在这些区域可以实现更好的性能

在DSTA中,我们首先采用1×1卷积来减少通道数,以获得足够的接收野和较低的计算成本,这是受到了文献[18]的启发。然后,在步长为2的卷积层之后是一个7×7的池层,以减小特征的空间大小。在减少特征的空间大小后,我们利用多尺度结构来预测偏移量。然后,可变形卷积层使用预测的偏移量来计算注意图。然后将该映射馈入上采样操作符和通道注意模块,分别生成空间注意掩码和通道权重。值得一提的是,通道注意机制对隐藏状态起着选择作用,其中不同的维度表示与目标帧的不同时间关系。因此,通道注意机制可以通过通道上的加权和来区分有用的时间信息。最后,DSTA块的输入与空间map和通道权重相乘。

请注意,非局部注意机制(参见[42])可能会带来更多的性能改进,但其巨大的计算量增加了恢复的时间成本,这是不可接受的,也不符合我们的动机。我们的DSTA模块在计算和性能之间实现了良好的平衡,并同时考虑时间和空间依赖性以获得更好的性能。如图4所示,提议的注意块更加关注移动区域,因此引导QE模块更加努力地恢复它们。

3.4 Training Scheme

为了进一步提高我们方法的性能,我们分两个阶段对模型进行训练。在第一阶段,我们移除RF模块,重点关注STDF和DSTA模块。当这两个模块融合时,我们会降低他们的学习率,并将RF模块添加到训练中。在第二阶段,我们利用视频剪辑作为输入来训练射频模块。这种训练策略可以缩短训练时间。相比之下,单阶段训练策略的收敛速度比我们的慢得多。在这两个阶段中,我们都使用Charbonnier损失来优化模型。

4 EXPERIMENTS

在这一部分中,我们进行了大量的实验来评估我们提出的方法的有效性和优越性。我们的评估包括两部分:(1)与最新方法的比较,(2)不同子模块影响的消融研究,所有这些都是在MFQE 2.0数据集上进行的,共有五个QP。

4.1 Datasets

在[7,11,34]之后,我们在MFQE 2.0数据集上进行了实验。它由从Xiph收集的126个视频序列组成。org【31】、VQEG【25】和JCT-VC【2】。MFQE 2.0中包含的视频序列的分辨率范围很大:SIF(352×240)、CIF(352×288)、NTSC(720×486)、4CIF(704×576)、240p(416×240)、360p(640×360)、480p(832×480)、720p(1280×720)、1080p(1920×1080)和WQXGA(2560×1600)。为了进行公平的比较,我们按照【7、11、34】中的设置:其中108人用于培训,其余18人用于测试。所有序列均采用HEVC Low-Delay-P(LDP)配置编码,使用HM 16.20,QP=22、27、32、37和42【11】

4.2 Implementation Details

在本文中,我们以文献[7]中最先进的方法STDF-R3为基线,这意味着R = 3对于本文中的STDF。在训练阶段,我们从原始视频和相应的压缩视频中随机裁剪112×112个片段作为训练样本,设置批量大小为32。我们还采用翻转和旋转作为数据扩充策略来进一步扩展数据集。在第一个训练阶段,模型由Adam(15)优化器进行训练,初始学习率为10−4,当达到60%和90%的迭代时,该值将减少一半。在第二个训练阶段,我们将STDF和QE的学习率设置为10−5并将训练集中的每个视频分割为多个视频片段。每个视频剪辑包含15帧。值得一提的是,在第一个训练阶段,我们逐帧计算损耗,而在第二个训练阶段,我们计算整个剪辑的损失,以便更好地利用射频模块的特性。我们的模型在4个NVIDIA GeForce RTX 3090 GPU上使用PyTorch1.8进行训练。

为了评估,按照[7,34]的设置,我们只报告YUV /YCbCr空间中Y通道的质量增强。我们采用对压缩峰值信噪比(ΔPSNR)和结构相似性(ΔSSIM)的改进来评估质量增强性能。以ΔPSNR为例,我们使用增强PSNR之间的差值(根据增强视频 和基本事实值 ) 以及压缩的PSNR(根据压缩视频计算和基本事实푉) 测量方法的性能,即![]()

4.3 Comparison with State of the art Methods

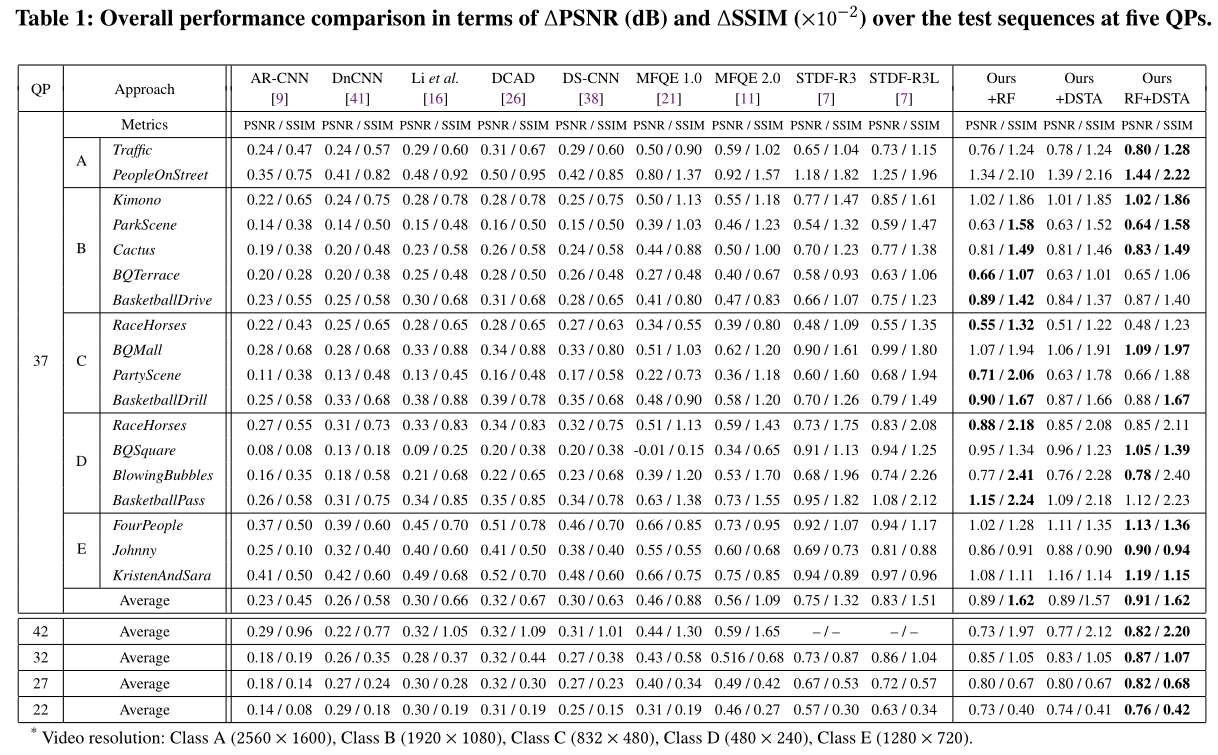

为了证明我们的方法的优势,我们将我们的方法与最先进的方法进行了比较,包括基于图像的方法[9、16、41]、基于单帧的方法[26、38]和多帧方法[7、11、21]。为了充分验证我们方法中模块的有效性,我们还将RF和DSTA分别应用于STDF-R3。文献[7,11]引用了现有方法的结果。

Overall performance:PSNR/SSIM改善的结果显示在表中。为了验证不同组件的有效性,我们还分别报告了仅使用RF和DSTA时的性能。从表1我们可以看到,由于利用时空信息的优势,基于多帧的方法的性能优于所有基于图像的方法。而我们的方法在五个QPs下的性能优于所有现有方法,这验证了所提方法的有效性和优越性。此外,仅具有RF或DSTA的STDF-R3在四个QP下的性能也优于最先进的方法。

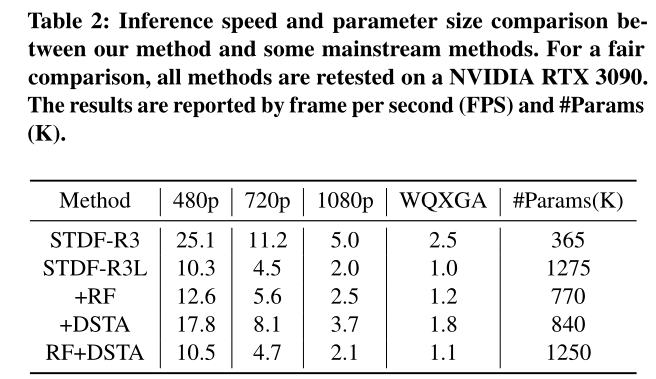

Speed and parameter size comparison:我们还比较了我们的方法和一些现有方法的推理速度和参数大小。如表2所示。我们的方法在推理速度和参数大小方面都优于最先进的方法STDF-R3L。具体而言,我们的方法平均ΔPSNR提高了8.8%(从0.83提高到0.91,见表1),并将推断FPS提高了0.1∼0.2(提高2∼10%,见表。2) ,而我们的模型的参数比STDF-R3L少(1250k比1275k,见表2),这证明了我们提出的方法的有效性和优越性。此外,通过表1和表2,我们可以看到,即使只使用RF或DSTA在恢复效果、速度和参数大小方面,仍然可以在四个QP下实现比STDF-R3L更好的性能。

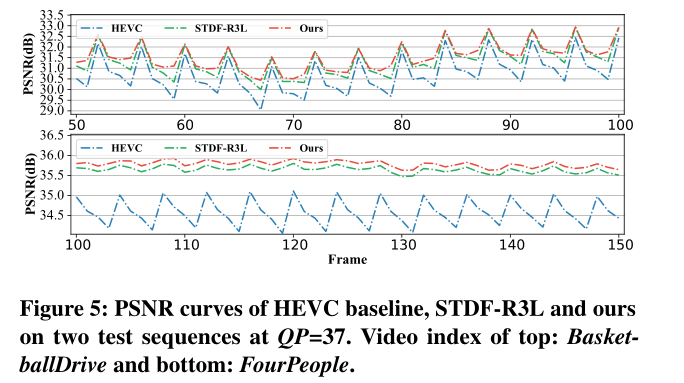

Quality fluctuation:质量波动是增强视频总体质量的另一个可观察指标。帧的剧烈质量波动导致了严重的纹理抖动和体验质量的下降。我们通过【11、33、38】中每个测试序列的标准偏差(SD)和峰值V巷差(PVD)来评估波动。我们的方法和主要现有方法的所有测试序列的平均PVD和SD如表所示。3、我们可以看到,我们的方法具有最小的平均PVD和SD,这表明我们的方法比其他方法更稳定。

图5显示了两组PSNR曲线,每组由HEVC压缩的测试序列的三条PSNR曲线以及STDF-R3L和我们的方法增强的两条相应序列组成。与STDF-R3L相比,我们的方法比压缩后的帧有更大的PSNR改善,但波动较小。

Rate-distortion:在此,我们评估了我们的方法的速率失真,并将其与最先进的方法进行比较。为便于说明,我们仅展示了压缩视频的结果、两种最先进方法(MFQE 2.0和STDF-R3L)的增强结果以及图6中的方法。由于[7]中缺乏数据,我们没有显示QP=32的STDF-R3L的结果,从图6中我们可以看到,对于类似的比特率,我们的方法比其他方法获得更大的PSNR,这表明我们的方法在速率失真方面优于最先进的方法。

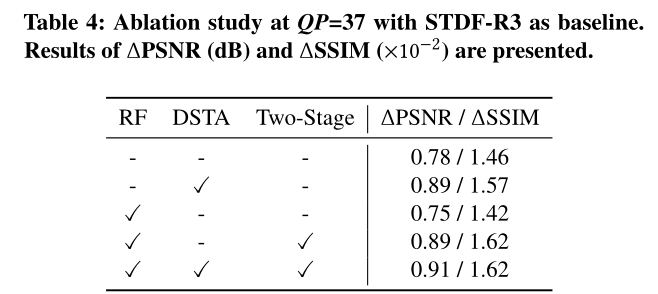

4.4 Ablation Study

为了验证我们的模块的效果,我们以STDF-R3为基线,并在基线中插入不同的模块组合。为了公平比较,我们对STDF-R3进行了再训练,并采用了类似的实验设置。选项卡。4给出了不同模块组合的STDF-R3和STDF-R3的结果。为简单起见,我们将两阶段培训策略缩写为两阶段。

Effect of Recursive Fusion:在这里,我们评估我们的射频模块的有效性。如表4中第四个原始输入、采用两阶段训练策略的射频模块的ΔPSNR为0.89,比基线方法高0.11。图7中的视觉示例还表明,RF模块通过学习从前面的帧恢复丢失的细节而带来好处。为了更好地说明射频模块的有效性,我们还训练了一个STDF-R4模型,该模型需要2个额外的参考帧来进行增强。STDF-R4的ΔPSNR为0.79,而我们的射频模块的ΔPSNR为0.89,这再次证明了射频模块的有效性。

我们注意到,我们的训练和推理阶段之间存在不一致:我们使用长度为15的视频片段训练我们的模型,在推理过程中,我们使用RF递归生成整个视频。为了更好地验证我们的模型是否有能力在长时间范围内利用时空相关性,我们设计了三种变体:无RF、有RF和有RF-15,RF-15意味着在训练和推理中,我们将每个视频分割为多个15帧视频片段,并逐一增强。图8显示了各种射频变体的峰值信噪比曲线。RF和RF-15都优于w/o RF。然而,RF-15在每个片段的起始帧处的性能比RF差,这进一步验证了引入遥远的前帧信息的有效性。

我们还将RF替换为ConvLSTM【30】,并在相同的实验设置下(两阶段,QP=37)将其与RF进行比较。我们得到了0.78ΔPSNR,远低于RF的0.89,这也证明了RF的优越性。

Effect of Deformable Spatiotemporal Attention:从表4,我们可以得出结论,DSTA对性能改进有很大贡献。为了深入研究,我们考虑对DSTA模块的分支结构进行额外的烧蚀研究。直观地说,拟议的DSTA模块有三种变体:不带DA的DSTA(删除可变形注意部分并使用基本卷积层生成注意图)、不带CA的DSTA(删除通道注意部分)和DSTA(使用两个分支)。实验结果如表所示。5、我们可以看到,两种单分支注意设置都能够提高STDF-R3的性能,但都比DSTA的性能差。

Effect of Two-Stage Training:在这里,我们检查两阶段培训策略的必要性。为了公平比较,我们使用相同的优化器和学习率衰减设置来训练有/无两阶段策略的模型。表4中显示了使用/不使用两个阶段训练的模型的结果。我们可以看到,两阶段得到0.14 /0.2×10−2ΔPSNR /ΔSSIM改进(第四行与第三行),表明两阶段策略的有效性。

4.5 Qualitative Comparison

我们还进行了定性比较,并提供几个视觉示例,在图9中的QP=37。在这里,我们将我们的方法与现有的四种主要方法进行比较:AR-CNN、DnCNN、MFQE 2.0和基线STDF-R3。如图9所示,压缩的片段(第2列中)存在严重的压缩伪影(例如,人体细节缺失),单帧方法无法处理时间噪声,而MFQE 2.0和STDF-R3存在过度平滑。然而,我们的方法恢复了更多的细节或纹理比其他方法,尤其是快速移动对象边界区域的细节。

5 CONCLUSION

本文提出了一种提高视频压缩伪影抑制性能的新方法。我们的方法由两个新模块组成:递归融合(RF)模块和可变形时空注意(DSTA)模块。前者旨在从大时间范围的帧中捕获时空信息,而后者旨在突出每个帧中伪影丰富的区域,例如运动对象的边界区域。我们的大量实验表明,我们提出的方法可以实现优于现有方法的性能。所提出的模块也可以很容易地适应现有的多帧方法和与视频相关的低级任务。

边栏推荐

- Design of test cases

- leetcode 310. Minimum Height Trees

- tars源码分析之6

- leetcode825. Age appropriate friends

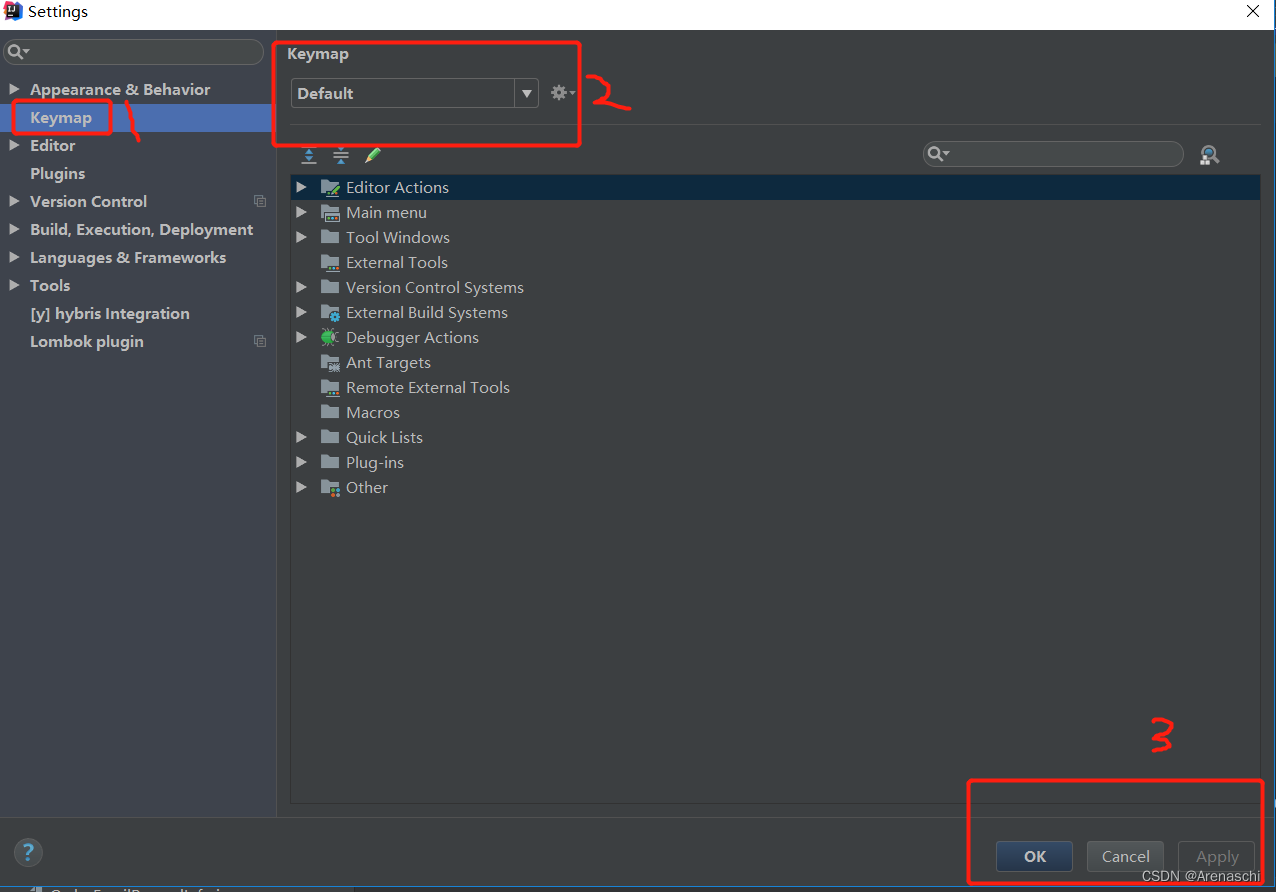

- About how idea sets up shortcut key sets

- what the fuck! If you can't grab it, write it yourself. Use code to realize a Bing Dwen Dwen. It's so beautiful ~!

- Download address of the official website of national economic industry classification gb/t 4754-2017

- 关于IDEA如何设置快捷键集

- Campus network problems

- the input device is not a TTY. If you are using mintty, try prefixing the command with ‘winpty‘

猜你喜欢

响应式移动Web测试题

Responsive mobile web test questions

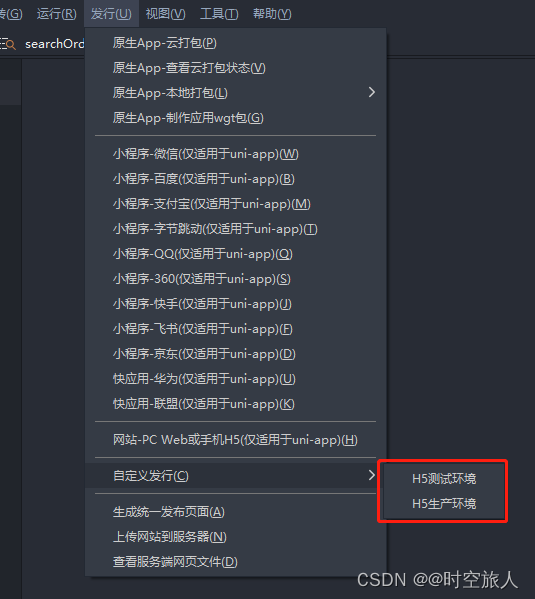

uniapp 自定义环境变量

About how idea sets up shortcut key sets

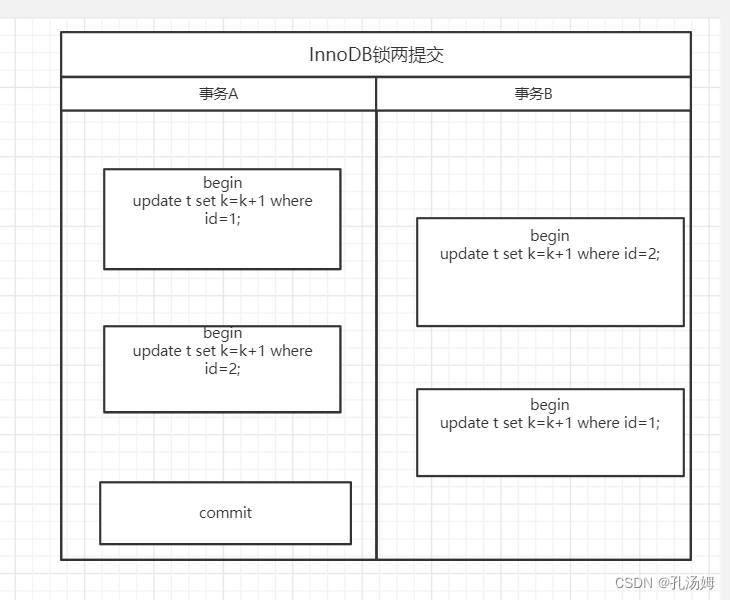

Mysql 45讲学习笔记(七)行锁

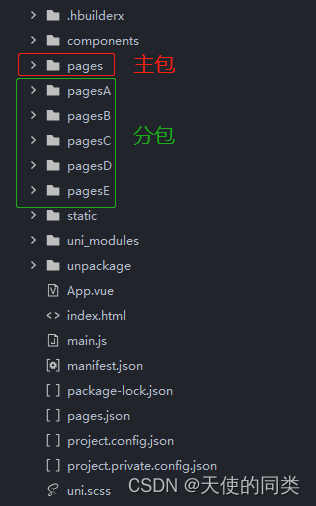

Uniapp applet subcontracting

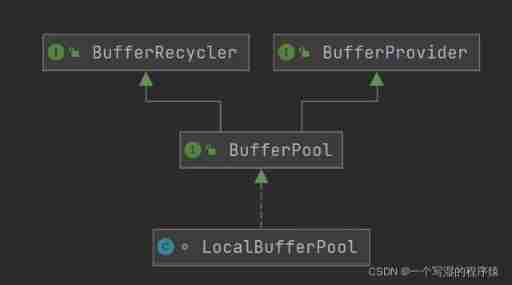

Flink memory model, network buffer, memory tuning, troubleshooting

the input device is not a TTY. If you are using mintty, try prefixing the command with ‘winpty‘

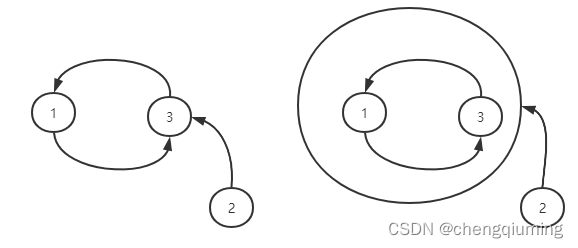

Bottom problem of figure

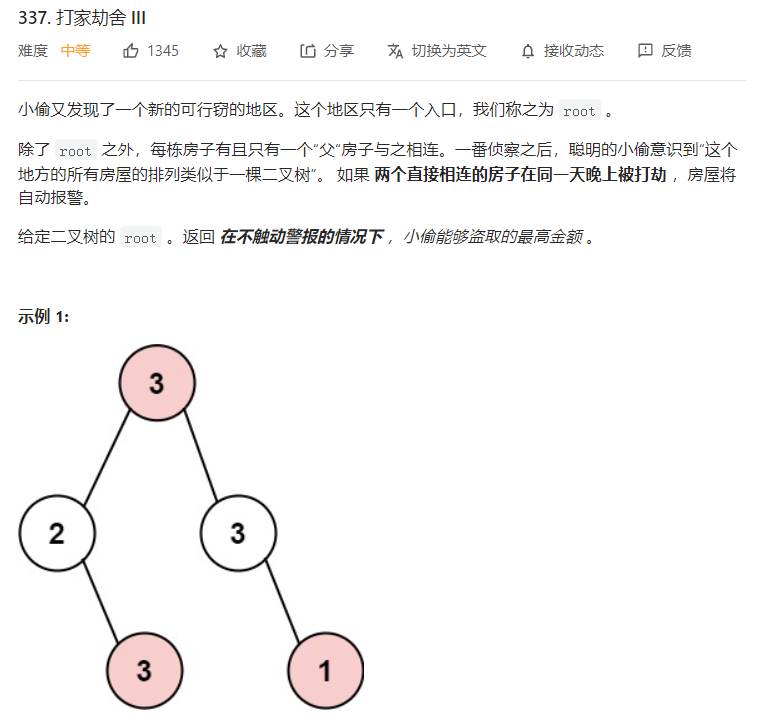

Tree DP

随机推荐

Wechat applet scroll view component scrollable view area

uniapp 自定义环境变量

1、 Relevant theories and tools of network security penetration testing

GoogleChromePortable 谷歌chrome浏览器便携版官网下载方式

C # symmetric encryption (AES encryption) ciphertext results generated each time, different ideas, code sharing

About how idea sets up shortcut key sets

Cervical vertebra, beriberi

Code rant: from hard coding to configurable, rule engine, low code DSL complexity clock

Selection (022) - what is the output of the following code?

What is industrial computer encryption and how to do it

Common usage of time library

tars源码分析之5

js 常用时间处理函数

notepad++如何统计单词数量

How to input single quotation marks and double quotation marks in latex?

MySQL 45 lecture learning notes (XIV) count (*)

Tar source code analysis Part 7

The important role of host reinforcement concept in medical industry

tars源码分析之10

Redis interview question set