当前位置:网站首页>Python爬蟲實戰詳解:爬取圖片之家

Python爬蟲實戰詳解:爬取圖片之家

2020-11-06 01:17:00 【itread01】

前言

本文的文字及圖片來源於網路,僅供學習、交流使用,不具有任何商業用途,版權歸原作者所有,如有問題請及時聯絡我們以作處理

如何使用python去實現一個爬蟲?

- 模擬瀏覽器

請求並獲取網站資料

在原始資料中提取我們想要的資料 資料篩選

將篩選完成的資料做儲存

完成一個爬蟲需要哪些工具

- Python3.6

- pycharm 專業版

目標網站

圖片之家

https://www.tupianzj.com/

爬蟲程式碼

匯入工具

python 自帶的標準庫

import ssl

系統庫 自動建立儲存資料夾

import os

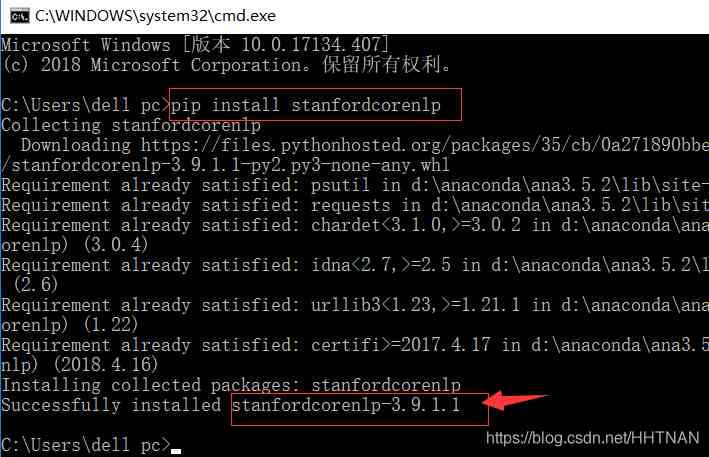

下載包

import urllib.request

網路庫 第三方包

import requests

網頁選擇器

from bs4 import BeautifulSoup

預設請求https網站不需要證書認證

ssl._create_default_https_context = ssl._create_unverified_context

模擬瀏覽器

headers = {

'User-Agent':

'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36',

}

自動建立資料夾

if not os.path.exists('./插畫素材/'):

os.mkdir('./插畫素材/')

else:

pass

請求操作

url = 'https://www.tupianzj.com/meinv/mm/meizitu/' html = requests.get(url, headers=headers).text

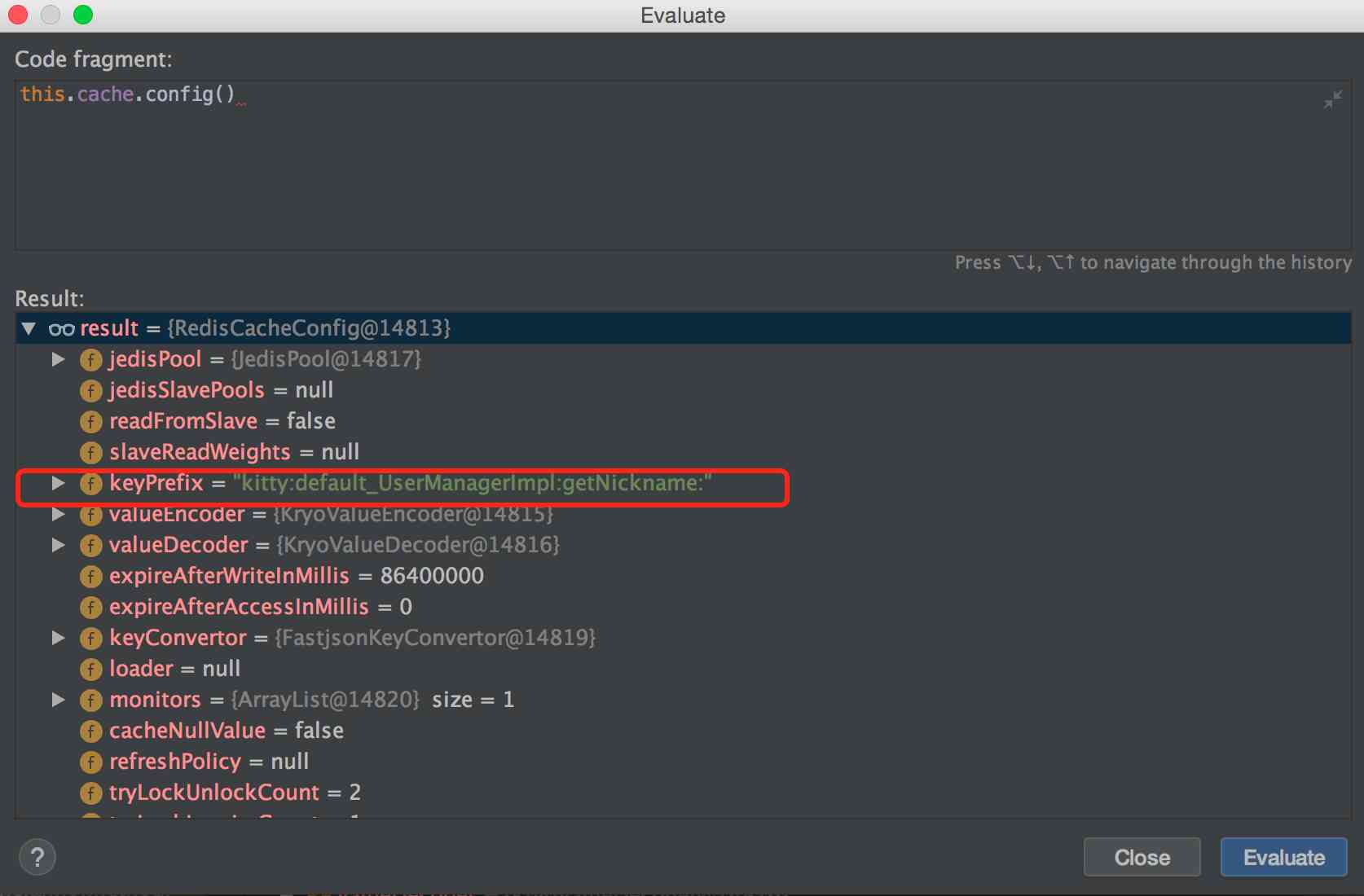

對頁面原始資料做資料提取

soup = BeautifulSoup(html, 'lxml')

images_data = soup.find('ul', class_='d1 ico3').find_all_next('li')

for image in images_data:

image_url = image.find_all('img')

for _ in image_url:

print(_['src'], _['alt'])

下載

try:

urllib.request.urlretrieve(_['src'], './插畫素材/' + _['alt'] + '.jpg')

except:

pass

效果圖

版权声明

本文为[itread01]所创,转载请带上原文链接,感谢

https://www.itread01.com/content/1604499424.html

边栏推荐

- (1)ASP.NET Core3.1 Ocelot介紹

- nlp模型-bert从入门到精通(二)

- Pattern matching: The gestalt approach一种序列的文本相似度方法

- DevOps是什么

- 6.8 multipartresolver file upload parser (in-depth analysis of SSM and project practice)

- GUI 引擎评价指标

- Menu permission control configuration of hub plug-in for azure Devops extension

- 如何将分布式锁封装的更优雅

- 自然语言处理-错字识别(基于Python)kenlm、pycorrector

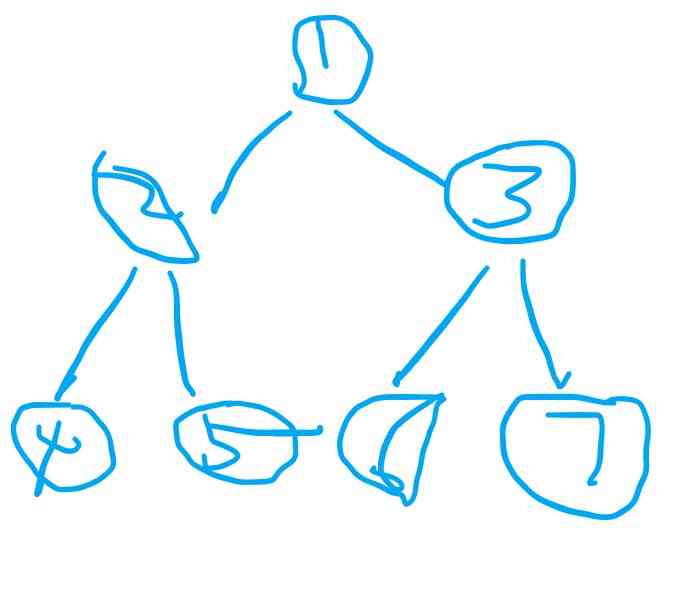

- 遞迴思想的巧妙理解

猜你喜欢

随机推荐

Chainlink将美国选举结果带入区块链 - Everipedia

连肝三个通宵,JVM77道高频面试题详细分析,就这?

WeihanLi.Npoi 1.11.0/1.12.0 Release Notes

Cocos Creator 原始碼解讀:引擎啟動與主迴圈

iptables基礎原理和使用簡介

基于深度学习的推荐系统

Query意图识别分析

GDB除錯基礎使用方法

Jmeter——ForEach Controller&Loop Controller

【Flutter 實戰】pubspec.yaml 配置檔案詳解

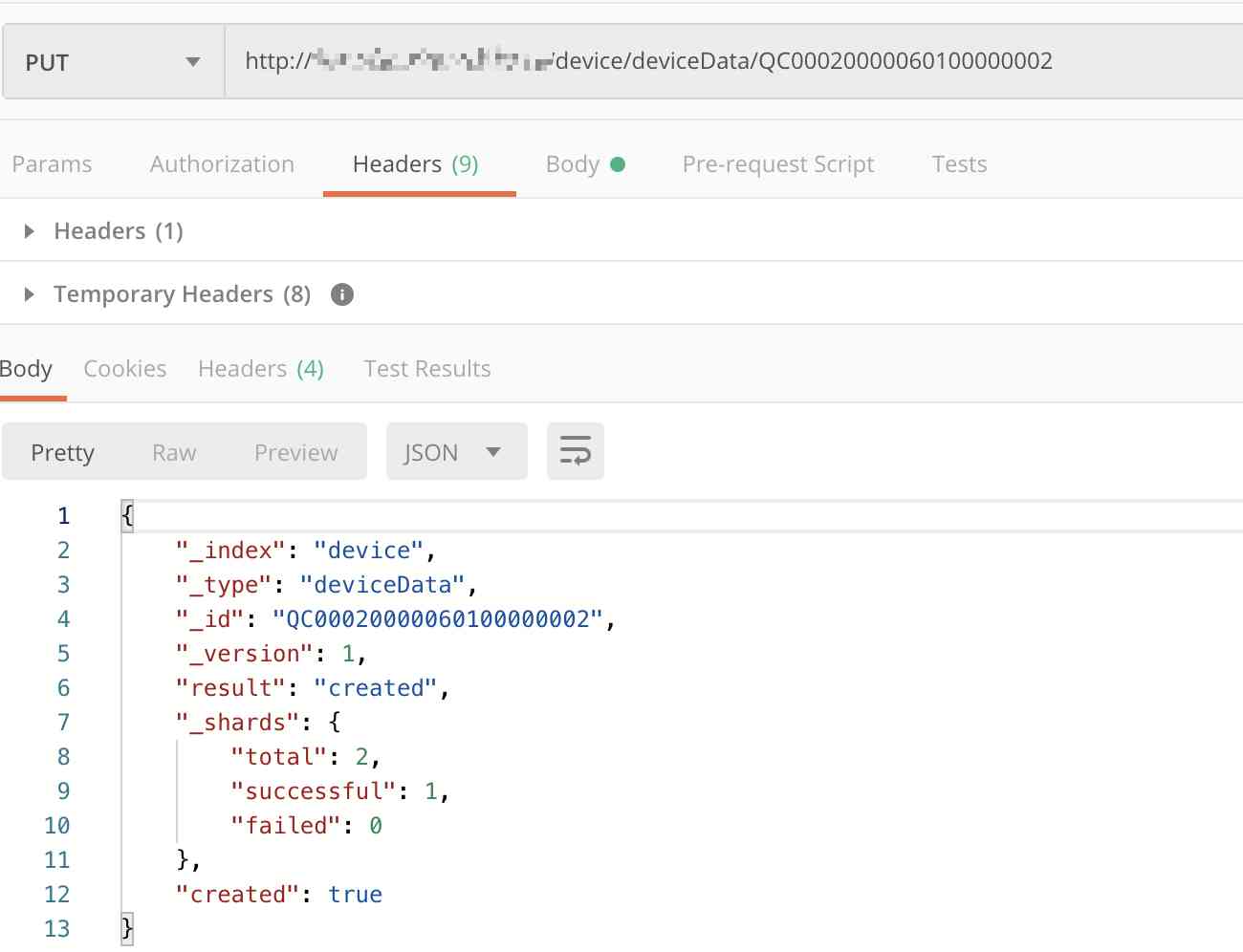

Elasticsearch database | elasticsearch-7.5.0 application construction

分布式ID生成服务,真的有必要搞一个

条码生成软件如何隐藏部分条码文字

Top 10 best big data analysis tools in 2020

如何成为数据科学家? - kdnuggets

什么是无副作用的函数方法?如何取名? - Mario

Python自动化测试学习哪些知识?

JVM内存区域与垃圾回收

用Python构建和可视化决策树

业内首发车道级导航背后——详解高精定位技术演进与场景应用