当前位置:网站首页>第一章 MapReduce概述

第一章 MapReduce概述

2022-07-06 09:29:00 【留不住斜阳】

1.1 MapReduce定义

MapReduce是一个分布式应用程序的编程框架,是用户开发“基于Hadoop的数据分析应用”的核心框架。

MapReduce核心功能是将用户编写的业务逻辑代码和自带默认组件整合成一个完整的分布式运算程序,并发运行在一个Hadoop集群上。

1.2 MapReduce优缺点

1.2.1 优点

(1) MapReduce易于编程,简单的实现一些借口,就可以完成一个分布式程序,这个分布式程序可以分布到大量廉价的PC机器上运行。跟写简单的串行程序是一模一样的。

(2) 良好的扩展性,计算资源不足时,可以通过增加机器来扩展计算能力。

(3) 高容错性,MapReduce设计初衷就是使程序能够部署在廉价的PC的机器上,这需要它具有很高的容错性。例如,其中一台机器挂了,它可以把上面的计算任务转移到另外一个节点上运行,不至于整个任务失败,且这个过程不需要人工参与,完全由Hadoop内部完成的。

(4) 适合PB级以上海量数据处理,可以实现上千台服务器集群并发工作,提供数据处理能力。

1.2.2 缺点

(1) 不擅长实时计算,MapReduce无法像MySQL一样,在毫秒或秒级内返回结果。

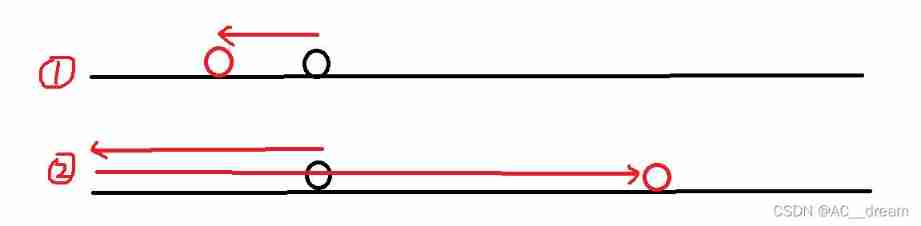

(2) 不擅长流式计算,流式计算输入数据是动态的,而MapReduce的输入数据是静态的,不能动态变化。由MapReduce适合批处理特性决定的。

(3) 不擅长DAG(有向图)计算,多个应用程序存在依赖关系,后一个应用程序的输入为前一个的输出。在这种情况下,MapReduce并不是不能做,而是MapReduce作业的输出结果都会写入到磁盘,会造成大量的磁盘IO,导致性能非常低下。

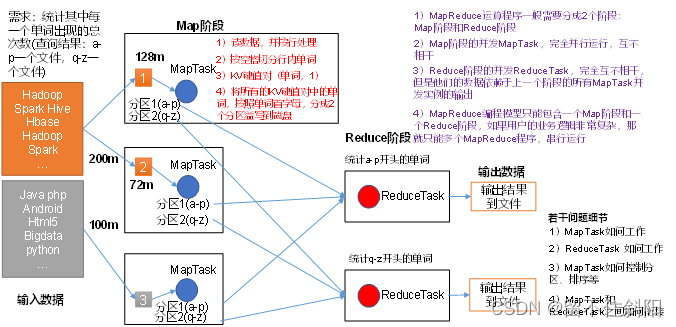

1.3 MapReduce核心思想

(1) 分布式的运算程序往往需要分成至少2个阶段。

(2) 第一个阶段的MapTask并发实例,完全并行运行,互不相干。

(3) 第二个阶段的ReduceTask并发实例互不相干,但是他们的数据依赖于上一个阶段的所有MapTask并发实例的输出。

(4) MapReduce编程模型只能包含一个Map阶段和一个Reduce阶段,如果用户的业务逻辑非常复杂,那就只能多个MapReduce程序,串行运行。

1.4 MapReduce进程

一个完整的MapReduce程序在分布式运行时有三类实例进程

- MrAppMaster:负责整个程序的过程调度及状态协调;

- MapTask:负责Map阶段的整个数据处理流程;

- ReduceTask:负责Reduce阶段的整个数据流程;

1.5 常用数据序列化类型

常用的数据类型对应的Hadoop数据序列化类型,如下表所示

| Java类型 | Hadoop Writable类型 |

|---|---|

| boolean | BooleanWritable |

| byte | ByteWritable |

| int | IntWritable |

| float | FloatWritable |

| long | LongWritable |

| double | DoubleWritable |

| String | Text |

| map | MapWritable |

| array | ArrayWritable |

1.6 MapReduce编程规范

用户编写的程序分成三个部分:Mapper、Reducer和Driver。

Mapper阶段

- 用户自定义的Mapper要继承Mapper父类;

- Mapper的输入数据是KV对的形式(KV类型可自定义);

- Mapper中的业务逻辑写在map()方法中;

- Mapper的输出数据是KV对的形式(KV类型可自定义);

- map()方法(MapTask进程)对每一个<K,V>调用一次;

Reducer阶段

- 用户自定义的Reducer要继承Reducer父类;

- Reducer的输入数据类型对应Mapper的输出数据类型,也是KV;

- Reducer的业务逻辑在reduce()方法中;

- ReduceTask进程对每一组相同K的<k, v>组调用一次reduce()方法;

Driver阶段

- 相当于YARN集群的客户端,用于提交整个程序到YARN集群,提交的是封装了MapReduce程序相关运行参数的Job对象;

1.7 WordCount案例

1.需求

在给定的文本文件中统计输出每一个单词出现的总次数

2.需求分析

按照MapReduce编程规范,分别编写Mapper,Reducer,Driver,如图所示

输入数据

java hello apple

hadoop spark

spark java hello

hello

输出数据

apple 1

hadoop1

hello 3

java 2

spark 2

编写Mapper

- 将MapTask传过来的文本内容转换成string

- 根据空格将一行切分成单词

- 将单词输出为<单词, 1>

编写Reducer

- 汇总各个key的个数;

- 输出key的总个数;

编写Driver

- 获取配置信息,获取Job实例对象;

- 指定本程序jar包所在本地路径;

- 关联Mapper/Reducer业务类;

- 指定Mapper输出数据的kv类型;

- 指定最终输出数据的kv类型;

- 指定输入数据的目录;

- 指定输出结果所在路径;

- 提交作业;

3.环境准备

(1) 创建maven工程

(2) 在pom.xml文件中添加如下依赖

<dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>RELEASE</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>2.8.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.2</version>

</dependency>

</dependencies>

(3) 在项目的src/main/resources目录下,新建一个文件命名为“log4j.properties”,在文件中填入。

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

4.编写程序

(1) 编写Mapper类

package com.test.mapreduce;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

public class WordcountMapper extends Mapper<LongWritable, Text, Text, IntWritable>{

Text k = new Text();

IntWritable v = new IntWritable(1);

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 1 获取一行

String line = value.toString();

// 2 切割

String[] words = line.split(" ");

// 3 输出

for (String word : words) {

k.set(word);

context.write(k, v);

}

}

}

(2) 编写Reducer类

package com.test.mapreduce.wordcount;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

public class WordcountReducer extends Reducer<Text, IntWritable, Text, IntWritable>{

int sum;

IntWritable v = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values,Context context) throws IOException, InterruptedException {

// 1 累加求和

sum = 0;

for (IntWritable count : values) {

sum += count.get();

}

// 2 输出

v.set(sum);

context.write(key,v);

}

}

(3) 编写Driver驱动类

package com.test.mapreduce.wordcount;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordcountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

// 1 获取配置信息以及封装任务

Configuration configuration = new Configuration();

Job job = Job.getInstance(configuration);

// 2 设置Driver类

job.setJarByClass(WordcountDriver.class);

// 3 设置map和reduce类

job.setMapperClass(WordcountMapper.class);

job.setReducerClass(WordcountReducer.class);

// 4 设置map输出

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

// 5 设置最终输出kv类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// 6 设置输入和输出路径

FileInputFormat.setInputPaths(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

// 7 提交

boolean result = job.waitForCompletion(true);

System.exit(result ? 0 : 1);

}

}

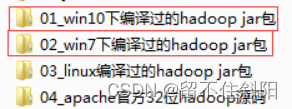

5.本地测试

(1) 如果电脑系统是win7的就将win7的hadoop jar包解压到非中文路径,并在Windows环境上配置HADOOP_HOME环境变量。如果是电脑win10操作系统,就解压win10的hadoop jar包,并配置HADOOP_HOME环境变量。

注意:win8电脑和win10家庭版操作系统可能有问题,需要重新编译源码或者更改操作系统。

(2) 在Eclipse/Idea上运行程序

6.集群上测试

用maven打jar包,需要添加的打包插件依赖

注意:com.test.mr.WordcountDriver需要替换为自己工程主类

<build>

<plugins>

<plugin>

<artifactId>maven-compiler-plugin</artifactId>

<version>2.3.2</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<artifactId>maven-assembly-plugin </artifactId>

<configuration>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

<archive>

<manifest>

<mainClass>com.test.mr.WordcountDriver</mainClass>

</manifest>

</archive>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

注意: 如果工程上显示红叉。在项目上右键->maven->update project即可。

将程序打成jar包,然后拷贝到Hadoop集群中

执行WordCount程序

[[email protected] software]$ hadoop jar wc.jar

com.test.wordcount.WordcountDriver /user/test/input /user/test/output

边栏推荐

- antd upload beforeUpload中禁止触发onchange

- 860. Lemonade change

- Suffix expression (greed + thinking)

- 软通乐学-js求字符串中字符串当中那个字符出现的次数多 -冯浩的博客

- 原生js实现全选和反选的功能 --冯浩的博客

- 业务系统兼容数据库Oracle/PostgreSQL(openGauss)/MySQL的琐事

- Opencv learning log 27 -- chip positioning

- Base dice (dynamic programming + matrix fast power)

- Advancedinstaller installation package custom action open file

- Problem - 922D、Robot Vacuum Cleaner - Codeforces

猜你喜欢

Some problems encountered in installing pytorch in windows11 CONDA

Codeforces Round #802(Div. 2)A~D

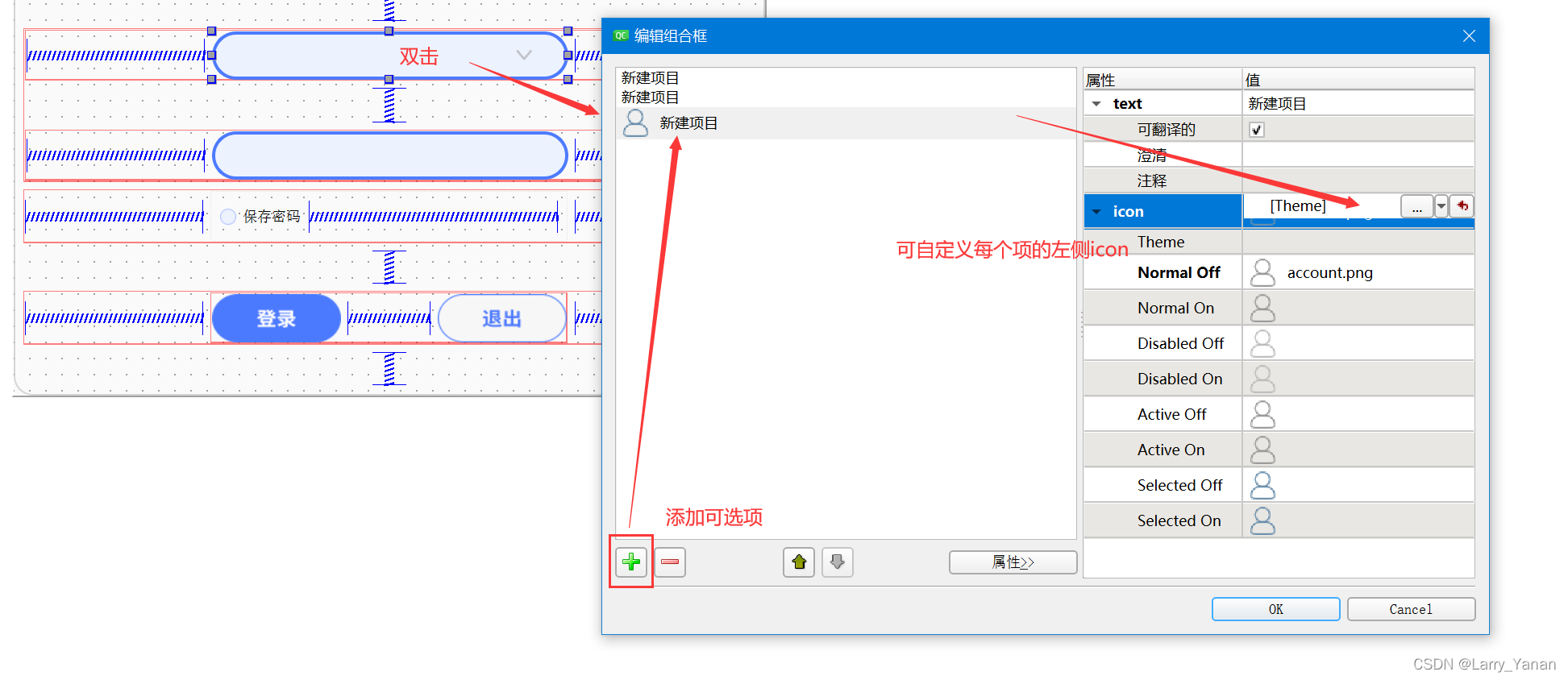

QT style settings of qcobobox controls (rounded corners, drop-down boxes, up expansion, editable, internal layout, etc.)

Codeforces Round #799 (Div. 4)A~H

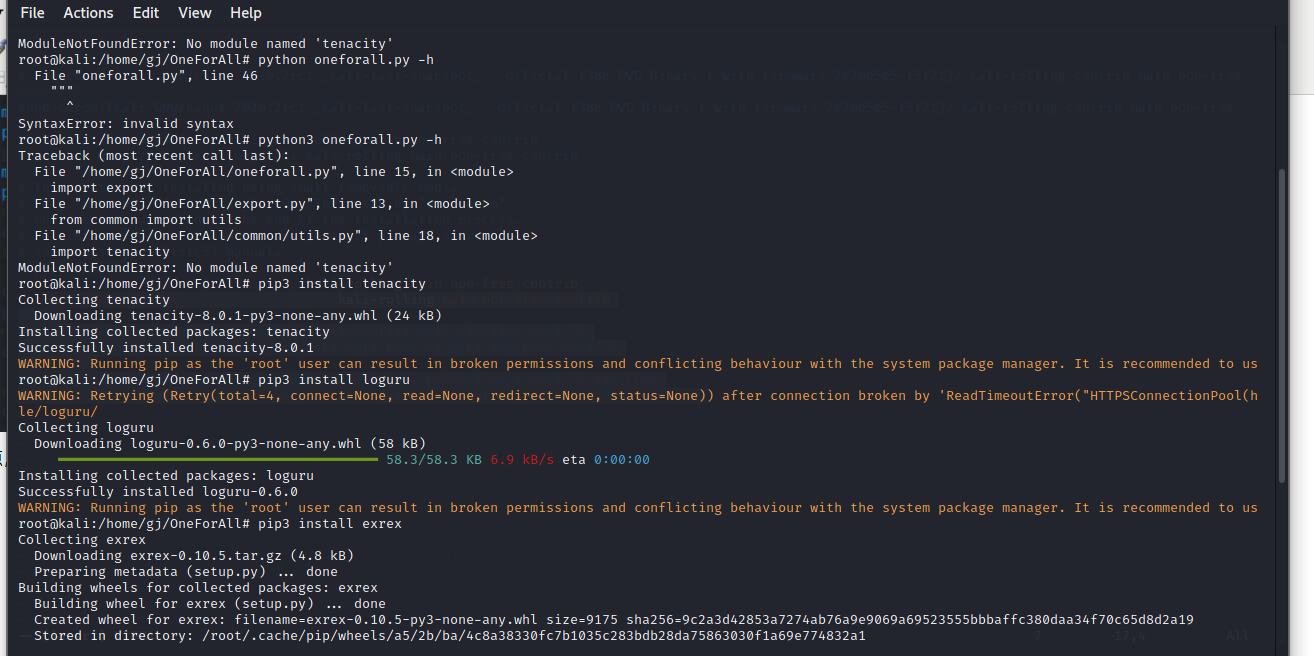

Oneforall installation and use

1323. Maximum number of 6 and 9

去掉input聚焦时的边框

简单尝试DeepFaceLab(DeepFake)的新AMP模型

(lightoj - 1323) billiard balls (thinking)

本地可视化工具连接阿里云centOS服务器的redis

随机推荐

Market trend report, technological innovation and market forecast of double door and multi door refrigerators in China

Summary of game theory

MariaDB的安装与配置

Bisphenol based CE Resin Industry Research Report - market status analysis and development prospect forecast

1903. Maximum odd number in string

Radar equipment (greedy)

Problem - 922D、Robot Vacuum Cleaner - Codeforces

Click QT button to switch qlineedit focus (including code)

Codeforces Round #799 (Div. 4)A~H

useEffect,函數組件掛載和卸載時觸發

Flask框架配置loguru日志庫

Codeforces - 1526C1&&C2 - Potions

QT实现窗口置顶、置顶状态切换、多窗口置顶优先关系

useEffect,函数组件挂载和卸载时触发

Sanic异步框架真的这么强吗?实践中找真理

Local visualization tools are connected to redis of Alibaba cloud CentOS server

Opencv learning log 27 -- chip positioning

计算时间差

“鬼鬼祟祟的”新小行星将在本周安全掠过地球:如何观看

Date plus 1 day