当前位置:网站首页>「博士毕业一年,我拿下 ACL Best Paper」

「博士毕业一年,我拿下 ACL Best Paper」

2022-07-06 09:29:00 【字节跳动技术范儿】

在不久前结束的自然语言处理(NLP)领域顶级学术会议 ACL 2021 上,字节跳动 AI Lab 研究员许晶晶完成了她的演讲。

在全球顶会做完分享后,许晶晶感到很欣慰:“没想到,一项如此底层的研究吸引了大家的兴趣,我们辛苦几个月的研究还是有回报的。”

没错,这项「底层的研究」就是荣获本年度 ACL 最佳论文的《Vocabulary Learning via Optimal Transport for Neural Machine Translation》,来自字节跳动 AI Lab 的许晶晶、周浩、甘纯、郑在翔、李磊五位同学正是这项研究的作者。

ACL 是国际自然语言处理领域的顶会,每年夏天的 ACL 会议不仅会吸引世界各大知名科研机构的注意,也是全球主要科技公司的关注焦点。今年的 ACL 共有 3350 篇论文投稿,仅评出一篇最佳论文,是整场会议的最高奖项。

此外,在本届 ACL 上,字节跳动 AI Lab 一共中选了 11 篇论文。

「词表」,NLP 底层研究

这篇荣获最佳论文的研究,主要聚焦在了「词表」方向。

词表,就是把完整句子拆开的一组数据,可以按词拆、按字母拆、按音节拆,每种拆法都可以有不同的意义和理解。

就像中文里「上课」是一个意思,「上」和「课」两个字单独拿出来又分别有不同的意思。

我们熟知的各种 NLP 方向的应用,比如机器翻译、文本纠错、聊天机器人等,都离不开词表这个基础,词表是机器学习的基本数据,是实现各类AI功能的养料。

可以说,词表是 NLP 各个方向应用的「地基」,把词表做好,可以提升各种不同 NLP 任务的表现。

在这篇论文里,字节跳动 AI Lab 的同学通过实验得出了词表大小和词表信息量与机器学习模型训练中的一些关系,这些规律可以进一步推动 NLP 科研界解决「什么是好的词表」这个问题。

在此基础之上,字节跳动的研究员们还提出了一种新的词表学习方案「VOLT」,在常见的英-德翻译、英-法翻译以及多语言自动翻译上,VOLT不仅能比传统的方法获得更好的翻译结果,使用的词表数据体积也大大减小。

比如在英-德翻译中,这种新方法将传统方法所需的词表数据减少了70%。

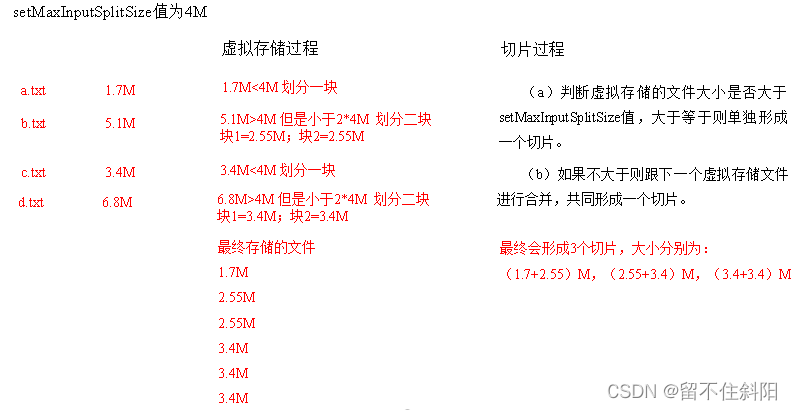

最下面两行为

VOLT 相比传统方法减小的词表数据体积

此外,字节跳动的一系列 NLP 相关研究,已经成功应用在了火山翻译及西瓜视频、飞书等产品的翻译功能中,无论是在字节同学或飞书客户的办公沟通中,还是在用户观看外语视频的场景下,这些研究正在从最基础的维度不断提升着用户体验。

博士毕业后的第一项工作成为Best paper

这项研究的一作许晶晶 2020 年博士毕业于北京大学,这项关于词表的研究也是她校招加入字节跳动后的第一项工作。

入职字节跳动 AI Lab 之后,许晶晶发现这里的氛围高度自驱:“在我们组,你的研究工作并不是 Leader 直接给你一个方向,而是自己找感兴趣的方向提出来,如果这个方向的确很重要,那你就可以全心全意投入进去了。”

词表是各类 NLP 研究的第一步,许晶晶所提出的几个研究方向中也包含词表方向:“关于词表,前人的研究已经有了一个方法,大家就直接按这个方法来了,还没有人深入研究探讨当前方法是不是最优解。”

看到许晶晶要做词表的基础研究,Leader 眼前一亮:公司正在做「火山翻译」业务,机器翻译业务是个硬技术,翻译技术越好,产品就越能获得客户的认可,像词表这样的基础组件,研究好了就可以提升机器翻译的效果,对业务起到巨大的作用。

许晶晶就这样在个人兴趣和公司整体发展方向上找到了交集。

但如何找到最佳的词表,其实是个没有人做过的难题。她先搜集了很多词表数据,反复实验来探索不同的词表和具体训练任务之间的关系,初步找到了不同词表和训练任务之间的规律。

发现了这些规律,就可以拿着规律去寻找那个最佳的词表,就像王子拿着灰姑娘的水晶鞋,在全世界寻找灰姑娘本人。

但王国的女孩成千上万,世上的词表也数不胜数,到底怎样才能找到最佳词表呢?许晶晶的研究陷入停滞。

实验日复一日地做着,真理的灵光却一直没有闪现。一筹莫展之际,团队的一次内部分享给了许晶晶灵感。

在字节跳动 AI Lab,有各种不同背景的同学会定期分享各自擅长的内容,有的同学数理思维优异、有的同学有丰富的多语言背景、有的同学对NLP理论研究深厚。在这次内部分享中,一位统计学专业出身的同学做了一次报告,讲到了一些和机器学习相关的数学理论知识。借助这些理论,许晶晶发现可以将此前发现的规律写成目标函数,引入经济学中「边际效益」的概念,通过离散优化来找到最佳的词表,锁定「灰姑娘」所在的区域。

许晶晶事后十分庆幸:“如果同学当时没有做这个报告,可能我们这项关于词表的研究就到此为止了。团队背景的多样化,的确有助于每个人拓宽自己的认知,启发研究的灵感。”

虽然有了新灵感的启发,但在茫茫人海中寻找「灰姑娘」的过程依然充满艰辛。持续数月的时间里,许晶晶每天都在重复着提出解决办法、做实验跑一遍、发现办法不管用、找其他同学沟通寻找启发的无限循环。

“虽然可以问别人,但组里同学并不是这项工作的主导者,他们会帮我建模、给一些意见或者解决别的问题,但核心工作必须自己一个人思考、想想问题在哪里、反思实验为什么失败。大部分时间还是自己在跟自己沟通,必须耐得住寂寞。”

苦闷的时间不断重复,“我曾经很长时间都很郁闷,但科研就是这样一件事,你会在很郁闷的时间里度过很长时间,你怎么都解不出来,就像解不出一道数学题一样,很痛苦。”

许晶晶甚至想过放弃,去研究别的方向,但同学们告诉她:“词表是很有价值的 NLP 基础研究,这个方向非常有前途,而且你已经做了这么多工作,可不要半途而废啊!”

在 Leader 的鼓励下,许晶晶又坚持了一个月。直到有一天,又一次实验失败的许晶晶垂头丧气地跑去食堂,看着眼前的饭菜,脑子里却都是实验的思路和过程。突然,一个灵感来了:把之前的方法简化一下,是不是就可以了?

饭后她又赶紧回到办公室,按照新的灵感重新部署了实验。实验结果证明,这个持续了半年的研究成功了。

但好的实验结果往往只是成功的一半,还需要发表正规的论文向科研界介绍。许晶晶看了一下时间,机器学习顶会 ICLR 2021 论文征集即将截止,留给她的时间只有7天。

虽然论文写得很快,但时间实在太仓促,ICLR 毫不意外地拒稿了。但 ICLR 的评审也给出了很多负责任的意见,建议她补充更多说明和实验证明。

基础理论的研究往往艰难晦涩,研究作者团队陷入了反复的改论文过程,他们常常会把自己「分裂」成两个人:一个人作为研究者,讲述这项研究的内容;一个人作为评审者,试图理解论文到底讲了什么。

大改了 3 个月之后,许晶晶把论文投给了 NLP 顶会 ACL 2021。在 ACL 的规则里,会有 3 位双盲评审(作者和评审互相不知道对方是谁)同时看同一篇论文,满分 5 分,大部分能中选的论文会拿到 3~3.5 分左右的分数,4 分以上就已经相当罕见了,而这篇论文有两位评审直接给了 5 分,第三位评审的分数也接近满分。在这样的高分之下,字节跳动 AI Lab团队的这篇论文获得推荐,最终中选本届 ACL 最佳论文奖。

获奖秘诀:长时间投入底层研究

博士毕业后的第一项工作就拿到了顶会 Best Paper,许晶晶觉得这和团队的支持密切相关:“我们团队背景很多元,有数学好的、有工程能力很强的、有 NLP 背景很强的,多元背景可以启发研究思路,并且还有丰富的训练资源,可以支持你来做大型实验。”

除了多元背景,更让许晶晶珍视的是团队「沉浸式」的科研氛围:“能拿到 Best Paper,首先我们的方向很重要,我们没有选择主流的在单个任务上做提升的方向,而是选择了比较小众的赛道,虽然基础但是没有很多人来研究,但基础研究的匮乏是整个业界都面临的问题,因为要长时间深入思考,没有那么立竿见影。我们团队的氛围刚好很宽松,不会被 push 要求你短时间内就有成果,可以长时间投入到重要的事情上去,做长期的工作。”

在 NLP 领域里,如果是研究翻译、对话等某一个具体任务,对具体场景做针对性的优化,效果会更好;但基础组件可以用在每个不同的领域里。因此,基础研究的提升对于每个具体的不同场景都可以起到推动作用。

在许晶晶看来,整个NLP行业都需要一些创新型的东西,让基础研究和具体任务都能得到进步和发展,“我们这篇论文的意义就是让大家重新思考,词表还有更大的空间。”

获奖论文链接:

https://arxiv.org/abs/2012.15671

GitHub地址:

https://github.com/Jingjing-NLP/VOLT

字节跳动更多技术应用

字节跳动多篇论文入选 CVPR 2021,精选干货都在这里了

100张图训练1小时,照片风格随意变,文末有Demo试玩|SIGGRAPH 2021

边栏推荐

- 我走过最迷的路,是字节跳动程序员的脑回路

- Market trend report, technical innovation and market forecast of China's desktop capacitance meter

- Market trend report, technical innovation and market forecast of double-sided foam tape in China

- [unsolved] 7-15 shout mountain

- Research Report on market supply and demand and strategy of Chinese table lamp industry

- 7-10 punch in strategy

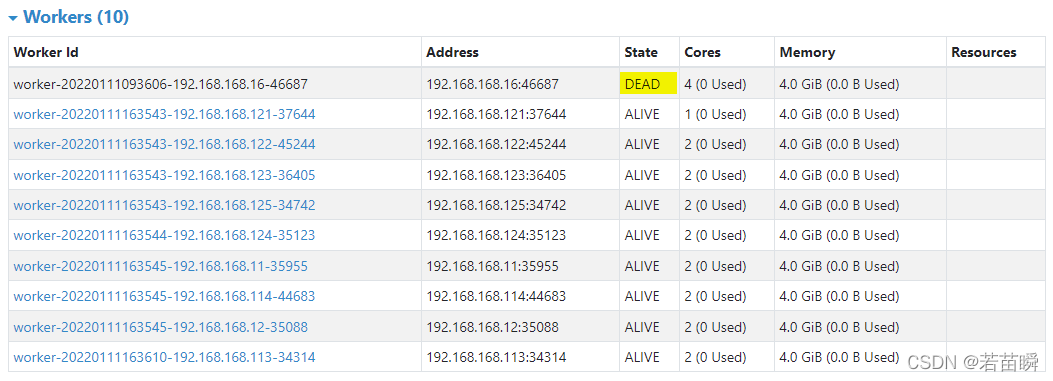

- Spark independent cluster dynamic online and offline worker node

- Market trend report, technological innovation and market forecast of China's double sided flexible printed circuit board (FPC)

- FLV格式详解

- ByteDance new programmer's growth secret: those glittering treasures mentors

猜你喜欢

Audio and video development interview questions

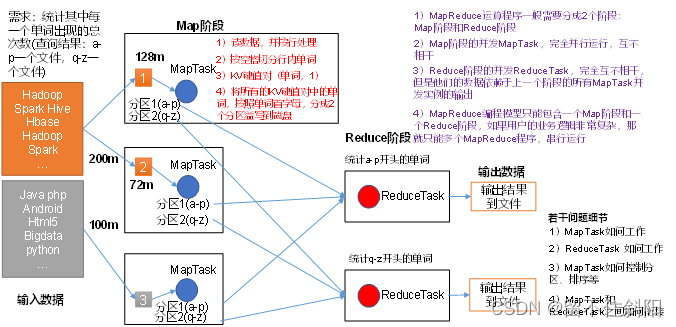

第三章 MapReduce框架原理

7-10 punch in strategy

Remove the border when input is focused

LeetCode 1641. Count the number of Lexicographic vowel strings

Solve the single thread scheduling problem of intel12 generation core CPU (II)

Spark独立集群动态上线下线Worker节点

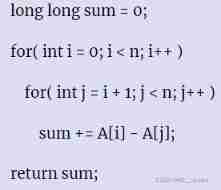

(lightoj - 1369) answering queries (thinking)

第一章 MapReduce概述

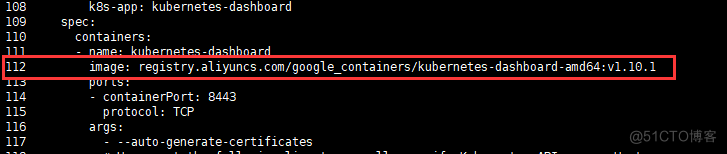

Kubernetes集群部署

随机推荐

The concept of spark independent cluster worker and executor

js时间函数大全 详细的讲解 -----阿浩博客

ByteDance new programmer's growth secret: those glittering treasures mentors

Educational Codeforces Round 122 (Rated for Div. 2)

两个礼拜速成软考中级软件设计师经验

SQL快速入门

Chapter 2 shell operation of hfds

LeetCode 1560. The sector with the most passes on the circular track

LeetCode 1557. The minimum number of points that can reach all points

(lightoj - 1323) billiard balls (thinking)

LeetCode 1562. Find the latest group of size M

图像处理一百题(1-10)

Solve the problem that intel12 generation core CPU single thread only runs on small cores

解决Intel12代酷睿CPU【小核载满,大核围观】的问题(WIN11)

7-4 harmonic average

业务系统从Oracle迁移到openGauss数据库的简单记录

7-5 blessing arrived

LeetCode 1640. Can I connect to form an array

SF smart logistics Campus Technology Challenge (no T4)

简单尝试DeepFaceLab(DeepFake)的新AMP模型