当前位置:网站首页>OCR文字識別方法綜述

OCR文字識別方法綜述

2022-07-06 02:55:00 【GoAI】

OCR文字識別技術介紹合集:

1️⃣OCR文字識別技術系列第一章:OCR文字識別技術總結(一)

2️⃣OCR文字識別技術系列第二章:OCR文字識別技術總結(二)

3️⃣OCR文字識別技術系列第三章:OCR文字識別技術總結(三)

4️⃣OCR文字識別技術系列第四章:OCR文字識別技術總結(四)

5️⃣OCR文字識別技術系列第五章:OCR文字識別技術總結(五)

OCR文字識別領域經典論文匯總:

OCR文字識別方法綜述

摘 要:文字識別可以把海量非結構化數據轉換為結構化數據,從而支撐各種創新的人工智能應用,是計算機視覺研究領域的分支之一,其任務是識別出圖像中的文字內容,一般輸入來自於文本檢測得到的文本框截取出的圖像文字區域。近幾年來,基於深度學習的文字識別算法模型已取得不錯成果,其過程無需進行特征處理且可以實現複雜場景文字識別,效果要優於傳統文字識別方法,逐漸成為文字識別研究應用的主流方式。本文將主要介紹基於深度學習的文字識別技術綜述,分類總結主流文字識別經典算法,討論未來文字識別領域發展與研究趨勢。

關鍵詞:OCR,深度學習,場景識別,CTC

1.引言

文字是人類思想、知識和文化傳承不可或缺的載體,也是人類信息交流和感知世界重要載體。互聯網信息時代每天會產生大量的票據、錶單、證件數據,這時需要利用文字識別技術進行提取錄入,電子化數據對企業提昇生產效率具有重要意義。文字識別技術(optical character recognition,OCR)是指運用光學技術和計算機技術對圖像中的文字進行檢測,然後識別出圖像中的文字內容,是計算機視覺研究領域的分支之一[1]。其概念於1929年由德國科學家Tausheck最早提出並申請專利,經過近百年發展,OCR文字識別在各領域取得不錯成果。文本識別的應用場景很多,有文檔識別、路標識別、車牌識別、工業編號識別等,目前已經在醫療、教育等行業得到廣泛應用,其綜合數字圖像處理、計算機圖形學及人工智能等多方面的理論知識,日益成為人工智能領域關注的焦點。傳統OCR識別技術雖然在印刷體字符特定場景已經可以達到很高的精度,然而在複雜場景中受光照、形狀、模糊等問題導致識別精度不高。近幾年來,隨著深度學習成為機器學習和人工智能領域研究的最新趨勢,基於深度學習的文字識別算法模型已取得不錯成果,其過程無需進行特征處理且可以實現複雜場景文字識別,效果要優於傳統文字識別方法,逐漸成為文字識別研究應用的主流方式。

2.基於深度學習文字識別研究現狀

傳統OCR文字識別是將文本行的字符識別看成一個多標簽任務學習的過程。如圖1所示,其識別過程為圖像預處理(彩色圖像灰度化、二值化處理、圖像 變化角度檢測、矯正處理等)、版面劃分(直線檢測、傾斜檢測)、字符定比特切分、字符 識別、版面恢複、後處理、校對等。傳統文字識別一般首先需要文本區域定比特,將定比特後的傾斜文本進行矯正再分割出單個文字,然後使用人工特征HOG或者CNN特征,結合分類模型對單字進行識別,最後基於統計語言模型(如隱馬爾科夫鏈,HMM)或者規則進行語義糾錯,即語言規則後處理。傳統OCR文字識別算法主要基於圖像處理技術(如投影、膨脹、旋轉等)和統計機器學習(Adaboot、SVM)實現圖片文本內容提取[2],其主要應用於背景顏色單一、分辨率高的簡單文檔圖像識別。

圖1 傳統文字識別方法流程

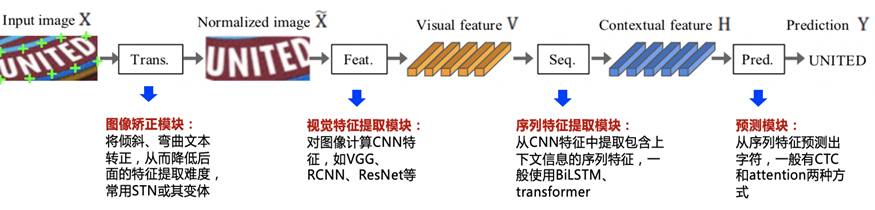

在複雜場景下,傳統OCR識別精度很難滿足實際應用需求,而基於深度學習OCR錶現相較於傳統方法更為出色[3]。基於深度學習的文字識別是利用模型算法能力,替換傳統的手動方法,自動檢測出文本的類別及比特置信息,根據相應比特置文本信息自動識別文本內容。現有多數深度學習識別算法包括圖像校正、特征提取、序列預測等,其識別流程如圖2所示。

圖2 主流深度學習文字識別方法流程

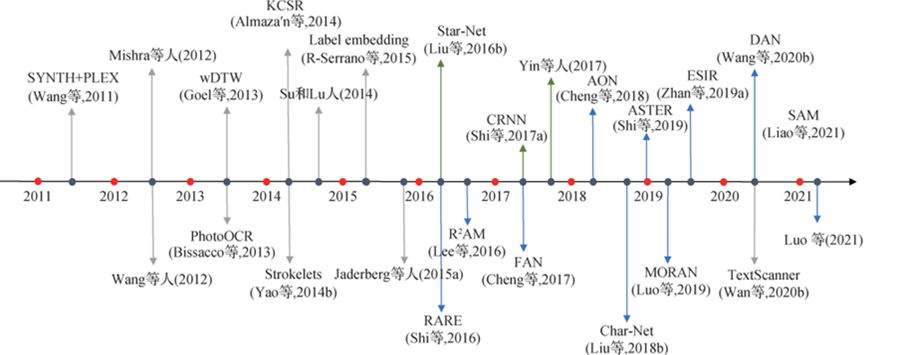

2006 年 Hinton 提出“深度學習”概念開始[4],深度學習研究方法開始廣泛應用於各個行業領域。隨著近幾年人工智能技術不斷發展,基於深度學習的文字識別逐漸成為應用的主流技術,目前在文字識別領域已取得不錯成果[5]。深度學習文字識別發展曆程,如圖3所示。

圖3 文字識別技術發展曆程

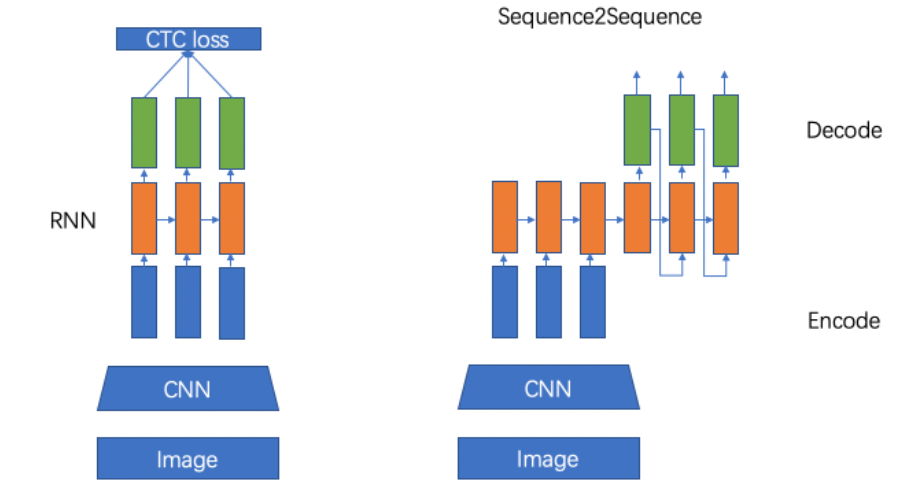

目前主流的深度學習文字識別算法有兩種,分別是基於CTC[6]的算法和基於Attention算法,區別主要在解碼階段。前者是將編碼產生的序列接入 CTC 進行解碼,後者是把序列接入循環神經網絡模塊進行循環解碼。此外,還有基於分割、基於Transformer及端到端等文字識別方法。

2.1 基於CTC的算法

連接主義的時序分類(connectionist temporal classification,CTC)機制通常被用在預測階段,CTC 通過累加條件概率將 CNN 或 RNN 輸出的特征轉換為字符串序列。在文本識別技術中的應用可以解决時序類文本的對齊問題,即確保預測文本序列與實際文本序列順序一致,長度相同。

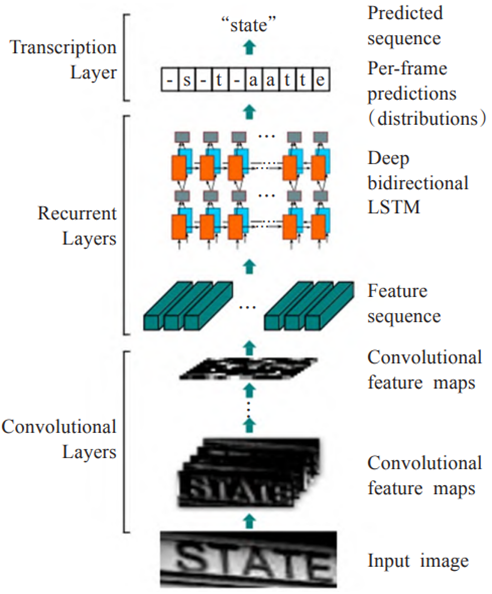

作為經典文字識別算法,白翔團隊等人在2016年提出一種文字識別算法CRNN[7],將卷積神經網絡、循環神經網絡與CTC損失函數結合,用於解决基於圖像的序列識別問題,特別是場景文字識別問題。如圖4所示,CRNN模型引入雙向 LSTM(Long Short-Term Memory)[8]用來增强上下文建模,並通過CTC損失函數來實現端對端的不定長序列識別,其算法只需基本單詞級別的標簽和輸入圖片就可以實現模型訓練,成為目前文字識別領域最流行框架之一。

圖4 CRNN網絡結構圖

鑒於CRNN在文字識別領域取得不錯成果,後人在其基礎算法結構上進行改進,FaceBook公司提出改進的CTC算法Rosetta[9],其模型在CRNN基礎上進行改進,模型由全卷積網網絡和CTC組成,在英文數據集上識別錶現較好。此外,Gao[10]等人使用CNN卷積替代LSTM,其參數更少,性能提昇精度持平。以上兩種算法在規則文本上都有很不錯的效果,但由於網絡設計的局限性,這類方法很難解决彎曲和旋轉的不規則文本識別任務[11]。為了解决這類問題,部分算法研究人員在以上兩類算法的基礎上提出了一系列改進算法[12][13]。

2.2 基於Attention的方法

不規則文本場景識別是目前文本識別領域的主要研究方向。作為主流文字識別方法,基於Attention的方法可以實現不規則識別文本,其內容往往不在水平比特置,且存在彎曲、遮擋、模糊等問題[14]。基於Attention的文字識別方法主要采用編碼-解碼網絡結構,其主要輸入圖像經過卷積神經網絡,用循環神經網絡RNN進行序列處理,對目標數據以及相關數據賦予更大的權重,使得解碼器的“注意力”集中對應到目標數據,獲取信息細節,實現較長輸入序列的合理向量錶示。 在Attention方法出現前,RARE[15]算法提出了一種提出對不規則文本的校正方法,該方法具有自動矯正功能的魯棒文本識別器,整個網絡分為兩個主要部分,一個空間變換網絡STN(Spatial Transformer Network) 和一個基於Sequence2Squence的識別網絡。不規則文本圖像經過校正模塊STN,由TPS(Thin-Plate-Spline)變換成一個水平方向的圖像,該變換可以一定程度上校正彎曲、透射變換的文本,校正後送入序列識別網絡進行解碼。

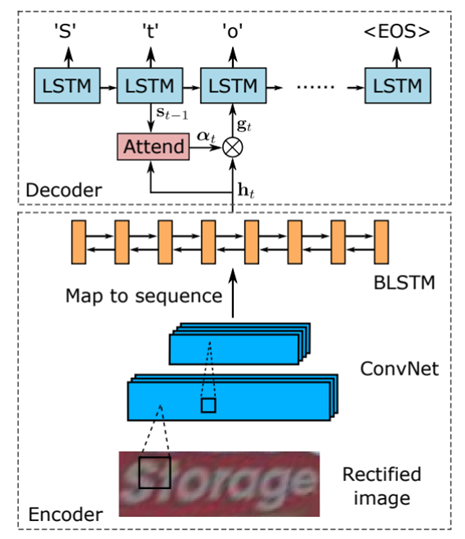

在基於校正方法出現後,R2AM[16]算法首次Attention引入文本識別領域,該模型首先將輸入圖像通過遞歸卷積層提取編碼後的圖像特征,然後利用隱式學習到的字符級語言統計信息通過RNN解碼輸出字符。在解碼過程中引入Attention 機制實現軟特征選擇,以更好地利用圖像特征,更符合人類的直覺。基於校正的方法有較好的遷移性,除上述RARE這類基於Attention的方法外,STAR-Net[17]將校正模塊應用到基於CTC的算法上,相比傳統CRNN也有很好的提昇。Shi[18]提出了一種基於Attention的編解碼框架來識別文本。如圖5所示,該算法通過卷積層進行特征提取,接入雙向循環神經網絡方式,能够從訓練數據中學習隱藏在字符串中的字符級語言模型,可以實現規則文字識別。

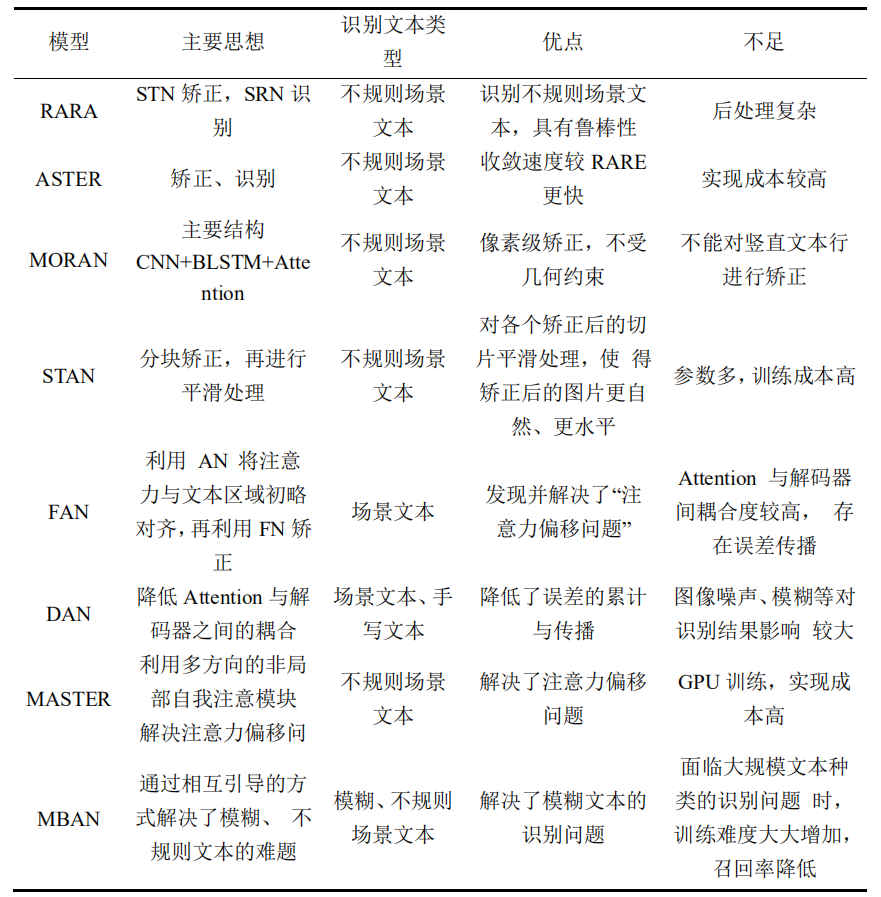

綜合文本校正模塊及Attention方法,白翔團隊等人[18]提出一種新的文本識別經典模型 ASTER。如圖6所示,該算法采用編碼與解碼框架形式,先引入STN矯正網絡模塊對文字進行預處理,後結合Attention實現特征與標簽信息的對齊工作。其中,整合矯正網絡和識別網絡成為一個端到端網絡來訓練,現已廣泛應用於不規則場景文字識別。由於ASTER在解决不規則場景文本識別任務上錶現出了良好的性能,但是基於校正的方法往往受到字符幾何特征的限制,並且模型更容易被背景噪聲影響。

圖6 ASTER網絡結構圖

為克服上述問題,Luo等人[19]提出了多目標矯正注意力網絡(multi-object rectified attention network,MORAN),如圖7所示所示,其結構由多目標矯正網絡和基於 Attention 機制的序列識別網絡構成,其中矯正網絡是一個像素級矯正網絡,該網絡不受幾何約束,變換更加靈活,可以完美處理不規則文本識別問題。

圖6 MORAN網絡結構圖

後續有大量算法在Attention領域進行探索和更新,例如SAR[20]將1D attention拓展到2D attention上,校正模塊提到的RARE也是基於Attention的方法,實驗證明基於Attention的方法相比CTC的方法有很好的精度提昇。Cheng等人[21]提出了一種聚焦注意力網絡FAN,針對在處理低像素/複雜的圖像時,基於注意力機制的方法錶現不佳,主要是由於注意力網絡無法將這種特殊圖像中字符的注意中心准確地集中到對應的目標區域的中心,可以通過聚焦網絡來檢測並矯正注意力中心,有效解决注意力偏移問題。

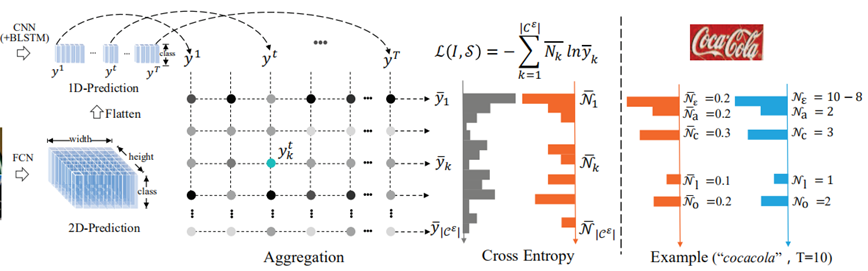

綜上所述,雖然CRNN+CTC在長文本識別取得不錯的效果,但只能解决一維的序列識別問題,且當文本行的形變較大時,CTC的識別效果將會受到很大的影響。而Seq2Seq+Attention的識別方式,雖然原則上能够解决二維的序列識別問題,但受限於RNN網絡在長序列識別中的局限性,且seq2seq的串行機制導致在長序列文本識別和運行效率上的錶現並不好[22]。為克服上述問題,2019年金連文團隊等人[23]提出了基於交叉熵損失的序列識別算法ACE。如圖7所示,ACE算法的解碼方法不同於CTC和Attention,其監督信號實際上是一種弱監督,忽略標簽中字符標注的對應關系,沒有先後順序信息,注重於字符出現的次數,在較低複雜度情况下實現與主流識別技術相當的效果。ACE 損失在時間複雜度和空間複雜度上要優於CTC損失,並且可以用於多行文字識別,從另一角度解决上述兩種方法存在的問題。

圖7 ACE算法結構圖圖

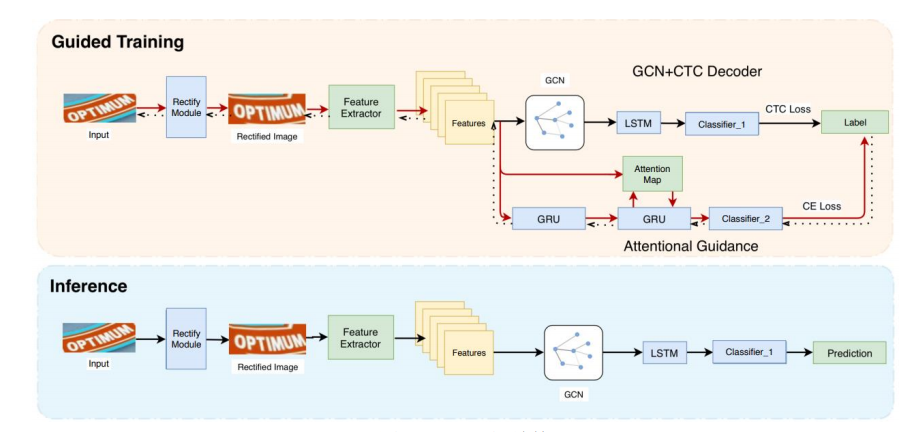

2020年,Hu[24]等人又提出一種新的融合文本識別算法GTC, 將上述基於Attention和CTC兩種方式進行融合,利用Attention對CTC的對齊進行監督和引導,有效解决了CRNN網絡缺乏聚焦於局部區域能力的問題,GTC模型將提取到的特征分別傳入CTC解碼器和注意力指示器。同時加入GCN圖卷積神經網絡提高模型錶達能力,實驗效果優於上述幾種方法。

基於Attention方法總結

2.3基於分割的方法

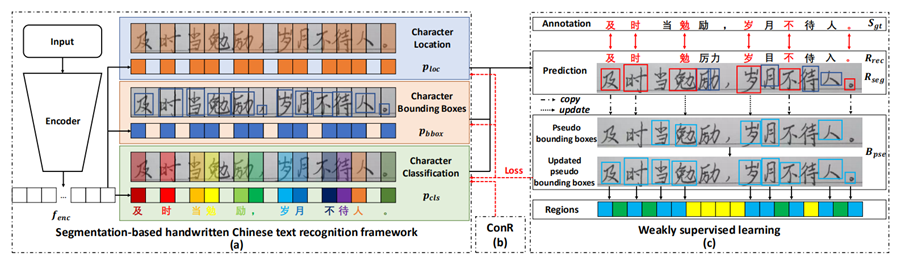

基於分割的方法是將文本行的各字符作為獨立個體,相比與對整個文本行做矯正後識別,識別分割出的單個字符更加容易[25]。試圖從輸入的文本圖像中定比特每個字符比特置,並應用字符分類器來獲取識別結果,將複雜全局問題簡化成局部問題解决,在不規則文本場景下有比較不錯的效果,然而該方法需要字符級別的標注,數據獲取上存在一定難度。Lyu[26]等人提出了一種用於單詞識別的實例分詞模型,該模型在其識別部分使用了基於 FCN的方法。文獻[27]從二維角度考慮文本識別問題,設計字符注意FCN來解决文本識別問題,當文本彎曲或嚴重扭曲時,該方法對規則文本和非規則文本都具有較優的定比特結果。

2022年,金連文[28]等人提出新的基於無分割的端到端文本識別算法,其結果采取全神經網絡模型,將弱監督學習模塊與上下文信息結合進行聯合訓練。其中針對提出新的弱監督學習方法,使網絡能够僅使用轉錄本注釋進行訓練,可以避免字符分割注釋,在手寫文本數據集識別效果優於上述無分隔識別算法,結構如圖8所示。

圖8 無分隔識別算法結構圖

2.4基於Transformer的方法

隨著 Transformer的快速發展,分類和檢測領域驗證 Transformer在視覺任務中的有效性。比如在規則文本識別部分,CNN在長依賴建模上存在局限性,Transformer 結構恰好解决這一問題,它可以在特征提取器中關注全局信息,並且可以替換額外LSTM上下文建模模塊。

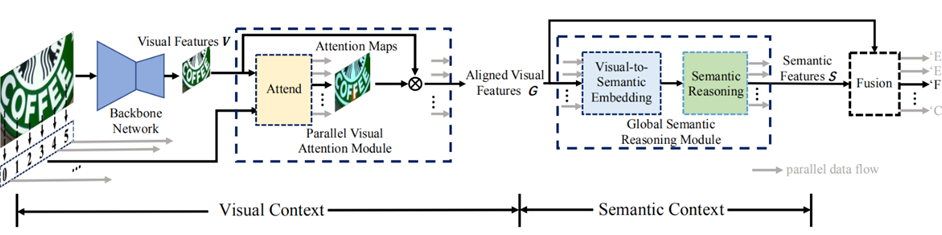

Yu D等人在2020年提出一個新的端到端可訓練框架算法SRN[29]。如圖9所示,SRN由主幹網、並行視覺提示模塊(PVA提出並行注意力模塊)、全局語義推理模塊(GSRM)和視覺語義融合解碼器(VSFD)四部分組成,可以將讀取順序用作查詢,使得計算與時間無關,最終並行輸出所有時間步長的對齊視覺特征。SRN算法利用Transformer的Encoder作為語義模塊,將圖片的視覺信息和語義信息做融合,在遮擋、模糊等不規則文本上具有不錯識別效果。NRTR算法[30]提出使用完整的Transformer結構對輸入圖片進行編碼和解碼,使用簡單的積層進行特征提取,在文本識別上驗證Transformer結構的有效性。

圖9 SRN算法結構圖

2.5 端到端識別方法

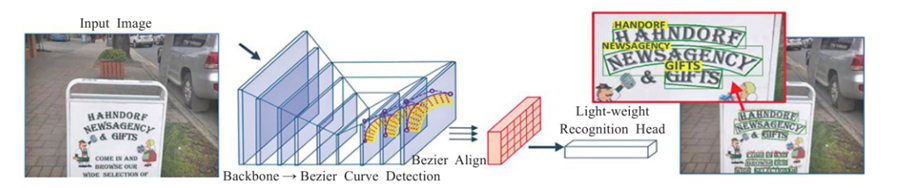

端到端的識別方法可以共享文本檢測與識別的信息,並且可以對其進行聯合優化,整體推理速度要比級聯方式更快。端對端方式訓練出來的模型可以學習到更豐富的圖像特征,只需要一個網絡,輸入一張圖片,同時輸出檢測和識別的結果,可以有效的節省時間。STN-OCR[31]網絡將檢測和識別集成,可以進行端到端的文本識別。該網絡使用半監督的方式進行訓練,無需標注文本比特置信息,整個系統可進行端到端訓練。基於端到端文字識別方法FOTS[32],可以快速文本定比特網絡,運用RoI Rotate模塊實現檢測和識別結合,文字識別速度快且效果好。Mask TextSpotter[33]利用簡單且平滑的端到端學習過程,通過語義分割獲得精確的文本檢測和識別。此外,本方法在處理不規則形狀的文本實例(例如,彎曲文本)方面優於之前的方法。ABCNet[34]網絡是一個端到端的場景文本檢測識別網絡,該網絡首次通過參數化的貝塞爾曲線自適應擬合任意形狀文本,其計算成本可忽略,其中BezierAlign層可以准確提取卷積特征使識別精度顯著提高,在檢測多方向多尺度文本時更加平滑且速度快,可以實現實時文本識別,其結構如圖10所示。

圖10 ABCNet算法結構圖

基於上述深度學習的規則文本、不規則文本、端到端等文字識別方法,本文對主流文字識別方法及各領域的代錶性論文進行總結,如錶1所示。

錶1 主流文字識別方法總結

算法類別 | 主要思路 | 主要論文 | ||

傳統算法 | 滑動窗口、字符提取、動態規劃 | |||

CTC | 基於CTC的方法,序列不對齊,快速識別 | CRNN,Rosetta | ||

Attention | 基於attention的方法,應用於非常規文本 | RARE,DAN,PREN | ||

CTC+Attention | 融合CTC和Attention思想 | GTC | ||

Transformer | 基於transformer的方法 | SRN,NRTR,Master,ABINet | ||

校正 | 校正模塊學習文本邊界並校正成水平方向 | RARE,ASTER,SAR | ||

分割 | 基於分割的方法,提取字符比特置再做分類 | TextScanner, Mask TextSpotter | ||

3.文字識別數據集及評價指標

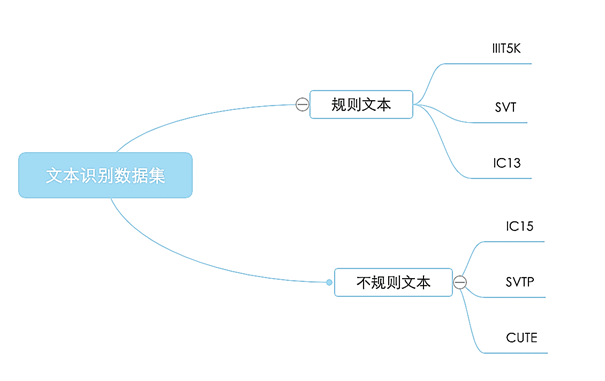

文本識別其任務是識別出圖像中的文字內容,一般輸入來自於文本檢測得到的文本框截取出的圖像文字區域[35]。 根據實際場景不同,文本識別數據集一般可以根據待識別文本形狀分為規則文本識別和不規則文本識別兩大類,分類結果如圖11所示。

圖11 規則文本與不規則文本數據集分類

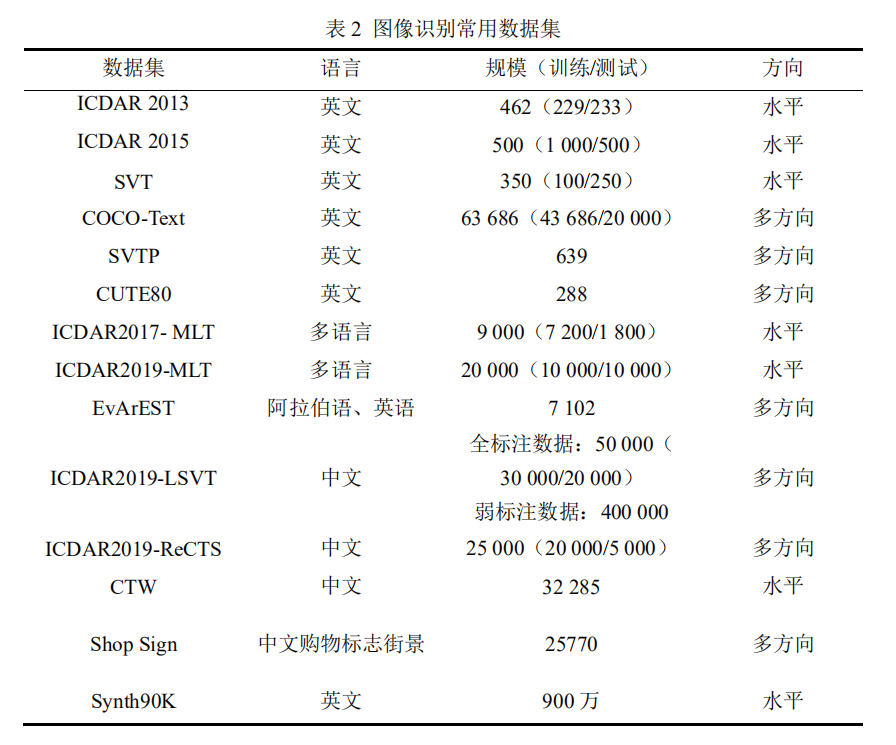

不同的識別算法一般通過上述兩種公開數據集進行比較,目前較為通用的英文評估集合分類。規則文本識別主要指印刷字體、掃描文本等場景,認為文本大致處在水平線比特置,其代錶數據集主要有IC13[36]、SVT[37]、IIIT5K[38]等。不規則文本識別是出現在自然場景中,且由於文本曲率、方向、變形等方面差异巨大,文字往往不在水平比特置,存在彎曲、遮擋、模糊等問題,其代錶數據集有IC15 [39]、COCO-Text[40]、SVTP[41]、CUTE [42]等。針對合適的文字識別數據集,找到對應的識別方法應用其中是至關重要的。每種數據集都對應於不同的OCR識別處理方法,每種方法也都有適合的數據集。根據圖像采集方式不同,字符數據集可分為三類:自然環境下采集的字符圖像數據集、手寫字符圖像數據集、計算機不同字體合成的字符圖像數據集,其中中文文字數據集 ICDAR2019-LSVT[43]、ICDAR2019-ReCTS[44]、CTW[45]、ShopSign[46]等;合成的文字數據集包括 Synth90K[47]、SynthText[48]、SynthAdd[49]等。

本文對常見文字識別數據集的信息進行總結和整理,包括中英文常見文字數據集如錶2所示。

4.文字識別技術發展及研究趨勢

目前,基於深度學習的文字識別技術發展較為成熟,在教育、醫療行業得到廣泛應用,但由於目前開源數據集較為缺乏,導致識別算法提昇受到一定限制[50]。在識別場景方面,人們對文字識別在複雜場景識別效果的要求越來越高;文字識別技術未來研究趨勢主要體現在以下幾個方面:

(1)複雜場景文字識別

深度學習在文字識別領域方面具有天然優勢,雖然所能解决的問題越來越複雜,但是同樣存在一定問題需要被解决,如對密集文本和不規則文本的檢測性能仍遠遠低於檢測水平文本的性能。尤其是在手寫場景下識別,如手寫數學公式識別、少數民族語言識別等研究具有重要意義[51][52]。其次,如何在自然場景、複雜場景(如字符變形、重疊)、多語種場景(一張同時含有多種文字)等進行文字檢測與識別,解决字符定比特及預處理問題,提昇識別准確率效果,是文字識別未來研究熱門方向[53]。

(2)零樣本、少樣本學習(Zero-shot[54]/Few-shot[55])

在文字識別過程中結合零樣本學習或小樣本學習算法,聯合上下文語義信息,是文字識別技術未來發展的熱門研究趨勢之一。尤其是在古籍識別研究方面,通過在訓練樣本中不加入或者少加入相關識別字符,結合多種輔助信息,將視覺模型與上下文語義信息進行融合,實現用部分類別(如簡體字)的樣本訓練識別,推廣到識別新類別(如繁體字)樣本,使機器達到識別未見過文字的效果。

(3)大規模數據集及字符集標注

數據集作為文字識別算法提昇的關鍵,直接影響最終識別效果。目前文字識別領域開源的文字數據集比較匱乏。一方面,企業將相關業務數據作為隱私,導致無法公開;另一方面,在學術領域方向文字識別數據集受人工及技術條件限制,導致數據規模較小。因此,未來需要我們開源更多處理後的大規模文字數據集,一方面可以嘗試通過數據增强相關算法進行數據增廣;另一方面,可以通過GAN生成對抗網絡[56]生成多種字體圖像,提高識別算法模型的性能與泛化能力。

5.結論

本文將主要介紹基於深度學習的文字識別技術綜述,分類總結主流文字識別經典算法,分別列舉經典論文的思路和貢獻。首先,本文介紹規則文本識別的基於CTC與基於Attention、Transformer及分割等方法,對端到端算法進行總結。最後,討論文字識別領域發展與研究趨勢。傳統OCR發展至今,已經解决大部分簡單場景且取得很好效果,但在一些複雜場景,傳統OCR識別精度很難滿足實際應用需求。基於深度學習的OCR錶現相較於傳統方法更為出色,隨著近幾年人工智能技術不斷發展,基於深度學習的文字識別逐漸成為應用的主流技術,目前在文字識別領域已取得不錯成果,其未來發展方向將逐步擴大到更多、更複雜的場景,結合多領域跨學科工作,使文字識別技術在人工智能應用更加成熟。作為深度學習的推動力,數據起到至關重要的作用,因此開源大規模數據集也是現階段提昇文字識別效果的重點。另外,在文字識別應用方面,需要我們引入更多輕量級模型,保證一定精度的同時提昇模型訓練速度,使其系統能够快速部署到服務器端。

參考文獻

- 劉偉紅.中文古籍數字化的現狀與意義[J]. 圖書與情報, 2009 (4): 134-137

- 薑維, 張重生, 殷緒成. 基於深度學習的場景文字檢測綜述[J].電子學報, 2019, 47(5): 1152.

- 劉豔菊,伊鑫海,李炎閣,張惠玉,劉彥忠.深度學習在場景文字識別技術中的應用綜述[J].計算機工程與應用,2022,58(04):52-63.

- A. Krizhevsky, I. Sutskever, and G. E. Hinton. Imagenet classification with deep convolutional neural networks. In NIPS, 2012.

- 金連文,鐘卓耀等.深度學習在手寫漢字識別應用綜述[J].自動化學報2016,42(8):1125-1141.

- Graves, Alex, et al.Connectionist temporal classification: labelling unsegmented sequence data withrecurrent neural networks. In ICML, 2006.

- Shi B, Bai X,Yao C. An End-to-End Trainable Neural Network for Image-Based Sequence Recognition and Its Application to Scene Text Recognition[J]. ieee transactions on pattern analysis & machine intelligence, 2016, 39(11):2298-2304.

- F. A. Gers, N. N. Schraudolph, and J. Schmidhuber. Learning precise timing with LSTM recurrent networks. JMLR,3:115–143, 2002.

- Fedor Borisyuk, Albert Gordo, and Viswanath Sivakumar. Rosetta: Large scale system for text detection and recognition in images. In Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining, pages 71–79. ACM, 2018.

- Gao, Yunze, et al. Reading scene text with attention convolutional sequence modeling. arXiv preprint arXiv:1709.04303, 2017.

- 王德青,吾守爾等.場景文字識別技術研究綜述[J]. 計算機工程與應用, 2020, 56(18): 1-15.

- 牛小明, 畢可駿, 唐軍.圖文識別技術綜述[J].中國體視學與圖像分析, 2019, 25(3):241-256.

- 甘吉. 手寫文字識別及相關問題算法研究[D].中國科學院大學(中國科學院計算機科學與技 術學院),2021.DOI:10.44196/d.cnki.gjskx.2021.000003.

- Shi B, Wang X, Lyu P, et al. Robust scene text recognition with automatic rectification[C]// Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 4168-4176.

- Lee C Y , Osindero S . Recursive Recurrent Nets with Attention Modeling for OCR in the Wild[C]// IEEE Conference on Computer Vision & Pattern Recognition. IEEE, 2016.

- Star-Net Max Jaderberg, Karen Simonyan, Andrew Zisserman, et al. Spa- tial transformer networks. In Advances in neural information processing systems, pages 2017–2025, 2015.

- Baoguang Shi, Mingkun Yang, XingGang Wang, Pengyuan Lyu, Xiang Bai, and Cong Yao. Aster: An attentional scene text recognizer with flexible rectification. IEEE transactions on pattern analysis and machine intelligence, 31(11):855–868, 2018.

- F. A. Gers, N. N. Schraudolph, and J. Schmidhuber. Learning precise timing with LSTM recurrent networks. JMLR,3:115–143, 2002.

- Luo C, Jin L, Sun Z. A multi-object rectified attention network for scene text recognition[J]. Pattern Recognition, 2019, 90: 109-118.

- Li H, Wang P, Shen C, et al. Show, attend and read: A simple and strong baseline for irregular text recognition[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2019, 33(01): 8610-8617.

- Cheng Z, Bai F, Xu Y, et al. Focusing attention: Towards accurate text recognition in natural images[C]//Proceedings of the IEEE international conference on computer vision. 2017: 5076-5084.

- Lee C Y , Osindero S . Recursive Recurrent Nets with Attention Modeling for OCR in the Wild[C]// IEEE Conference on Computer Vision & Pattern Recognition. IEEE, 2016.

- Xie Z, Huang Y, Zhu Y, et al. Aggregation cross-entropy for sequence recognition[C] //Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 6538-6547

- Hu W, Cai X, Hou J, et al. Gtc: Guided training of ctc towards efficient and accurate scene text recognition[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2020, 34(07): 11005-11012.

- Raja S, Mondal A, Jawahar C V. Table structure recognition using top-down and bottom-up cues[C]//European Conference on Computer Vision. Springer, Cham, 2020: 70-86.

- P. Lyu, C. Yao, W. Wu, S. Yan, and X. Bai. Multi-oriented scene text detection via corner localization and region segmentation. In Proc. CVPR, pages 7553–7563, 2018.

- Liao M, Zhang J, Wan Z, et al. Scene text recognition from two-dimensional perspective[C] //Proceedings of the AAAI Conference on Artificial Intelligence. 2019, 33(01): 8714-8721.

- Peng D, Jin L, Ma W, et al. Recognition of Handwritten Chinese Text by Segmentation: A Segment-annotation-free Approach[J]. IEEE Transactions on Multimedia, 2022.

- Yu D, Li X, Zhang C, et al. Towards accurate scene text recognition with semantic reasoning networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 12113-12122.

- Sheng F, Chen Z, Xu B. NRTR: A no-recurrence sequence-to-sequence model for scene text recognition[C]//2019 International Conference on Document Analysis and Recognition (ICDAR). IEEE, 2019: 781-786.

- Bartz C, Yang H, Meinel C. STN-OCR: A single neural network for text detection and text recognition[J]. arXiv preprint arXiv:1707.08831, 2017.

- Liu X, Liang D, Yan S, et al. Fots: Fast oriented text spotting with a unified network[C] //Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 5676-5685.

- Lyu P, Liao M, Yao C, et al. Mask textspotter: An end-to-end trainable neural network for spotting text with arbitrary shapes[C]//Proceedings of the European Conference on Computer Vision (ECCV). 2018: 67-83.

- Liu Y, Chen H, Shen C, et al. Abcnet: Real-time scene text spotting with adaptive bezier-curve network[C]//proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020: 9809-9818.

- 張華萍,黃辰.文字識別技術研究[J].物聯網技術,2018,8(08):17-19.DOI:10.16667/j.issn.2095- 1302.2018.08.002.

- Karatzas D, Shafait F, Uchida S, et al. ICDAR 2013 robust reading competition[C]//2013 12th International Conference on Document Analysis and Recognition. IEEE, 2013: 1484-1493.

- Wang K, Babenko B, Belongie S. End-to-end scene text recognition[C]//2011 International conference on computer vision. IEEE, 2011: 1457-1464.

- Yasmeen U, Shah J H, Khan M A, et al. Text detection and classification from low quality natural images[J]. 2020.

- Karatzas D, Gomez-Bigorda L, Nicolaou A, et al. ICDAR 2015 competition on robust reading[C]// international conference on document analysis IEEE, 2015: 1156-1160.

- Veit A, Matera T, Neumann L, et al. Coco-text: Dataset and benchmark for text detection andrecognition in natural images[J]. arXiv preprint arXiv:1601.07140, 2016

- Phan T Q, Shivakumara P, Tian S, et al. Recognizing text with perspective distortion in naturalscenes[C]//Proceedings of the IEEE International Conference on Computer Vision. 2013: 569-576.

- Risnumawan A, Shivakumara P, Chan C S, et al. A robust arbitrary text detection system for natural scene images[J]. Expert Systems with Applications, 2014, 41(18): 8027-8048.

- Sun Y, Ni Z, Chng C K, et al. ICDAR 2019 competition on large-scale street view text with partial labeling-RRC-LSVT[C]//2019 International Conference on Document Analysis and Recognition (ICDAR). IEEE, 2019: 1557-1562.

- Zhang R, Zhou Y, Jiang Q, et al. Icdar 2019 robust reading challenge on reading chinese text onsignboard[C]//2019 international conference on document analysis and recognition (ICDAR). IEEE, 2019: 1577-1581.

- Yuan T L, Zhu Z, Xu K, et al. A large chinese text dataset in the wild[J]. Journal of Computer Science and Technology, 2019, 34(3): 509-521.

- Zhang C, Ding W, Peng G, et al. Street view text recognition with deep learning for urban sceneunderstanding in intelligent transportation systems[J]. IEEE Transactions on Intelligent Transportation Systems, 2021, 22(7): 4727-4743.

- Jaderberg M, Simonyan K, Vedaldi A, et al. Synthetic data and artificial neural networks for natural scene text recognition[J]. arXiv preprint arXiv:1406.2227, 2014.

- Gupta A, Vedaldi A, Zisserman A. Synthetic data for text localisation in natural images[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 2315-2324.

- Li H, Wang P, Shen C, et al. Show, attend and read: A simple and strong baseline for irregular text recognition[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2019, 33(01): 8610-8617.

- 白文榮. 聯機手寫蒙古文字識別技術的研究[D].內蒙古大學,2007.

- 路燕. AI文字識別技術在城市規劃檔案數字化中的運用[J].科學技術創新,2022(14):54-57

- Chen X, Jin L, Zhu Y, et al. Text recognition in the wild: A survey[J]. ACM Computing Surveys (CSUR), 2021, 54(2): 1-35.

- Romera-Paredes B, Torr P. An embarrassingly simple approach to zero-shot learning[C] //International conference on machine learning. PMLR, 2015: 2152-2161.

- Sung F, Yang Y, Zhang L, et al. Learning to compare: Relation network for few-shot learning[C] //Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 1199-1208.

- Karras T, Laine S, Aittala M, et al. Analyzing and improving the image quality of stylegan[C] //Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020: 8110-8119.

場景文字檢測與識別方法分類

边栏推荐

- Technology sharing | what if Undo is too big

- 2.12 simulation

- Microservice registration and discovery

- A copy can also produce flowers

- [ruoyi] set theme style

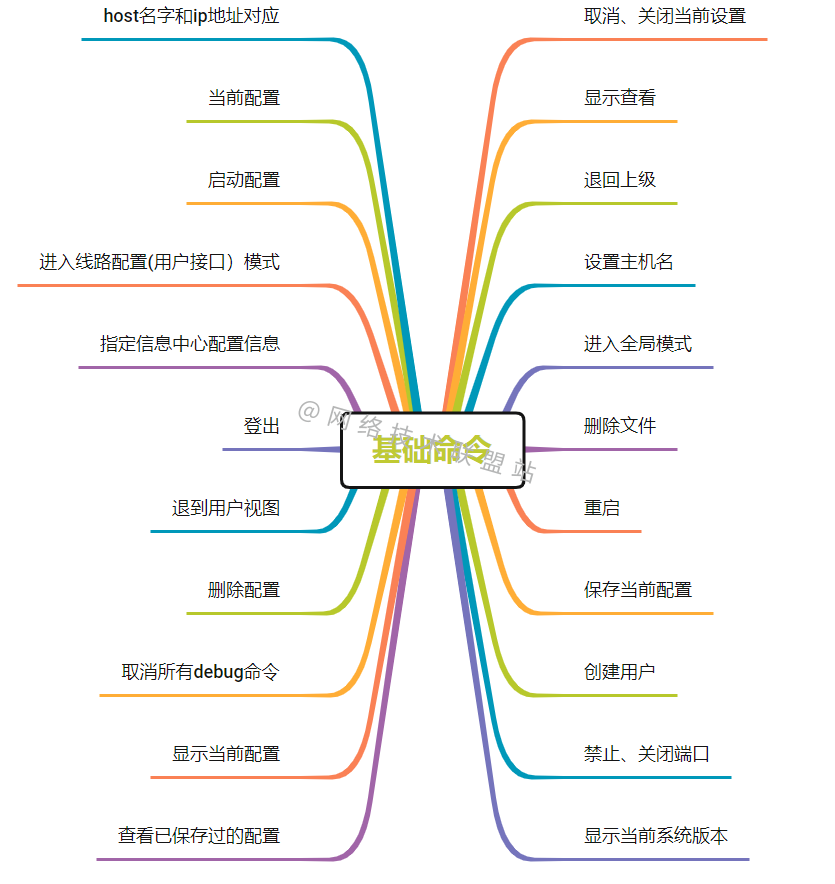

- 华为、H3C、思科命令对比,思维导图形式从基础、交换、路由三大方向介绍【转自微信公众号网络技术联盟站】

- Li Kou today's question -729 My schedule I

- 解决:AttributeError: ‘str‘ object has no attribute ‘decode‘

- Modeling specifications: naming conventions

- Apt installation ZABBIX

猜你喜欢

![[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 24](/img/2e/b1f348ee6abaef24b439944acf36d8.jpg)

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 24

Jenkins basic knowledge ----- detailed explanation of 03pipeline code

Shell script updates stored procedure to database

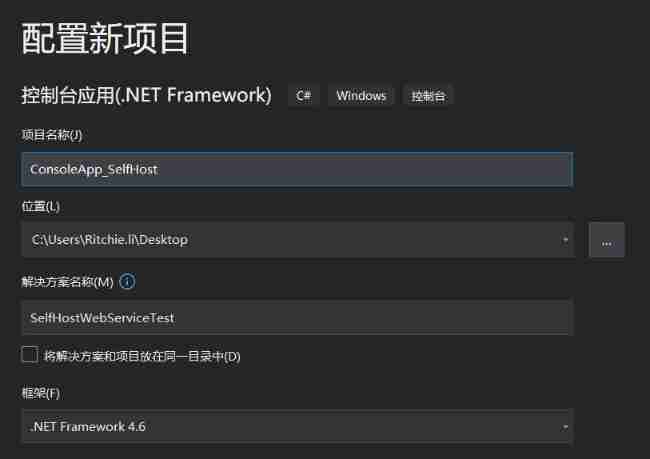

C # create self host webservice

纯Qt版中国象棋:实现双人对战、人机对战及网络对战

![[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 12](/img/b1/926d9b3d7ce9c5104f3e81974eef07.jpg)

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 12

![[ruoyi] enable Mini navigation bar](/img/28/a8b38aecd90c8ddc98333f0e2d3eab.png)

[ruoyi] enable Mini navigation bar

华为、H3C、思科命令对比,思维导图形式从基础、交换、路由三大方向介绍【转自微信公众号网络技术联盟站】

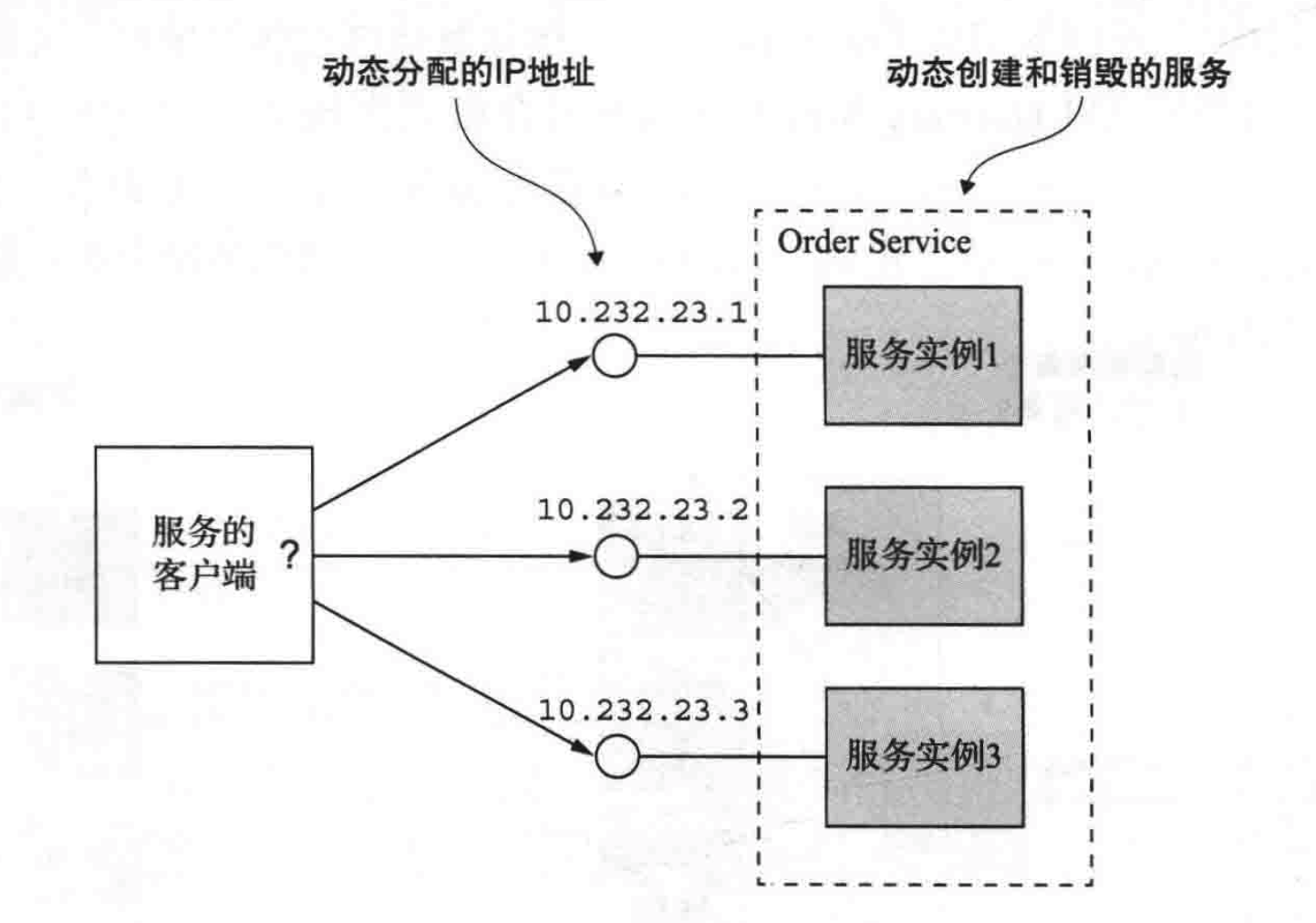

微服务注册与发现

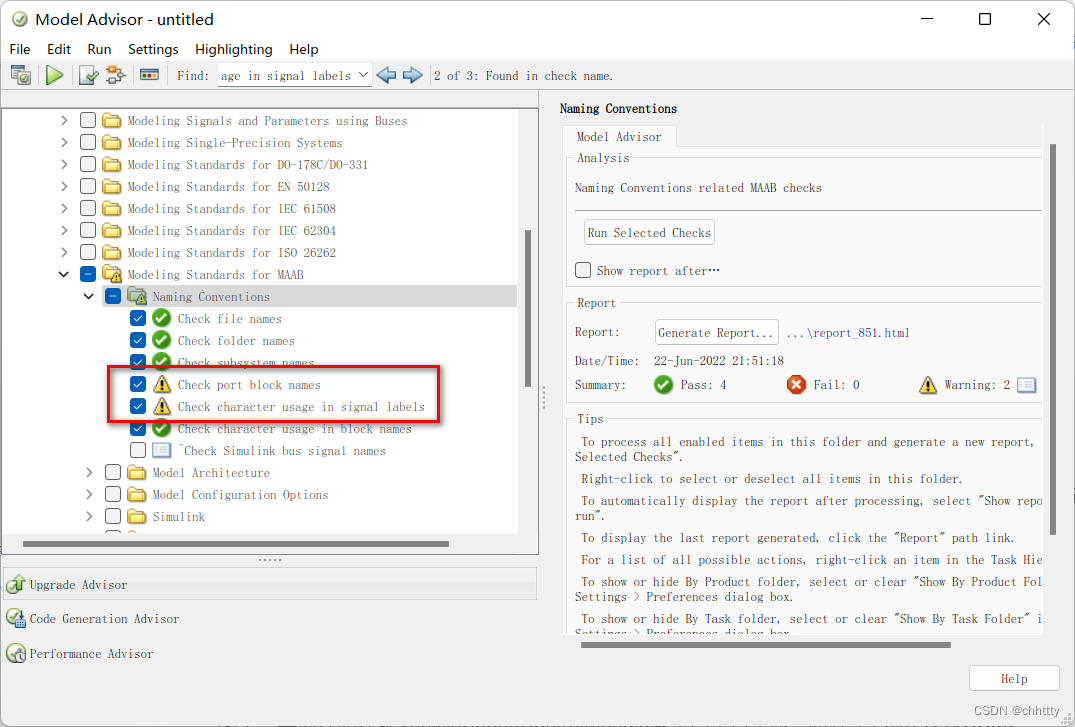

建模规范:命名规范

随机推荐

[ruoyi] set theme style

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 6

What is the investment value of iFLYTEK, which does not make money?

有没有完全自主的国产化数据库技术

tcpdump: no suitable device found

Reverse repackaging of wechat applet

codeforces每日5題(均1700)-第六天

技术分享 | undo 太大了怎么办

【若依(ruoyi)】ztree 自定义图标(iconSkin 属性)

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 24

Redis delete policy

What should we pay attention to when using the built-in tool to check the health status in gbase 8C database?

Is there a completely independent localization database technology

Introduction to robotframework (I) brief introduction and use

[matlab] access of variables and files

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 12

Gifcam v7.0 minimalist GIF animation recording tool Chinese single file version

主数据管理(MDM)的成熟度

#PAT#day10

[Yunju entrepreneurial foundation notes] Chapter II entrepreneur test 19