当前位置:网站首页>一张图深入的理解FP/FN/Precision/Recall

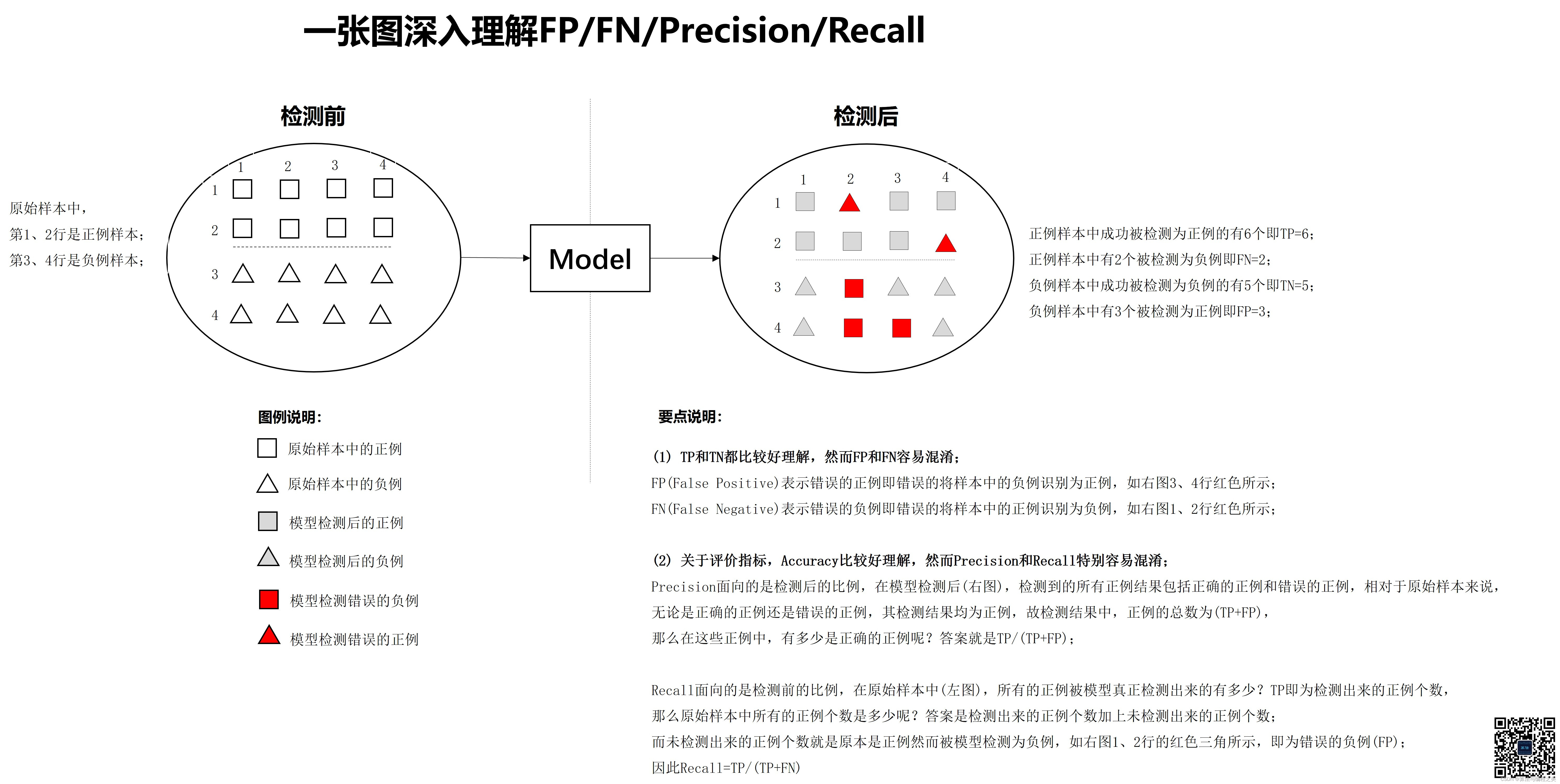

一张图深入的理解FP/FN/Precision/Recall

2022-07-07 17:14:00 【算法与编程之美】

由于图片较大,建议右键打开新的窗口以便于阅读!

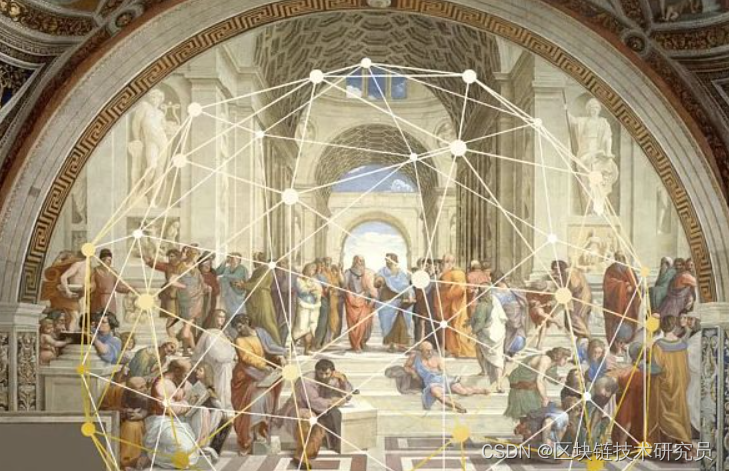

(1) TP和TN都比较好理解,然而FP和FN容易混淆;

- FP(False Positive)表示错误的正例即错误的将样本中的负例识别为正例,如右图3、4行红色正方形所示;

- FN(False Negative)表示错误的负例即错误的将样本中的正例识别为负例,如右图1、2行红色三角形所示;

(2) 关于评价指标,Accuracy比较好理解,然而Precision和Recall特别容易混淆;

- Precision面向的是检测后的比例,在模型检测后(右图),检测到的所有正例结果包括正确的正例和错误的正例,相对于原始样本来说, 无论是正确的正例还是错误的正例,其检测结果均为正例,故检测结果中,正例的总数为(TP+FP), 那么在这些正例中,有多少是正确的正例呢?答案就是TP/(TP+FP);FP越小,则Precision越大,而FP即为误报为正例数量; 因此,Precision反映的是样本中正例误报的情况。

- Recall面向的是检测前的比例,在原始样本中(左图),所有的正例被模型真正检测出来的有多少?TP即为检测出来的正例个数, 那么原始样本中所有的正例个数是多少呢?答案是检测出来的正例个数加上未检测出来的正例个数; 而未检测出来的正例个数就是原本是正例然而被模型检测为负例,如右图1、2行的红色三角所示,即为错误的负例(FP); 故Recall=TP/(TP+FN);FN越小,则Recall越大,而FN即为漏检为正例的数量;因此Recall反映的是样本中正例漏检的情况。

边栏推荐

- 脑洞从何而来?加州大学最新研究:有创造力的人神经连接会「抄近道」

- Chief technology officer of Pasqual: analog quantum computing takes the lead in bringing quantum advantages to industry

- Business experience in virtual digital human

- L1-025 positive integer a+b (Lua)

- Tips and tricks of image segmentation summarized from 39 Kabul competitions

- 完整的电商系统

- Basic operation of chain binary tree (implemented in C language)

- Scientists have observed for the first time that the "electron vortex" helps to design more efficient electronic products

- 2022上半年朋友圈都在传的10本书,找到了

- Hutool - lightweight DB operation solution

猜你喜欢

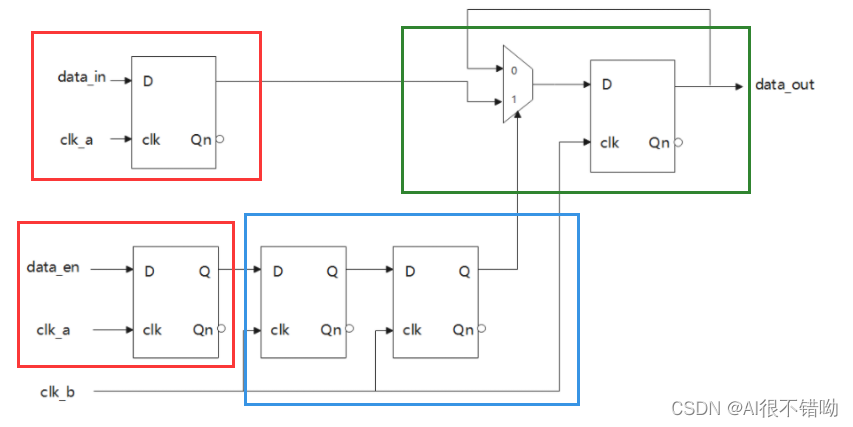

【牛客网刷题系列 之 Verilog进阶挑战】~ 多bit MUX同步器

2022.07.05

2022上半年朋友圈都在传的10本书,找到了

CMD command enters MySQL times service name or command error (fool teaching)

![[Verilog advanced challenge of Niuke network question brushing series] ~ multi bit MUX synchronizer](/img/7d/ed9a5c536b4cc1913fb69640afb98d.png)

[Verilog advanced challenge of Niuke network question brushing series] ~ multi bit MUX synchronizer

Desci: is decentralized science the new trend of Web3.0?

SlashData开发者工具榜首等你而定!!!

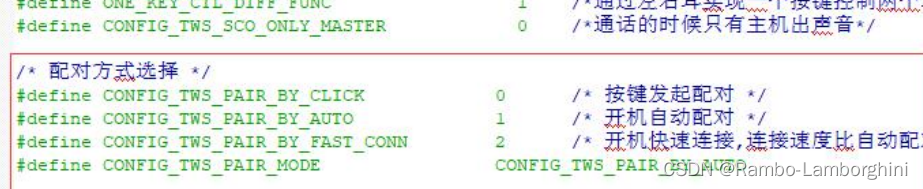

杰理之关于 TWS 配对方式配置【篇】

A hodgepodge of ICER knowledge points (attached with a large number of topics, which are constantly being updated)

Reuse of data validation framework Apache bval

随机推荐

AI写首诗

【HDU】5248-序列变换(贪心+二分)「建议收藏」

【牛客网刷题系列 之 Verilog进阶挑战】~ 多bit MUX同步器

SlashData开发者工具榜首等你而定!!!

Solve the problem of remote rviz error reporting

杰理之测试盒配置声道【篇】

Creative changes brought about by the yuan universe

Responsibility chain model - unity

企业MES制造执行系统的分类与应用

二叉树的基本概念和性质

Flipping game (enumeration)

First time in China! The language AI strength of this Chinese enterprise is recognized as No.2 in the world! Second only to Google

[mime notes]

杰理之关于 TWS 交叉配对的配置【篇】

Desci: is decentralized science the new trend of Web3.0?

POJ 2392 Space Elevator

POJ 1182 :食物链(并查集)[通俗易懂]

Review of network attack and defense

Numpy——axis

Solve the error reporting problem of rosdep