当前位置:网站首页>Orin 安装CUDA环境

Orin 安装CUDA环境

2022-07-05 06:28:00 【恩来贺】

有两种方法可以安装CUDA环境

1.命令行方式

在刷机完成的Orin,执行如下命令:

a. sudo apt update

b. sudo apt upgrade

c. sudo apt install nvidia-jetpack -y

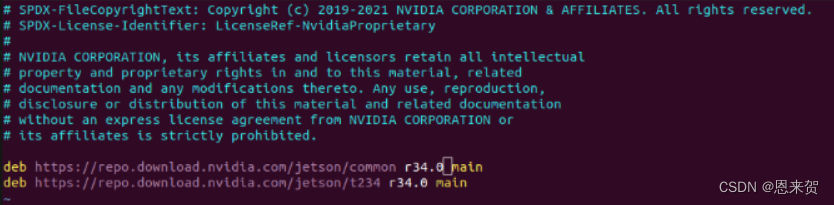

如果报错则,查看版本:/etc/apt/sources.list.d/nvidia-l4t-apt-source.list 文件中,目前最新的为34.1

改为

执行完毕即可安装,如果使用 l4t_for_tegra 最新的版本,通过flash.sh刷机之后不会报错。

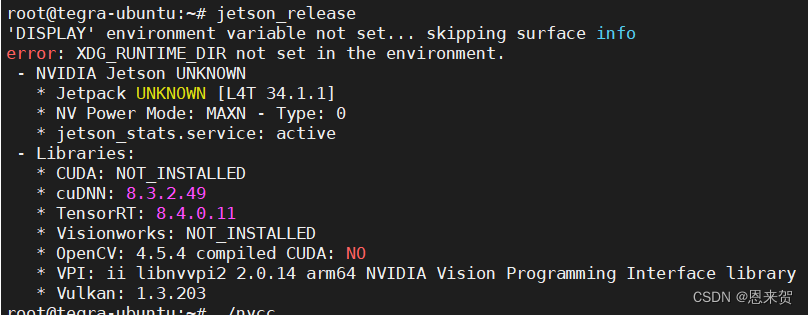

a. CUDA 检查是否安装成功

nvcc -V

如果报错,需要把nvcc添加到环境变量。

出现如下则表示安装正确:

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2021 NVIDIA Corporation

Built on Thu_Nov_11_23:44:05_PST_2021

Cuda compilation tools, release 11.4, V11.4.166

Build cuda_11.4.r11.4/compiler.30645359_0b.cuDNN

dpkg -l libcudnn8显示如下信息:

Desired=Unknown/Install/Remove/Purge/Hold

| Status=Not/Inst/Conf-files/Unpacked/halF-conf/Half-inst/trig-aWait/Trig-pend

|/ Err?=(none)/Reinst-required (Status,Err: uppercase=bad)

||/ Name Version Architecture Description

+++-==============-===================-============-======================

ii libcudnn8 8.3.2.49-1+cuda11.4 arm64 cuDNN runtime librariesc.TensorRT:

显示如下信息:

Desired=Unknown/Install/Remove/Purge/Hold

| Status=Not/Inst/Conf-files/Unpacked/halF-conf/Half-inst/trig-aWait/Trig-pend

|/ Err?=(none)/Reinst-required (Status,Err: uppercase=bad)

||/ Name Version Architecture Description

+++-==============-===================-============-=====================

ii tensorrt 8.4.0.11-1+cuda11.4 arm64 Meta package of TensorRTd.OpenCV:

显示如下信息:

Desired=Unknown/Install/Remove/Purge/Hold

| Status=Not/Inst/Conf-files/Unpacked/halF-conf/Half-inst/trig-aWait/Trig-pend

|/ Err?=(none)/Reinst-required (Status,Err: uppercase=bad)

||/ Name Version Architecture Description

+++-==============-===================-============-=======================

ii libopencv 4.5.4-8-g3e4c170df4 arm64 Open Computer Vision Library2. 使用SDKmanager 安装

在SDKmanager 下载所需要的文件

执行step1/2/3/4 即可,操作比较简单。

查看安装的版本:

TensorRT

TensorRT是一个高性能的深度学习推理(Inference)优化器,可以为深度学习应用提供低延迟、高吞吐率的部署推理。TensorRT可用于对超大规模数据中心、嵌入式平台或自动驾驶平台进行推理加速。 TensorRT现已能支持TensorFlow、Caffe、Mxnet、Pytorch等几乎所有的深度学习框架,将TensorRT和NVIDIA的GPU结合起来,能在几乎所有的框架中进行快速和高效的部署推理。

cuDNN

cuDNN是用于深度神经网络的GPU加速库。它强调性能、易用性和低内存开销。NVIDIA cuDNN可以集成到更高级别的机器学习框架中,如谷歌的Tensorflow、加州大学伯克利分校的流行caffe软件。简单的插入式设计可以让开发人员专注于设计和实现神经网络模型,而不是简单调整性能,同时还可以在GPU上实现高性能现代并行计算。

CUDA

CUDA(ComputeUnified Device Architecture),是显卡厂商NVIDIA推出的运算平台。 CUDA是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题。

CUDA与cuDNN的关系

CUDA看作是一个工作台,上面配有很多工具,如锤子、螺丝刀等。cuDNN是基于CUDA的深度学习GPU加速库,有了它才能在GPU上完成深度学习的计算。它就相当于工作的工具,比如它就是个扳手。但是CUDA这个工作台买来的时候,并没有送扳手。想要在CUDA上运行深度神经网络,就要安装cuDNN,就像你想要拧个螺帽就要把扳手买回来。这样才能使GPU进行深度神经网络的工作,工作速度相较CPU快很多。

边栏推荐

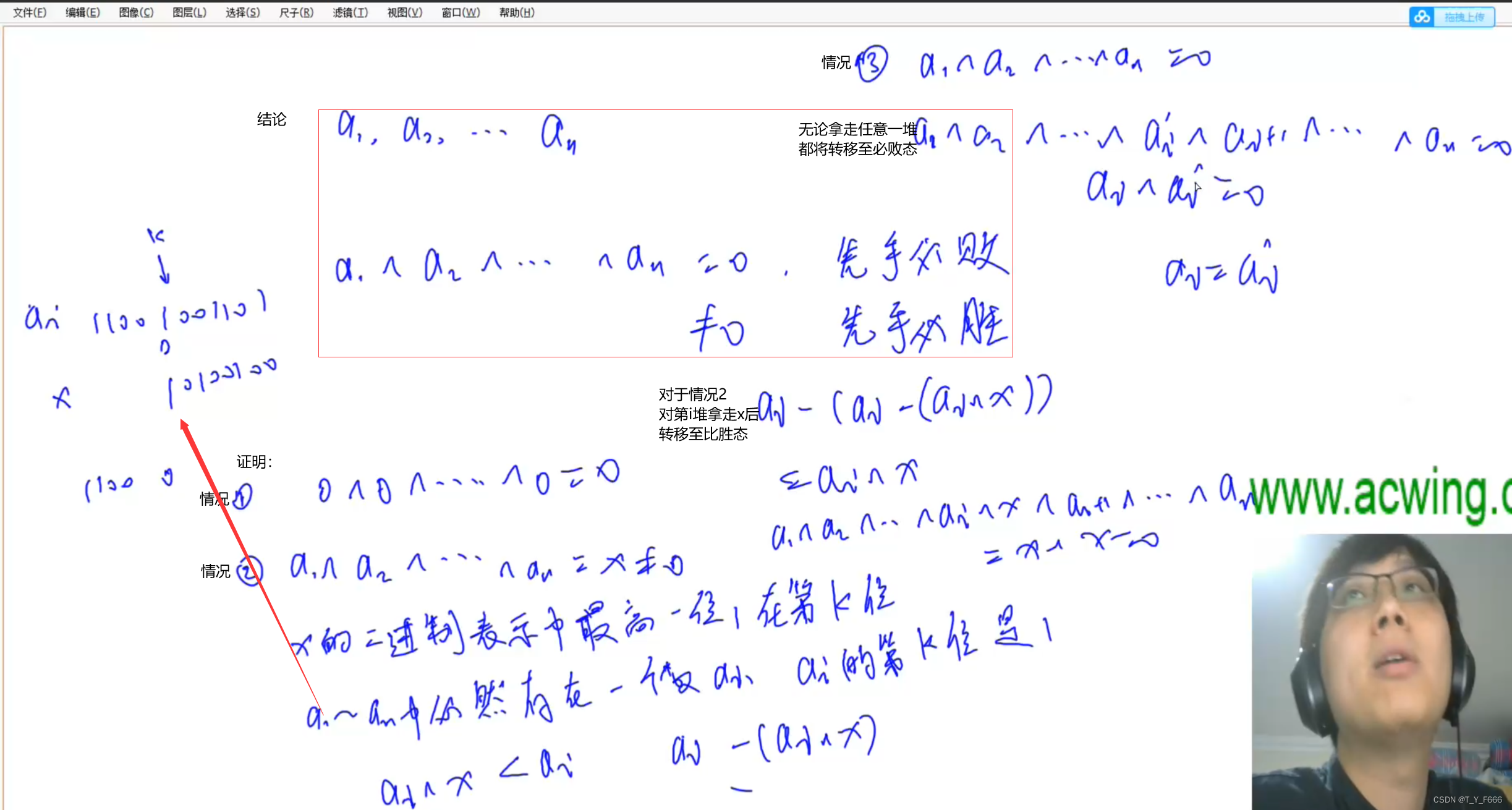

- Game theory acwing 893 Set Nim game

- June 29, 2022 daily

- Vscode configures the typera editor for MD

- ‘mongoexport‘ 不是内部或外部命令,也不是可运行的程序 或批处理文件。

- Modnet matting model reproduction

- 4. Oracle redo log file management

- Vant Weapp SwipeCell设置多个按钮

- Record of problems in ollvm compilation

- H5 模块悬浮拖动效果

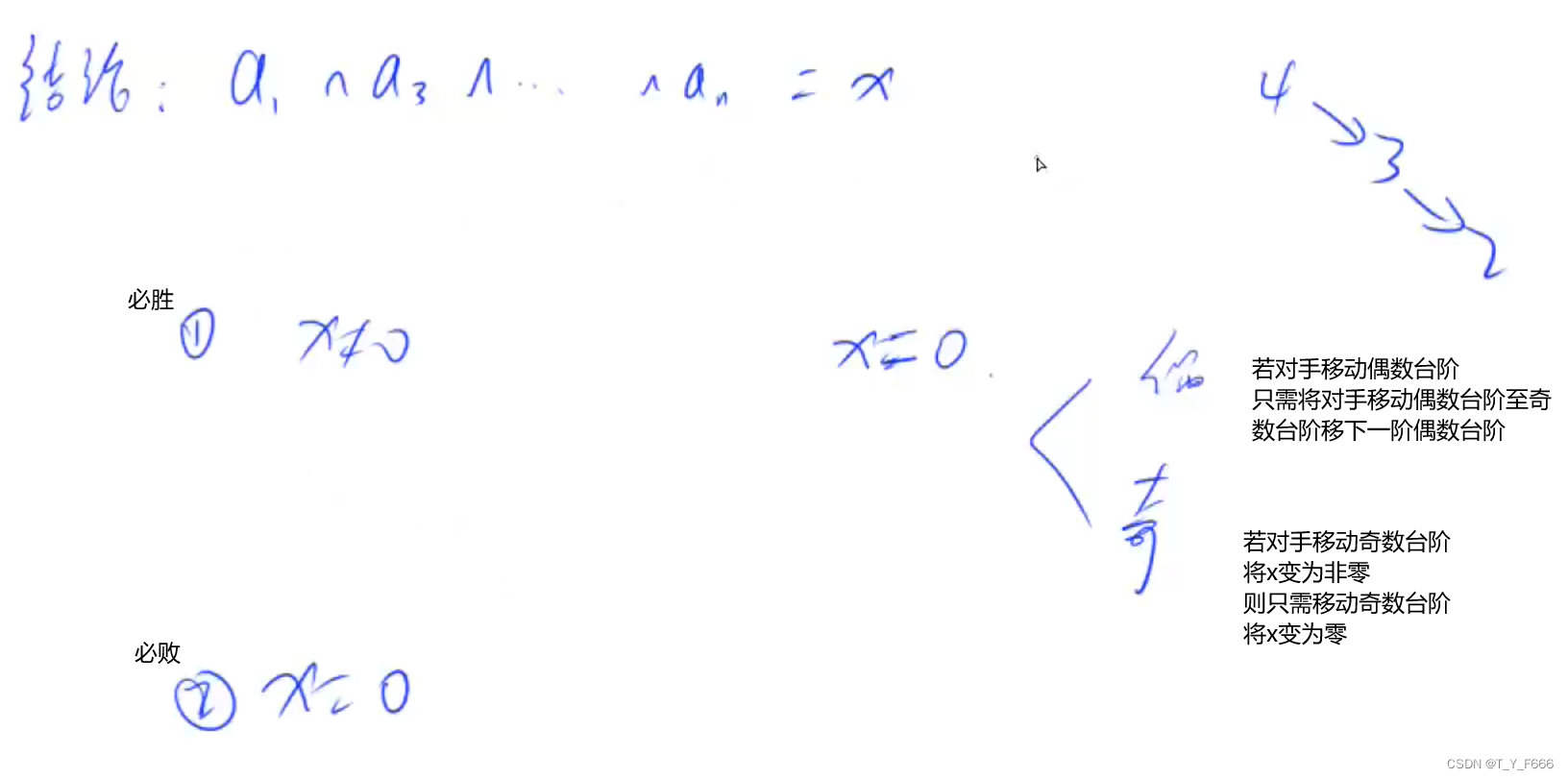

- Game theory acwing 892 Steps Nim game

猜你喜欢

Game theory acwing 894 Split Nim game

International Open Source firmware Foundation (osff) organization

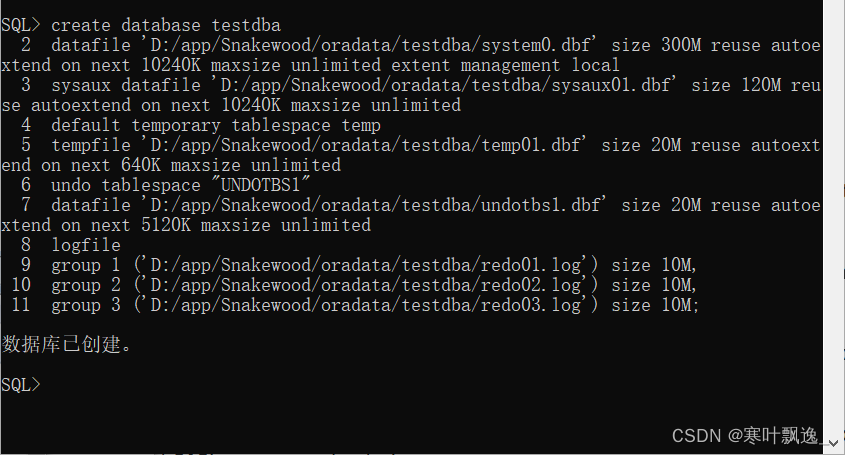

1. Create Oracle database manually

Game theory acwing 891 Nim games

代码中的英语全部

Skywalking全部

SolidWorks template and design library are convenient for designers to call

Database mysql all

Game theory acwing 892 Steps Nim game

Day 2 document

随机推荐

在本地搭建一个微服务集群环境,学习自动化部署

vsCode创建自己的代码模板

H5内嵌App适配暗黑模式

How to answer when you encounter a jet on CSDN?

The “mode“ argument must be integer. Received an instance of Object

Redis-02.Redis命令

Interval problem acwing 906 Interval grouping

达梦数据库全部

How to make water ripple effect? This wave of water ripple effect pulls full of retro feeling

[Chongqing Guangdong education] 1185t administrative leadership reference test of National Open University in autumn 2018

'mongoexport 'is not an internal or external command, nor is it a runnable program or batch file.

Huawei bracelet, how to add medicine reminder?

Suppose a bank's ATM machine, which allows users to deposit and withdraw money. Now there is 200 yuan in an account, and both user a and user B have the right to deposit and withdraw money from this a

ollvm编译出现的问题纪录

TypeScript入门

代码中的英语全部

5. Oracle TABLESPACE

June 29, 2022 daily

2048 project realization

Gaussian elimination acwing 884 Gauss elimination for solving XOR linear equations