当前位置:网站首页>特征生成

特征生成

2022-07-07 20:57:00 【全栈程序员站长】

大家好,又见面了,我是全栈君。

特征准则

区分性:不同类别模式在特征空间可分

不变性:同一类别模式在特征空间的变化(变化、形变、噪声) 选取区分性高、且同意一定不变性的特征

特征生成的一些方法 1 时域、频域、视频联合 相关系数、FFT、DCT、Wavelet、Gabor 2 统计、结构、混合 直方图、属性-关系图 3 底层、中层、高层 颜色、梯度(Robert、Prewitt、Sobel、差分+平滑、HOG)、纹理(类Harr、LBP)、形状、语义 4 模型 ARMA、LPC

三个实例

A SIFT 1 建立高斯金字塔 做差生成DOG(LOG)的近似 2 求取极值点,并依据导数求取优化极值点 3 依据Hessian矩阵(能够自相关函数)去掉边缘和不稳定的点 4 进行梯度描写叙述

详细步骤參考《图像局部不变性特征与描写叙述》及 http://underthehood.blog.51cto.com/2531780/658350 带有SIFT凝视的代码,请參考

B Bag of Words 1 聚类-构建词典 2 映射到词典,然后SVM等其它分类器进行训练分类就可以

详细点有 1 Feature extraction 2 Codebook generation 3 Coding(Hard or Soft) 4 Polling(Average or Max) 5 Classify

“ 如今Computer Vision中的Bag of words来表示图像的特征描写叙述也是非常流行的。

大体思想是这种,如果有5类图像。每一类中有10幅图像。这样首先对每一幅图像划分成patch(能够是刚性切割也能够是像SIFT基于关键点检測的),这样。每个图像就由非常多个patch表示,每个patch用一个特征向量来表示,咱就如果用Sift表示的,一幅图像可能会有成百上千个patch,每个patch特征向量的维数128。

接下来就要进行构建Bag of words模型了,如果Dictionary词典的Size为100,即有100个词。那么咱们能够用K-means算法对全部的patch进行聚类,k=100,我们知道,等k-means收敛时。我们也得到了每个cluster最后的质心。那么这100个质心(维数128)就是词典里德100个词了,词典构建完成。

词典构建完了怎么用呢?是这种,先初始化一个100个bin的初始值为0的直方图h。每一幅图像不是有非常多patch么?我们就再次计算这些patch和和每个质心的距离,看看每个patch离哪一个质心近期,那么直方图h中相相应的bin就加1,然后计算完这幅图像全部的patches之后,就得到了一个bin=100的直方图。然后进行归一化。用这个100维德向量来表示这幅图像。

对全部图像计算完毕之后。就能够进行分类聚类训练预測之类的了。 “

C 图像显著性 1 多尺度对照 2 中心周围直方图 3 颜色空间分布

发布者:全栈程序员栈长,转载请注明出处:https://javaforall.cn/116276.html原文链接:https://javaforall.cn

边栏推荐

- Intelligent software analysis platform embold

- CodeSonar如何帮助无人机查找软件缺陷?

- 如何满足医疗设备对安全性和保密性的双重需求?

- object-c编程tips-timer「建议收藏」

- MinGW MinGW-w64 TDM-GCC等工具链之间的差别与联系「建议收藏」

- 机械臂速成小指南(十一):坐标系的标准命名

- UVA 11080 – Place the Guards(二分图判定)

- I wrote a markdown command line gadget, hoping to improve the efficiency of sending documents by garden friends!

- npm uninstall和rm直接删除的区别

- Small guide for rapid formation of manipulator (12): inverse kinematics analysis

猜你喜欢

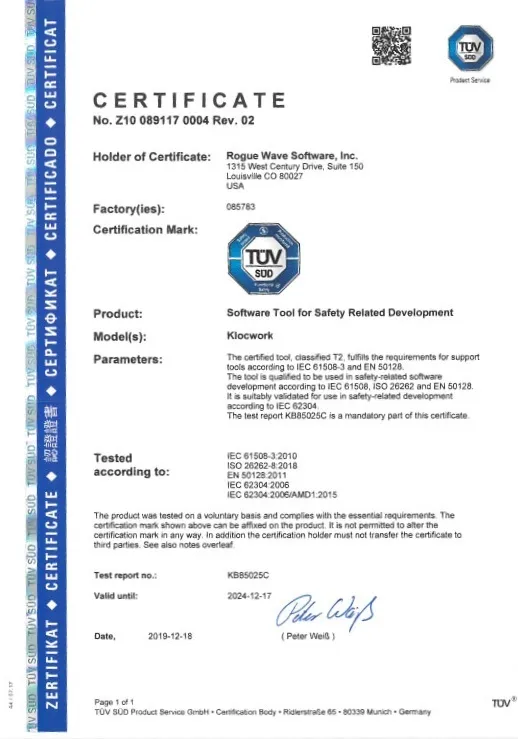

Klocwork 代码静态分析工具

程序猿赚的那点钱算个P啊!

The latest version of codesonar has improved functional security and supports Misra, c++ parsing and visualization

How to meet the dual needs of security and confidentiality of medical devices?

Nebula importer data import practice

测量楼的高度

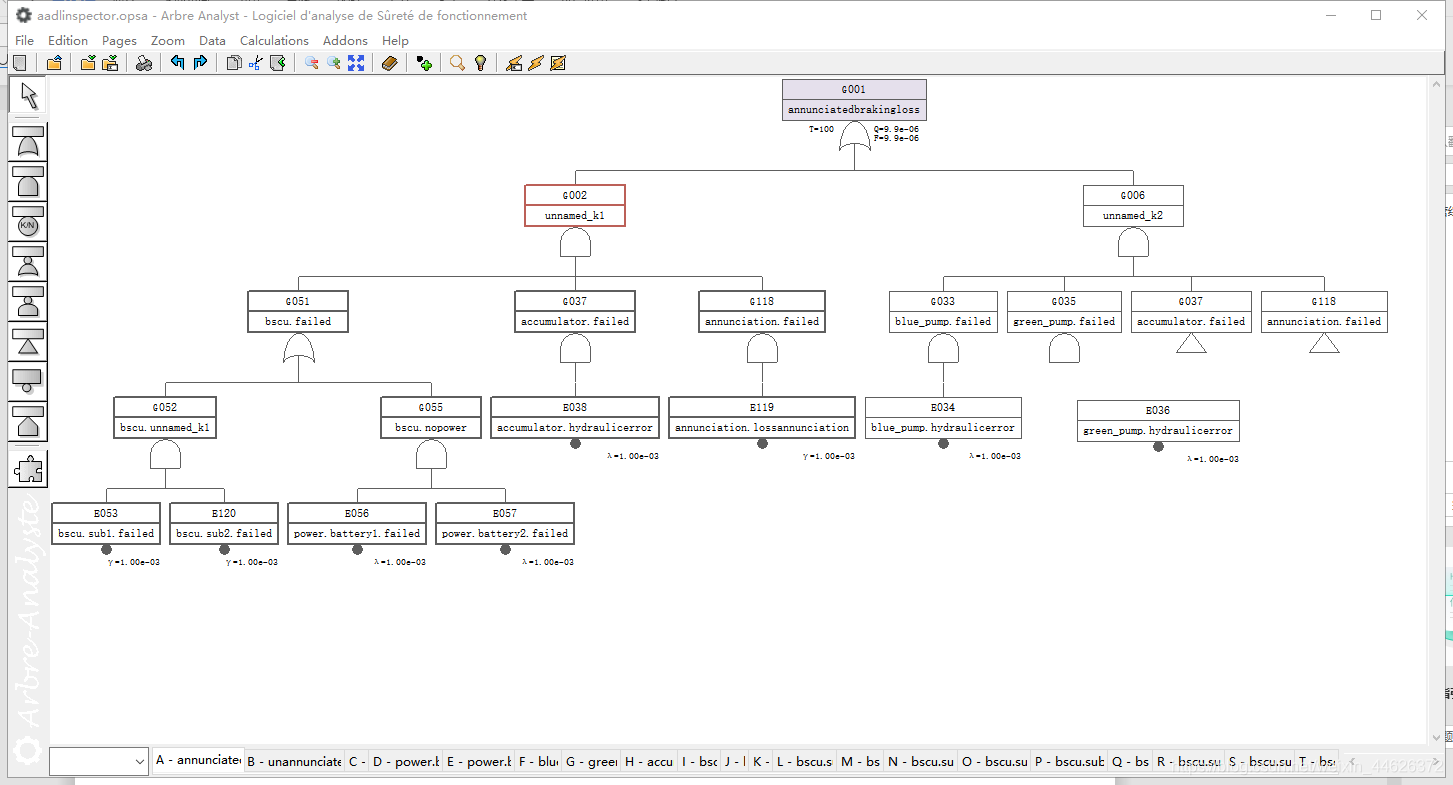

AADL Inspector 故障树安全分析模块

Codesonar enhances software reliability through innovative static analysis

如何满足医疗设备对安全性和保密性的双重需求?

目标:不排斥 yaml 语法。争取快速上手

随机推荐

使用camunda做工作流设计,驳回操作

Flask1.1.4 Werkzeug1.0.1 源码分析:路由

Is it safe to open an account of BOC shares in kainiu in 2022?

MySQL约束之默认约束default与零填充约束zerofill

Jetty:配置连接器[通俗易懂]

What are the official stock trading apps in the country? Is it safe to use

【论文阅读】MAPS: Multi-agent Reinforcement Learning-based Portfolio Management System

国家正规的股票交易app有哪些?使用安不安全

sqlHelper的增删改查

UVA 11080 – Place the Guards(二分图判定)

2022年在启牛开中银股票的账户安全吗?

写一下跳表

guava多线程,futurecallback线程调用不平均

VMWare中虚拟机网络配置

Write a jump table

Numerical method for solving optimal control problem (0) -- Definition

Phoenix JDBC

使用高斯Redis实现二级索引

【C语言】指针进阶---指针你真的学懂了吗?

Intelligent software analysis platform embold