当前位置:网站首页>【阅读笔记】图对比学习 GNN+CL

【阅读笔记】图对比学习 GNN+CL

2022-07-05 09:13:00 【处女座程序员的朋友】

来源: https://mp.weixin.qq.com/s/X7gxlcY-PaQ97MiEJmKfbg

对给定的大量无标注图数据,图对比学习算法旨在训练出一个图编码器,目前一般指图神经网络(Graph Neural Network, GNN)。由这个 GNN 编码得到的图表示向量,可以很好地保留图数据的特性。

Graph Contrastive Learning with Augmentations. NeurIPS 2020.

算法步骤:

1. 随机采样一批(batch)图

2. 对每一个图进行两次随机的数据增强(增删边/舍弃节点)得到新图(view)

3. 使用待训练的 GNN 对 View 进行编码,得到节点表示向量(node representation)和图表示向量(graph representations)

4. 根据上述表示向量计算 InfoNCE 损失,其中由同一个 graph 增强出来的 view 的表示相互靠近,由不同的 graph 增强得到的 view 的表示相互远离;【特征被加强】

【启发式图数据增强】由于图数据经过GNN 后会产生 节点表示 和 图表示 两个层次的表示向量Contrastive Multi-View Representation Learning on Graphs. ICML 2020. 设计实验对不同层次的对比进行分析,发现将节点表示与图表示进行对比会取得更好的效果。芜湖~

【Learning方法图数据增强】JOAO:通过对抗训练(adversarial training)的方式,迭代训练选择每种数据增强方式【半自动】的概率矩阵,并对应更换 GraphCL 中的映射头(projection head)。实验结果表明,对抗训练学习得到的概率矩阵和此前 GraphCL 关于数据增强选择的实验结果趋势相近,并在不需要过多人工干预的情况下达到了有竞争力的结果。

【全自动】自动学习数据增强时对图做扰动的分布。Adversarial Graph Augmentation to Improve Graph Contrastive Learning 作者从数据增强如何保留图的信息出发,假设增强出的两个 View 之间并不是互信息越大越好,因为这些互信息中可能包含大量噪音。作者引入信息瓶颈 (Information Bottleneck)原则,认为更好的 View 应该是在共同保留图本身的特性这一前提下,彼此之间的互信息最小。即在训练中,学习如何通过增强保留 graph 中的必要信息,并同时减少噪音。基于这一原则,作者设计了 min-max game 的训练模式,并训练神经网络以决定是否在数据增强中删除某条边。【剪枝策略?】

————————————————

版权声明:本文为CSDN博主「Amber_7422」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/Amber_7422/article/details/123773606

边栏推荐

- Programming implementation of ROS learning 6 -service node

- Codeforces Round #648 (Div. 2) D. Solve The Maze

- Applet (subcontracting)

- Explain NN in pytorch in simple terms CrossEntropyLoss

- [beauty of algebra] singular value decomposition (SVD) and its application to linear least squares solution ax=b

- File server migration scheme of a company

- 阿里云发送短信验证码

- 我的一生.

- Solution to the problems of the 17th Zhejiang University City College Program Design Competition (synchronized competition)

- Golang foundation - the time data inserted by golang into MySQL is inconsistent with the local time

猜你喜欢

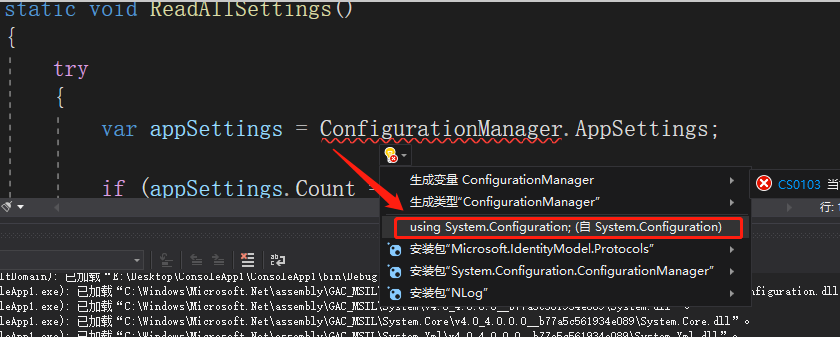

C#【必备技能篇】ConfigurationManager 类的使用(文件App.config的使用)

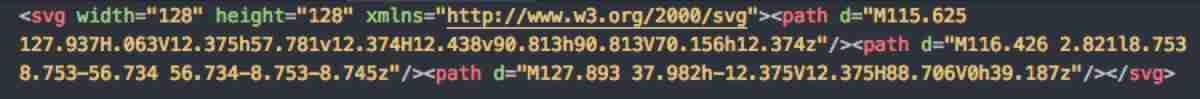

Svg optimization by svgo

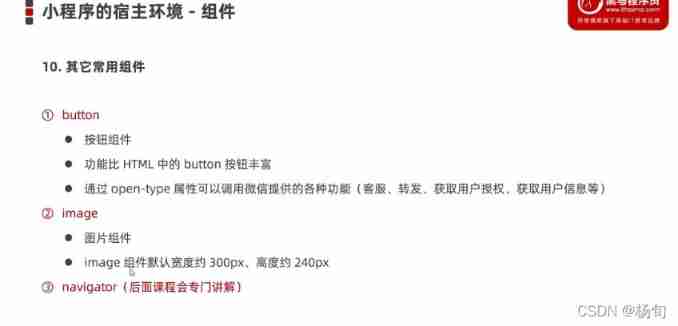

Composition of applet code

![[beauty of algebra] singular value decomposition (SVD) and its application to linear least squares solution ax=b](/img/ee/8e07e2dd89bed63ff44400fe1864a9.jpg)

[beauty of algebra] singular value decomposition (SVD) and its application to linear least squares solution ax=b

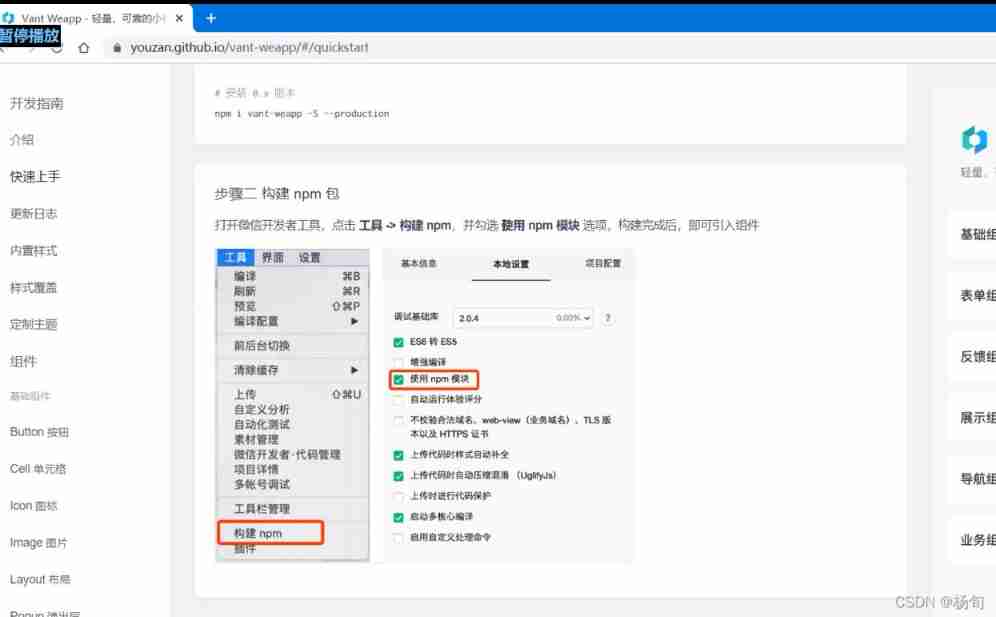

Applet (use of NPM package)

微信H5公众号获取openid爬坑记

c语言指针深入理解

Blogger article navigation (classified, real-time update, permanent top)

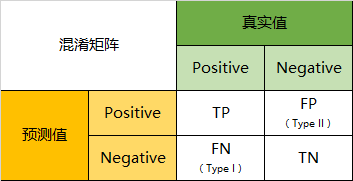

Confusion matrix

![[daiy4] copy of JZ35 complex linked list](/img/bc/ce90bb3cb6f52605255f1d6d6894b0.png)

[daiy4] copy of JZ35 complex linked list

随机推荐

Codeforces round 684 (Div. 2) e - green shopping (line segment tree)

Introduction Guide to stereo vision (4): DLT direct linear transformation of camera calibration [recommended collection]

C # draw Bezier curve with control points for lattice images and vector graphics

Introduction Guide to stereo vision (3): Zhang calibration method of camera calibration [ultra detailed and worthy of collection]

c#比较两张图像的差异

Multiple solutions to one problem, asp Net core application startup initialization n schemes [Part 1]

nodejs_ 01_ fs. readFile

Wxml template syntax

优先级队列(堆)

迁移学习和域自适应

C [essential skills] use of configurationmanager class (use of file app.config)

Applet global style configuration window

一题多解,ASP.NET Core应用启动初始化的N种方案[上篇]

Use arm neon operation to improve memory copy speed

Ecmascript6 introduction and environment construction

RT thread kernel quick start, kernel implementation and application development learning with notes

2311. Longest binary subsequence less than or equal to K

kubeadm系列-01-preflight究竟有多少check

ROS learning 4 custom message

AdaBoost use