当前位置:网站首页>遥感图像超分辨重建综述

遥感图像超分辨重建综述

2022-07-06 03:18:00 【leon.shadow】

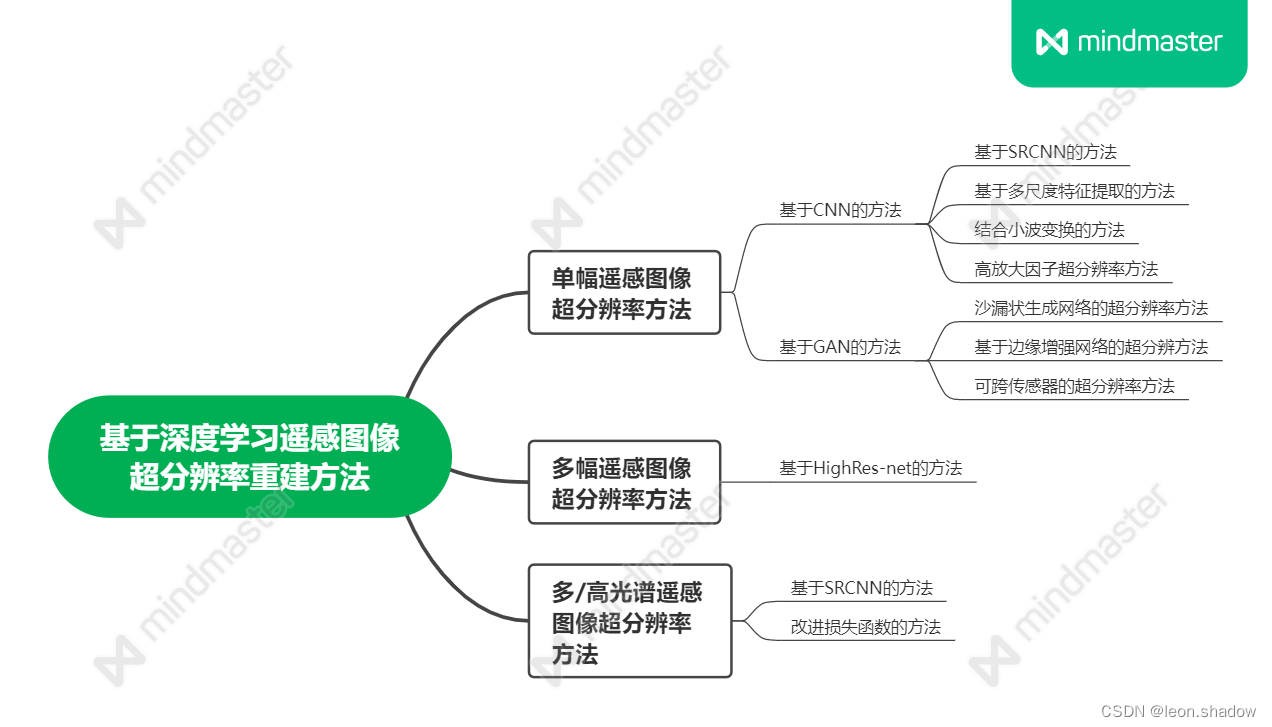

基于深度学习的遥感图像超分辨率重建技术综述

摘要部分

基于深度学习的遥感图像超分重建方法分成三大类

单幅遥感图像超分重建

最好的是基于GAN的方法

方法:

- 基于多尺度特征提取的方法

- 结合小波变换的方法

- 沙漏状生成网络的方法

- 边缘增强网络的方法

- 可跨传感器的方法

多幅遥感图像超分重建

超分效果不佳,存在配准融合、多源信息融合等问题

多/高光谱遥感图像超分重建

超分效果不佳,存在配准融合、多源信息融合等问题

未来趋势

- 构建针对遥感图像特点的神经网络结构

- 无监督学习的遥感图像超分重建方法(想法:GAN可用于无监督学习)

- 多源遥感图像的超分重建方法

引言

概念

遥感图像超分辨率重建是对具有互补信息的低分辨率遥感图像进行处理,来获得高分辨率遥感图像的技术。

方法框架

基于深度学习的遥感图像超分重建方法渊源

传统的遥感图像超分重建方法

频域法

主要分为频谱解混叠算法,递归最小二乘法等,其 基于的理论前提过于理想化,不能有效地应用于 多个场合,所以目前这类方法已不再成为研究的主流。

空域法

空域法虽然灵活性好,但是它涉及帧内运动 模糊、光学模糊以及其他复杂的降质模型等许多因素,导致其优化方法复杂,计算的代价大,没能成为主流的方法。

频域-空域结合的方法

频域-空域结合的方法,虽然结合了频域法和空域法的优势,但运算复杂,计算量巨大,也没能成为主流的方法。

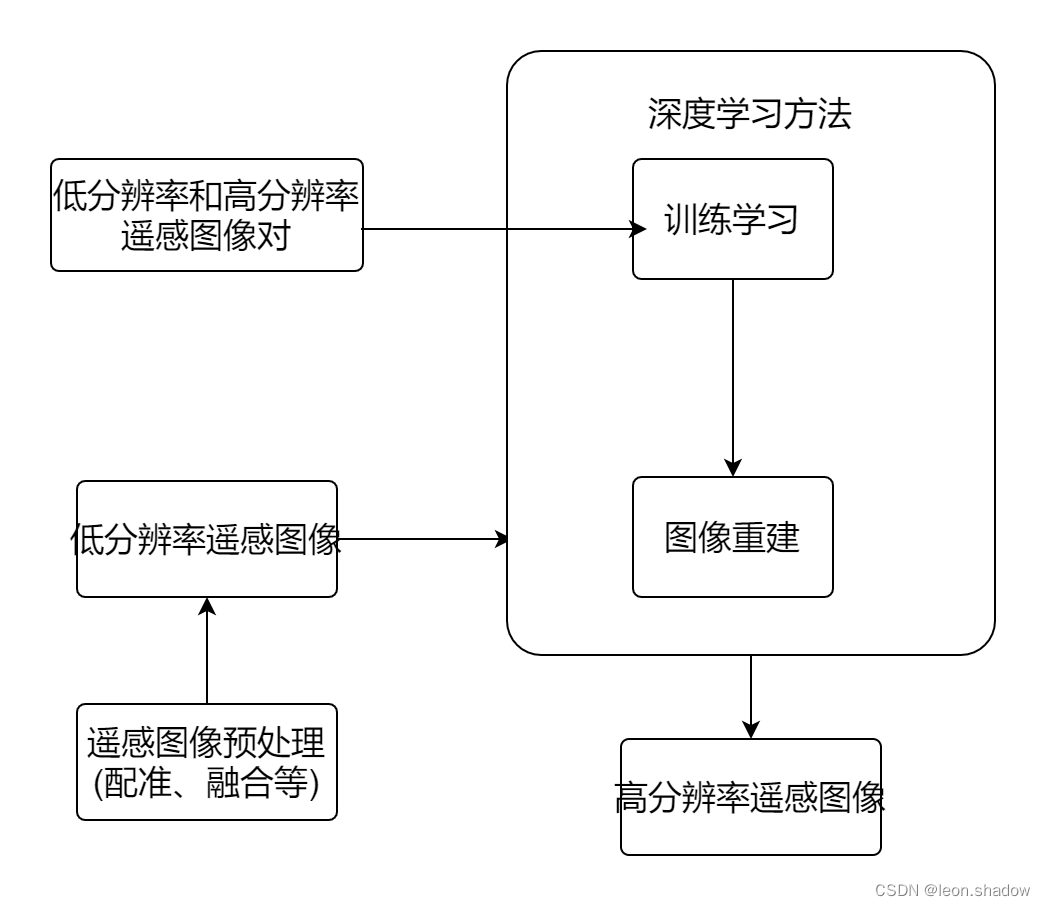

基于深度学习的遥感图像超分辨重建步骤

将低分辨率和高分辨率遥感图像对送入深度学习方法中,进行学习训练,得到低分辨率和高分辨率遥感图像之间的关系。再将低分辨率遥感图像送入训练好的深度模型中,得到重建后的超分辨率遥感图像。

基于深度学习的单幅遥感图像超分辨率重建

基于CNN的单幅遥感图像超分辨率

常用CNN架构

SRCNN

第一个将 CNN 应用于超分辨率问题的方法。2016年Liebel 等首次提出将 SRCNN 用于单幅遥感图像超分辨率重建。该方法 没有考虑遥感图像尺度多样性的特点,所以重建效 果不太明显,于是人们根据遥感图像的尺度多样性特点,提出了许多基于多尺度特征提取的方法。

VDSR

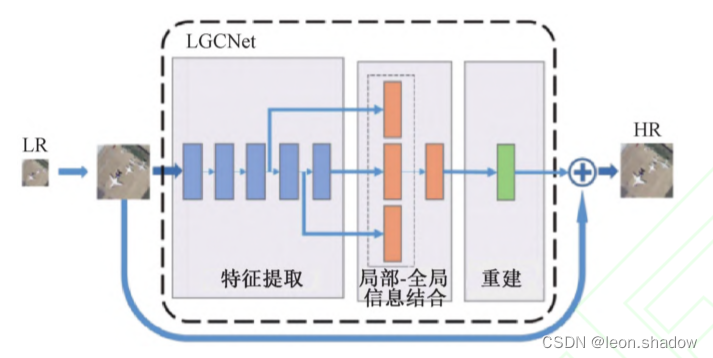

在 SRCNN 的基础上引入了残差网络,扩展了 SRCNN 的功能。由于遥感图像和自然图像有很大的不同,遥感图像中包含的物体和环境常常耦合在一起,而 且图像尺度跨度较大,但是目前大部分网络都是 在单个对象范围内构建字典或者先验知识,忽略了环境信息。于是,2017年,Lei 等提出一种基于 VDSR的网络, 称为局部-全局结合网络 ( local-global combined networks,LGCNet)。

该网络分为三个部分:

- 特征提取部分,利用L层卷积,获取不同层的特征表示

- 局部-全局信息结合部分,不同层的特征表示;②局部-全局信息 结合部分,这部分也是整个 LGCNet 的核心部分,主要将不同层的结果级联起来,也就是所谓的“多叉结构”

- 重建部分,重建出高分辨率的遥感图像

2018年,Xu 等也针对多个尺度提取特征的问题,提出深度记忆连接网络( deep memory connected network,DMCN)。 DMCN 是一种对称的沙漏结构CNN,具有多个跳跃连接。与 LGCNet相比,虽然它的重建效果只有略微的提升,但是内存占用量和测试时间大大减少了。

上面两项工作虽然都使用了多尺度特征提取 的方法,但是网络较深且结构单一,不能灵活适应多尺度特征,网络较深且结构单一,不能灵活适应 多尺度特征,于是2020年, Wang 等提出了一种用于遥感图像的超分辨率的自适应多尺度特征融合网络。 该方法提出了一种自适应多尺度特征提取模 块,该模块结合挤压激励网络和自适应门控机制。 通过该模块可以自适应地将提取的多尺度信息进行融合,该方法优于SRCNN、ESPCN、MSRN等经典方法。

EDSR

是目前通用图像超分重建性能最好 的方法之一。

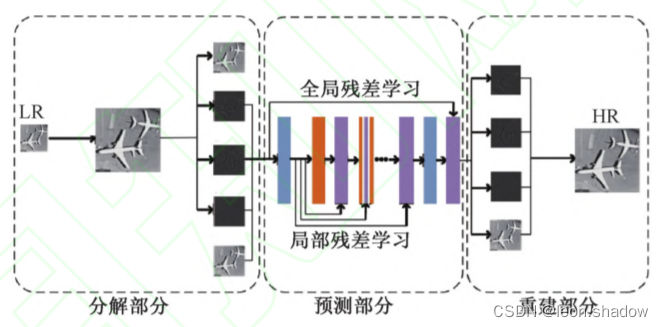

结合小波变换的遥感图像超分辨率

2019年,Ma等提出另外一种结合小波变换和带有局部、全局残差连接的 CNN 超分辨率网络结构 (WTCRR)。该网络带有局部和全局的残差连接,通过关注频域来解决超分辨率问题。

该网络有三个部分:

分解

将经过双 3 次插值的图像通过 2D 离散小 波变换分解为 4 张低分辨率图像

预测

把上一步分解出的 4 张图像输入到具有递归和 残差网络的 CNN 网络结构中,得到初步的预测结果

重建

将预测部分得到的图片通过逆离散 小波变换进行组合,重建出最终的高分辨率图像。

与 DRNN( deep recurrent neural network)相比,该方法重建后的图片边缘有所改进。

高放大因子的遥感图像超分辨率

目前,适度放大单幅遥感图像空间分辨率 (例如×2,×3)的问题得到了有效的解决,但是高 放大因子(例如×4,×8)的遥感图像超分辨率重建

仍是个难题。2019年,×4,×8)的遥感图像超分辨率重建 仍是个难题。 Pan 等针对上述问题提出快速残差密集反投影网络( fast residual dense back projection network,FRDBPN)。 FRDBPN 采用上投影和包含特定卷积和扩张卷积序列的下采样单元,以及全局和局部残差连接。

基于GAN的单幅遥感图像超分辨率

沙漏状生成网络的遥感图像超分辨率

2018年,Haut 等聚焦于生成模型,提出一种沙漏状的生成网络架构。 该网络以无监督的方式进行 训练。 生成网络由随机噪声作为输入,通过下采 样生成低空间分辨率数据,并传递给上采样结构, 如此反复优化最终生成高分辨率图片。在图像放大4倍时效果更好。

边缘增强网络的遥感图像超分辨率

由于受噪声的污染,遥感图像恢复高频边缘细 节方面仍然需要改善。 于是2019年,Jiang 等提出一种基于生成对抗网络的边缘增强网络,该网络的生成网络由两个子网络组成,超密集子网( ultra dense sub network, UDSN ) 和 边 缘 增 强 子 网 ( edge enhancement subnetwork,EESN)。 当 UDSN 用于重 建图像时,重建结果看上去很锐化,边缘受噪声污 染严重,因此,专门设计了 EESN 通过学习噪声掩 码来增强边缘。 该方法比经典的 SRCNN、VDSR[10] 和 SRGAN方法的重建效果有很大提升。

可跨传感器的遥感图像超分辨率

用于遥感图像超分辨率重建的数据通常局限 于特定的位置和特定的传感器,所以导致不同位置和传感器之间推广模型的能力有限。于是 2020年,Xiong 等修改了 SRGAN 的损失函数和网络结构,并提出改进的 SRGAN( improved SRGAN,ISRGAN),该方法使得模型训练更加稳定,并增强了 泛化能力,实现遥感图像一次训练,就可以用于任何地方和不同的传感器。结果表明,使用ISRGAN 超分辨率重建之后的土地覆盖分类的准 确性可以得到显著提高,尤其在具有高分辨率纹理道路和建筑物上,准确率提高了 15%。

基于深度学习的多幅遥感图像超分辨率重建

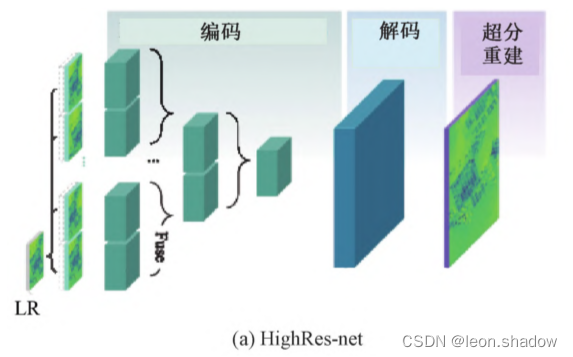

与单幅遥感图像超分辨率重建相比,多幅遥感图像超分辨率重建中包含有更多的互补信息,过程也更具有挑战性,需要解决多个低分辨率图像之间联合配准和融合等额外挑战。2020年,Deudon 等提出了HightRes-net 网络,首次将深度学习的方法引用到 多幅遥感图像超分辨率重建中,该方法以端到端的方式学习子任务。

子任务包括

- 图像配准

- 图像融合

- 上采样

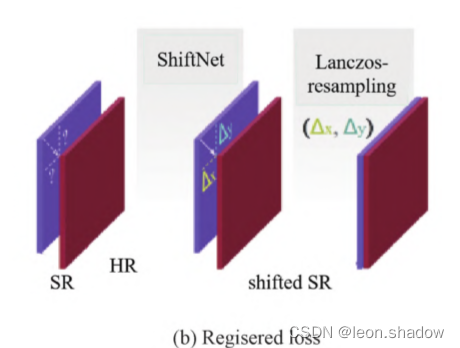

- 配准损失函数部分

HightRes-Net 是一种深层结构,通过参 考帧通道,学习将任意数量的低分辨率图像进行联合配准,然后进行上采样和超分辨率重建。

最后将得到的 ShiftNet 损失反馈到 HightRes-Net 模型中,得到重建图片。ShiftNet 损 失函数保证了多幅遥感图像的超分辨率重建不会因为配准不足,亚像素偏移等导致模糊的结果输出。

基于深度学习的多/高光谱遥感图像超分辨率重建

感图像的空间分 辨率和光谱分辨率的重建方法。 光谱图像包含数 百个波段,提供了丰富的光谱特征,每张图像代表不同电磁波段下场景的反射率和辐射率,这种物 理表示在许多应用中起着至关重要的作用,例如 遥感分类、目标检测和异常检测。 但是由于硬件 限制,收集高质量的高光谱图像比全色图像困难, 并且分辨率也较低,因此超分辨率重建技术也被引入到该领域。 以下是几种代表性方法。

基于 SRCNN 的多/高光谱图像超分辨率重建

2017年,Yuan 等将用在自然图像上预先训练的单图像超分重建方法 SRCNN 用来独立增强多 / 高光谱遥感图像的每个频段,并借鉴转移学习思想将其转化为高光谱图像。另外,为了研究低分 辨率和多 /高分辨率高光谱图像之间的光谱性质, 作者还提出了协作非负矩阵分解来增强低分辨率和高分辨率光谱之间的关联。

[1] He Z , Liu L . Hyperspectral Image Super-Resolution Inspired by Deep Laplacian Pyramid Network[J]. Remote Sensing, 2018, 10(12).

这篇文章也考虑了类似Yuan等人的思想先用自然图像训练拉普拉斯金字塔网络然后利用预训练好的的网络对多/高光谱遥感图像的每个波段进行超分辨率 重建;最后,利用编码光谱在低空间分辨率多/高光谱图像上训练,来提高多/高光谱分辨率。

改进损失函数的多/高光谱图像超分辨率重建

大多数基于 CNN 的图像超分辨率重建网络, 都是使用默认的 L2 损失函数,但是对于高光谱图像,该损失函数可能会导致光谱不一致。多/高 光谱图像的超分,损失函数不仅应该关注空间信息,还要关注光谱信息。于是,2018年,仅应该关注空间信 息,还要关注光谱信息。 于是 Zheng 等提出一种同时考虑空间和光谱信息的多损失函数网络, 它由串联密集残差网络( concatenate dense residual network,CDRN)和损失网络( loss network,LN) 组成。 CDRN 是图像重建部分,LN 包括像素的空间损失和光谱损失,它驱动整个模型的学习。

相关资料

数据集

- UC Merced数据集,它是一个用于研 究土地利用的数据集,一共有 2 100 张图片,包含 21 类场景,每类 100 张,每张图片的像素大小为

256×256。 - RSCNN7数据集,一共包含 2 800 幅遥感图像,分别来自 7 个不同的场景类别,每个类别包含 400 张图像。

- NWPU-RESISC45数据集,来自西北工业大学,一共含有 31500 张图片,分为 45 个场景类别, 每类有 700 张, 每张图像的大小为

256×256。 - Kaggle开源数据集,是一个开源数据集, 该数据集中 Draper 卫星图像包含了 1 000 多张在南加州拍摄的高分辨率航空照片。

- Sentinel-2数据集,它是 Sentinel 系列里 的其中一个系列,数据免费,主要有效载荷是多光 谱成像仪,共有 13 个波段,光谱范围在 0. 4 ~ 2. 4 μm 之间,涵盖了可见光、近红外和短波红外, 并且该数据集作为 Landsat 系统在对地观测领域的补充,目前应用越来越多。

结果分析

对于单幅遥感 图像超分辨率重建方法的结果表明,使用基于 GAN 的结构,并在通用图像上进行预训练,PSNR 提升的更高,可以取得目前最好的重建效果。 对 于多 /高光谱遥感图像超分重建方法,PSNR 提升 明显较低,这主要是由于多 /高光谱遥感图像的特 殊性造成的,这一结果表明,同时利用空间和光谱信息,可以获得更好的性能。

讨论

- 从模型类型来看,基于 CNN 的方法仍然 是目前基于深度学习的遥感图像超分重建中的主 流方法,但也有少部分学者将其他的深度模型应用于遥感图像的超分重建中。

- 从单幅遥感图像重建方法及其效果来 看,基于 GAN 的方法可以取得目前最好的重建效果,这与在自然图像上的方法结果是一致的。

- 对于多幅遥感图像超分辨率重建而言, 需要考虑图像配准和融合等额外挑战,所以重建 模型会比较大,并且目前基于深度学习的多幅遥 感图像超分辨率重建方法较少,主要都是针对单幅遥感图像重建的方法。

- 对于多 /高光谱遥感图像超分辨率重建 的情况,性能最好的方法是同时注意提高空间分辨率和光谱分辨率,而不是像早期的方法那样只是独立地考虑光谱通道。

- 大部分的基于深度学习的遥感图像超分 辨率重建网络使用的是 L1 和 L2 损失函数,这两 个损失函数都是基于像素差异的。对于多/高光谱遥感图像进行光谱分辨率重建时,需要设计合适的光谱信息损失函数,这样才能生成高质量的多/高光谱遥感图像。

展望

- 研究针对遥感图像特点的神经网络结构。遥感图像具 有尺度多样性、视角特殊性、多方向和背景复杂度

高等特点。 - 研究无监督学习的遥感图像超分辨率重建方法。遥感图像在同一场景下的不同分辨率的 图像很难获取,所以缺乏训练样本,而且目前主要 的研究是有监督的遥感图像超分辨率重建方法, 但是有监督学习的超分方法训练出来的模型不能 很好地应对一些实际场景的超分任务,所以无监 督的遥感图像超分重建模型具有重要的研究价值。

- 研究多源遥感图像的超分重建方法。融合同一场景不同传感器的图像信息(包括空间信息、时间信息、光谱信息和位置信息等),目前基 于深度学习的遥感图像超分重建方法中,大多只是根据一种信息来进行重建,模型学习到的信息 较少,重建效果有限,所以研究多源遥感图像信息 的融合问题,充分挖掘这些互补信息,以提高遥感 图像重建效果,这也将是未来一个十分重要的研究方向。

参考文献:[1]成科扬,荣兰,蒋森林,詹永照.基于深度学习的遥感图像超分辨率重建技术综述[J/OL].郑州大学学报(工学版):1-9[2022-06-21].DOI:10.13705/j.issn.1671-6833.2022.05.013.

边栏推荐

- SD卡報錯“error -110 whilst initialising SD card

- Performance analysis of user login TPS low and CPU full

- Audio audiorecord binder communication mechanism

- JS音乐在线播放插件vsPlayAudio.js

- [ruoyi] ztree custom icon (iconskin attribute)

- Software design principles

- ArabellaCPC 2019(补题)

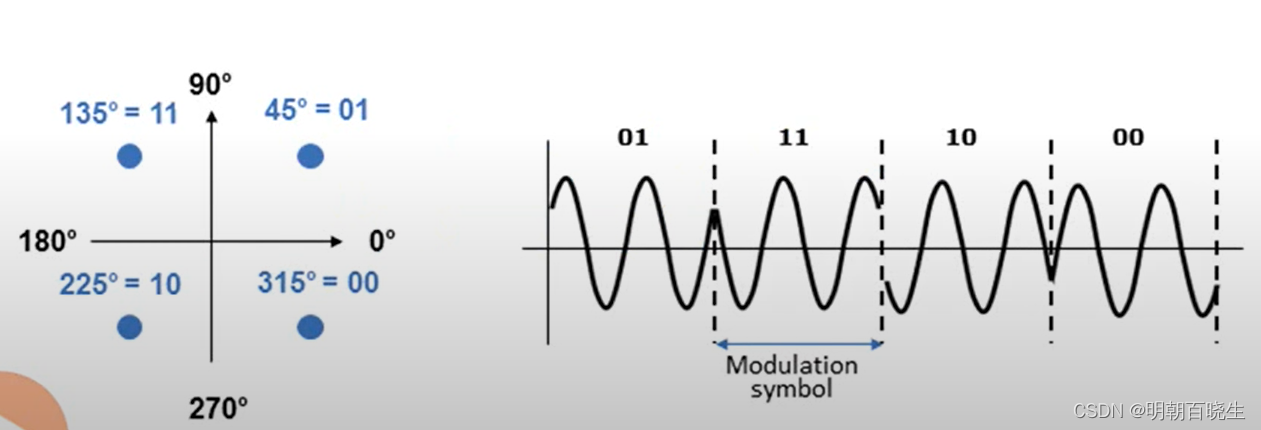

- NR modulation 1

- Handwriting database client

- 11. Container with the most water

猜你喜欢

Reverse repackaging of wechat applet

Analyze menu analysis

![[kubernetes series] learn the exposed application of kubernetes service security](/img/61/4564230feeb988886fe595e3125ef4.png)

[kubernetes series] learn the exposed application of kubernetes service security

NR modulation 1

ERA5再分析资料下载攻略

Mysql database operation

Princeton University, Peking University & UIUC | offline reinforcement learning with realizability and single strategy concentration

The next industry outlet: NFT digital collection, is it an opportunity or a foam?

记录一下逆向任务管理器的过程

真机无法访问虚拟机的靶场,真机无法ping通虚拟机

随机推荐

继承day01

Force buckle 1189 Maximum number of "balloons"

【 kubernets series】 a Literature Study on the Safe exposure Applications of kubernets Service

ESBuild & SWC浅谈: 新一代构建工具

3857墨卡托坐标系转换为4326 (WGS84)经纬度坐标

下一个行业风口:NFT 数字藏品,是机遇还是泡沫?

StrError & PERROR use yyds dry inventory

Polymorphic day02

八道超经典指针面试题(三千字详解)

How to write compile scripts compatible with arm and x86 (Makefile, cmakelists.txt, shell script)

Tomb. Weekly update of Finance (February 7 - February 13)

Sign SSL certificate as Ca

3857 Mercator coordinate system converted to 4326 (WGS84) longitude and latitude coordinates

Web security SQL injection vulnerability (1)

Lua uses require to load the shared library successfully, but the return is Boolean (always true)

C language judgment, ternary operation and switch statement usage

Performance test method of bank core business system

Reverse repackaging of wechat applet

JS音乐在线播放插件vsPlayAudio.js

Prototype design